Umetna inteligenca

EAGLE: Raziskovanje oblikovalskega prostora za multimodalne velike jezikovne modele z mešanico kodirnikov

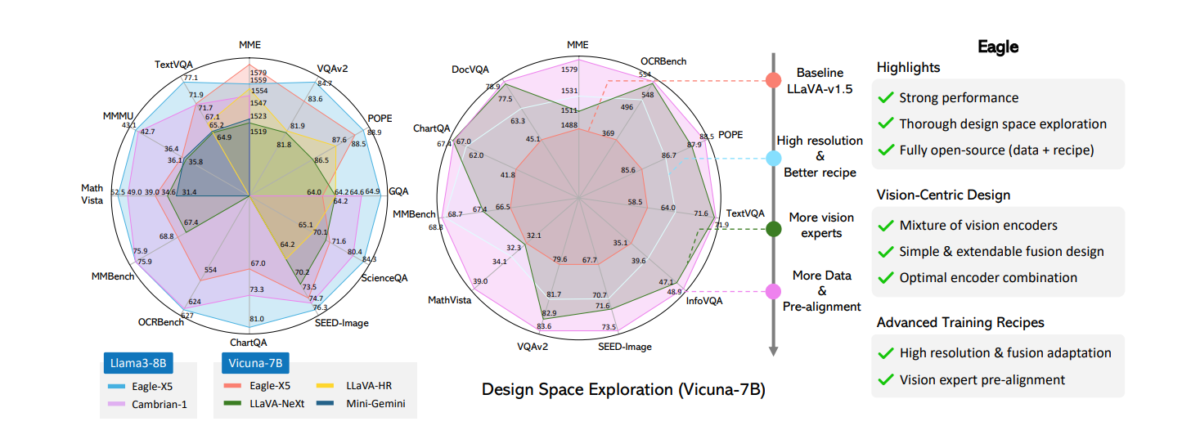

Sposobnost natančne interpretacije kompleksnih vizualnih informacij je ključni poudarek večmodalnih velikih jezikovnih modelov (MLLM). Nedavno delo kaže, da izboljšano vizualno zaznavanje znatno zmanjša halucinacije in izboljša učinkovitost nalog, ki so občutljive na ločljivost, kot sta optično prepoznavanje znakov in analiza dokumentov. Več nedavnih MLLM-jev to doseže z uporabo mešanice vidnih kodirnikov. Kljub njihovemu uspehu primanjkuje sistematičnih primerjav in podrobnih študij ablacije, ki bi obravnavale kritične vidike, kot sta izbira strokovnjakov in integracija več strokovnjakov za vid. Ta članek zagotavlja obsežno raziskovanje prostora oblikovanja za MLLM z uporabo mešanice kodirnikov vida in ločljivosti, ogrodja Eagle, ki poskuša raziskati prostor oblikovanja za večmodalne velike jezikovne modele z mešanico kodirnikov. Ugotovitve razkrivajo več temeljnih načel, ki so skupna različnim obstoječim strategijam, kar vodi do poenostavljenega, a učinkovitega pristopa oblikovanja. Eagle odkrije, da je preprosto povezovanje vizualnih žetonov iz nabora komplementarnih vidnih kodirnikov enako učinkovito kot bolj zapletene mešalne arhitekture ali strategije. Poleg tega Eagle uvaja predhodno poravnavo za premostitev vrzeli med kodirniki, osredotočenimi na vid, in jezikovnimi žetoni ter tako izboljša skladnost modela. Nastala družina MLLM, Eagle, presega druge vodilne odprtokodne modele na glavnih merilih MLLM.

Eaglovo delo je povezano s splošno zasnovo arhitekture večmodalnih velikih jezikovnih modelov (MLLM). Poleg prej omenjene reprezentativne odprtokodne raziskave druge pomembne družine MLLM vključujejo, vendar niso omejene na, MiniGPT-4, Lynx, Otter, QwenVL, CogVLM, VILA, GPT-4V, Gemini in Llama 3.1. Glede na to, kako so vidni signali integrirani v jezikovni model, lahko MLLM na splošno kategoriziramo v modele »medmodalne pozornosti« in modele »naravnavanja predpon«. Prvi vnaša vizualne informacije v različne plasti LLM-jev z navzkrižno modalno pozornostjo, medtem ko drugi obravnava vizualne žetone kot del zaporedja jezikovnih žetonov in jih neposredno doda z vdelavo besedila. Eagleov model spada v družino predponske nastavitve, saj sledi multimodalni arhitekturi v slogu LLaVA. Glede na to, da je MLLM hitro rastoče področje, Eagle priporoča, da se za nadaljnje vpoglede obrnete na podrobnejše študije in ankete.

Eaglovo delo je tesno povezano z raziskavami, osredotočenimi na izboljšanje zasnov kodirnikov vida za MLLM. Zgodnja dela so običajno uporabljala vidne kodirnike, ki so bili predhodno usposobljeni za naloge poravnave vizualnega jezika, kot sta CLIP in EVA-CLIP. Močnejši kodirniki vida, kot sta SigLIP in InternVL, so bili predlagani za izboljšanje nalog vizualnega jezika z boljšimi oblikami, večjimi velikostmi modelov in učinkovitejšimi recepti za usposabljanje. Ker so modeli pogosto vnaprej usposobljeni za slike z nizko ločljivostjo in morda nimajo zmožnosti kodiranja drobnozrnatih podrobnosti, se pogosto izvaja prilagoditev višje ločljivosti, da se poveča vhodna ločljivost MLLM. Poleg prilagajanja z višjo ločljivostjo modeli, kot so LLaVA-NeXT, LLaVA-UHD, Monkey, InternLM-XComposer in InternVL, uporabljajo postavitev ali prilagodljivo polaganje za obdelavo vnosa z visoko ločljivostjo, kjer so slike razdeljene na popravke z nižjo ločljivostjo in obdelane ločeno. Medtem ko je zmožnost obdelave višje ločljivosti omogočena z uvedbo dodatnih strokovnjakov za vid, se ta pristop nekoliko razlikuje od tehnik polaganja ploščic, čeprav sta obe združljivi in ju je mogoče kombinirati.

EAGLE: Uporaba mešanice kodirnikov za raziskovanje prostora za oblikovanje multimodalnih LLM

Uspeh velikih jezikovnih modelov (LLM) je sprožil veliko zanimanje za omogočanje njihovih zmožnosti vizualnega zaznavanja, kar jim omogoča, da vidijo, razumejo in razmišljajo v resničnem svetu. V jedru teh multimodalni veliki jezikovni modeli (MLLM) je tipična zasnova, pri kateri se slike pretvorijo v vrsto vizualnih žetonov s kodirniki vida in dodajo vdelano besedilo. CLIP je pogosto izbran kot kodirnik vida, ker je njegova vizualna predstavitev usklajena s prostorom besedila s predhodnim usposabljanjem na parih slika-besedilo. Odvisno od arhitektur, receptov za usposabljanje in načina, kako so vidni žetoni vbrizgani v jezikovni model, pomembne družine MLLM vključujejo Flamingo, BLIP, PaLI, PaLM-E in LLaVA. Večina teh modelov ohranja sorazmerno nizke vhodne ločljivosti zaradi omejitev vnaprej usposobljenih vidnih kodirnikov in dolžine zaporedja LLM. Eaglovo delo je tesno povezano z modeli, ki uporabljajo več vidnih kodirnikov za izboljšano zaznavanje. Mini-Gemini in LLaVA-HR predlagata zlitje vizualnih funkcij visoke ločljivosti v vizualne žetone nizke ločljivosti. Poleg težav z ločljivostjo ti vnaprej usposobljeni kodirniki vida morda nimajo posebnih zmogljivosti, kot je branje besedila ali lokalizacija predmetov. Da bi to rešili, različni modeli vključujejo kodirnike vida, ki so bili vnaprej usposobljeni za različne naloge vida, da izboljšajo zmogljivosti kodirnika vida.

Na primer, modeli, kot sta Mousi in Brave, združita vizualne žetone iz različnih vidnih kodirnikov z združevanjem vzdolž kanala ali smeri žetona. RADIO uvaja metodo destilacije več učiteljev za poenotenje zmožnosti različnih kodirnikov vida v en sam model. MoAI, IVE in Prismer nadalje uporabljajo rezultate strokovnjakov za vid, kot so OCR, zaznavanje ali ocena globine, da dopolnijo dodatne informacije za MLLM za ustvarjanje odgovorov. MoVA oblikuje usmerjevalno omrežje za dodelitev optimalnega modela vida na podlagi dane slike in navodil.

Nedavne študije so pokazale, da so močnejši modeli kodirnikov vida pomembni za zmanjšanje MLLM halucinacije in izboljšanje zmogljivosti pri nalogah, ki so občutljive na ločljivost, kot je optično prepoznavanje znakov (OCR). Več del se osredotoča na izboljšanje zmogljivosti kodirnika vida, bodisi s povečevanjem podatkov in parametrov pred usposabljanjem bodisi z razdelitvijo slik na zaplate z nizko ločljivostjo. Vendar ti pristopi pogosto zahtevajo velike vire usposabljanja. Učinkovita, a zmogljiva strategija je mešanje vizualnih kodirnikov, predhodno usposobljenih za različne naloge in vhodne ločljivosti, bodisi z združitvijo kodirnikov z višjo ločljivostjo s kodirnikom CLIP, zaporednim dodajanjem funkcij iz različnih kodirnikov ali s sprejetjem bolj zapletenih strategij združevanja in usmerjanja za povečanje prednosti različne kodirnike. Ta pristop »mešanice strokovnjakov za vizijo« se je izkazal za učinkovitega, čeprav še vedno manjka podrobna študija njegovega oblikovalskega prostora s strogo ablacijo, kar je spodbudilo Eagle, da ponovno obišče to področje. Ključna vprašanja ostajajo: katere kombinacije kodirnikov vida izbrati, kako združiti različne strokovnjake in kako prilagoditi strategije usposabljanja z več kodirniki vida.

Da bi odgovoril na ta vprašanja, Eagle sistematično raziskuje prostor zasnove mešanice vidnih kodirnikov za izboljšano zaznavanje MLLM. Raziskovanje tega oblikovalskega prostora vključuje naslednje korake: 1) primerjalno analizo različnih vidnih kodirnikov in iskanje prilagoditve višje ločljivosti; 2) Izvajanje primerjave »jabolka z jabolki« med strategijami fuzije vidnega kodirnika; 3) Postopno prepoznavanje optimalne kombinacije več kodirnikov vida; 4) Izboljšanje predhodne poravnave strokovnjakov za vid in mešanice podatkov. Koraki raziskovanja so prikazani na naslednji sliki.

Eaglova študija zajema delovanje vidnih kodirnikov, ki so bili vnaprej usposobljeni za različne naloge in ločljivosti, kot je usklajevanje vidnega jezika, samonadzorovano učenje, zaznavanje, segmentacija in OCR. Z uporabo krožnega pristopa Eagle začne z osnovnim kodirnikom CLIP in dodaja enega dodatnega strokovnjaka naenkrat, pri čemer izbere strokovnjaka, ki zagotavlja najboljše izboljšave v vsakem krogu.

Medtem ko Eaglovo delo ni prvo, ki uporablja več kodirnikov vida v MLLM, sistematična študija vodi do več ključnih ugotovitev v tej nastavitvi:

- Odklepanje vidnih kodirnikov med usposabljanjem MLLM je pomembno. To je v nasprotju z modeli, kot so LLaVA in drugi, ki upoštevajo več vidnih kodirnikov ali učiteljev, kjer je bila zamrznitev vidnih kodirnikov običajna praksa.

- Nekatere nedavno predlagane fuzijske strategije ne kažejo bistvenih prednosti. Namesto tega se preprosto združevanje kanalov pojavi kot preprosta, a konkurenčna fuzijska strategija, ki ponuja najboljšo učinkovitost in zmogljivost.

- Vključitev dodatnih strokovnjakov za vizijo vodi do doslednih dobičkov. Zaradi tega je obetavna pot za sistematično izboljšanje zaznavanja MLLM, poleg povečanja posameznih kodirnikov. Izboljšava je še posebej izrazita, ko so vidni kodirniki odklenjeni.

- Faza predusklajevanja je ključna. Eagle uvaja stopnjo predporavnave, kjer se strokovnjaki za vid, ki niso poravnani z besedilom, individualno natančno prilagodijo z zamrznjenim LLM, preden se skupaj usposabljajo. Ta stopnja bistveno izboljša zmogljivost MLLM pri zasnovi kodirnika mešanega vida.

Eagle: Metodologija in arhitektura

Za razliko od prejšnjih metod, ki se osredotočajo na nove fuzijske strategije ali arhitekture med kodirniki vida, je Eagleov cilj identificirati minimalistično zasnovo za spajanje različnih kodirnikov vida, podprto s podrobnimi ablacijami in odstranitvijo vseh nepotrebnih komponent. Kot je prikazano na naslednji sliki, Eagle začne z razširitvijo osnovnega kodirnika CLIP na nabor strokovnjakov za vid z različnimi arhitekturami, nalogami pred usposabljanjem in ločljivostmi. S temi strokovnjaki Eagle nato primerja različne fuzijske arhitekture in metode ter raziskuje, kako optimizirati strategije pred usposabljanjem z več kodirniki.

Končno Eagle združuje vse ugotovitve in razširja pristop na več strokovnih vidnih kodirnikov z različnimi ločljivostmi in poznavanjem področja. Z uporabo istih podatkov pred usposabljanjem kot LLaVA-1.5, ki je sestavljen iz 595k parov slika-besedilo, Eagle preide na nadzorovano fazo natančnega prilagajanja z zbiranjem podatkov iz niza nalog in njihovo pretvorbo v večmodalne pogovore, vključno z LLaVA-1.5, Laion-GPT4V, ShareGPT-4V, DocVQA, synDog-EN, ChartQA, DVQA in AI2D, rezultat 934k vzorcev.

Model je najprej vnaprej usposobljen s pari slika-besedilo za eno epoho z velikostjo paketa 256, kjer je celoten model zamrznjen in posodobljena samo plast projektorja. Na drugi stopnji je model natančno nastavljen na podlagi nadzorovanih podatkov natančnega prilagajanja za eno obdobje z velikostjo paketa 128. Za to raziskavo Eagle uporablja Vicuna-7B kot osnovni jezikovni model. Stopnje učenja so nastavljene na 1e-3 za prvo stopnjo in 2e-5 za drugo stopnjo.

Močnejši kodirnik CLIP

Eagle začenja raziskovanje z modelom CLIP, saj je za mnoge postal primarna izbira MLLM. Medtem ko je znano, da modeli CLIP izboljšujejo multimodalne naloge, so bile tudi njihove omejitve dobro dokumentirane. Številni obstoječi MLLM-ji na primer običajno uporabljajo vnaprej pripravljene ločljivosti CLIP (na primer 224 × 224 ali 336 × 336) kot svoje vhodne ločljivosti. V teh primerih kodirniki pogosto težko zajamejo natančne podrobnosti, pomembne za naloge, ki so občutljive na ločljivost, kot sta OCR in razumevanje dokumentov.

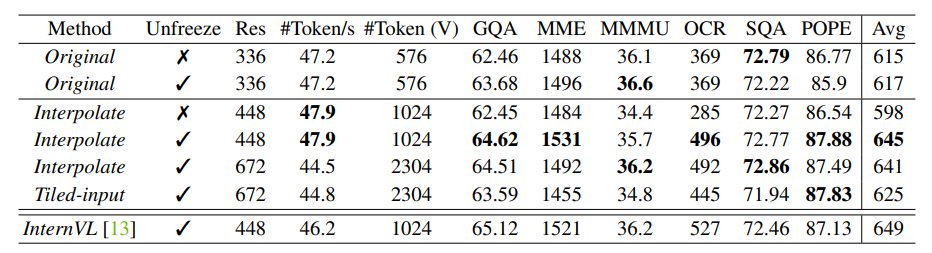

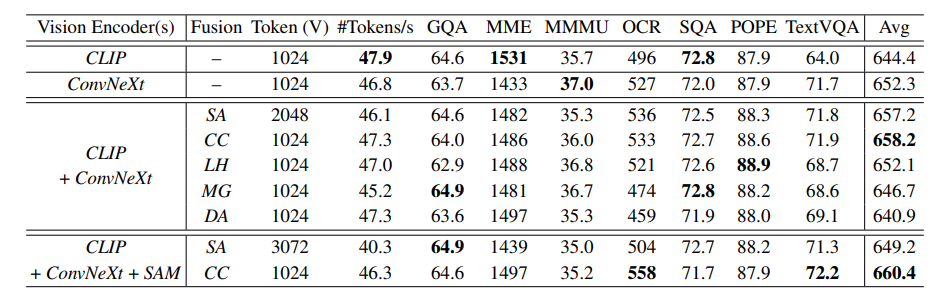

Za obdelavo povečane vhodne ločljivosti je običajen pristop razporeditev, kjer so vhodne slike razdeljene na ploščice in ločeno kodirane. Druga enostavnejša metoda je neposredno povečanje vhodne ločljivosti in po potrebi interpolacija vdelav položaja modela transformatorja vida. Eagle primerja ta dva pristopa z kodirniki zamrznjenega in nezamrznjenega vida v različnih ločljivostih, z rezultati v zgornji tabeli. Ugotovitve lahko povzamemo takole:

- Odmrznitev kodirnika CLIP povzroči znatno izboljšanje pri interpolaciji na višjo vhodno ločljivost MLLM, ki se razlikuje od ločljivosti pred usposabljanjem CLIP, brez poslabšanja zmogljivosti, ko ločljivosti ostanejo enake.

- Zamrznitev kodirnika CLIP in njegova neposredna prilagoditev na višjo vhodno ločljivost MLLM znatno škodi zmogljivosti.

- Med primerjanimi strategijami se je neposredna interpolacija na 448 × 448 z nezamrznjenim kodirnikom CLIP izkazala za učinkovito in uspešno v smislu zmogljivosti in stroškov.

- Najboljši kodirnik CLIP dosega zmogljivost, ki je blizu InternVL, kljub temu, da je precej manjši model (300M proti 6B) z manj podatki pred usposabljanjem.

Treba je omeniti, da CLIP-448 omogoča Eagleu uskladitev nastavitve z LLaVA-HR in InternVL, kjer so kodirniki CLIP podobno prilagojeni za sprejemanje 448 × 448 vhodnih in izhodnih 1024 žetonov popravkov. Za nadaljnjo preiskavo Eagle sledi tej preprosti strategiji povečevanja vhodne ločljivosti in odklepanja vidnega kodirnika med usposabljanjem.

Eagle opaža, da je mogoče obstoječe priljubljene fuzijske strategije, kljub njihovim konstrukcijskim različicam, na splošno kategorizirati na naslednji način:

- Sequence Append: Neposredno dodajanje vizualnih žetonov iz različnih hrbtenic kot daljšega zaporedja.

- Združevanje kanalov: Združevanje vizualnih žetonov vzdolž dimenzije kanala brez povečanja dolžine zaporedja.

- LLaVA-HR: Vstavljanje funkcij visoke ločljivosti v kodirnike vida z nizko ločljivostjo z uporabo adapterja mešane ločljivosti.

- Mini-Dvojčka: Uporaba žetonov CLIP kot poizvedb nizke ločljivosti za navzkrižno spremljanje drugega kodirnika vida visoke ločljivosti v solociranih lokalnih oknih.

- Deformabilna pozornost: Nova osnovna linija, uvedena na vrhu Mini-Gemini, kjer je pozornost vaniličastega okna nadomeščena z deformabilno pozornostjo.

Namesto usposabljanja projektorja za sočasno usklajevanje več strokovnjakov za vid, kot je to v prvotni strategiji pred usposabljanjem LLaVA, najprej uskladimo predstavitev vsakega posameznega strokovnjaka z manjšim jezikovnim modelom (Vicuna-7B v praksi) z uporabo nadzora napovedi naslednjega žetona. Kot je prikazano na spodnji sliki, je s predhodno uskladitvijo celoten proces usposabljanja sestavljen iz treh korakov: 1) usposabljanje vsakega predhodno usposobljenega strokovnjaka za vid z lastnim projektorjem na podatkih SFT, medtem ko jezikovni model ostane zamrznjen; 2) združevanje vseh strokovnjakov za vid od prvega koraka in usposabljanje samo projektorja s podatki parov slika-besedilo; 3) usposabljanje celotnega modela na podatkih SFT.

Eagle: Poskusi in rezultati

Po natančnem razvoju svojih strategij je Eagle za model vzpostavil naslednja načela: (1) vključevanje več strokovnjakov za vid z optimiziranim receptom za usposabljanje; (2) združevanje več strokovnjakov za vid z neposrednim združevanjem kanalov; (3) ločeno predhodno usposabljanje strokovnjakov za vizijo s predhodno uskladitvijo. V tem razdelku so za nadaljnji prikaz prednosti modelov Eagle vključeni dodatni podatki o usposabljanju, Eagle pa se primerja s trenutnimi najsodobnejšimi MLLM pri različnih nalogah. Eagle kot jezikovne modele uporablja Vicuna-v1.5-7B, Llama3-8B in Vicuna-v1.5-13B. Za vidne kodirnike so na podlagi rezultatov v razdelku 2.6 modeli Eagle označeni kot Eagle-X4, ki vključuje štiri vidne kodirnike: CLIP, ConvNeXt, Pix2Struct in EVA-02, ter Eagle-X5, ki vključuje dodatni SAM vision kodirnik.

Naloge z vizualnimi odgovori na vprašanja

Eagle primerja serijo modelov v treh merilih uspešnosti Visual Question Answering (VQA), vključno z GQA, VQAv2 in VizWiz. Kot je prikazano v naslednji tabeli, Eagle-X5 dosega najsodobnejšo zmogljivost na GQA in VQAv2, kar poudarja prednosti vključitve dodatnih strokovnjakov za vid.

Naloge za OCR in razumevanje grafikonov

Za ovrednotenje zmožnosti Eagle za OCR, dokumente in razumevanje grafikonov se model primerja z OCRBench, TextVQA in ChartQA. Kot je prikazano v zgornji tabeli, Eagle znatno prekaša konkurente na TextVQA, saj ima koristi od svoje arhitekture visoke ločljivosti in integracije različnih kodirnikov vida. Predvsem Eagle ohranja preprosto zasnovo, saj podpira do 1024 žetonov, ne da bi zahteval zapleteno razgradnjo slik na ploščice.

Spodnja slika prikazuje primere primerov OCR in razumevanja dokumentov. S prilagoditvijo visoke ločljivosti in vključitvijo več strokovnjakov za vid lahko Eagle prepozna majhno besedilo v slikah in natančno izvleče informacije na podlagi uporabniških navodil.

Da bi bolje razumeli prednosti uvedbe strokovnjakov, predhodno usposobljenih za druge naloge vida, naslednja slika vizualizira rezultate modela z le kodirnikoma vida ConvNeXt in CLIP v primerjavi z rezultati Eagle-X5. S celotnim naborom vidnih kodirnikov model uspešno popravlja napake in dokazuje, da so zmogljivosti Eagle, tudi če je opremljen z visokoločljivostnimi vidnimi kodirniki, ki so vnaprej usposobljeni za poravnavo vizualnega jezika, dodatno izboljšane z vključitvijo dodatnih strokovnjakov za vid, ki so predhodno usposobljeni za raznolik vid. naloge.

Multimodalna primerjalna ocena

Eagle je ocenjen na sedmih merilih uspešnosti za MLLM, da se prikažejo njegove zmogljivosti iz različnih perspektiv, vključno z MME, MMBench, SEED, MathVista, MMMU, ScienceQA in POPE. Natančneje, MME, MMBench in SEED ocenjujejo celotno uspešnost pri različnih nalogah iz resničnega sveta, ki vključujejo sklepanje, prepoznavanje, znanje in OCR. MMMU se osredotoča na zahtevne probleme z različnih področij, ki zahtevajo visokošolsko znanje. POPE ocenjuje vizualne halucinacije MLLM. Meritve, uporabljene v tej oceni, so v skladu s privzetimi nastavitvami teh meril uspešnosti. Eagle poroča o rezultatu zaznavanja za MME, razdelitvi en_dev za MMBench, razdelitvi slike za SEED, testni mini split za MathVista, razdelitvi val za MMMU, rezultatu F1 za POPE in rezultatu slike za ScienceQA, kar zagotavlja poravnavo s prijavljenimi rezultati drugih modelov.

Končna thoughts

V tem članku smo govorili o Eagleu, poglobljeni analizi oblikovalskega prostora za integracijo vidnih kodirnikov v multimodalne velike jezikovne modele. Za razliko od prejšnjih del, ki se osredotočajo na oblikovanje novih paradigem fuzije, Eagle ugotavlja, da so sistematične izbire oblikovanja pomembne, in odkriva vrsto uporabnih tehnik. Korak za korakom Eagle optimizira recept za usposabljanje posameznih vidnih kodirnikov, identificira razširljivo in učinkovito metodo fuzije in postopoma združuje vidne kodirnike z različnim znanjem domene. Rezultati poudarjajo ključno pomembnost osnovnih premislekov o oblikovanju prostora.