Inteligența artificială

MINT-1T: Scalare de 10 ori a datelor multimodale open-source

Formarea modelelor multimodale mari (LMM) de frontieră necesită seturi de date la scară mare cu secvențe intercalate de imagini și text în formă liberă. Deși LMM-urile cu sursă deschisă au evoluat rapid, există încă o lipsă majoră de seturi de date intercalate multimodale la scară, care sunt cu sursă deschisă. Importanța acestor seturi de date nu poate fi exagerată, deoarece ele formează baza pentru crearea de sisteme AI avansate capabile să înțeleagă și să genereze conținut în diferite modalități. Fără o sursă suficientă de seturi de date cuprinzătoare, intercalate, potențialul de dezvoltare a LMM-urilor mai sofisticate și mai capabile este îngreunat semnificativ. Aceste seturi de date permit modelelor să învețe dintr-o gamă variată de intrări, făcându-le mai versatile și mai eficiente în diverse aplicații. În plus, deficitul de astfel de seturi de date reprezintă o provocare pentru comunitatea open-source, care se bazează pe resurse partajate pentru a stimula inovația și colaborarea.

Modelele multimodale open-source au făcut progrese semnificative în ultimii ani, dar creșterea lor este împiedicată de disponibilitatea limitată a seturilor de date intercalate la scară largă. Pentru a depăși acest obstacol, sunt necesare eforturi concertate pentru a colecta, adnota și publica seturi de date mai cuprinzătoare, care pot sprijini dezvoltarea și rafinarea continuă a modelelor multimodale. În plus, crearea și diseminarea acestor seturi de date implică depășirea mai multor obstacole tehnice și logistice. Colectarea datelor trebuie să fie extinsă și reprezentativă pentru diversele contexte în care vor fi implementate modelele multimodale. Adnotarea necesită o analiză atentă pentru a se asigura că secvențele intercalate de imagini și text sunt aliniate într-un mod care îmbunătățește capacitățile de învățare ale modelului. Mai mult, asigurarea faptului că seturile de date sunt open-source implică abordarea considerațiilor legale și etice legate de confidențialitatea datelor și drepturile de utilizare. Extinderea disponibilității seturilor de date multimodale intercalate la scară largă, de înaltă calitate, este esențială pentru viitorul cercetării și dezvoltării în domeniul inteligenței artificiale. Prin abordarea deficitului actual, comunitatea inteligenței artificiale poate promova o mai mare inovație și colaborare, ducând la crearea unor modele multimodale mai puternice și mai versatile, capabile să abordeze probleme complexe din lumea reală.

Pornind de la această notă, MINT-1T, cel mai mare și mai divers set de date open-source intercalate multimodal de până acum. MINT-1T: O scară de 10 ori mai mare, inclusiv un trilion de simboluri text și 3.4 miliarde de imagini decât seturile de date open-source existente. Setul de date MINT-1T introduce, de asemenea, surse care nu au fost expuse niciodată, cum ar fi fișierele PDF, documentele ArXiv. Deoarece seturile de date intercalate multimodale nu se scalează ușor, este important ca setul de date MINT-1T să partajeze procesul de conservare a datelor, astfel încât și alții să poată efectua experimente pe astfel de variante bogate în informații. Setul de date MINT-1T demonstrează că metoda sa; Modelele LM instruite pe MINT-1T sunt competitive (deși oarecum) față de OBELICS anterioare de ultimă generație.

MINT-1T: Un set de date multimodal cu un trilion de jetoane

Seturi de date mari de pre-formare open-source au fost esențiale pentru comunitatea de cercetare în explorarea ingineriei datelor și formarea modelelor transparente, open-source. În domeniul textului, lucrările timpurii, cum ar fi C4 și The Pile, au jucat un rol crucial în a permite comunității să antreneze primul set de modele de limbaj mari open-source precum GPT-J, GPT-Neo și altele. Aceste eforturi fundamentale au deschis, de asemenea, calea pentru îmbunătățiri ulterioare ale metodelor de filtrare și scalare a datelor. În mod similar, în spațiul imagine-text, seturile de date open-source la scară largă au stimulat inovații în metode mai bune de conservare a datelor, cum ar fi rețelele de filtrare a datelor și T-MARS. Există o schimbare vizibilă de la laboratoarele de frontieră la formare modele mari multimodale (LMM) care necesită seturi de date intercalate multimodale extinse care cuprind secvențe libere de imagini și text. Pe măsură ce capacitățile modelelor de frontieră avansează rapid, apare un decalaj semnificativ în datele de antrenament multimodal între modelele închise și cele open-source. Seturile de date intercalate multimodale cu sursă deschisă actuale sunt mai mici și mai puțin diverse decât omologii lor doar text, fiind provenite în principal din documente HTML, ceea ce limitează amploarea și varietatea datelor. Această limitare împiedică dezvoltarea LMM-urilor open-source robuste și creează o diferență între capacitățile modelelor open-source și closed-source.

Pentru a aborda acest decalaj, MINT-1T a fost creat ca cel mai mare și mai divers set de date intercalate multimodale open-source până în prezent. MINT-1T conține un total de un trilion de simboluri text și trei miliarde de imagini, provenite din diverse origini, cum ar fi HTML, PDF-uri și ArXiv. Înainte de MINT-1T, cel mai mare set de date open-source din această zonă a fost OBELICS, care includea 115 miliarde de simboluri text și 353 milioane de imagini, toate provenite din HTML.

Contribuțiile MINT-1T sunt următoarele:

- Ingineria datelor: Scalarea acestor date intercalate multimodale prezintă mai mult o provocare de inginerie decât construirea de seturi de date doar text sau imagine-text. Gestionarea documentelor de dimensiuni mult mai mari și păstrarea ordinii originale a imaginilor și textului este crucială.

- Diversitate: MINT-1T este primul din spațiul intercalat multimodal care adună documente multimodale de înaltă calitate la scară largă din surse precum PDF-uri CommonCrawl și ArXiv.

- Experimente model: Experimentele arată că LMM-urile antrenate pe MINT-1T nu numai că se potrivesc, ci și pot depăși performanța modelelor antrenate pe cel mai bun set de date open-source existent, OBELICS, oferind în același timp o creștere de zece ori la scară.

MINT-1T: Construirea setului de date

MINT-1T gestionează un set de date open-source la scară largă, care utilizează surse mai diverse de documente intercalate, cum ar fi PDF-uri și documente ArXiv. Această secțiune detaliază metodele MINT-1T pentru obținerea de documente multimodale, filtrarea conținutului de calitate scăzută, deduplicarea datelor și eliminarea materialelor nesigure pentru muncă sau NSFW și nedorite. Setul de date final cuprinde 922 de miliarde (B) de token-uri HTML, 106 miliarde de token-uri PDF și 9 miliarde de token-uri ArXiv.

Aprovizionarea cu cantități mari de documente multimodale

Pipeline HTML

MINT-1T urmează metoda OBELICS pentru extragerea documentelor multimodale intercalate din fișierele WARC CommonCrawl prin analizarea arborelui DOM al fiecărei intrări WARC. În timp ce OBELICS a procesat documente doar din februarie 2020 până în februarie 2023, depozitele CommonCrawl, MINT-1T a extins grupul de documente pentru a include documente HTML din mai 2017 până în aprilie 2024 (cu depozitări complete din octombrie 2018 până în aprilie 2024 și depozite parțiale din anii anteriori). Similar cu OBELICS, MINT-1T filtrează documentele care nu conțin imagini, mai mult de treizeci de imagini sau orice imagini cu adrese URL care includ subșiruri neadecvate, cum ar fi logo, avatar, porno și xxx.

PDF Pipeline

MINT-1T generează documente PDF din fișierele WAT CommonCrawl din februarie 2023 până în aprilie 2024. Inițial, toate linkurile PDF sunt extrase din aceste depozite. MINT-1T încearcă apoi să descarce și să citească PDF-uri folosind PyMuPDF, eliminând PDF-urile de peste 50 MB (conținând probabil imagini mari) și cele de peste 50 de pagini. Paginile fără text sunt excluse și se stabilește o ordine de citire pentru paginile rămase. Ordinea de citire este determinată de găsirea casetei de delimitare a tuturor blocurilor de text dintr-o pagină, gruparea blocurilor pe baza coloanelor și ordonarea lor de la stânga sus la dreapta jos. Imaginile sunt integrate în secvență pe baza apropierii lor de blocurile de text de pe aceeași pagină.

Conducta ArXiv

MINT-1T construiește documente intercalate ArXiv din codul sursă LaTeX folosind TexSoup pentru a găsi etichete de figuri și a intercala imagini cu textul hârtiei. Pentru lucrările cu mai multe fișiere, MINT-1T identifică fișierul principal Tex și înlocuiește etichetele de intrare cu conținutul fișierelor sale. Codul LaTeX este curățat prin eliminarea importurilor, bibliografiei, tabelelor și etichetelor de citare. Deoarece ArXiv este deja o sursă de date foarte bine îngrijită, nu se efectuează nicio filtrare și deduplicare suplimentară.

Filtrarea calității textului

MINT-1T evită utilizarea euristicii bazate pe model pentru filtrarea textului, urmând practicile stabilite de RefinedWeb, Dolma și FineWeb. Inițial, documentele care nu sunt în limba engleză sunt eliminate folosind modelul de identificare a limbii Fasttext (cu un prag de încredere de 0.65). Documentele cu adrese URL care conțin subșiruri NSFW sunt, de asemenea, eliminate pentru a exclude conținutul pornografic și nedorit. Se aplică metode de filtrare a textului de la RefinedWeb, în special eliminând documentele cu n-grame duplicate excesive sau cele identificate ca fiind de calitate scăzută folosind regulile MassiveText.

Filtrarea imaginilor

După curatarea fișierelor PDF și HTML, MINT-1T încearcă să descarce toate adresele URL ale imaginilor din setul de date HTML, eliminând linkurile care nu pot fi recuperate și eliminând documentele fără linkuri de imagine valide. Imaginile mai mici de 150 de pixeli sunt eliminate pentru a evita imaginile zgomotoase, cum ar fi logo-uri și pictograme, iar imaginile mai mari de 20,000 de pixeli sunt, de asemenea, eliminate, deoarece de obicei corespund imaginilor în afara subiectului. Pentru documentele HTML, imaginile cu un raport de aspect mai mare de două sunt eliminate pentru a filtra imaginile de calitate scăzută, cum ar fi bannere publicitare. Pentru PDF-uri, pragul este ajustat la trei pentru a păstra cifrele și tabelele științifice.

Figura de mai sus reprezintă modul în care MINT-1T include în mod unic date din PDF-uri și documente ArXiv dincolo de sursele HTML.

Filtrare de siguranță

- Filtrarea imaginilor NSFW: MINT-1T aplică un detector de imagine NSFW tuturor imaginilor din setul de date. Dacă un document conține o singură imagine NSFW, întregul document este aruncat.

- Eliminarea informațiilor de identificare personală: Pentru a atenua riscul scurgerii de date cu caracter personal, adresele de e-mail și adresele IP din datele text sunt anonimizate. E-mailurile sunt înlocuite cu șabloane precum „[e-mail protejat]” și IP-uri cu IP-uri nefuncționale generate aleatoriu.

Deduplicarea

MINT-1T efectuează deduplicarea paragrafelor și a textului documentului în fiecare instantaneu CommonCrawl și deduplicare a imaginii pentru a elimina imaginile repetitive, neinformative, cum ar fi pictogramele și logo-urile. Toți pașii de deduplicare sunt desfășurați separat pentru fiecare sursă de date.

Deduplicarea paragrafelor și documentelor

Urmând metodologia Dolma, MINT-1T folosește un filtru Bloom pentru deduplicarea eficientă a textului, setând rata fals pozitive la 0.01 și deduplicand paragrafele de 13 grame (indicate prin delimitatori dublu de linie nouă) din fiecare document. Dacă mai mult de 80% din paragrafele unui document sunt duplicate, întregul document este aruncat.

Înlăturarea textului standard comun

După deduplicarea paragrafelor, MINT-1T elimină propozițiile scurte comune din documentele HTML, cum ar fi „Săriți la conținut” sau „Arhiva blogului”. Acest lucru se realizează prin deduplicarea exactă a paragrafelor pe 2% din fiecare instantaneu CommonCrawl, în conformitate cu practicile CCNet, asigurând în principal eliminarea textului standard comun.

Figura de mai sus demonstrează procesul de filtrare pentru MINT-1T și arată cum jetoanele sunt eliminate de-a lungul conductei de date pentru documentele HTML, PDF și ArXiv.

Deduplicarea imaginii

În cadrul fiecărui instantaneu CommonCrawl, MINT-1T elimină imaginile care apar frecvent pe baza hashurilor SHA256. În loc de deduplicarea strictă, doar imaginile care apar de mai mult de zece ori într-un instantaneu sunt eliminate, urmând practicile Multimodal-C4. În conformitate cu OBELICS, imaginile repetate dintr-un singur document sunt eliminate, păstrând doar prima apariție.

Infrastructură

Pe parcursul procesării datelor, MINT-1T a avut acces la o medie de 2,350 de nuclee CPU dintr-un amestec de 190 de procesoare și 90 de noduri de procesor. În total, aproximativ 4.2 milioane de ore CPU au fost folosite pentru a construi acest set de date.

Comparând compoziția documentului în MINT-1T cu OBELICS

În evaluarea compoziției seturilor de date intercalate, sunt examinate două caracteristici cheie: distribuția simbolurilor de text pe document și numărul de imagini per document. Pentru această analiză, 50,000 de documente au fost prelevate aleatoriu atât din OBELICS, cât și din fiecare sursă de date din MINT-1T. GPT-2 Tokenizer a fost folosit pentru a calcula numărul de jetoane text. Valorile aberante au fost eliminate prin excluderea documentelor care nu se încadrau în intervalul intercuartil de 1.5 pentru numărul de simboluri text și imagini. După cum se arată în figura următoare, subsetul HTML al MINT-1T se aliniază îndeaproape cu distribuția de token văzută în OBELICS. Cu toate acestea, documentele provenite din PDF-uri și ArXiv tind să fie mai lungi decât documentele HTML, în medie, evidențiind beneficiile aprovizionării datelor din diverse surse. Figura 5 examinează densitatea imaginii în toate documentele, dezvăluind că PDF-urile și documentele ArXiv conțin mai multe imagini în comparație cu documentele HTML, mostrele ArXiv fiind cele mai dense de imagini.

Cum diferitele surse de date îmbunătățesc diversitatea documentelor?

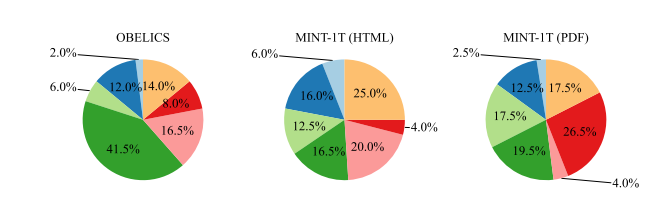

O motivație importantă pentru extinderea grupului de documente multimodale dincolo de HTML este îmbunătățirea acoperirii domeniului. Pentru a cuantifica diversitatea și profunzimea acestei acoperiri, un model Latent Dirichlet Allocation (LDA) a fost instruit pe 100,000 de documente eșantionate din setul de date OBELICS, subsetul HTML al MINT-1T și subsetul PDF (excluzând ArXiv) de la MINT-1T la obține 200 de subiecte. GPT-4 a fost apoi folosit pentru a clasifica setul de cuvinte pentru a identifica domeniile dominante – cum ar fi Sănătate și Medicină, Știință, Afaceri, Științe Umaniste, Istorie etc. – pe baza domeniilor MMMU. Analiza relevă tendințe distincte în distribuția domeniilor:

- OBELICI: Acest set de date arată o concentrare pronunțată în „Științe umaniste și științe sociale”. Acest lucru poate fi atribuit procesului său de construcție a datelor, care implică filtrarea documentelor care nu seamănă cu articolele Wikipedia, modificând astfel distribuția către cunoștințe mai generale și conținut centrat pe științe umaniste.

- Subsetul HTML al lui MINT-1T: Spre deosebire de OBELICS, subsetul HTML al MINT-1T nu este puternic părtinitor către niciun domeniu specific, sugerând o reprezentare a domeniului mai largă și mai echilibrată.

- Subsetul PDF al lui MINT-1T: Există o proporție mai mare de documente „Știință și tehnologie” în documentele PDF ale MINT-1T. Această tendință se datorează probabil naturii comunicării științifice, unde PDF-urile sunt formatul preferat pentru partajarea lucrărilor detaliate de cercetare și a rapoartelor tehnice.

MINT-1T: Rezultate și experimente

Pentru toate experimentele, MINT-1T antrenează modelul pe 50% loturi de subtitrări imagine-text și 50% loturi intercalate multimodale. Un maxim de 2048 de jetoane multimodale sunt eșantionate din fiecare document intercalat și 340 de jetoane din fiecare eșantion imagine-text. Similar cu Flamingo, se adaugă un simbol „sfârșit” pentru a indica sfârșitul unei secvențe imagine-text adiacent. În timpul antrenamentului, 50% dintre documentele intercalate cu o singură imagine sunt aruncate aleatoriu în documente cu mai multe imagini. Setul de date imagine-text este compus dintr-un amestec de seturi de date de subtitrări organizate intern. Capacitatea modelului de a raționa despre secvențe intercalate multimodale este evaluată prin abilitățile sale de învățare în context și prin performanța raționamentului cu mai multe imagini.

Figura de mai sus ilustrează procentul de documente din fiecare domeniu în MMMU pentru OBELICS și subseturile MINT-1T.

Învățare în context: Modelele sunt evaluate pe baza performanțelor de învățare în context de patru și opt shot-uri pe diferite benchmark-uri de subtitrare (COCO (test Karpathy) și TextCaps (validare)) și seturi de date vizuale cu răspunsuri la întrebări (VQAv2 (validare), OK-VQA (validare) , TextVQA (validare) și VizWiz (validare)). Demonstrațiile sunt prelevate aleatoriu din setul de antrenament. Scorurile sunt mediate pe mai multe runde de evaluare, cu demonstrații randomizate pentru a ține cont de sensibilitatea la solicitările alese. Diferite solicitări sunt eliminate pentru fiecare sarcină pentru a le selecta pe cele mai performante.

Raționament cu mai multe imagini: Modelele sunt evaluate pe MMMU (conținând atât întrebări cu o singură imagine, cât și cu mai multe imagini) și Mantis-Eval (toate întrebările cu mai multe imagini) pentru a testa abilitățile de raționament cu mai multe imagini dincolo de evaluările de învățare în context.

Instruire pe documente HTML

Inițial, porțiunea HTML a lui MINT-1T este comparată cu OBELICS, deoarece OBELICS este setul de date intercalat lider anterior, de asemenea, strâns din documente HTML. Două modele sunt instruite pe porțiunile HTML ale MINT-1T și OBELICS pentru un total de 10B jetoane multimodale. Performanța lor de învățare în context este evaluată. Următorul tabel prezintă performanța în 4 și 8 lovituri pe benchmark-uri comune; modelul instruit pe documentele HTML MINT-1T are performanțe mai bune decât OBELICS la sarcinile VQA, dar mai rău la benchmark-urile de subtitrări. În medie, OBELICS are performanțe puțin mai bune decât MINT-1T (HTML).

Adăugarea documentelor PDF și ArXiv

Ulterior, instruirea este efectuată pe sursele complete de date ale MINT-1T, cu un amestec de documente HTML, PDF și ArXiv. Documentele intercalate sunt eșantionate cu 50% din HTML, 45% din PDF-uri și 5% din ArXiv. Modelul este antrenat pentru un total de 10B jetoane multimodale. După cum se vede în tabelul de mai sus, modelul antrenat pe amestecul complet de date MINT-1T depășește OBELICS și MINT-1T (HTML) la majoritatea benchmark-urilor de învățare în context. Pe criterii de referință mai complexe de raționament multimodal, modelul MINT-1T depășește OBELICS pe MMMU, dar are performanțe mai slabe pe Mantis-Eval.

Tendințe fine

Cum se scalează performanța învățării în context cu demonstrații?

Performanța învățării în context este evaluată atunci când vi se solicită cu una până la opt demonstrații. Se desfășoară o singură încercare pe număr de lovituri pentru fiecare etalon de evaluare. După cum se vede în figura următoare, modelul antrenat pe MINT-1T depășește modelul antrenat pe subsetul HTML al MINT-1T și OBELICS în toate fotografiile. Modelul MINT-1T (HTML) are performanțe puțin mai slabe decât OBELICS.

Performanță la sarcinile de subtitrări și răspunsuri vizuale la întrebări

Următoarea figură prezintă performanța medie de învățare în context la punctele de referință pentru subtitrări și răspunsuri vizuale la întrebări (VQA). OBELICS depășește toate variantele MINT-1T la standardele de referință pentru subtitrări în patru fotografii și are performanțe puțin mai slabe în comparație cu MINT-1T la subtitrarea în opt fotografii. Cu toate acestea, MINT-1T depășește semnificativ ambele linii de bază în ceea ce privește benchmark-urile VQA. MINT-1T (HTML) depășește, de asemenea, OBELICS în sarcinile VQA.

Performanță pe diferite domenii

Includerea diverselor domenii în MINT-1T are ca scop îmbunătățirea generalizării modelului. Figura de mai sus prezintă performanța pe MMMU pentru fiecare domeniu. Cu excepția domeniului Business, MINT-1T depășește OBELICS și MINT-1T (HTML). Creșterea performanței în domeniile Știință și Tehnologie pentru MINT-1T este atribuită prevalenței acestor domenii în documentele ArXiv și PDF.

Gânduri finale

În acest articol am vorbit despre MINT-1T, cel mai mare și mai divers set de date open-source intercalate multimodal de până acum. MINT-1T: O scară de 10 ori mai mare, inclusiv un trilion de simboluri text și 3.4 miliarde de imagini decât seturile de date open-source existente. Setul de date MINT-1T introduce, de asemenea, surse care nu au fost expuse niciodată, cum ar fi fișierele PDF, documentele ArXiv. Deoarece seturile de date intercalate multimodale nu se scalează ușor, este important ca setul de date MINT-1T să partajeze procesul de conservare a datelor, astfel încât și alții să poată efectua experimente pe astfel de variante bogate în informații. Setul de date MINT-1T demonstrează că metoda sa; Modelele LM instruite pe MINT-1T sunt competitive (deși oarecum) față de OBELICS anterioare de ultimă generație.