Inteligența artificială

Mai puțin este mai mult: de ce preluarea mai puține documente poate îmbunătăți răspunsurile AI

Recuperare-Augmented Generation (RAG) este o abordare a construirii sistemelor AI care combină un model lingvistic cu o sursă externă de cunoștințe. În termeni simpli, AI caută mai întâi documente relevante (cum ar fi articole sau pagini web) legate de interogarea unui utilizator și apoi folosește acele documente pentru a genera un răspuns mai precis. Această metodă a fost celebrată pentru ajutor modele de limbaj mari (LLM) rămâneți faptici și reduceți halucinațiile prin fundamentarea răspunsurilor lor în date reale.

Intuitiv, s-ar putea crede că cu cât un AI preia mai multe documente, cu atât va fi mai bine informat răspunsul său. Cu toate acestea, cercetările recente sugerează o întorsătură surprinzătoare: când vine vorba de furnizarea de informații către o IA, uneori mai puțin înseamnă mai mult.

Mai puține documente, răspunsuri mai bune

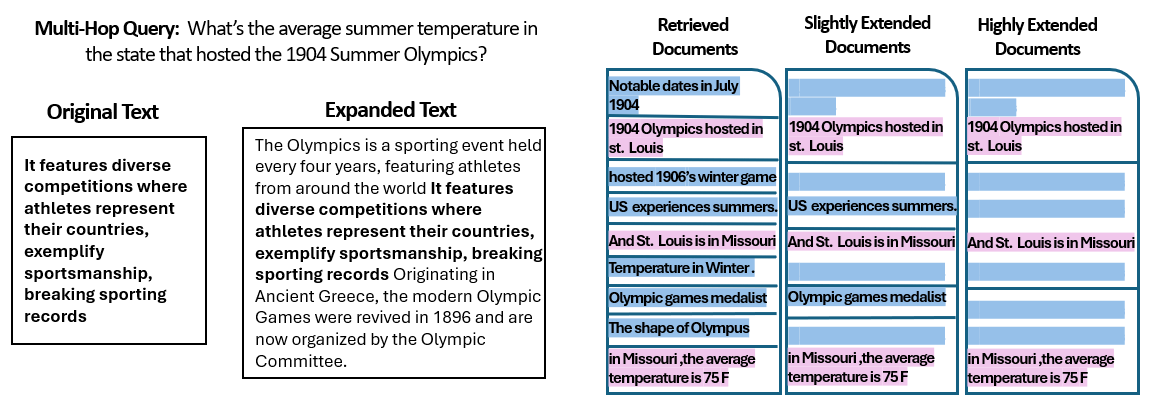

A nou studiu de către cercetătorii de la Universitatea Ebraică din Ierusalim au explorat modul în care număr a documentelor date unui sistem RAG afectează performanța acestuia. În mod esențial, au păstrat constantă cantitatea totală de text - ceea ce înseamnă că, dacă erau furnizate mai puține documente, acele documente au fost ușor extinse pentru a umple aceeași lungime ca multe documente. În acest fel, orice diferență de performanță ar putea fi atribuită cantității de documente, mai degrabă decât pur și simplu o introducere mai scurtă.

Cercetătorii au folosit un set de date cu răspunsuri la întrebări (MuSiQue) cu întrebări trivia, fiecare asociată inițial cu 20 de paragrafe Wikipedia (doar câteva dintre ele conțin de fapt răspunsul, restul fiind elemente de distracție). Reducerea numărului de documente de la 20 la doar 2-4 documente cu adevărat relevante – și umplerea celor cu un pic de context suplimentar pentru a menține o lungime constantă – au creat scenarii în care AI avea mai puține materiale de luat în considerare, dar totuși aproximativ aceleași cuvinte totale de citit.

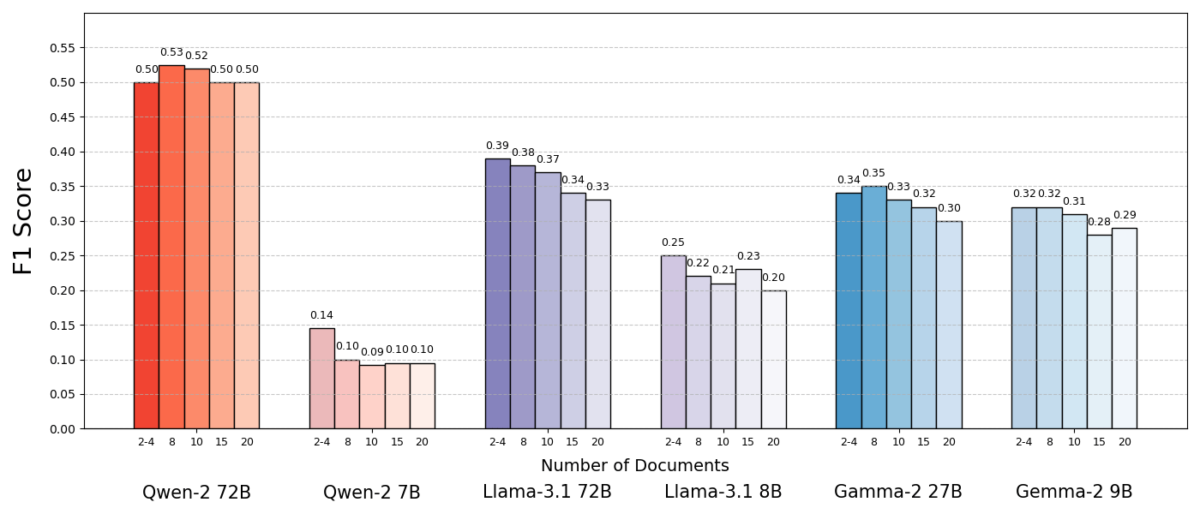

Rezultatele au fost izbitoare. În cele mai multe cazuri, modelele AI au răspuns mai precis atunci când li s-au oferit mai puține documente decât setul complet. Performanța s-a îmbunătățit semnificativ – în unele cazuri cu până la 10% în precizie (scor F1) când sistemul a folosit doar câteva documente justificative în loc de o colecție mare. Acest impuls contraintuitiv a fost observat în mai multe modele diferite de limbaj open-source, inclusiv variante ale lui Meta's Llama și altele, ceea ce indică faptul că fenomenul nu este legat de un singur model AI.

Un model (Qwen-2) a fost o excepție notabilă care a gestionat mai multe documente fără o scădere a scorului, dar aproape toate modelele testate au funcționat mai bine cu mai puține documente în general. Cu alte cuvinte, adăugarea mai multor materiale de referință dincolo de piesele cheie relevante le-a afectat de fapt performanța mai des decât a ajutat.

Sursa: Levy et al.

De ce este aceasta o astfel de surpriză? În mod obișnuit, sistemele RAG sunt proiectate pe baza ipotezei că recuperarea unei game mai largi de informații poate ajuta doar AI - la urma urmei, dacă răspunsul nu este în primele câteva documente, ar putea fi în al zecelea sau al douăzecilea.

Acest studiu răstoarnă acel scenariu, demonstrând că adunarea fără discernământ pe documente suplimentare poate fi inversă. Chiar și atunci când lungimea totală a textului a fost menținută constantă, simpla prezență a multor documente diferite (fiecare cu propriul context și ciudații) a făcut ca sarcina de răspuns la întrebări să fie mai dificilă pentru AI. Se pare că, dincolo de un anumit punct, fiecare document suplimentar a introdus mai mult zgomot decât semnal, derutând modelul și afectând capacitatea acestuia de a extrage răspunsul corect.

De ce mai puțin poate fi mai mult în RAG

Acest rezultat „mai puțin înseamnă mai mult” are sens odată ce luăm în considerare modul în care modelele de limbaj AI procesează informațiile. Atunci când unui AI i se oferă doar cele mai relevante documente, contextul pe care îl vede este concentrat și lipsit de distrageri, la fel ca unui student căruia i-au fost înmânate doar paginile potrivite pentru a studia.

În studiu, modelele au avut rezultate semnificativ mai bune atunci când au primit doar documentele justificative, cu materialul irelevant eliminat. Contextul rămas nu era doar mai scurt, ci și mai curat – conținea fapte care indicau direct răspunsul și nimic altceva. Cu mai puține documente de jonglat, modelul și-ar putea dedica toată atenția informațiilor pertinente, făcându-l mai puțin probabil să fie deturnat sau confuz.

Pe de altă parte, atunci când multe documente au fost preluate, AI a trebuit să cerceteze un amestec de conținut relevant și irelevant. Adesea, aceste documente suplimentare erau „similare, dar fără legătură” – ele puteau împărtăși un subiect sau cuvinte cheie cu interogarea, dar să nu conțină de fapt răspunsul. Un astfel de conținut poate induce în eroare modelul. Inteligența artificială ar putea pierde efort încercând să conecteze puncte între documente care nu conduc de fapt la un răspuns corect sau, mai rău, ar putea îmbina informații din mai multe surse incorect. Acest lucru crește riscul de halucinații - cazuri în care AI generează un răspuns care sună plauzibil, dar care nu este bazat pe o singură sursă.

În esență, alimentarea cu prea multe documente la model poate dilua informațiile utile și poate introduce detalii conflictuale, făcând mai greu pentru AI să decidă ce este adevărat.

Interesant este că cercetătorii au descoperit că, dacă documentele suplimentare erau în mod evident irelevante (de exemplu, text aleatoriu fără legătură), modelele au fost mai bune în a le ignora. Problema reală provine din datele care distrag atenția care par relevante: atunci când toate textele preluate sunt pe subiecte similare, AI presupune că ar trebui să le folosească pe toate și poate avea dificultăți să spună care detalii sunt de fapt importante. Acest lucru se aliniază cu observația studiului că distractoarele aleatorii au cauzat mai puțină confuzie decât distractorii realiști în intrare. Inteligența artificială poate filtra prostiile flagrante, dar informațiile subtil în afara subiectului sunt o capcană zgomotoasă - se strecoară sub pretextul relevanței și deraiează răspunsul. Prin reducerea numărului de documente doar la cele cu adevărat necesare, evităm în primul rând să punem aceste capcane.

Există, de asemenea, un beneficiu practic: preluarea și procesarea mai puține documente reduce cheltuielile de calcul pentru un sistem RAG. Fiecare document care este introdus trebuie analizat (încorporat, citit și îngrijit de model), care utilizează timp și resurse de calcul. Eliminarea documentelor superflue face sistemul mai eficient – poate găsi răspunsuri mai rapid și la un cost mai mic. În scenariile în care precizia s-a îmbunătățit prin concentrarea pe mai puține surse, obținem un câștig pentru toate: răspunsuri mai bune și un proces mai simplu și mai eficient.

Sursa: Levy et al.

Regândirea RAG: Direcții viitoare

Această nouă dovadă că calitatea bate adesea cantitatea în recuperare are implicații importante pentru viitorul sistemelor AI care se bazează pe cunoștințe externe. Acesta sugerează că proiectanții sistemelor RAG ar trebui să prioritizeze filtrarea inteligentă și clasarea documentelor față de volumul absolut. În loc să aduci 100 de pasaje posibile și să sperăm că răspunsul este îngropat acolo undeva, ar putea fi mai înțelept să aduci doar câteva dintre cele mai relevante.

Autorii studiului subliniază necesitatea metodelor de regăsire pentru a „atinge un echilibru între relevanță și diversitate” în informațiile pe care le furnizează unui model. Cu alte cuvinte, dorim să oferim suficientă acoperire a subiectului pentru a răspunde la întrebare, dar nu atât de mult încât faptele de bază să fie înecate într-o mare de text străin.

Mergând mai departe, cercetătorii sunt probabil să exploreze tehnici care ajută modelele AI să gestioneze mai multe documente cu mai multă grație. O abordare este de a dezvolta sisteme de retriever sau re-rankere mai bune care pot identifica ce documente adaugă cu adevărat valoare și care introduc doar conflicte. Un alt unghi este îmbunătățirea modelelor de limbaj în sine: dacă un model (cum ar fi Qwen-2) a reușit să facă față multor documente fără a pierde acuratețea, examinarea modului în care a fost antrenat sau structurat ar putea oferi indicii pentru a face alte modele mai robuste. Poate că viitoarele modele de limbaj mari vor încorpora mecanisme pentru a recunoaște când două surse spun același lucru (sau se contrazic) și se vor concentra în consecință. Scopul ar fi acela de a permite modelelor să utilizeze o varietate bogată de surse fără a cădea pradă confuziei – obținând efectiv tot ce este mai bun din ambele lumi (largitatea informațiilor și claritatea focalizării).

De asemenea, merită remarcat faptul că Sistemele AI obțin ferestre de context mai mari (abilitatea de a citi mai mult text deodată), pur și simplu aruncarea mai multor date în prompt nu este un glonț de argint. Un context mai mare nu înseamnă automat o mai bună înțelegere. Acest studiu arată că, chiar dacă un AI poate citi din punct de vedere tehnic 50 de pagini la un moment dat, oferindu-i 50 de pagini de informații de calitate mixtă ar putea să nu dea un rezultat bun. Modelul beneficiază în continuare de a avea conținut curat și relevant cu care să lucreze, mai degrabă decât de o descărcare nediscriminată. De fapt, recuperarea inteligentă poate deveni și mai crucială în era ferestrelor de context gigantice - pentru a asigura că capacitatea suplimentară este utilizată pentru cunoștințe valoroase, mai degrabă decât pentru zgomot.

Constatările din „Mai multe documente, aceeași lungime” (lucrarea cu titlul potrivit) încurajează o reexaminare a ipotezelor noastre în cercetarea AI. Uneori, furnizarea unei IA cu toate datele pe care le avem nu este atât de eficientă pe cât credem. Concentrându-ne pe cele mai relevante informații, nu numai că îmbunătățim acuratețea răspunsurilor generate de inteligența artificială, ci și facem sistemele mai eficiente și mai ușor de încredere. Este o lecție contraintuitivă, dar cu ramificații interesante: viitoarele sisteme RAG ar putea fi atât mai inteligente, cât și mai slabe, alegând cu atenție mai puține documente mai bune de recuperat.