Inteligența artificială

Cerebras introduce cea mai rapidă soluție de inferență AI din lume: viteză de 20 ori la o fracțiune din cost

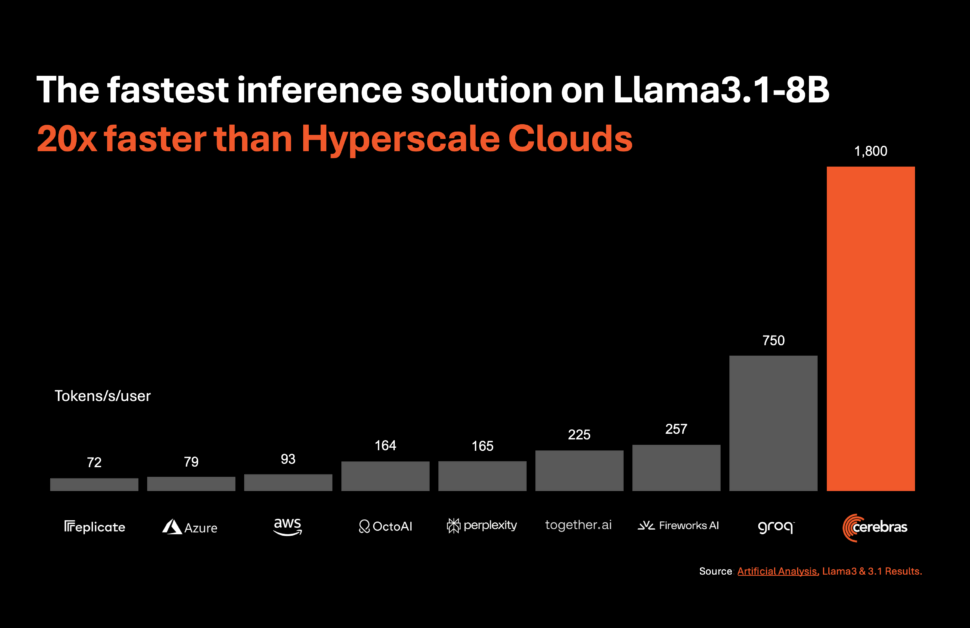

Sisteme cerebrale, un pionier în calculul AI de înaltă performanță, a introdus o soluție revoluționară care este setat să revoluționeze inferența AI. Pe 27 august 2024, compania a anunțat lansarea Cerebras Inference, cel mai rapid serviciu de inferență AI din lume. Cu valori de performanță care le depășesc pe cele ale sistemelor tradiționale bazate pe GPU, Cerebras Inference oferă o viteză de 20 de ori mai mare la o fracțiune din cost, stabilind un nou punct de referință în calculul AI.

Viteză și eficiență fără precedent

Cerebras Inference este conceput pentru a oferi performanțe excepționale în diferite modele de IA, în special în segmentul în evoluție rapidă a modele lingvistice mari (LLM-uri). De exemplu, procesează 1,800 de jetoane pe secundă pentru modelul Llama 3.1 8B și 450 de jetoane pe secundă pentru modelul Llama 3.1 70B. Această performanță nu este doar de 20 de ori mai rapidă decât cea a soluțiilor bazate pe GPU NVIDIA, dar are și un cost semnificativ mai mic. Cerebras oferă acest serviciu începând de la doar 10 cenți per milion de jetoane pentru modelul Llama 3.1 8B și 60 de cenți per milion de jetoane pentru modelul Llama 3.1 70B, reprezentând o îmbunătățire de 100 ori a prețului-performanță în comparație cu ofertele existente bazate pe GPU.

Menținerea preciziei în timp ce împingeți limitele vitezei

Unul dintre cele mai impresionante aspecte ale Cerebras Inference este capacitatea sa de a menține acuratețea de ultimă generație, oferind în același timp o viteză de neegalat. Spre deosebire de alte abordări care sacrifică precizia în favoarea vitezei, soluția Cerebras rămâne în domeniul de 16 biți pentru întreaga rulare a inferenței. Acest lucru asigură că câștigurile de performanță nu vin în detrimentul calității rezultatelor modelului AI, un factor crucial pentru dezvoltatorii concentrați pe precizie.

Micah Hill-Smith, co-fondator și CEO al Artificial Analysis, a subliniat semnificația acestei realizări: „Cerebras oferă viteze cu un ordin de mărime mai rapide decât soluțiile bazate pe GPU pentru modelele Meta Llama 3.1 8B și 70B AI. Măsurăm viteze de peste 1,800 de jetoane de ieșire pe secundă pe Llama 3.1 8B și peste 446 de jetoane de ieșire pe secundă pe Llama 3.1 70B – un nou record în aceste benchmark-uri.”

Importanța tot mai mare a inferenței AI

Inferența AI este segmentul de calcul AI cu cea mai rapidă creștere, reprezentând aproximativ 40% din piața totală a hardware-ului AI. Apariția inferenței AI de mare viteză, cum ar fi cea oferită de Cerebras, este asemănătoare cu introducerea internetului în bandă largă, deblocând noi oportunități și anuntând o nouă eră pentru aplicațiile AI. Cu Cerebras Inference, dezvoltatorii pot acum construi aplicații AI de ultimă generație care necesită performanțe complexe, în timp real, cum ar fi agenți AI și sisteme inteligente.

Andrew Ng, fondatorul DeepLearning.AI, a subliniat importanța vitezei în dezvoltarea AI: „DeepLearning.AI are mai multe fluxuri de lucru agentice care necesită solicitarea în mod repetat a unui LLM pentru a obține un rezultat. Cerebras a construit o capacitate de inferență impresionant de rapidă, care va fi de mare ajutor pentru astfel de sarcini de lucru.Matei 22:21

Sprijin larg în industrie și parteneriate strategice

Cerebras a obținut un sprijin puternic din partea liderilor din industrie și a format parteneriate strategice pentru a accelera dezvoltarea aplicațiilor AI. Kim Branson, SVP AI/ML la GlaxoSmithKline, unul dintre primele clienți Cerebras, a subliniat potențialul de transformare al acestei tehnologii: „Viteza și scara schimbă totul.”

Alte companii, cum ar fi LiveKit, dezorientare, și Meter, și-au exprimat, de asemenea, entuziasmul pentru impactul pe care Cerebras Inference îl va avea asupra operațiunilor lor. Aceste companii profită de puterea capabilităților de calcul ale Cerebras pentru a crea experiențe AI mai receptive, asemănătoare oamenilor, pentru a îmbunătăți interacțiunea utilizatorilor în motoarele de căutare și pentru a îmbunătăți sistemele de management al rețelei.

Inferență cerebrală: niveluri și accesibilitate

Cerebras Inference este disponibil pe trei niveluri la prețuri competitive: gratuit, dezvoltator și întreprindere. Nivelul gratuit oferă acces gratuit la API cu limite generoase de utilizare, făcându-l accesibil pentru o gamă largă de utilizatori. Nivelul pentru dezvoltatori oferă o opțiune de implementare flexibilă, fără server, cu modele Llama 3.1 la prețuri de 10 cenți și 60 de cenți per milion de jetoane. Nivelul Enterprise se adresează organizațiilor cu sarcini de lucru susținute, oferind modele ajustate, acorduri personalizate de nivel de servicii și asistență dedicată, cu prețuri disponibile la cerere.

Powering Cerebras Inference: The Wafer Scale Engine 3 (WSE-3)

În centrul Cerebras Inference se află sistemul Cerebras CS-3, alimentat de Wafer Scale Engine 3 (WSE-3), lider în industrie. Acest procesor AI este de neegalat în ceea ce privește dimensiunea și viteza, oferind o lățime de bandă de memorie de 7,000 de ori mai mare decât H100 de la NVIDIA. Scara masivă a WSE-3 îi permite să se ocupe de mulți utilizatori concurenți, asigurând viteze extraordinare fără a compromite performanța. Această arhitectură permite Cerebras să evite compromisurile care afectează de obicei sistemele bazate pe GPU, oferind cea mai bună performanță din clasă pentru sarcinile de lucru AI.

Integrare perfectă și API-ul prietenos pentru dezvoltatori

Cerebras Inference este conceput pentru dezvoltatori. Dispune de un API care este pe deplin compatibil cu API-ul OpenAI Chat Completions, permițând o migrare ușoară cu modificări minime de cod. Această abordare prietenoasă pentru dezvoltatori asigură că integrarea Cerebras Inference în fluxurile de lucru existente este cât mai simplă posibil, permițând implementarea rapidă a aplicațiilor AI de înaltă performanță.

Cerebras Systems: Stimularea inovației în toate industriile

Cerebras Systems nu este doar un lider în calculul AI, ci și un jucător cheie în diverse industrii, inclusiv asistența medicală, energie, guvern, calcul științific și servicii financiare. Soluțiile companiei au fost esențiale în realizarea unor progrese în instituții precum Laboratoarele Naționale, Aleph Alpha, Clinica Mayo și GlaxoSmithKline.

Oferind viteză, scalabilitate și acuratețe de neegalat, Cerebras permite organizațiilor din aceste sectoare să abordeze unele dintre cele mai dificile probleme din AI și nu numai. Fie că este vorba de accelerarea descoperirii de medicamente în domeniul sănătății sau de îmbunătățirea capacităților de calcul în cercetarea științifică, Cerebras este în fruntea inovației.

Concluzie: O nouă eră pentru inferența AI

Cerebras Systems stabilește un nou standard pentru inferența AI odată cu lansarea Cerebras Inference. Oferind de 20 de ori viteza sistemelor tradiționale bazate pe GPU, la o fracțiune din cost, Cerebras nu numai că face AI mai accesibilă, ci și deschide calea pentru următoarea generație de aplicații AI. Cu tehnologia sa de ultimă oră, parteneriatele strategice și angajamentul față de inovare, Cerebras este gata să conducă industria AI într-o nouă eră de performanță și scalabilitate fără precedent.

Pentru mai multe informații despre Cerebras Systems și pentru a încerca Cerebras Inference, vizitați www.cerebras.ai.