Inteligența artificială

O introducere în IA Vertex

Având în vedere peisajul în rapidă evoluție al Inteligenței Artificiale, unul dintre cele mai mari obstacole cu care se confruntă adesea liderii din domeniul tehnologiei este tranziția de la a fi „experimental” la a fi „pregătit pentru întreprindere”. Deși chatboții pentru consumatori și o platformă interactivă ajută la imaginația publicului, afacerile nu pot avea succes doar cu o interfață de chat. Într-o eră în care concurența este mai agresivă ca niciodată, afacerile au nevoie de un ecosistem robust, scalabil și sigur, iar acesta este ceea ce Google încearcă să ofere cu... Vertex AI, platforma unificată de inteligență artificială și învățare automată a Google Cloud.

Vertex AI încearcă să se consolideze ca coloană vertebrală pentru integrarea IA generativă cu infrastructura cloud modernă, oferind o suită cuprinzătoare de caracteristici care elimină decalajul dintre modelele de bază brute și aplicațiile de producție. Vertex AI nu este doar un încapsulator pentru modele lingvistice mari (LLM), ci mai degrabă un ecosistem unificat de învățare automată și inteligență artificială (ML/AI) care tratează IA generativă ca pe un cetățean de primă clasă al infrastructurii cloud moderne.

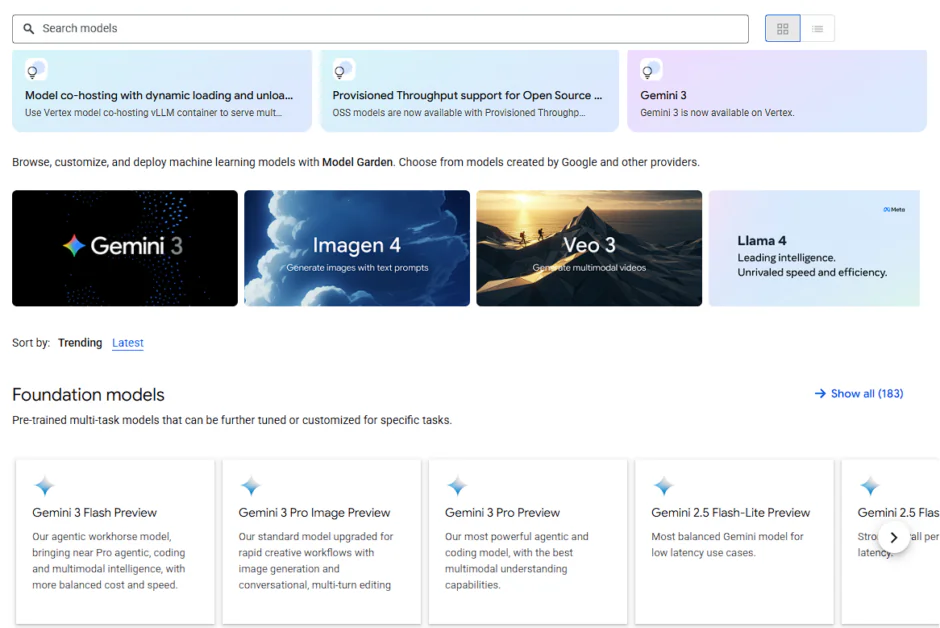

În inima Vertex AI se află Model Garden, o piață centrală care oferă acces la peste 200 de modele fundamentale atent selecționate, inclusiv puternica platformă multimodală Gemini 2.5 Pro, care dispune de o fereastră contextuală uimitoare de 2 milioane de token-uri. În acest articol, vom analiza arhitectura Vertex AI, vom explora modul în care Model Garden servește drept „App Store” pentru inteligență în industrie și vom analiza pilonii tehnici care fac din această platformă coloana vertebrală a următoarei generații de software pentru întreprinderi.

Arhitectura de bază: o platformă unificată

Vertex AI nu este o colecție slab cuplată de instrumente, ci mai degrabă un ecosistem unificat de date și IA, conceput pentru a reduce fragmentarea datelor, instrumentelor și echipelor care afectează învățarea automată până în prezent. În mod tradițional, dezvoltarea IA are loc în medii izolate și, uneori, datele sunt răspândite și blocate în mai multe depozite. De exemplu, organizațiile ar putea stoca datele clienților în depozite SQL, în timp ce documentele nestructurate sunt depozitate într-un Data Lake. Atunci când datele sunt izolate, IA vede doar un „adevăr parțial”, ceea ce duce la rezultate părtinitoare sau la rate ridicate de halucinații, deoarece îi lipsește contextul complet al întreprinderii.

Vertex AI încearcă să integreze întregul ciclu de viață, de la ingerarea datelor brute în BigQuery și Cloud Storage până la monitorizarea producției, servind în esență ca un „țesut conjunctiv” între aceste silozuri. Vertex AI se integrează nativ cu Cloud Storage și BigQuery, permițând modelelor de inteligență artificială să recupereze datele fără conducte complexe de extragere, transformare și încărcare.

Fundația: Hipercomputerul cu inteligență artificială al Google

Stratul GenAI al Vertex AI se află pe arhitectura AI Hypercomputer a Google, un sistem integrat de supercomputing, care constă din:

TPU v5p și v5e (Unități de procesare Tensor)

Unitățile de procesare tensorial Google sunt ASIC-uri (circuite integrate specifice aplicației) construite la comandă, concepute special pentru multiplicarea matricei care definește învățarea profundă.

- TPU v5p (Performanță): Acesta este acceleratorul emblematic pentru antrenament la scară largă. Fiecare pod TPU v5p poate fi scalat până la 8,960 de cipuri interconectate prin intermediul Inter-Chip Interconnect (ICI) de la Google, cu cea mai mare lățime de bandă, la 4,800 Gbps. Pentru un lider tehnic, aceasta înseamnă un antrenament de 2.8 ori mai rapid pentru un model de dimensiuni GPT-3 (175 de miliarde de parametri) comparativ cu generația anterioară, reducând drastic timpul de lansare pe piață.

- TPU v5e (Eficiență): Conceput pentru performanță „optimizată din punct de vedere al costurilor”, v5e este soluția ideală pentru antrenament la scară medie și inferență de mare randament. Oferă un raport preț-performanță de până la 2.5 ori mai bun, ceea ce îl face alegerea ideală pentru companiile care trebuie să ruleze inferențe 24/7 fără un buget masiv.

GPU-uri NVIDIA H100/A100 pentru flexibilitate

Deși TPU-urile sunt specializate, multe echipe de dezvoltare se bazează pe ecosistemul NVIDIA CUDA. Vertex AI oferă asistență de primă clasă pentru cele mai recente componente hardware de la NVIDIA:

- NVIDIA H100 (Hopper): Ideal pentru reglarea fină a celor mai mari modele open-source (cum ar fi Llama 3.1 405B) care necesită o lățime de bandă masivă de memorie.

- Rețeaua Jupiter: Pentru a preveni „blocajul rețelei”, Google folosește structura de rețea a centrelor de date Jupiter. Aceasta asigură că datele se deplasează între GPU-uri la o viteză fulgerătoare, suportând RDMA (Remote Direct Memory Access) pentru a ocoli supraîncărcarea procesorului și a oferi performanțe aproape locale pe noduri distribuite.

Orchestrație dinamică

Cea mai importantă schimbare tehnică în Vertex AI este Orchestrație dinamicăÎntr-un mediu vechi, dacă un nod GPU se defectează în timpul unei perioade de antrenament de 3 săptămâni, întreaga lucrare s-ar putea bloca.

- Reziliență automatizată: IA Vertex, adesea alimentată de Google Kubernetes Engine (GKE) Sub capotă, dispune de noduri „auto-reparatoare”. Dacă se detectează o eroare hardware, platforma migrează automat volumul de lucru către un nod sănătos.

- Planificator dinamic de sarcină de lucru: Acest instrument permite echipelor să solicite capacitate în funcție de urgență. Puteți opta pentru Flex Start (mai ieftin, pornește atunci când este disponibilă capacitate) sau Guaranteed Capacity pentru versiuni critice.

- Instruire fără server: Pentru echipele care nu doresc nicio gestionare a infrastructurii, Vertex AI Serverless Training vă permite să trimiteți codul și datele; platforma furnizează clusterul, rulează jobul și îl demontează, taxându-vă doar pentru secundele de calcul utilizate.

Cele trei puncte de intrare: descoperire, experimentare și automatizare

Pentru a se adapta diferitelor personalități tehnice - de la specialiști în date la dezvoltatori de aplicații - Vertex AI oferă trei puncte de acces principale:

- Model GardenPiața pentru descoperiri.

- Vertex AI StudioLocul de joacă pentru experimentare.

- Vertex AI Agent BuilderFabrica de Automatizare.

Grădina Model: Piața pentru Descoperiri

Vertex AI Model Garden din Google Cloud este o platformă centralizată în cadrul Google Cloud pentru descoperirea, testarea, personalizarea și implementarea unei game largi de modele AI first-party, open-source și third-party, inclusiv modele multimodale (viziune, text, cod) pentru diverse nevoi de afaceri, oferind o integrare perfectă cu instrumentele Vertex AI pentru MLO-uri simplificate. Acționează ca o bibliotecă cuprinzătoare, ajutând dezvoltatorii și companiile să selecteze modelul potrivit (de la modele de bază mari la modele specializate) pentru sarcinile lor, fie că este vorba de generarea de text, analiza imaginilor sau completarea codului, și să le implementeze eficient în mediul lor Google Cloud.

Model Garden își clasifică cele peste 200 de modele în trei niveluri distincte, permițând arhitecților să echilibreze performanța, costul și controlul:

- Modele proprietare (Google): Acestea sunt modelele multimodale emblematice disponibile în cadrul Vertex AI, iar Google le oferă în diferite dimensiuni, de la Pro cu raționament complex până la Flash cu latență redusă și volum mare, permițând astfel dezvoltatorilor să își optimizeze modelele în funcție de cazurile lor de utilizare.

- Modele terțe (proprietare): Prin intermediul unor parteneriate strategice, Vertex AI oferă acces „Model-as-a-Service” (MaaS) către titani precum Anthropic (Claude 3.5) și Mistral AI. În loc să gestioneze separat facturarea și acreditările de securitate pentru cinci furnizori de inteligență artificială diferiți, o echipă tehnică îi poate accesa pe toți prin intermediul proiectului Google Cloud existent, utilizând un format API unificat.

- Modele open-source și open-weight: Acest nivel include Lama lui Meta 3.2, Mistralși propriile companii Google MugurAcestea sunt ideale pentru organizațiile care doresc să implementeze singure modele în propriul VPC (Virtual Private Cloud) pentru a asigura o izolare maximă a datelor.

Într-un mediu neunificat, implementarea unui model open-source precum Llama necesită configurarea unui mediu PyTorch, configurarea driverelor CUDA și gestionarea unui wrapper Flask sau FastAPI.

Grădina Model elimină această fază de „Munging” prin Endpoint-uri gestionate unificat:

- Implementare cu un singur clic: Pentru multe modele, dacă se dă clic pe „Implementare”, se furnizează automat resursele TPU/GPU necesare, se încadrează modelul într-un container pregătit pentru producție și se oferă un endpoint API REST.

- Integrarea feței îmbrățișate: Vertex AI permite acum dezvoltatorilor să implementeze modele direct din Hugging Face Hub într-un endpoint Vertex, oferind o extindere aproape infinită a inteligenței disponibile.

- Conectare la servicii private (PSC): Pentru industriile extrem de reglementate, modelele pot fi implementate folosind Private Service Connect, asigurându-se că endpoint-ul modelului nu este niciodată expus la internetul public - menținând traficul de date strict în rețeaua corporativă.

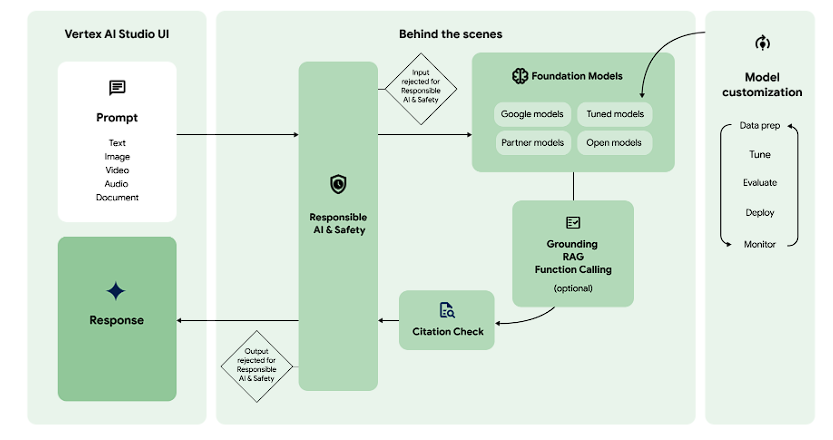

Vertex AI Studio: Locul de joacă pentru experimentare

În timp ce Model Garden este vorba despre selecție, Vertex AI Studio este despre precizie. Vertex AI Studio poate fi comparat cu compilatoarele și depanatoarele pe care le întâlniți în lumea software-ului tradițional. Vertex AI Studio este spațiul de lucru în care modelele brute sunt sculptate în instrumente de business specifice printr-o combinație de inginerie promptă, testare multimodală și reglare avansată a hiperparametrilor.

Prototipare multimodală: Dincolo de text

Una dintre caracteristicile remarcabile ale Studio este suportul nativ pentru multimodalitateÎn timp ce alte platforme necesită codare complexă pentru a gestiona date non-text, Vertex AI Studio vă permite să plasați fișiere direct în interfață pentru a testa Gemini 2.5 capacități de raționament.

- Inteligență video: Puteți încărca o prezentare tehnică de 45 de minute și să solicitați modelului să „identifice de fiecare dată când este menționată o anumită API și să ofere un rezumat cu marcaj temporal”.

- Analiza documentelor: În loc să citească doar text, modelul poate analiza aspect vizual unui PDF de 1,000 de pagini, înțelegând relația dintre diagrame, tabele și proza din jur.

- Executarea codului: Studio acceptă acum execuție de cod în locul de joacăDacă îi ceri unui model să rezolve o problemă matematică complexă sau să analizeze un fișier CSV, modelul poate scrie și executa cod Python într-un mediu sandbox securizat pentru a oferi un răspuns verificat.

Personalizare avansată: Calea de reglare

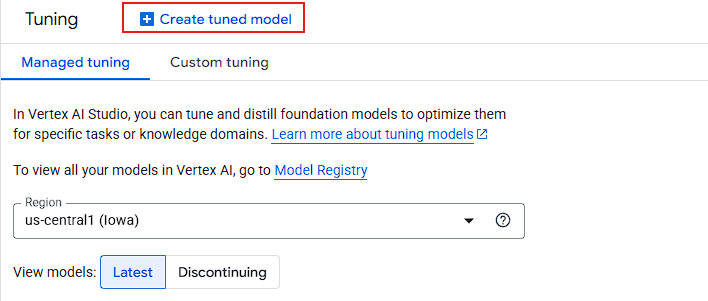

Când ingineria promptă (Zero-shot sau Few-shot) atinge un prag maxim, Vertex AI Studio oferă utilajele necesare: Tuning model.

- Reglaj fin supravegheat (SFT): Dezvoltatorii furnizează un set de date cu perechi „Prompt/Response” (în mod ideal, peste 100 de exemple). Acest lucru învață modelul să adopte o anumită voce specifică mărcii, un format de ieșire (cum ar fi JSON specializat) sau un jargon specific domeniului.

- Cache-ul contextului: Pentru întreprinderile care lucrează cu seturi de date statice masive (cum ar fi o bibliotecă juridică sau o bază de cod), Studio permite Cache-ul contextuluiAcest lucru vă permite să „preîncărcați” un milion de jetoane de date în memoria modelului, reducând drastic latența și costurile pentru interogările ulterioare.

- Distilare (Profesor-Student): Aceasta este o mișcare arhitecturală de nivel înalt. Puteți utiliza un model masiv (Gemini 2.5 Pro) pentru a „învăța” un model mai mic și mai rapid (Gemini 2.0 Flash). Rezultatul este un model ușor care are performanțe la nivel „Pro”, dar rulează la viteza și costul „Flash”.

Vertex AI Agent Builder: Fabrica pentru automatizare

Vertex AI Agent Builder este un framework de orchestrare la nivel înalt care permite dezvoltatorilor să creeze acești agenți prin combinarea modelelor de bază cu date ale întreprinderii și API-uri externe.

Arhitectura „Adevărului”: Împământare și RAG

Principala barieră tehnică în calea inteligenței artificiale la nivel de întreprindere este halucinaţieAgent Builder rezolvă acest lucru printr-o metodă sofisticată Pregătire motor.

- Conectarea la pământ cu Căutarea Google: Pentru interogări care necesită cunoștințe despre lumea reală în timp real (de exemplu, „Care sunt ratele ipotecare actuale în New York?”), agentul poate efectua o căutare pe Google, poate extrage informațiile și poate cita sursele.

- Căutare Vertex AI (RAG-as-a-Service): În loc să construiască manual o bază de date vectorială (Pinecone, Weaviate), dezvoltatorii pot folosi Vertex AI Search să-și indexeze propriile documente (PDF-uri, HTML, BigQuery). Se ocupă automat de pașii de „chunking”, „embedding” și „recuperare”, asigurându-se că agentul răspunde doar pe baza „Sursei de adevăr” interne.

- Motor Vertex AI RAG: Pentru implementări personalizate la scară largă, acest serviciu gestionat permite căutarea hibridă (combinând rezultate bazate pe vectori și cuvinte cheie) pentru a îmbunătăți precizia cu până la 30% peste rezultatele standard ale LLM.

Orchestrare multi-agent (Protocolul A2A)

Fluxurile de lucru avansate ale întreprinderilor necesită adesea mai mulți agenți specializați care lucrează împreună. Vertex AI introduce Protocolul agent-agent (A2A), un standard deschis care permite:

- „Agentul de turism” a vorbi cu „Agent financiar” pentru a se asigura că rezervarea unui zbor se încadrează în bugetul companiei.

- interoperabilitate: Deoarece folosește un protocol deschis, agenții construiți pe Vertex pot comunica cu cei construiți pe alte framework-uri precum LangChain sau CrewAI.

Stack-ul pentru dezvoltatori: ADK și Agent Engine

Pentru publicul „platformă tehnologică”, Agent Builder oferă două căi distincte:

- Consolă fără cod: O interfață vizuală drag-and-drop pentru prototipare rapidă și configurare pentru utilizatorii business.

- Kit de dezvoltare a agenților (ADK): Un set de instrumente Python axat pe codare, destinat inginerilor. Permite integrarea „Prompt-as-Code” cu controlul versiunilor și posibilitatea de implementare pe Motor de agenți Vertex AI—un runtime gestionat care gestionează automat persistența sesiunii, scalarea și gestionarea stării.

Concluzie: De la „Ce-ar fi dacă?” la „Ce urmează?”

Tranziția de la o demonstrație ostentativă de inteligență artificială la o aplicație enterprise de nivel de producție a fost mult timp „valea morții” pentru proiectele de transformare digitală. După cum am explorat, Vertex AI este conceput special pentru a acoperi această problemă. Prin unificarea silozurilor fragmentate de date, infrastructură și orchestrare a modelelor, Google Cloud a mutat conversația departe de puterea brută a Modelelor Limbajoase Mari și către... maturitatea operațională din ciclul de viață al IA.