Kunstig intelligens

Mobile-Agents: Autonom Multi-modal Mobile Device Agent med visuell persepsjon

Fremkomsten av Multimodal Large Language Models (MLLM) har innledet en ny æra av mobilenhetsagenter, som er i stand til å forstå og samhandle med verden gjennom tekst, bilder og stemme. Disse agentene markerer et betydelig fremskritt i forhold til tradisjonell AI, og gir en rikere og mer intuitiv måte for brukere å samhandle med enhetene sine. Ved å utnytte MLLM kan disse agentene behandle og syntetisere enorme mengder informasjon fra ulike modaliteter, noe som gjør dem i stand til å tilby personlig assistanse og forbedre brukeropplevelsene på måter som tidligere var utenkelige.

Disse agentene er drevet av toppmoderne maskinlæringsteknikker og avanserte naturlig språkbehandlingsevner, som lar dem forstå og generere menneskelignende tekst, samt tolke visuelle og auditive data med bemerkelsesverdig nøyaktighet. Fra å gjenkjenne objekter og scener i bilder til å forstå talte kommandoer og analysere tekstfølelse, er disse multimodale agentene utstyrt for å håndtere et bredt spekter av input sømløst. Potensialet til denne teknologien er stort, og tilbyr mer sofistikerte og kontekstuelt bevisste tjenester, for eksempel virtuelle assistenter tilpasset menneskelige følelser og pedagogiske verktøy som tilpasser seg individuelle læringsstiler. De har også potensial til å revolusjonere tilgjengelighet, og gjøre teknologi mer tilgjengelig på tvers av språk- og sensoriske barrierer.

I denne artikkelen skal vi snakke om Mobile-Agents, en autonom multimodal enhetsagent som først utnytter muligheten til visuell persepsjonsverktøy for å identifisere og lokalisere de visuelle og tekstlige elementene med en mobilapplikasjons front-end-grensesnitt nøyaktig. Ved å bruke denne oppfattede visjonskonteksten, planlegger og dekomponerer Mobile-Agent-rammeverket den komplekse operasjonsoppgaven autonomt, og navigerer gjennom mobilappene gjennom trinnvise operasjoner. Mobile-Agent-rammeverket skiller seg fra eksisterende løsninger siden det ikke er avhengig av mobilsystemmetadata eller XML-filer fra mobilapplikasjonene, noe som gir rom for forbedret tilpasningsevne på tvers av forskjellige mobile driftsmiljøer på en visjonsentrisk måte. Tilnærmingen som følges av Mobile-Agent-rammeverket eliminerer kravet til systemspesifikke tilpasninger som resulterer i forbedret ytelse og lavere datakrav.

Mobile-Agents: Autonom Multi-modal Mobile Device Agent

I den fartsfylte verdenen av mobilteknologi dukker et banebrytende konsept frem som et fremtredende: store språkmodeller, spesielt multimodale store språkmodeller eller MLLM-er som er i stand til å generere et bredt spekter av tekst, bilder, videoer og tale på tvers av forskjellige språk. Den raske utviklingen av MLLM-rammeverk de siste årene har gitt opphav til en ny og kraftig applikasjon av MLLM: autonome mobilagenter. Autonome mobile agenter er programvareenheter som handler, beveger seg og fungerer uavhengig, uten å trenge direkte menneskelige kommandoer, designet for å krysse nettverk eller enheter for å utføre oppgaver, samle informasjon eller løse problemer.

Mobile Agenter er designet for å betjene brukerens mobile enhet på grunnlag av brukerinstruksjonene og skjermens visuelle elementer, en oppgave som krever at agentene har både semantisk forståelse og visuell persepsjonsevne. Eksisterende mobilagenter er imidlertid langt fra perfekte siden de er basert på multimodale store språkmodeller, og til og med dagens toppmoderne MLLM-rammeverk inkludert GPT-4V mangler visuelle persepsjonsevner som kreves for å fungere som en effektiv mobilagent. Videre, selv om eksisterende rammeverk kan generere effektive operasjoner, sliter de med å finne posisjonen til disse operasjonene nøyaktig på skjermen, noe som begrenser applikasjonene og muligheten til mobilagenter til å operere på mobile enheter.

For å takle dette problemet valgte noen rammeverk å utnytte layoutfilene for brukergrensesnittet for å hjelpe GPT-4V eller andre MLLM-er med lokaliseringsmuligheter, med noen rammeverk som klarte å trekke ut handlingsbare posisjoner på skjermen ved å få tilgang til XML-filene til applikasjonen, mens andre rammeverk valgte å bruke HTML-koden fra nettapplikasjonene. Som det kan sees, er et flertall av disse rammeverkene avhengige av tilgang til underliggende og lokale applikasjonsfiler, noe som gjør metoden nesten ineffektiv hvis rammeverket ikke får tilgang til disse filene. For å løse dette problemet og eliminere lokale agenters avhengighet av underliggende filer på lokaliseringsmetodene, har utviklere jobbet med Mobile-Agent, en autonom mobilagent med imponerende visuelle persepsjonsevner. Ved å bruke sin visuelle persepsjonsmodul, bruker Mobile-Agent-rammeverket skjermbilder fra den mobile enheten for å finne operasjoner nøyaktig. Den visuelle persepsjonsmodulen inneholder OCR- og deteksjonsmodeller som er ansvarlige for å identifisere tekst på skjermen og beskrive innholdet innenfor en bestemt region på mobilskjermen. Mobile-Agent-rammeverket bruker nøye utformede spørsmål og muliggjør effektiv interaksjon mellom verktøyene og agentene, og automatiserer dermed operasjonene på mobilenheten.

Videre har Mobile-Agents-rammeverket som mål å utnytte de kontekstuelle egenskapene til toppmoderne MLLM-rammeverk som GPT-4V for å oppnå egenplanleggingsevner som lar modellen planlegge oppgaver basert på operasjonshistorikk, brukerinstruksjoner og skjermbilder helhetlig. For ytterligere å forbedre agentens evne til å identifisere ufullstendige instruksjoner og feil operasjoner, introduserer Mobile-Agent-rammeverket en selvrefleksjonsmetode. Under veiledning av nøye utformede spørsmål, reflekterer agenten konsekvent over feil og ugyldige operasjoner, og stopper operasjonene når oppgaven eller instruksjonen er fullført.

Samlet sett kan bidragene fra Mobile-Agent-rammeverket oppsummeres som følger:

- Mobile-Agent fungerer som en autonom mobilenhetsagent, og bruker visuelle persepsjonsverktøy for å utføre operasjonslokalisering. Den planlegger metodisk hvert trinn og engasjerer seg i introspeksjon. Spesielt er Mobile-Agent utelukkende avhengig av enhetsskjermbilder, uten bruk av noen systemkode, som viser frem en løsning som utelukkende er basert på synsteknikker.

- Mobile-Agent introduserer Mobile-Eval, en benchmark utviklet for å evaluere agenter for mobilenheter. Denne referansen inkluderer en rekke av de ti mest brukte mobilappene, sammen med intelligente instruksjoner for disse appene, kategorisert i tre vanskelighetsgrader.

Mobile-Agent: Arkitektur og metodikk

I kjernen består Mobile-Agent-rammeverket av en toppmoderne Multimodal stor språkmodell, GPT-4V, en tekstgjenkjenningsmodul som brukes til tekstlokaliseringsoppgaver. Sammen med GPT-4V bruker Mobile-Agent også en ikondeteksjonsmodul for ikonlokalisering.

Visuell oppfatning

Som nevnt tidligere, gir GPT-4V MLLM tilfredsstillende resultater for instruksjoner og skjermbilder, men den klarer ikke å sende ut plasseringen effektivt der operasjonene finner sted. På grunn av denne begrensningen, må Mobile-Agent-rammeverket som implementerer GPT-4V-modellen stole på eksterne verktøy for å hjelpe til med operasjonslokalisering, og dermed forenkle driftsutgangen på mobilskjermen.

Tekstlokalisering

Mobile-Agent-rammeverket implementerer et OCR-verktøy for å oppdage posisjonen til den tilsvarende teksten på skjermen når agenten trenger å trykke på en bestemt tekst som vises på mobilskjermen. Det er tre unike tekstlokaliseringsscenarier.

Scenario 1: Ingen spesifisert tekst oppdaget

Utgave: OCR-en klarer ikke å oppdage den angitte teksten, noe som kan forekomme i komplekse bilder eller på grunn av OCR-begrensninger.

Response: Instruer agenten til å enten:

- Velg teksten for å trykke på nytt, slik at du kan korrigere OCR-ens overvåking manuelt, eller

- Velg en alternativ operasjon, for eksempel å bruke en annen inndatametode eller å utføre en annen handling som er relevant for oppgaven.

Argumentasjon: Denne fleksibiliteten er nødvendig for å håndtere sporadiske unøyaktigheter eller hallusinasjoner av GPT-4V, for å sikre at agenten fortsatt kan fortsette effektivt.

Scenario 2: Enkeltforekomst av spesifisert tekst oppdaget

Operation: Generer automatisk en handling for å klikke på midtkoordinatene til den oppdagede tekstboksen.

Berettigelse: Med bare én forekomst oppdaget, er sannsynligheten for korrekt identifikasjon høy, noe som gjør det effektivt å fortsette med en direkte handling.

Scenario 3: Flere forekomster av spesifisert tekst oppdaget

Evaluering: Først, evaluer antall oppdagede forekomster:

Mange forekomster: Indikerer en skjerm som er rotete med lignende innhold, noe som kompliserer valgprosessen.

Handling: Be agenten om å velge teksten på nytt, med sikte på å avgrense utvalget eller justere søkeparametrene.

Noen få tilfeller: Et håndterbart antall deteksjoner gir mulighet for en mer nyansert tilnærming.

Handling: Beskjær regionene rundt disse forekomstene, og utvide tekstgjenkjenningsboksene utover for å fange ytterligere kontekst. Denne utvidelsen sikrer at mer informasjon blir bevart, og hjelper til med beslutningstaking.

Neste steg: Tegn deteksjonsbokser på de beskårne bildene og presenter dem for agenten. Denne visuelle assistansen hjelper agenten med å bestemme hvilken instans de skal samhandle med, basert på kontekstuelle ledetråder eller oppgavekrav.

Denne strukturerte tilnærmingen optimerer samspillet mellom OCR-resultater og agentoperasjoner, og forbedrer systemets pålitelighet og tilpasningsevne ved håndtering av tekstbaserte oppgaver på tvers av ulike scenarier. Hele prosessen er demonstrert i følgende bilde.

Ikon lokalisering

Mobile-Agent-rammeverket implementerer et ikondeteksjonsverktøy for å finne posisjonen til et ikon når agenten må klikke på det på mobilskjermen. For å være mer spesifikk ber rammeverket først agenten om å gi spesifikke attributter for bildet, inkludert form og farge, og deretter implementerer rammeverket Grounding DINO-metoden med ledetekstikonet for å identifisere alle ikonene i skjermbildet. Endelig, Mobil-Agent bruker CLIP-rammeverket for å beregne likheten mellom beskrivelsen av klikkregionen, og beregner likheten mellom de slettede ikonene, og velger regionen med størst likhet for et klikk.

Utførelse av instruksjoner

For å oversette handlingene til operasjoner på skjermen av agentene, definerer Mobile-Agent-rammeverket 8 forskjellige operasjoner.

- Start applikasjon (appnavn): Start det angitte programmet fra skrivebordsgrensesnittet.

- Trykk på Tekst (tekstetikett): Samhandle med skjermdelen som viser etiketten "Tekstetikett".

- Samhandle med ikon (ikonbeskrivelse, plassering): Målrett og trykk på det angitte ikonområdet, der "Ikonbeskrivelse" detaljerer attributter som farge og form på ikonet. Velg "Plassering" fra alternativer som topp, bunn, venstre, høyre eller midt, muligens kombiner to for presis navigering og for å redusere feil.

- Skriv inn tekst (skriv inn tekst): Skriv inn den gitte "Input Text" i det aktive tekstfeltet.

- Rull opp og ned: Naviger oppover eller nedover gjennom innholdet på denne siden.

- Gå tilbake: Gå tilbake til den tidligere viste siden.

- Lukk: Naviger tilbake til skrivebordet direkte fra gjeldende skjerm.

- Stopp: Avslutt operasjonen når oppgaven er fullført.

Selvplanlegging

Hvert trinn i operasjonen utføres iterativt av rammeverket, og før begynnelsen av hver iterasjon, må brukeren gi en input-instruksjon, og Mobile-Agent-modellen bruker instruksjonen til å generere en systemforespørsel for hele prosessen. Videre, før starten av hver iterasjon, fanger rammeverket et skjermbilde og mater det til agenten. Agenten observerer deretter skjermbildet, operasjonshistorikken og systemmeldingene for å sende ut neste trinn i operasjonene.

Selvrefleksjon

Under operasjonene kan agenten møte feil som hindrer den i å utføre en kommando. For å øke instruksjonsoppfyllingsgraden er det implementert en selvevalueringstilnærming som aktiveres under to spesifikke omstendigheter. Til å begynne med, hvis agenten utfører en feil eller ugyldig handling som stopper fremdriften, for eksempel når den gjenkjenner at skjermbildet forblir uendret etter operasjonen eller viser en feil side, vil den bli bedt om å vurdere alternative handlinger eller justere parametrene for den eksisterende operasjonen. For det andre kan agenten gå glipp av noen elementer i et komplekst direktiv. Når agenten har utført en rekke handlinger basert på den opprinnelige planen, vil den bli bedt om å gjennomgå handlingssekvensen, det siste skjermbildet og brukerens direktiv for å vurdere om oppgaven er fullført. Hvis det oppdages avvik, får agenten i oppgave å generere nye handlinger autonomt for å oppfylle direktivet.

Mobile-Agent: Eksperimenter og resultater

For å evaluere dens evner omfattende, introduserer Mobile-Agent-rammeverket Mobile-Eval-standarden som består av 10 ofte brukte applikasjoner, og designer tre instruksjoner for hver applikasjon. Den første operasjonen er enkel, og dekker bare grunnleggende applikasjonsoperasjoner, mens den andre operasjonen er litt mer kompleks enn den første siden den har noen tilleggskrav. Til slutt er den tredje operasjonen den mest komplekse av dem alle siden den inneholder abstrakte brukerinstruksjoner der brukeren ikke eksplisitt spesifiserer hvilken app som skal brukes eller hvilken operasjon som skal utføres.

Mobile-Agent-rammeverket designer og implementerer fire forskjellige beregninger for å vurdere ytelsen fra forskjellige perspektiver.

- Su eller suksess: Hvis mobilagenten fullfører instruksjonene, anses det som en suksess.

- Prosessscore eller PS: Prosessscore-beregningen måler nøyaktigheten av hvert trinn under utførelsen av brukerinstruksjonene, og den beregnes ved å dele antall riktige trinn på det totale antallet trinn.

- Relativ effektivitet eller RE: Den relative effektivitetspoengene er et forhold eller sammenligning mellom antall trinn det tar et menneske for å utføre instruksjonen manuelt, og antall trinn det tar agenten for å utføre den samme instruksjonen.

- Fullføringsrate eller CR: Beregningen for fullføringsgrad deler antall menneskestyrte trinn som rammeverket fullfører med suksess med det totale antallet trinn tatt av et menneske for å fullføre instruksjonen. Verdien av CR er 1 når agenten fullfører instruksjonen vellykket.

Resultatene er vist i følgende figur.

I utgangspunktet, for de tre gitte oppgavene, oppnådde mobilagenten fullføringsgrader på henholdsvis 91 %, 82 % og 82 %. Selv om ikke alle oppgavene ble utført feilfritt, oversteg oppnåelsesratene for hver oppgavekategori 90 %. Videre avslører PS-beregningen at mobilagenten konsekvent viser en høy sannsynlighet for å utføre nøyaktige handlinger for de tre oppgavene, med suksessrater på rundt 80 %. I tillegg, i henhold til RE-metrikken, viser Mobile-Agent 80 % effektivitet ved å utføre operasjoner på et nivå som kan sammenlignes med menneskelig optimalitet. Disse resultatene understreker samlet mobilagentens ferdigheter som assistent for mobilenheter.

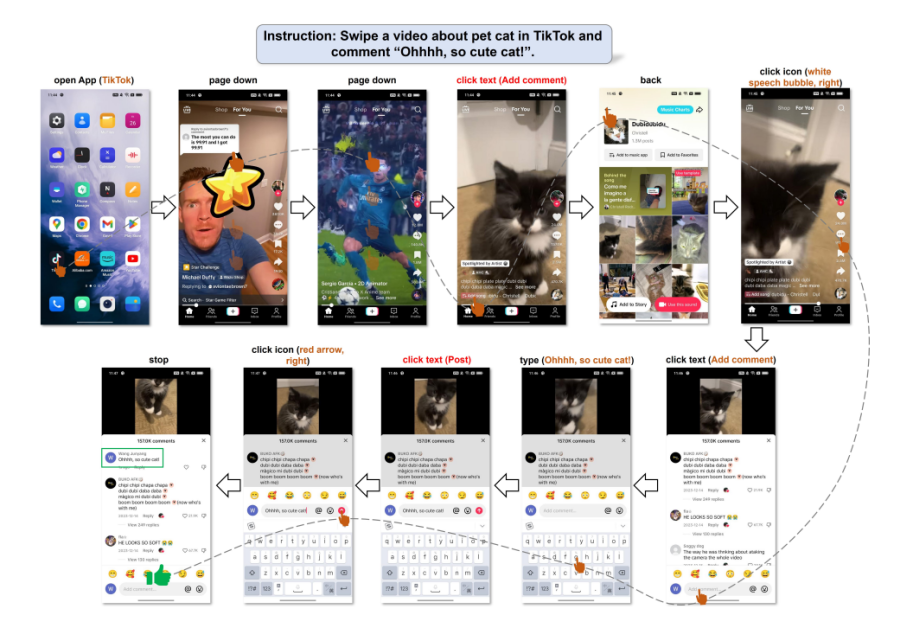

Følgende figur illustrerer mobilagentens evne til å forstå brukerkommandoer og uavhengig orkestrere handlingene. Selv i fravær av eksplisitte operasjonsdetaljer i instruksjonene, tolket Mobile-Agenten på en dyktig måte brukerens behov, og konverterte dem til handlingsbare oppgaver. Etter denne forståelsen utførte agenten instruksjonene via en systematisk planleggingsprosess.

Final Thoughts

I denne artikkelen har vi snakket om Mobile-Agents, en multimodal autonom enhetsagent som i utgangspunktet bruker visuell persepsjonsteknologi for å nøyaktig oppdage og finne både visuelle og tekstlige komponenter i grensesnittet til en mobilapplikasjon. Med denne visuelle konteksten i tankene, skisserer og bryter Mobile-Agent-rammeverket autonomt ned de intrikate oppgavene til håndterbare handlinger, og navigerer jevnt gjennom mobilapplikasjoner trinn for trinn. Dette rammeverket skiller seg ut fra eksisterende metodikk ettersom det ikke er avhengig av mobilsystemets metadata eller mobilappenes XML-filer, og legger dermed til rette for større fleksibilitet på tvers av ulike mobile operativsystemer med fokus på visuell-sentrisk prosessering. Strategien brukt av Mobile-Agent-rammeverket eliminerer behovet for systemspesifikke tilpasninger, noe som fører til forbedret effektivitet og reduserte beregningskrav.