Artificial Intelligence

Een AI-gestuurde bias-checker voor nieuwsartikelen, beschikbaar in Python

Onderzoekers in Canada, India, China en Australië hebben samengewerkt om een vrij beschikbaar Python-pakket te produceren dat effectief kan worden gebruikt om 'oneerlijk taalgebruik' in nieuwsteksten te herkennen en te vervangen.

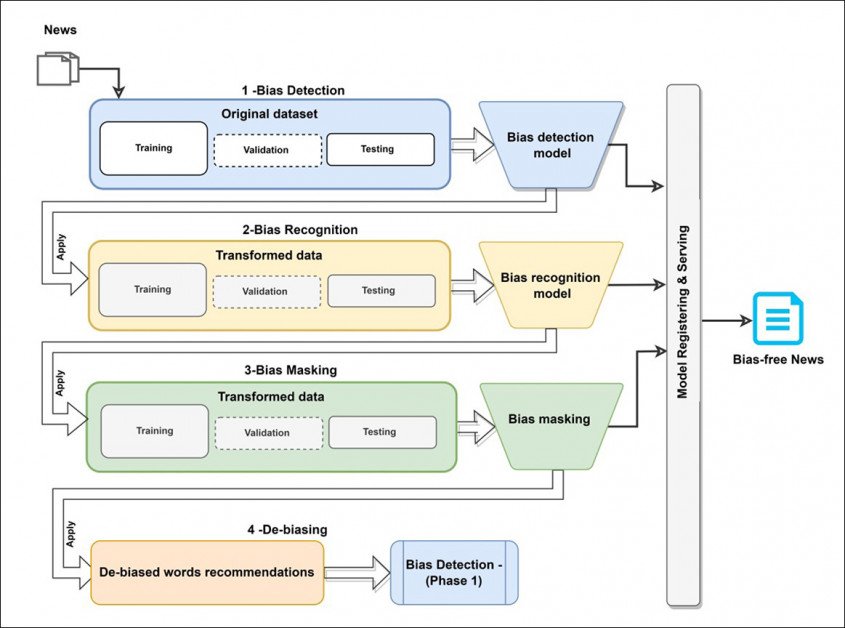

Het systeem, getiteld Dbias, maakt gebruik van verschillende machine learning-technologieën en databases om een circulaire workflow in drie fasen te ontwikkelen die kan worden verfijnd vooringenomen tekst totdat het een niet-bevooroordeelde, of in ieder geval meer neutrale versie retourneert.

Geladen taal in een nieuwsfragment dat als 'bevooroordeeld' wordt geïdentificeerd, wordt door Dbias omgezet in een minder opruiende versie. Bron: https://arxiv.org/ftp/arxiv/papers/2207/2207.03938.pdf

Het systeem vertegenwoordigt een herbruikbare en op zichzelf staande pijplijn die kan zijn geïnstalleerd via Pip van Hugging Face, en geïntegreerd in bestaande projecten als een aanvullende fase, add-on of plug-in.

In april is vergelijkbare functionaliteit geïmplementeerd in Google Docs kwam onder kritiek, niet in de laatste plaats vanwege het gebrek aan bewerkbaarheid. Dbias daarentegen kan selectiever worden getraind op elk corpus nieuws dat de eindgebruiker wenst, met behoud van de mogelijkheid om op maat gemaakte richtlijnen voor eerlijkheid te ontwikkelen.

Het cruciale verschil is dat de Dbias-pijplijn bedoeld is om 'geladen taal' (woorden die een kritische laag toevoegen aan feitelijke communicatie) automatisch om te zetten in neutrale of prozaïsche taal, in plaats van de gebruiker doorlopend te scholen. In wezen zal de eindgebruiker ethische filters definiëren en het systeem dienovereenkomstig trainen; in de Google Docs-benadering traint het systeem de gebruiker - aantoonbaar - op een eenzijdige manier.

Conceptuele architectuur voor de Dbias-workflow.

Volgens de onderzoekers is Dbias het eerste echt configureerbare pakket voor het detecteren van bias, in tegenstelling tot de kant-en-klare assemblageprojecten die deze subsector van Natural Language Processing (NLP) tot nu toe hebben gekenmerkt.

De nieuw papier is getiteld Een benadering om eerlijkheid in nieuwsartikelen te waarborgen, en is afkomstig van medewerkers van de University of Toronto, Toronto Metropolitan University, Environmental Resources Management in Bangalore, DeepBlue Academy of Sciences in China en The University of Sydney.

Methode

De eerste module in Dbias is Bias detectie, die gebruik maakt van de DestillerenBERT pakket - een sterk geoptimaliseerde versie van Google's vrij machine-intensieve BERT. Voor het project werd DistilBERT gefinetuned op de Media Bias Annotation (MBIC) gegevensset.

MBIC bestaat uit nieuwsartikelen uit verschillende mediabronnen, waaronder de Huffington Post, USA Today en MSNBC. De onderzoekers gebruikten de uitgebreide versie van de dataset.

Hoewel de oorspronkelijke gegevens werden geannoteerd door medewerkers van crowdsourcing (een methode die kwam onder vuur eind 2021) konden de onderzoekers van het nieuwe artikel extra niet-gelabelde gevallen van vertekening in de dataset identificeren en deze handmatig toevoegen. De geïdentificeerde gevallen van vooringenomenheid met betrekking tot ras, opleiding, etniciteit, taal, religie en geslacht.

de volgende module, Biasherkenning, toepassingen Erkende entiteitsherkenning (NER) om bevooroordeelde woorden uit de invoertekst te onderscheiden. Het papier stelt:

'Het nieuws "Koop de pseudo-wetenschappelijke hype over tornado's en klimaatverandering niet" is bijvoorbeeld geclassificeerd als bevooroordeeld door de voorgaande module voor het detecteren van vooringenomenheid, en de module voor vooringenomen herkenning kan nu de term "pseudo-wetenschappelijke hype" identificeren als een bevooroordeeld woord.'

NER is niet specifiek ontworpen voor deze taak, maar is gebruikt vaardigheden voor identificatie van vooringenomenheid, met name voor a 2021-project van Durham University in het Verenigd Koninkrijk.

Voor deze fase gebruikten de onderzoekers RoBERTa gecombineerd met de SpaCy English Transformer NER-pijplijn.

De volgende stap, Vooringenomenheid maskeren, omvat een nieuw meervoudig masker van de geïdentificeerde biaswoorden, dat opeenvolgend werkt in het geval van meerdere geïdentificeerde biaswoorden.

Geladen taal wordt vervangen door pragmatische taal in de derde fase van Dbias. Merk op dat 'in de mond nemen' en 'gebruiken' gelijk staan aan dezelfde actie, hoewel de eerste als spottend wordt beschouwd.

Indien nodig wordt de feedback uit deze fase teruggestuurd naar het begin van de pijplijn voor verdere evaluatie totdat er een aantal geschikte alternatieve formuleringen of woorden zijn gegenereerd. Deze fase maakt gebruik van Masked Language Modeling (MLM) langs lijnen vastgesteld door a 2021 samenwerking onder leiding van Facebook Research.

Normaal gesproken zal de MLM-taak 15% van de woorden willekeurig maskeren, maar in plaats daarvan vertelt de Dbias-workflow het proces om de geïdentificeerde bevooroordeelde woorden als invoer te nemen.

De architectuur is geïmplementeerd en getraind op Google Colab Pro op een NVIDIA P100 met 24 GB VRAM in een batchgrootte van 16, met slechts twee labels (vooringenomen en onpartijdige).

Tests

De onderzoekers testten Dbias tegen vijf vergelijkbare benaderingen: LG-TFIDF met Logistische regressie en TfidfVectorizer (TFIDF) woordinbeddingen; LG ELMO; MLP-ELMO (een feed-forward kunstmatig neuraal netwerk met ELMO-inbeddingen); BERT; en Roberta.

Metrieken die voor de tests werden gebruikt, waren nauwkeurigheid (ACC), precisie (PREC), terugroepactie (Rec) en een F1-score. Omdat de onderzoekers geen kennis hadden van een bestaand systeem dat alle drie de taken in een enkele pijplijn kon volbrengen, werd dispensatie gemaakt voor de concurrerende frameworks door alleen de primaire taken van Dbias te evalueren: biasdetectie en -herkenning.

Resultaten van de Dbias-proeven.

Dbias slaagde erin de resultaten van alle concurrerende frameworks te overtreffen, inclusief die met een zwaardere verwerkingsvoetafdruk

In de krant staat:

'Het resultaat laat ook zien dat diepe neurale inbeddingen in het algemeen beter presteren dan traditionele inbeddingsmethoden (bijv. TFIDF) in de bias-classificatietaak. Dit blijkt uit de betere prestaties van diepe neurale netwerkinbeddingen (dwz ELMO) in vergelijking met TFIDF-vectorisatie bij gebruik met LG.

'Dit komt waarschijnlijk omdat diepe neurale inbeddingen de context van de woorden in de tekst in verschillende contexten beter kunnen vastleggen. De diepe neurale inbeddingen en diepe neurale methoden (MLP, BERT, RoBERTa) presteren ook beter dan de traditionele ML-methode (LG).'

De onderzoekers merken ook op dat op Transformer gebaseerde methoden beter presteren dan concurrerende methoden bij het opsporen van vooringenomenheid.

Een aanvullende test omvatte een vergelijking tussen Dbias en verschillende smaken van het SpaCy Core Web, waaronder core-sm (small), core-md (medium) en core-lg (large). Dbias kon het bestuur ook leiden in deze proeven:

De onderzoekers concluderen door te constateren dat bias-herkenningstaken over het algemeen een betere nauwkeurigheid vertonen in grotere en duurdere modellen, vanwege – zo speculeren ze – het toegenomen aantal parameters en datapunten. Ze merken ook op dat de doeltreffendheid van toekomstig werk op dit gebied zal afhangen van grotere inspanningen om hoogwaardige datasets te annoteren.

Het bos en de bomen

Hopelijk zal dit soort fijnmazige projecten voor het herkennen van vooroordelen uiteindelijk worden opgenomen in kaders voor het zoeken naar vooringenomenheid die in staat zijn om een minder kortzichtige kijk te hebben, en om rekening te houden met het feit dat de keuze om een bepaald verhaal te verslaan op zichzelf een daad van vooringenomenheid is die mogelijk is. gedreven door meer dan alleen gerapporteerde kijkstatistieken.

Voor het eerst gepubliceerd op 14 juli 2022.