Artificial Intelligence

LoReFT: Representatieafstemming voor taalmodellen

Parameter-efficiënte fine-tuning- of PeFT-methoden proberen grote taalmodellen aan te passen via updates van een klein aantal gewichten. Het merendeel van het bestaande interpreteerbaarheidswerk heeft echter aangetoond dat representaties semantische rijke informatie coderen, wat suggereert dat het een beter en krachtiger alternatief zou kunnen zijn om deze representaties te bewerken. Vooraf getrainde grote modellen worden vaak verfijnd om te worden gebruikt voor nieuwe domeinen of taken, en tijdens het verfijningsproces kan een enkel basismodel worden aangepast aan een grote verscheidenheid aan taken, zelfs als er slechts kleine hoeveelheden gegevens binnen het domein beschikbaar zijn naar het model. Het proces van het verfijnen van een heel model vergt echter veel middelen en is duur, vooral voor taalmodellen met een aanzienlijk groter aantal afmetingen en parameters.

Parameter-efficiënte fine-tuning- of PeFT-methoden stellen voor om de hoge kosten die gepaard gaan met het verfijnen van het hele model aan te pakken door slechts een klein deel van de totale beschikbare gewichten bij te werken, een proces dat helpt bij het verminderen van de trainingstijd en het geheugengebruik. Wat belangrijker is, is dat parameter-efficiënte fijnafstemming of PeFT-methoden vergelijkbare prestaties hebben laten zien als fijnafstemming in verschillende praktische instellingen. Adapters, een gemeenschappelijke familie van parameter-efficiënte fijnafstemmings- of PeFT-methoden, leren een bewerking die kan worden toegevoegd aan een extra set gewichten die naast het bevroren basismodel werken, waarbij recente adapters zoals LoRA het aantal trainbare parameters in geleerde gewichtsupdates door lage benaderingen te gebruiken in plaats van matrices met volledig gewicht bij het trainen van de adapters.

Omdat eerdere werken aantonen dat bewerkingsrepresentaties een beter alternatief kunnen zijn voor parameter-efficiënte fijnafstemming of PeFT-methoden, zullen we in dit artikel praten over Representation Fine-tuning of ReFT-methoden die werken op een bevroren model, en taakspecifieke technieken leren interventies op verborgen representaties. Dit artikel heeft tot doel het ReFt- of Representation Fine-tuning-framework diepgaand te behandelen, en we onderzoeken het mechanisme, de methodologie en de architectuur van het raamwerk, samen met de vergelijking ervan met de modernste raamwerken. Dus laten we beginnen.

ReFT: Representatieverfijning voor taalmodellen

In een poging om vooraf getrainde taalmodellen toe te passen op nieuwe domeinen en taken, verfijnen de huidige raamwerken deze vooraf getrainde taalmodellen regelmatig, omdat met het geïmplementeerde verfijningsproces één enkel basismodel kan worden aangepast aan een verscheidenheid aan taken, zelfs wanneer u werkt met een kleine hoeveelheid gegevens binnen het domein. Hoewel het verfijningsproces de algehele prestaties verbetert, is het een duur proces, vooral als het taalmodel een aanzienlijk groot aantal parameters heeft. Om dit probleem aan te pakken en de bijbehorende kosten te verlagen, wordt gebruik gemaakt van PeFT of Parameter-efficiënt raamwerken verfijnen slechts een klein deel van de totale gewichten bijwerken, een proces dat niet alleen de trainingstijd verkort, maar ook het geheugengebruik vermindert, waardoor de PeFT-frameworks vergelijkbare prestaties kunnen bereiken in vergelijking met volledige afstemmingsbenaderingen in praktische scenario's. Adapters, een veel voorkomende familie van PeFT's, werken door een bewerking te leren die kan worden toegevoegd aan een extra set gewichten, samen met een subset van gewichten die samenwerken met het basismodel met bevroren gewichten. Recente adapterframeworks zoals LoRA en QLoRA hebben aangetoond dat het mogelijk is om adapters met volledige precisie te trainen bovenop modellen met verminderde precisie zonder de prestaties te beïnvloeden. Adapters zijn meestal efficiënter en effectiever in vergelijking met andere methoden die nieuwe modelcomponenten introduceren.

Een belangrijk hoogtepunt van de huidige stand van de techniek van parameter-efficiënte raamwerken voor fijnafstelling is dat ze in plaats van representaties te wijzigen, gewichten wijzigen. Raamwerken die zich bezighouden met interpreteerbaarheid hebben echter aangetoond dat representaties rijke semantische informatie coderen, wat suggereert dat het bewerken van representaties een betere en krachtigere aanpak zou kunnen zijn in vergelijking met gewichtsupdates. Deze veronderstelling dat het bewerken van representaties de betere aanpak is, vormt de basis van het ReFT- of Representation Fine-tuning-framework dat interventies traint in plaats van het aanpassen van modelgewichten, waardoor het model een klein deel van alle representaties kan manipuleren in een poging het modelgedrag te sturen. om stroomafwaartse taken tijdens gevolgtrekking op te lossen. ReFT- of Representation Fine-tuning-methoden zijn drop-in-vervangingen voor op gewicht gebaseerde PeFT- of parameter-efficiënte fine-tuning-frameworks. De ReFT-benadering is geïnspireerd op recente modellen die werken met een grote modelinterpreteerbaarheid die ingrijpt op representaties om getrouwe causale mechanismen te vinden, en het gedrag van het model stuurt tijdens inferentie, en kan daarom worden gezien als een generalisatie van de modellen voor het bewerken van representaties. Voortbouwend op hetzelfde is LoReFT of Low-Rank Subspace ReFT een sterk en effectief exemplaar van ReFT, en is een parametrisering van ReFT die ingrijpt op verborgen representaties in de lineaire ruimte die wordt overspannen door een projectiematrix van lage rang, en rechtstreeks voortbouwt op de DAS of Distributed Alignment Search-framework.

In tegenstelling tot volledige verfijning traint het PeFT- of parameterefficiënte raamwerk voor fijnafstemming slechts een klein deel van de parameters van het model en slaagt het erin het model aan te passen aan stroomafwaartse taken. Het parameter-efficiënte raamwerk voor fijnafstemming kan in drie hoofdcategorieën worden ingedeeld:

- Op adapters gebaseerde methoden: Op adapters gebaseerde methoden trainen extra modules zoals volledig verbonden lagen bovenop het vooraf getrainde model met bevroren gewichten. Serieadapters voegen componenten in tussen de meerlaagse perceptron- of MLP- en LM- of grote modelaandachtslagen, terwijl parallelle adapters modules toevoegen naast bestaande componenten. Omdat adapters nieuwe componenten toevoegen die niet gemakkelijk in bestaande modelgewichten kunnen worden gevouwen, vormen ze een extra last tijdens de gevolgtrekking.

- LoRA: LoRA benadert, samen met zijn recente varianten, additieve gewichten tijdens de training door gebruik te maken van matrices van lage rang, en ze vereisen geen extra overheadkosten tijdens gevolgtrekking, aangezien de gewichtsupdates kunnen worden samengevoegd in het model, en dit is de reden waarom ze worden beschouwd als de huidige sterkste PeFT-frameworks.

- Op prompt gebaseerde methoden: Op prompts gebaseerde methoden voegen zachte tokens toe die willekeurig in de invoer worden geïnitialiseerd, en trainen hun inbedding terwijl de gewichten van het taalmodel bevroren blijven. De prestaties die deze methoden bieden zijn vaak niet bevredigend in vergelijking met andere PeFT-benaderingen, en ze brengen ook aanzienlijke overheadkosten met zich mee.

In plaats van de gewichten bij te werken, leert het ReFT-framework interventies om een klein deel van de totale representaties te wijzigen. Bovendien hebben recente werkzaamheden op het gebied van representatie-engineering en activeringssturing aangetoond dat het toevoegen van vaste stuurvectoren aan de reststroom een zekere mate van controle over vooraf getrainde grote modelgeneraties zou kunnen vergemakkelijken zonder dat hiervoor veel hulpbronnen nodig zijn. scherpstellen. Andere raamwerken hebben aangetoond dat het bewerken van representaties met een aangeleerde schalings- en vertaaloperatie kan proberen de prestaties van LoRA-adapters te evenaren, maar niet te overtreffen, voor een breed scala aan taken met minder geleerde parameters. Bovendien heeft het succes van deze raamwerken voor een reeks taken aangetoond dat representaties geïntroduceerd door vooraf getrainde taalmodellen een rijke semantiek met zich meedragen, hoewel de prestaties van deze modellen suboptimaal zijn, wat ertoe leidt dat PeFT's blijven bestaan als de state-of-the-art benadering. zonder extra gevolgtrekkingslast.

ReFT: Methodologie en architectuur

Om het stijlbehoudproces eenvoudig te houden, gaat het ReFT-framework uit van een op transformatoren gebaseerd groot model als doelmodel dat in staat is een gecontextualiseerde weergave van de reeks tokens te produceren. Voor een gegeven reeks met n aantal invoertokens sluit het ReFT-framework deze invoertokens eerst in in een lijst met representaties, waarna de m lagen achtereenvolgens de lijst met verborgen representaties berekenen als een functie van de vorige lijst met verborgen representaties. Elke verborgen representatie is een vector, en het taalmodel gebruikt de uiteindelijke verborgen representaties om de voorspellingen te produceren. Het ReFT-framework houdt rekening met zowel gemaskeerde taalmodellen als autoregressieve taalmodellen. Volgens de lineaire representatiehypothese worden concepten in neurale netwerken gecodeerd binnen de lineaire deelruimten van representaties. Recente modellen hebben ontdekt dat deze bewering waar is in neurale netwerkmodellen die zijn getraind op natuurlijke taal, samen met andere invoerdistributies.

Bovendien gebruikt het informele abstractieraamwerk in interpreteerbaarheidsstudies uitwisselingsinterventies om terloops de rol van neurale netwerkcomponenten vast te stellen bij het implementeren van bepaald gedrag. De logica achter uitwisselingsinterventie is dat als men een representatie fixeert op wat deze zou zijn geweest voor een contrafeitelijke input, en deze interventie de output van het model consistent beïnvloedt op de manier waarop de beweringen van het ReFT-framework over de component die verantwoordelijk is voor de productie representatie, dan speelt de component een causale rol in het gedrag. Hoewel er een paar methoden zijn, is gedistribueerde uitwisselingsinterventie de ideale aanpak om te testen of een concept is gecodeerd in een lineaire deelruimte van een representatie, zoals beweerd door de lineaire representatiehypothese. Bovendien is de DAS-methode eerder gebruikt om lineaire representatie in taalmodellen te vinden van entiteitsattributen, sentiment, taalkundige kenmerken en wiskundig redeneren. Verschillende experimenten hebben echter aangetoond dat de DAS-methode zeer expressief is en het vermogen bezit om causaal effectieve deelruimten te vinden, zelfs wanneer het transformertaalmodel willekeurig is geïnitialiseerd, en daarom nog taakspecifieke representaties moet leren, resulterend in de debatteren over de vraag of DAS effectief en verantwoordelijk genoeg is voor interpreteertaken.

De expressiviteit die DAS biedt, suggereert dat de aanpak een ideaal hulpmiddel zou kunnen zijn om het gedrag van het taalmodel te controleren, samen met zijn werk op het gebied van controleerbare generatie en verantwoorde bewerking. Om taalmodellen voor stroomafwaartse taken aan te passen, gebruikt het ReFT-framework daarom de gedistribueerde uitwisselingsinterventie om een nieuwe parameter-efficiënte methode te maken. Bovendien is de ReFT-methode een reeks interventies, en het raamwerk dwingt af dat voor elke twee interventies die op dezelfde laag opereren, de interventieposities disjunct moeten zijn, waarbij de parameters van alle interventiefuncties onafhankelijk blijven. Als gevolg hiervan is de ReFT een generiek raamwerk dat interventies op verborgen representaties tijdens de voorwaartse doorgang van het model omvat.

ReFT: experimenten en resultaten

Om de prestaties ervan te vergelijken met bestaande PEFT-frameworks, voert het ReFT-framework experimenten uit met vier verschillende natuurlijke taalverwerkingsbenchmarks, en bestrijkt het meer dan twintig datasets, met als voornaamste doel een rijk beeld te geven van hoe het LoReFT-framework presteert in verschillende scenario's. Bovendien moeten ontwikkelaars, wanneer het LoReFT-framework in het echte leven wordt geïmplementeerd, beslissen hoeveel interventies ze willen leren, samen met de invoerposities en lagen waarop ze elke interventie moeten toepassen. Om de taak te voltooien, stemt het ReFT-framework vier hyperparameters af.

- Het aantal prefixposities waarop moet worden ingegrepen.

- Het aantal achtervoegselposities waarop moet worden ingegrepen.

- Op welke reeks lagen moet worden ingegrepen.

- Of interventieparameters al dan niet over verschillende posities in dezelfde laag moeten worden gekoppeld.

Door dit te doen vereenvoudigt het ReFT-framework de zoekruimte voor hyperparameters en zorgt het alleen voor vaste extra gevolgtrekkingskosten die niet schalen met de lengte van de prompt.

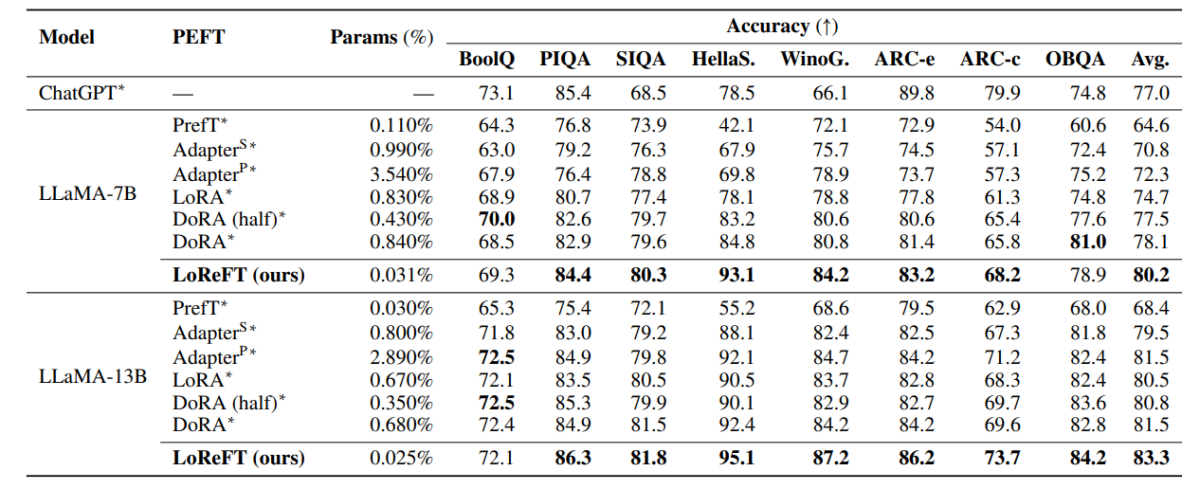

De bovenstaande tabel vergelijkt de nauwkeurigheid van de LLaMA-7B- en LLaMA-13B-frameworks met bestaande PEFT-modellen in acht op gezond verstand gebaseerde datasets. Zoals kan worden waargenomen presteert het LoReFT-model ruimschoots beter dan de bestaande PEFT-benaderingen, ondanks dat er veel minder parameters zijn, waarbij de gemiddelde prestatie van drie runs wordt gerapporteerd met verschillende parameterzaden voor het LoReFT-model. De param(%) wordt berekend door het aantal trainbare parameters te delen door het aantal totale parameters van het grote basismodel.

De bovenstaande tabel vat de nauwkeurigheidsvergelijking samen van de LLaMA-7B- en LLaMA-13B-frameworks met bestaande PEFT-modellen in vier verschillende datasets voor rekenkundig redeneren, waarbij het raamwerk de gemiddelde prestaties van drie runs met verschillende willekeurige zaden rapporteert. Zoals kan worden opgemerkt, presteert het LoReFT-framework, ondanks dat het veel minder params (%) heeft, aanzienlijk beter dan de bestaande PEFT-frameworks.

De bovenstaande tabel vat de nauwkeurigheidsvergelijking samen van de RoBERTa-base en RoBERTa-large raamwerken met bestaande PEFT-modellen in de GLUE-benchmark, waarbij het raamwerk de gemiddelde prestaties rapporteert van vijf runs met verschillende willekeurige zaden. Zoals kan worden opgemerkt, presteert het LoReFT-framework, ondanks dat het veel minder params (%) heeft, aanzienlijk beter dan de bestaande PEFT-frameworks.

Conclusie

In dit artikel hebben we gesproken over LoReFT, een krachtig alternatief voor bestaande PEFT-frameworks dat sterke prestaties levert in benchmarks uit vier verschillende domeinen en tegelijkertijd tot 50 keer de efficiëntie biedt die wordt geboden door eerdere geavanceerde PEFT-modellen. Vooraf getrainde grote modellen worden vaak verfijnd om te worden gebruikt voor nieuwe domeinen of taken, en tijdens het verfijningsproces kan een enkel basismodel worden aangepast aan een grote verscheidenheid aan taken, zelfs als er slechts kleine hoeveelheden gegevens binnen het domein beschikbaar zijn naar het model. Het proces van het verfijnen van een heel model vergt echter veel middelen en is duur, vooral voor taalmodellen met een aanzienlijk groter aantal afmetingen en parameters. Parameter-efficiënte fine-tuning- of PeFT-methoden stellen voor om de hoge kosten die gepaard gaan met het verfijnen van het hele model aan te pakken door slechts een klein deel van de totale beschikbare gewichten bij te werken, een proces dat helpt bij het verminderen van de trainingstijd en het geheugengebruik. LoReFT levert met name nieuwe state-of-the-art prestaties op het gebied van gezond verstand redeneren, het volgen van instructies en het begrijpen van natuurlijke taal tegen de sterkste PEFT's.