- Terminologie (A bis D)

- AI Kapazitéit Kontroll

- AI Ops

- albumations

- Asset Leeschtung

- Autoencoder

- Réckpropagatioun

- Bayes Theorem

- Big Data

- Chatbot: En Ufänger Guide

- Computational Denken

- Computer Visioun

- Duercherneen Matrix

- Konvolutional Neural Netzwierker

- Cybersecurity

- Daten Stoff

- Donnéeën Storytelling

- Data Science

- Donnéeën Depôt

- Entscheedung Tree

- Deepfakes

- Deep Learning

- Deep Verstäerkung Léieren

- Devops

- DevSecOps

- Diffusioun Modeller

- Digital Zwilling

- Dimensionalitéit Reduktioun

- Terminologie (E bis K)

- Rand AI

- Emotion AI

- Ensemble Léieren

- Ethesch Hacking

- ETL

- Erklärbar AI

- Federéiert Léieren

- Finen

- Generativ AI

- Generative Géigner Netzwierk

- Generativ vs Diskriminativ

- Gradient Boosting

- Gradient Ofstamung

- Puer-Shot Léieren

- Bild Klassifikatioun

- IT Operations (ITOps)

- Tëschefall Automatisatioun

- Afloss Engineering

- K-Mëtt Clustering

- K-Noosten Noperen

- Terminologie (L bis Q)

- Terminologie (R bis Z)

- Verstäerkung Léieren

- Responsabel AI

- RLHF

- Roboter Prozess Automatiséierung

- Strukturéiert vs Onstrukturéiert

- Gefiller Analyse

- Iwwerwaacht vs Net iwwerwaacht

- Ënnerstëtzung Vecteure Maschinnen

- Synthetesch Donnéeën

- Synthetesch Medien

- Text Klassifikatioun

- TinyML

- Transfer Léieren

- Transformer Neural Netzwierker

- Turing Test

- Vector Ähnlechkeet Sich

AI 101

Wéi funktionéiert Text Klassifikatioun?

Inhaltsverzeechnes

Textklassifikatioun ass de Prozess fir Textsequenzen ze analyséieren an hinnen e Label ze ginn, se an eng Grupp ze setzen op Basis vun hirem Inhalt. Text Klassifikatioun ënnerläit bal all AI oder Maschinn Léieren Aufgab mat Natural Language Processing (NLP). Mat Textklassifikatioun kann e Computerprogramm eng breet Varietéit vu verschiddenen Aufgaben ausféieren wéi Spam Unerkennung, Gefillsanalyse a Chatbot Funktiounen. Wéi funktionéiert Textklassifikatioun genee? Wat sinn déi verschidde Methoden fir Textklassifikatioun auszeféieren? Mir wäerten d'Äntwerten op dës Froen hei ënnen entdecken.

Text Klassifikatioun definéieren

Et ass wichteg e bëssen Zäit ze huelen a sécherzestellen datt mir et verstinn wat Text Klassifikatioun ass, am Allgemengen, ier Dir an déi verschidde Methode verdéiwen fir Textklassifikatioun ze maachen. Textklassifikatioun ass ee vun deene Begrëffer déi op vill verschidden Aufgaben an Algorithmen applizéiert ginn, also ass et nëtzlech fir sécherzestellen datt mir d'Basiskonzept vun der Textklassifikatioun verstinn ier Dir weider geet fir déi verschidde Weeër ze entdecken wéi se ausgefouert kënne ginn.

Alles wat involvéiert ass fir verschidde Kategorien fir Text ze kreéieren, an dann verschidden Textproben als dës Kategorien ze markéieren, kann als Textklassifikatioun ugesi ginn. Soulaang e System dës Basis Schrëtt ausféiert, kann et als Textklassifizéierer ugesi ginn, onofhängeg vun der exakter Method déi benotzt gëtt fir den Text ze klassifizéieren an egal wéi den Textklassifizéierer schlussendlech applizéiert gëtt. E-Mail Spam z'entdecken, Dokumenter no Thema oder Titel z'organiséieren an d'Gefill vun enger Bewäertung fir e Produkt z'erkennen sinn all Beispiller vun Textklassifikatioun well se erreecht ginn andeems Dir Text als Input hëlt an e Klasseetikett fir dat Stéck Text ausgëtt.

Wéi funktionéiert Text Klassifikatioun?

Foto: Quinn Dombrowski via Flickr, CC BY SA 2.0, (https://www.flickr.com/photos/quinnanya/4714794045)

Déi meescht Textklassifikatiounsmethoden kënnen an eng vun dräi verschiddene Kategorien plazéiert ginn: Regel-baséiert Methoden oder Maschinnléieremethoden.

Regel-baséiert Klassifikatioun Methoden

Regel-baséiert Textklassifikatiounsmethoden funktionnéieren duerch d'Benotzung vun explizit konstruéierte sproochleche Reegelen. De System benotzt d'Regele vum Ingenieur erstallt fir ze bestëmmen zu wéi enger Klass e bestëmmten Text soll gehéieren, a sicht no Hiweiser a Form vun semantesch relevant Textelementer. All Regel huet e Muster dat den Text muss passen fir an déi entspriechend Kategorie ze placéieren.

Fir méi konkret ze sinn, loosst eis soen, Dir wollt en Textklassifizéierer designen, dee fäeg ass gemeinsam Gespréichsthemen z'ënnerscheeden, wéi d'Wieder, Filmer oder Iessen. Fir Ären Textklassifizéierer z'erméiglechen, d'Diskussioun iwwer d'Wieder z'erkennen, kënnt Dir et soen datt Dir no Wiederbezunnen Wierder am Kierper vun den Textproben kuckt, déi se gefiddert gëtt. Dir hätt eng Lëscht vu Schlësselwieder, Ausdréck an aner relevant Mustere, déi benotzt kënne ginn fir d'Thema z'ënnerscheeden. Zum Beispill kënnt Dir de Klassifizéierer instruéieren no Wierder wéi "Wand", "Reen", "Sonn", "Schnéi" oder "Wollek" ze sichen. Dir kënnt dann de Klassifizéierer duerch den Input Text kucken an d'Zuel vun de Mol zielen datt dës Wierder am Kierper vum Text erschéngen a wa se méi heefeg schéngen wéi Wierder am Zesummenhang mat Filmer, géift Dir den Text klasséieren als gehéiert zu der Wiederklass.

De Virdeel vu Regelbaséierte Systemer ass datt hir Inputen an Ausgänge prévisibel an interpretéierbar vu Mënschen sinn, a si kënne verbessert ginn duerch manuell Interventioun vum Ingenieur. Wéi och ëmmer, Regelbaséiert Klassifikatiounsmethoden sinn och e bësse brécheg, a si hunn dacks eng schwiereg Zäit ze generaliséieren, well se nëmmen un déi virdefinéiert Mustere festhalen, déi programméiert goufen. Als Beispill kann d'Wuert "Wollek" op Feuchtigkeit an der Himmel, oder et kéint op eng digital Wollek bezéien, wou Daten gespäichert ginn. Et ass schwéier fir Regel-baséiert Systemer dës Nuancen ze handhaben ouni datt d'Ingenieuren eng fair Zäit verbréngen fir dës Subtletien manuell virzegoen an unzepassen.

Maschinn Léieren Systemer

Wéi uewen ernimmt, Regel-baséiert Systemer hunn Aschränkungen, well hir Funktiounen a Regele muss pre-programméiert ginn. Am Géigesaz, Maschinn Léieren-baséiert Klassifikatiounssystemer funktionnéieren andeems Algorithmen applizéiert ginn, déi Datensätz analyséieren fir Mustere déi mat enger bestëmmter Klass verbonne sinn.

Maschinn Léieren Algorithmen gi virgezeechent / virklasséiert Instanzen gefiddert, déi fir relevant Features analyséiert ginn. Dës pre-labeléiert Instanzen sinn d'Trainingsdaten.

De Maschinnléierklassifizéierer analyséiert d'Trainingsdaten a léiert Musteren déi mat de verschiddene Klassen verbonne sinn. Duerno ginn onsiichtbar Instanzen vun hiren Etiketten entlooss an an de Klassifikatiounsalgorithmus gefüttert, deen den Instanzen e Label zouginn. Déi zougewisen Etiketten ginn dann mat den ursprénglechen Etiketten verglach fir ze kucken wéi genau de Maschinnléierklassifizéierer war, beurteelt wéi gutt de Modell geléiert huet wéi eng Mustere viraussoen wéi eng Klassen.

Maschinn Léieren Algorithmen funktionnéieren andeems numeresch Donnéeën analyséiert ginn. Dëst bedeit datt fir e Maschinnléieralgorithmus op Textdaten ze benotzen, den Text muss an en numerescht Format ëmgewandelt ginn. Et gi verschidde Methoden fir Textdaten als numeresch Donnéeën ze kodéieren an Maschinnléieremethoden ronderëm dës Donnéeën ze kreéieren. Mir decken e puer vun de verschiddene Weeër fir Textdaten hei drënner ze representéieren.

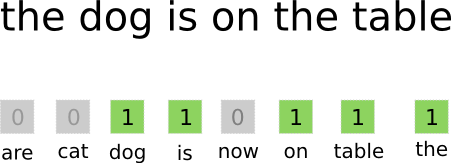

Sak-vun-Wörter

Sak-vun-Wierder ass eng vun de meescht benotzten Approche fir Textdaten ze codéieren an ze representéieren. De Begrëff "bag-of-words" kënnt aus der Tatsaach datt Dir am Fong all d'Wierder an den Dokumenter hëlt an se all an eng "Täsch" setzt ouni op d'Wuertuerdnung oder d'Grammatik opmierksam ze maachen, nëmmen op d'Opmierksamkeet opzepassen Frequenz vu Wierder an der Täsch. Dëst resultéiert an enger laanger Array, oder Vektor, déi eng eenzeg Representatioun vun all de Wierder an den Inputdokumenter enthält. Also wann et 10000 eenzegaarteg Wierder am Ganzen an den Inputdokumenter sinn, wäerten d'Featurevektoren 10000 Wierder laang sinn. Dëst ass wéi d'Gréisst vum Wuertbeutel / Featurevektor berechent gëtt.

Foto: gk_ via Machinelearning.co, (https://machinelearnings.co/text-classification-using-neural-networks-f5cd7b8765c6)

Nodeems d'Feature Vecteure Gréisst bestëmmt gouf, gëtt all Dokument an der Lëscht vun de Gesamtdokumenter säin eegene Vektor zougewisen, gefëllt mat Zuelen, déi uginn wéi oft dat Wuert am aktuellen Dokument erschéngt. Dëst bedeit datt wann d'Wuert "Liewensmëttel" aacht Mol an engem Textdokument erschéngt, deen entspriechende Featurevektor / Feature-Array eng aacht an der entspriechender Positioun huet.

Anescht gesot, all déi eenzegaarteg Wierder, déi an den Input-Dokumenter optrieden, ginn all an eng Täsch gestapelt an dann kritt all Dokument e Wuertvektor vun der selwechter Gréisst, deen dann mat der Unzuel vun Mol ausgefëllt gëtt, déi verschidde Wierder am Dokument erschéngen. .

Textdatesets enthalen dacks eng grouss Unzuel vun eenzegaartege Wierder, awer déi meescht vun hinnen ginn net ganz dacks benotzt. Aus dësem Grond ass d'Zuel vu Wierder, déi benotzt gi fir de Wuertvektor ze kreéieren, typesch op e gewielte Wäert (N) ofgeschloss an dann ass d'Featurevektor Dimensioun Nx1.

Term Frequenz-Inverse Dokument Frequenz (TF-IDF)

Eng aner Manéier fir en Dokument ze representéieren baséiert op de Wierder an et ass dubbed Term Frequenz-Inverse Dokument Frequenz (TF-IDF). Eng TF-IDF Approche erstellt och e Vektor deen d'Dokument duerstellt baséiert op de Wierder dran, awer am Géigesaz zu Bag-of-words sinn dës Wierder Gewiicht vu méi wéi nëmmen hir Frequenz. TF-IDF betruecht d'Wichtegkeet vun de Wierder an den Dokumenter, a probéiert ze quantifizéieren wéi relevant dat Wuert zum Thema vum Dokument ass. An anere Wierder, TF-IDF analyséiert d'Relevanz amplaz vun der Frequenz an d'Wuertzuelen an engem Featurevektor ginn duerch en TF-IDF Score ersat, dee mat Bezuch op de ganzen Dataset berechent gëtt.

Eng TF-IDF Approche funktionnéiert andeems d'Begrëffsfrequenz fir d'éischt berechent gëtt, d'Zuel vun de Mol, datt déi eenzegaarteg Begrëffer an engem spezifesche Dokument erschéngen. Wéi och ëmmer, TF-IDF këmmert sech och fir den Afloss ze limitéieren datt extrem heefeg Wierder wéi "den", "oder", an "an", well dës "Stoppwierder" ganz heefeg sinn awer awer ganz wéineg Informatioun iwwer den Inhalt vum Dokument vermëttelen. Dës Wierder musse reduzéiert ginn, dat ass wat den "inverse-Dokumentfrequenz" Deel vun TF-IDF bezitt. Dëst gëtt gemaach well wat méi Dokumenter an deem e spezifescht Wuert opdaucht, dest manner nëtzlech ass dat Wuert fir et vun deenen aneren Dokumenter an der Lëscht vun allen Dokumenter z'ënnerscheeden. D'Formel déi TF-IDF benotzt fir d'Wichtegkeet vun engem Wuert ze berechnen ass entwéckelt fir d'Wierder ze erhaalen déi am heefegsten an déi semantesch räich sinn.

D'Feature Vecteure erstallt vun der TF-IDF Approche enthalen normaliséiert Wäerter, déi zu engem summen, all Wuert e gewiichtte Wäert zouginn wéi berechent duerch d'TF-IDF Formel.

Wuert Embeddings

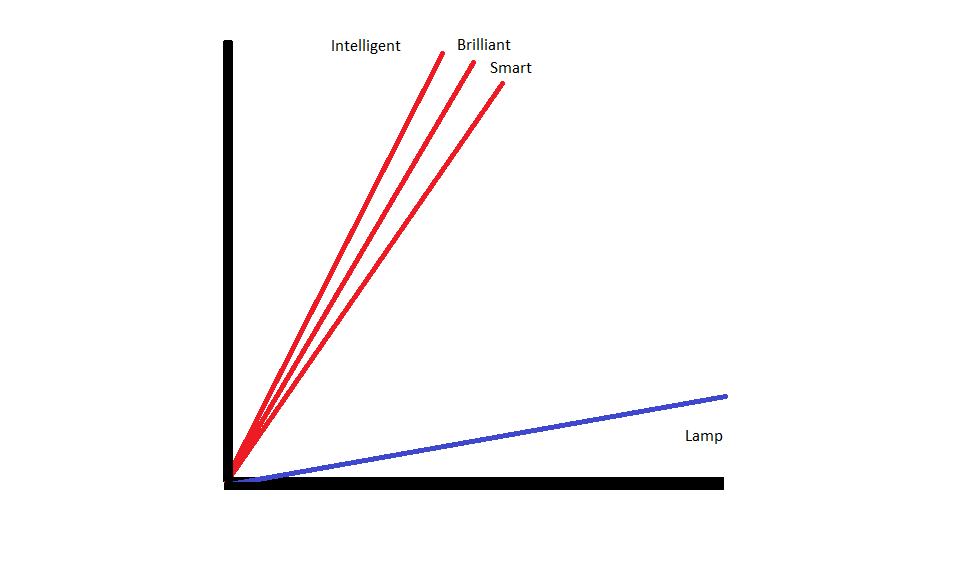

Wuert Embeddings si Methoden fir Text ze representéieren, déi garantéieren datt Wierder mat ähnleche Bedeitunge ähnlech numeresch Representatioune hunn.

Wuert Embeddings Bedreiwen duerch "vectorizing" Wierder, dat heescht datt se Wierder als real-gewäert-Vektoren an engem Vektorraum representéieren. D'Vektoren existéieren an engem Gitter oder Matrix, a si hunn eng Richtung a Längt (oder Magnitude). Wann Dir Wierder als Vecteure representéiert, ginn d'Wierder a Vektore ëmgewandelt, déi aus echte Wäerter besteet. All Wuert gëtt op ee Vecteure gemappt, a Wierder déi ähnlech a Bedeitung sinn hunn eng ähnlech Richtung a Gréisst. Dës Zort Kodéierung mécht et méiglech fir e Maschinnléieralgorithmus komplizéiert Bezéiungen tëscht Wierder ze léieren.

D'Embeddings déi verschidde Wierder representéieren ginn erstallt wat d'Wierder a Fro benotzt ginn. Well Wierder déi op ähnlech Aart a Weis benotzt ginn ähnlech Vektoren hunn, iwwersetzt de Prozess fir Wuertbefehlungen automatesch e puer vun der Bedeitung déi d'Wierder hunn. Eng Täsch vu Wierder Approche, am Géigesaz, erstellt brécheg Representatioune wou verschidde Wierder ënnerschiddlech Representatioune hunn och wa se an héich ähnleche Kontexter benotzt ginn.

Als Resultat si Wuert Embeddings besser fir de Kontext vu Wierder an engem Saz z'erfëllen.

Et gi verschidde Algorithmen an Approche benotzt fir Wuert Embeddings ze kreéieren. E puer vun den heefegsten an zouverlässegsten Wuert Embedding Methoden enthalen: Embedding Schichten, word2vec, a GloVe.

Embedding Schichten

Ee potenzielle Wee fir Wuert Embeddings niewent engem Maschinnléieren / Deep Learning System ze benotzen ass benotzen eng embedding Layer. Embedding Schichten sinn déif Léierschichten déi Wierder an Embeddings konvertéieren déi dann an de Rescht vum Deep Learning System gefüttert ginn. D'Wuert Embeddings gi geléiert wéi d'Netzwierk trainéiert fir eng spezifesch textbaséiert Aufgab.

An enger Wuert Embedding Approche wäerten ähnlech Wierder ähnlech Representatioune hunn a méi no beienee sinn wéi zu ënnerschiddleche Wierder.

Fir Embedding Schichten ze benotzen, muss den Text als éischt virveraarbecht ginn. Den Text am Dokument muss een-hot encoded sinn, an d'Vektorgréisst muss am Viraus spezifizéiert ginn. Den eenheetlechen Text gëtt dann a Wuertvektoren ëmgewandelt an d'Vektore ginn an de Maschinnléiermodell iwwerginn.

Word2Vec

Word2Vec ass eng aner gemeinsam Method fir Wierder z'integréieren. Word2Vec benotzt statistesch Methoden fir Wierder an Embeddingen ze konvertéieren an et ass optimiséiert fir mat neuralen Netzwierk baséiert Modeller ze benotzen. Word2Vec gouf vu Google Fuerscher entwéckelt an et ass eng vun de meescht benotzt Embedding Methoden, well et zouverlässeg nëtzlech, räich Embeddings gëtt. Word2Vec Representatioune sinn nëtzlech fir semantesch a syntaktesch Gemeinsamkeeten an der Sprooch z'identifizéieren. Dëst bedeit datt Word2Vec Representatioune Bezéiungen tëscht ähnlechen Konzepter erfaasst, fäeg z'ënnerscheeden datt d'Gemeinlechkeet tëscht "Kinnek" an "Kinnigin" royalty ass an datt "Kinnek" implizéiert "Mënschheet" wärend d'Kinnigin "Fra" implizéiert.

Handschuesch

GloVE, oder Global Vector fir Wuert Representatioun, baut op den Embedding Algorithmen, déi vu Word2Vec benotzt ginn. GloVe Embedding Methoden kombinéieren Aspekter vu Word2Vec a Matrixfaktoriséierungstechnike wéi Latent Semantic Analyse. De Virdeel vu Word2Vec ass datt et Kontext erfaasse kann, awer als Ofwiesselung erfaasst se schlecht global Textstatistiken. Ëmgekéiert sinn traditionell Vektorrepresentatioune gutt fir global Textstatistiken ze bestëmmen awer si sinn net nëtzlech fir de Kontext vu Wierder a Sätze ze bestëmmen. GloVE zitt aus de beschten vun deenen zwou Approchen, erstellt Wuertkontext baséiert op globalen Textstatistiken.

Blogger a Programméierer mat Spezialitéiten am Machine Learning an Deep Learning Themen. Den Daniel hofft anerer ze hëllefen d'Kraaft vun der AI fir sozial Gutt ze benotzen.

Dir kënnt gär

De Rise vun AI Software Ingenieuren: SWE-Agent, Devin AI an d'Zukunft vum Kodéierung

InstructIR: Héichqualitativ Bild Restauratioun No Mënsch Instruktioune

NLP Rise mat Transformer Modeller | Eng ëmfaassend Analyse vun T5, BERT, a GPT

Analogesch & Schrëtt-Back-Prompting: En Tauche a rezent Fortschrëtter vu Google DeepMind

LlamaIndex: Augmentéiert Är LLM Uwendungen mat personaliséierten Donnéeën einfach

D'Roll vu Vektordatabasen a modernen generativen AI Uwendungen