בינה מלאכותית

LoReFT: כוונון ייצוג למודלים של שפה

כוונון עדין יעיל בפרמטרים או שיטות PeFT מבקשות להתאים מודלים של שפות גדולות באמצעות עדכונים למספר קטן של משקלים. עם זאת, רוב עבודת הפרשנות הקיימת הוכיחה כי ייצוגים מקודדים מידע עשיר סמנטי, מה שמרמז על כך שזו עשויה להיות אלטרנטיבה טובה וחזקה יותר לערוך ייצוגים אלה. מודלים גדולים שעברו הכשרה מראש מותאמים לעתים קרובות לשימוש עבור תחומים או משימות חדשות, ובמהלך תהליך הכוונון, ניתן להתאים מודל בסיס יחיד למגוון רחב של משימות אפילו עם כמויות קטנות בלבד של נתונים בתוך הדומיין. לדגם. עם זאת, תהליך כוונון עדין של דגם שלם הוא גוזל משאבים, ויקר, במיוחד עבור מודלים של שפה עם מספר גבוה משמעותית של גודל ופרמטרים.

כוונון עדין יעיל בפרמטרים או שיטות PeFT מציעות להתמודד עם העלויות הגבוהות הכרוכות בכוונון עדין של המודל כולו על ידי עדכון רק כמות קטנה מהמשקלים הכוללים הזמינים, תהליך המסייע בהפחתת זמן האימון יחד עם השימוש בזיכרון. מה שחשוב יותר הוא ששיטות כוונון עדין יעיל-פרמטר או PeFT הוכיחו ביצועים דומים לכיוונון בכמה הגדרות מעשיות. מתאמים, משפחה נפוצה של שיטות כוונון עדין יעיל-פרמטר או PeFT, לומדים עריכה שניתן להוסיף לסט נוסף של משקלים הפועלים לצד דגם הבסיס הקפוא, כאשר מתאמים עדכניים כמו LoRA מפחיתים את מספר הפרמטרים הניתנים לאימון עדכוני משקל על ידי שימוש בקירוב בדרגה נמוכה במקום במטריצות במשקל מלא בעת אימון המתאמים.

עם עבודות קודמות המדגימות עריכת ייצוגים עשויה להיות אלטרנטיבה טובה יותר לכוונון עדין יעיל בפרמטרים או לשיטות PeFT, במאמר זה, נדבר על שיטות ייצוג עדין או ReFT הפועלות על מודל קפוא, ונלמד משימה ספציפית. התערבויות על ייצוגים נסתרים. מאמר זה נועד לכסות את מסגרת ה-ReFt או Representation Fine-tuning לעומק, ואנו חוקרים את המנגנון, המתודולוגיה, הארכיטקטורה של המסגרת יחד עם ההשוואה שלה למסגרות המתקדמות ביותר. אז בואו נתחיל.

ReFT: ייצוג כוונון עדין עבור מודלים של שפה

בניסיון לאמץ מודלים של שפה שהוכשרו מראש לתחומים ומשימות חדשות, מסגרות נוכחיות מכווננות את המודלים של השפה המאומנים מראש בתדירות גבוהה, שכן בתהליך הכוונון המיושם, ניתן להתאים מודל בסיס יחיד למגוון משימות אפילו כאשר עובדים עם כמות קטנה של נתונים בדומיין. למרות שתהליך הכוונון אכן משפר את הביצועים הכוללים, זהו תהליך יקר במיוחד אם למודל השפה יש מספר גבוה משמעותית של פרמטרים. כדי להתמודד עם בעיה זו, ולהפחית את העלויות הנלוות, PeFT או פרמטר יעיל כוונון עדין של מסגרות עדכן רק חלק קטן מהמשקלים הכוללים, תהליך שלא רק מקטין את זמן האימון, אלא גם מקטין את השימוש בזיכרון, ומאפשר למסגרות PeFT להשיג ביצועים דומים בהשוואה לגישות כוונון מלא בתרחישים מעשיים. מתאמים, משפחה נפוצה של PeFTs, פועלים על ידי לימוד עריכה שניתן להוסיף לסט נוסף של משקלים יחד עם תת-קבוצה של משקלים הפועלים יחד עם דגם הבסיס עם משקלים קפואים. מסגרות מתאם אחרונות כמו LoRA ו-QLoRA הוכיחו שאפשר להכשיר מתאמים בעלי דיוק מלא על גבי דגמים עם דיוק מופחת מבלי להשפיע על הביצועים. מתאמים בדרך כלל יעילים ויעילים יותר בהשוואה לשיטות אחרות שמציגות רכיבי דגם חדשים.

גולת הכותרת של מסגרות כוונון עדין היעילות בפרמטרים היא שבמקום לשנות ייצוגים, הן משנות משקלים. עם זאת, מסגרות העוסקות בפרשנות הוכיחו כי ייצוגים מקודדים מידע סמנטי עשיר, דבר המצביע על כך שעריכת ייצוגים עשויה להיות גישה טובה וחזקה יותר בהשוואה לעדכוני משקל. הנחה זו של עריכת ייצוגים היא הגישה הטובה יותר היא מה שמהווה את הבסיס למסגרת ReFT או Representation Fine-tuning המאמנת התערבויות במקום להתאים משקלי מודל, מה שמאפשר למודל לתפעל חלק קטן מכל הייצוגים בניסיון לכוון את התנהגויות המודל כדי לפתור משימות במורד הזרם במהלך מסקנות. שיטות כוונון עדין של ReFT או Representation הן תחליפים נמוכים עבור מסגרות כוונון עדין מבוססות משקל של PeFT או פרמטר יעיל. גישת ה-ReFT שואבת השראה ממודלים עדכניים העובדים עם פרשנות של מודלים גדולים שמתערבים בייצוגים כדי למצוא מנגנונים סיבתיים נאמנים, ומנווט את התנהגות המודל במהלך ההסקה, ולכן ניתן לראות בה הכללה של המודלים לעריכת הייצוג. בהתבסס על אותו הדבר, LoReFT או Low-Rank Subspace ReFT הוא מופע חזק ויעיל של ReFT, והוא פרמטריזציה של ReFT שמתערבת על ייצוגים נסתרים במרחב הליניארי המתפרש על ידי מטריצת הקרנה בדרגה נמוכה, ומתבססת ישירות על ה-DAS או מסגרת חיפוש יישור מבוזרת.

בהמשך, בניגוד לכוונון עדין מלא, מסגרת הכוונון העדין של PeFT או Parameter-efficient מאמנת רק חלק קטן מהפרמטרים של המודל, ומצליחה להתאים את המודל למשימות במורד הזרם. ניתן לסווג את מסגרת הכוונון העדין יעילה בפרמטרים לשלוש קטגוריות עיקריות:

- שיטות מבוססות מתאם: שיטות מבוססות מתאם מאמנות מודולים נוספים כמו שכבות מחוברות במלואן על גבי הדגם המאומן מראש עם משקולות קפואות. מתאמי סדרה מכניסים רכיבים בין ה-perceptron הרב שכבתי או MLP ו-LM או שכבות תשומת לב מדגמים גדולים, בעוד שמתאמים מקבילים מוסיפים מודולים לצד רכיבים קיימים. מאחר שמתאמים מוסיפים רכיבים חדשים שלא ניתנים לקיפול למשקולות של דגם קיים בקלות, הם מהווים עומס נוסף במהלך ההסקה.

- LoRA: LoRA יחד עם הווריאציות האחרונות שלה מקרוב משקלים תוספים במהלך אימון על ידי שימוש במטריצות בדרגה נמוכה, והם אינם דורשים תקורה נוספת במהלך הסקת מסקנות מכיוון שניתן למזג את עדכוני המשקל לתוך המודל, וזו הסיבה מדוע הם נחשבים הנוכחיים מסגרות PeFT החזקות ביותר.

- שיטות מבוססות הנחיות: שיטות המבוססות על הנחיה מוסיפות אסימונים רכים שמאוחלים באופן אקראי לקלט, ומאמנות את ההטמעות שלהם תוך הקפאת משקלי מודל השפה. הביצועים המוצעים בשיטות אלה לרוב אינם משביעי רצון בהשוואה לגישות אחרות של PeFT, והן גם נושאות עלות תקורה משמעותית.

במקום לעדכן את המשקולות, מסגרת ReFT לומדת התערבויות לשינוי חלק קטן מסך הייצוגים. יתרה מזאת, עבודות אחרונות בנושא הנדסת ייצוג והיגוי הפעלה הוכיחו שהוספת וקטורי היגוי קבועים לזרם השיורי עשויה להקל על מידה של שליטה על דורות דגמים גדולים שהוכשרו מראש מבלי לדרוש משאבים עתירי משאבים כוונון עדין. מסגרות אחרות הוכיחו כי עריכת ייצוגים עם פעולת קנה מידה ותרגום נלמדת יכולה לנסות להתאים אך לא לעלות על הביצועים שמציעים מתאמי LoRA במגוון רחב של משימות עם פחות פרמטרים נלמדים. יתרה מזאת, הצלחתן של מסגרות אלו על פני מגוון משימות הוכיחה כי ייצוגים שהוצגו על ידי מודלים של שפה מאומנים מראש נושאים סמנטיקה עשירה, אם כי הביצועים של מודלים אלו אינם אופטימליים, וכתוצאה מכך PeFTs ימשיכו כגישה המתקדמת ביותר. ללא נטל מסקנות נוסף.

ReFT: מתודולוגיה וארכיטקטורה

כדי לשמור על תהליך שימור הסגנון פשוט, מסגרת ReFT מניחה מודל גדול מבוסס שנאי כמודל היעד שלה, המסוגל לייצר ייצוג בהקשר של רצף אסימונים. עבור רצף נתון עם מספר n של אסימוני קלט, המסגרת של ReFT מטביעה תחילה את אסימוני הקלט הללו לתוך רשימה של ייצוגים שבעקבותיה M שכבות מחשבות את רשימת הייצוגים המוסתרים ברצף כפונקציה של הרשימה הקודמת של ייצוגים מוסתרים. כל ייצוג נסתר הוא וקטור, ומודל השפה משתמש בייצוגים הנסתרים הסופיים כדי לייצר את התחזיות. מסגרת ReFT מתייחסת הן למודלים של שפה מכוסה והן במודלים של שפה אוטורגרסיבית. כעת, על פי השערת הייצוג הליניארי, ברשתות עצביות, מושגים מקודדים בתוך תת-המרחבים הליניאריים של ייצוגים. מודלים אחרונים מצאו שטענה זו נכונה במודלים של רשתות עצביות המאומנות על שפה טבעית יחד עם הפצות קלט אחרות.

יתרה מזאת, במחקרי פרשנות, מסגרת ההפשטה המקרית משתמשת בהתערבויות חילופיות כדי לבסס את התפקיד של רכיבי רשת עצבית כלאחר יד בעת יישום התנהגויות מסוימות. ההיגיון מאחורי התערבות מחליפים הוא שאם מתקנים ייצוג למה שהוא היה עבור קלט נגד עובדתי, והתערבות זו משפיעה על הפלט של המודל באופן עקבי באופן שבו הטענות שהועלו על ידי מסגרת ReFT לגבי הרכיב שאחראי להפקת הייצוג הזה, אז הרכיב ממלא תפקיד סיבתי בהתנהגות. למרות שישנן מספר שיטות, התערבות מחולפת מבוזרת היא הגישה האידיאלית לבחון האם מושג מקודד בתת-מרחב ליניארי של ייצוג, כפי שנטען בהשערת הייצוג הליניארי. יתר על כן, שיטת DAS שימשה בעבר כדי למצוא ייצוג ליניארי במודלים של שפה של תכונות ישות, סנטימנט, מאפיינים לשוניים והיגיון מתמטי. עם זאת, מספר ניסויים הצביעו על כך ששיטת DAS היא מאוד אקספרסיבית, והיא בעלת יכולת למצוא תת-מרחבים יעילים סיבתיים גם כאשר מודל שפת השנאי אותחל באופן אקראי, ולכן עדיין לא למדו ייצוגים ספציפיים למשימה, וכתוצאה מכך להתווכח אם DAS יעיל ואחראי מספיק למשימות פרשנות.

האקספרסיביות שמציע DAS מעידה על כך שהגישה יכולה להיות כלי אידיאלי לשלוט בהתנהגות של מודל השפה יחד עם עבודתו על יצירה ניתנת לשליטה ועריכה אחראית. לכן, כדי להתאים מודלים של שפה למשימות במורד הזרם, מסגרת ReFT משתמשת בפעולת ההתערבות המבוזרת על מנת להפוך שיטה חדשה ליעילה של פרמטרים. יתרה מזאת, שיטת ReFT היא קבוצה של התערבויות, והמסגרת אוכפת שלכל שתי התערבויות הפועלות על אותה שכבה, עמדות ההתערבות חייבות להיות מפורקות, כשהפרמטרים של כל פונקציות ההתערבות נשארות בלתי תלויות. כתוצאה מכך, ה-ReFT הוא מסגרת גנרית הכוללת התערבויות על ייצוגים נסתרים במהלך העברת המודל קדימה.

ReFT: ניסויים ותוצאות

כדי להעריך את הביצועים שלה מול מסגרות PEFT קיימות, מסגרת ReFT מבצעת ניסויים על פני ארבעה אמות מידה מגוונות לעיבוד שפה טבעית, ומכסה מעל 20 מערכי נתונים, כשהמטרה העיקרית היא לספק תמונה עשירה של ביצועי המסגרת של LoReFT בתרחישים שונים. יתר על כן, כאשר מסגרת LoReFT מיושמת בחיים האמיתיים, מפתחים צריכים להחליט על כמה התערבויות ללמוד יחד עם עמדות הקלט והשכבות ליישם כל אחת מהן. כדי להשלים את המשימה, מסגרת ReFT מכווננת ארבעה היפרפרמטרים.

- מספר עמדות הקידומת להתערב בהן.

- מספר עמדות הסיומות להתערב בהן.

- באיזה סט של שכבות להתערב.

- האם לקשור פרמטרי התערבות בין עמדות שונות באותה שכבה או לא.

על ידי כך, מסגרת ReFT מפשטת את מרחב החיפוש ההיפרפרמטרי, ומבטיחה רק עלות מסקנת נוספת קבועה שאינה משתנה בהתאם לאורך ההנחיה.

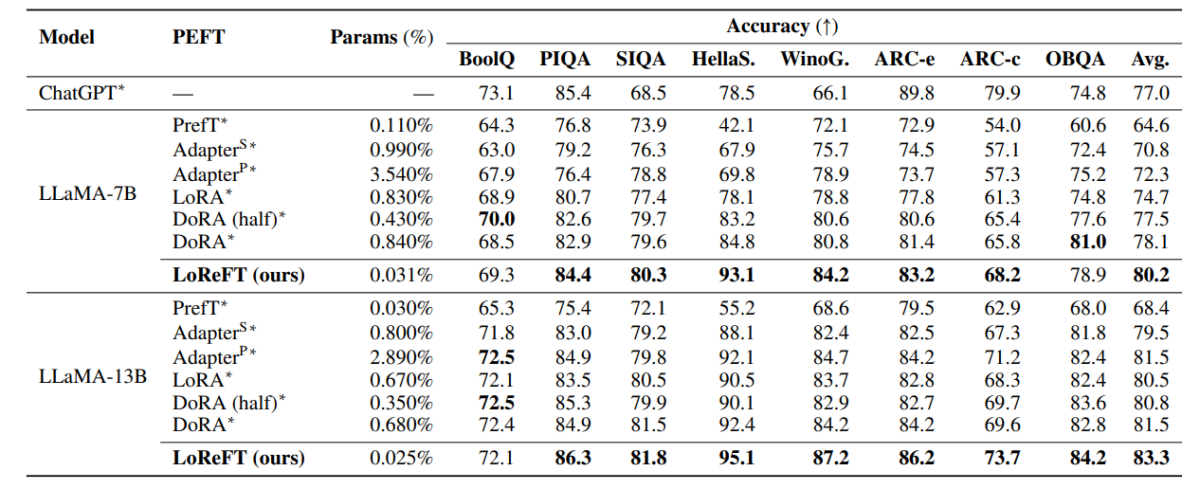

הטבלה לעיל משווה את הדיוק של מסגרות LLaMA-7B ו-LLaMA-13B מול מודלים קיימים של PEFT על פני 8 מערך נתונים של חשיבה תקינה. כפי שניתן לראות, מודל LoReFT עולה על גישות ה-PEFT הקיימות בהפרש הגון, למרות שיש לו הרבה פחות פרמטרים, כאשר הביצועים הממוצעים של שלוש ריצות מדווחים עם זרעי פרמטרים ברורים עבור מודל LoReFT. ה-param(%) מחושב על ידי חלוקת מספר הפרמטרים הניתנים לאימון במספר הפרמטרים הכוללים של המודל הגדול הבסיסי.

הטבלה לעיל מסכמת את השוואת הדיוק של מסגרות LLaMA-7B ו-LLaMA-13B מול מודלים קיימים של PEFT על פני 4 מערכי נתונים שונים של חשיבה אריתמטית, כאשר המסגרת מדווחת על הביצועים הממוצעים של שלוש ריצות עם זרעים אקראיים מובהקים. כפי שניתן לראות, למרות שיש לה הרבה פחות פרמים (%), המסגרת של LoReFT מתעלה על מסגרות PEFT קיימות בפער ניכר.

הטבלה שלמעלה מסכמת את השוואת הדיוק של ה-RoBERTa-base וה-RoBERTa-large frameworks מול מודלים קיימים של PEFT על פני מדד GLUE, כאשר המסגרת מדווחת על הביצועים הממוצעים של חמש ריצות עם זרעים אקראיים מובהקים. כפי שניתן לראות, למרות שיש לה הרבה פחות פרמים (%), המסגרת של LoReFT מתעלה על מסגרות PEFT קיימות בפער ניכר.

מחשבות סופיות

במאמר זה, דיברנו על LoReFT, אלטרנטיבה רבת עוצמה למסגרות PEFT קיימות המשיגה ביצועים חזקים על פני מדדים מארבעה תחומים שונים תוך שהיא מציעה עד פי 50 מהיעילות שהציעו דגמי PEFT קודמים מתקדמים. מודלים גדולים שעברו הכשרה מראש מותאמים לעתים קרובות לשימוש עבור תחומים או משימות חדשות, ובמהלך תהליך הכוונון, ניתן להתאים מודל בסיס יחיד למגוון רחב של משימות אפילו עם כמויות קטנות בלבד של נתונים בתוך הדומיין. לדגם. עם זאת, תהליך כוונון עדין של דגם שלם הוא גוזל משאבים, ויקר, במיוחד עבור מודלים של שפה עם מספר גבוה משמעותית של גודל ופרמטרים. כוונון עדין יעיל בפרמטרים או שיטות PeFT מציעות להתמודד עם העלויות הגבוהות הכרוכות בכוונון עדין של המודל כולו על ידי עדכון רק כמות קטנה מהמשקלים הכוללים הזמינים, תהליך המסייע בהפחתת זמן האימון יחד עם השימוש בזיכרון. יש לציין, LoReFT מבסס ביצועים חדישים חדשים בנושא הגיון בריא, מעקב אחר הוראות והבנת שפה טבעית מול ה-PEFTs החזקים ביותר.