בינה מלאכותית

UniTune: טכניקת עריכת תמונה עצבית אלטרנטיבית של גוגל

Google Research, כך נראה, תוקפת עריכת תמונות מבוססת טקסט ממספר חזיתות, וככל הנראה, מחכה לראות מה 'לוקח'. לוהט על עקבותיו של יציאתו השבוע נייר דמיון, ענקית החיפוש הציעה שיטה נוספת מבוססת דיפוזיה סמויה לביצוע עריכות מבוססות AI בלתי אפשריות בתמונות באמצעות פקודות טקסט, הפעם בשם UniTune.

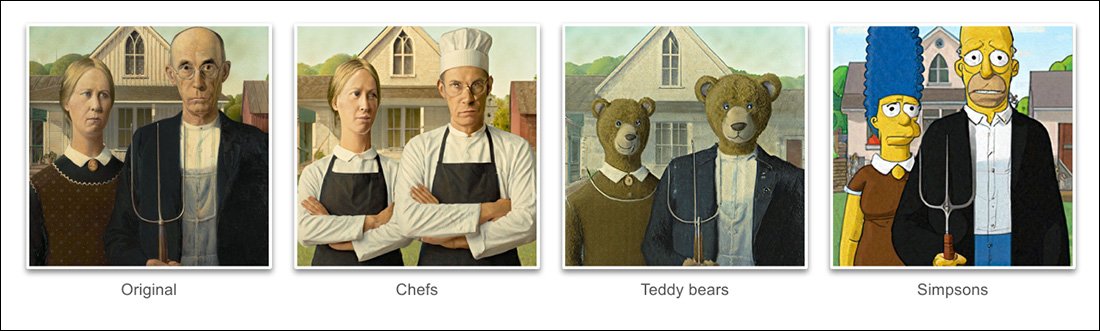

בהתבסס על הדוגמאות שניתנו בפרויקט מאמר חדש, UniTune השיגה דרגה יוצאת דופן של התפרקות של תנוחה סמנטית ורעיון מתוכן תמונה קשה בפועל:

השליטה של UniTune בקומפוזיציה סמנטית יוצאת מן הכלל. שימו לב כיצד בשורת התמונות העליונה, פניהם של שני האנשים לא עווות על ידי הטרנספורמציה יוצאת הדופן בשאר תמונת המקור (מימין). מקור: https://arxiv.org/pdf/2210.09477.pdf

כפי שמעריצי Stable Diffusion למדו עד עכשיו, החלת עריכות על קטעים חלקיים של תמונה מבלי לשנות לרעה את שאר התמונה יכולה להיות פעולה מסובכת, לפעמים בלתי אפשרית. למרות הפצות פופולריות כגון AUTOMATIC1111 יכול ליצור מסכות לעריכות מקומיות ומוגבלות, התהליך מפותל ולעתים קרובות בלתי צפוי.

התשובה הברורה, לפחות למתרגל ראיית מחשב, היא להכניס שכבה של פילוח סמנטי שמסוגל לזהות ולבודד אובייקטים בתמונה ללא התערבות משתמש, ואכן, היו כמה יוזמות חדשות לאחרונה בקו המחשבה הזה.

אחר אפשרות לנעילה של פעולות עריכת תמונות עצביות מבולגנות ומסובכות היא למנף את ההכשרה המוקדמת של OpenAI המשפיעה על שפה-תמונה (CLIP) מודול, שנמצא בלב מודלים של דיפוזיה סמויה כגון DALL-E 2 ו-Stable Diffusion, לשמש כמסנן בנקודה שבה מודל טקסט לתמונה מוכן לשלוח עיבוד מפורש בחזרה למשתמש . בהקשר זה, CLIP צריך לפעול כמודול זקיף ובקרת איכות, לדחות עיבודים פגומים או לא מתאימים אחרת. זה עומדים להתכונן (קישור דיסקורד) בפורטל מונחה API של DreamStudio של Stability.ai.

עם זאת, מכיוון ש-CLIP הוא ללא ספק גם האשם וגם הפתרון בתרחיש כזה (מכיוון שהוא בעצם גם הודיע על האופן שבו התמונה התפתחה), ומכיוון שדרישות החומרה עשויות לחרוג ממה שסביר שיהיה זמין מקומית למשתמש קצה, ייתכן שגישה זו אינה אידיאלית.

שפה דחוסה

ה-UniTune המוצע במקום זאת 'מכוונן' מודל דיפוזיה קיים - במקרה זה, ה-Image של גוגל עצמה, אם כי החוקרים קובעים שהשיטה תואמת ארכיטקטורות דיפוזיה סמויות אחרות - כך שמוזרק לתוכה אסימון ייחודי שניתן לזמן אליו על ידי הכללתו בהנחיית טקסט.

בערך הנקוב, זה נשמע כמו גוגל תא חלומות, כיום אובססיה בקרב מעריצי ומפתחי Stable Diffusion, שיכולים להחדיר דמויות או חפצים חדשים למחסום קיים, לרוב תוך פחות משעה, בהתבסס על קומץ תמונות מקור בלבד; או אחרת כמו היפוך טקסטואלי, שיוצר קבצי 'צדדיות' עבור מחסום, שלאחר מכן מטופלים כאילו הוכשרו במקור לתוך המודל, ויכולים לנצל את המשאבים העצומים של המודל על ידי שינוי מסווג הטקסט שלו, וכתוצאה מכך נוצר קובץ זעיר (בהשוואה ל- נקודות גזום של מינימום 2GB של DreamBooth).

למעשה, טוענים החוקרים, UniTune דחתה את שתי הגישות הללו. הם גילו שהיפוך טקסט השמיט יותר מדי פרטים חשובים, בעוד DreamBooth "הופיע גרוע יותר ולקח יותר זמן" מאשר הפתרון שהם התיישבו בו לבסוף.

אף על פי כן, UniTune משתמשת באותה גישת 'מטאפפרופט' סמנטית מובלעת כמו DreamBooth, עם שינויים מיומנים המזומנים על ידי מילים ייחודיות שנבחרו על ידי המאמן, שלא יתנגשו עם שום מונח שקיים כיום במודל שחרור פומבי שהוכשר בעמל רב.

'כדי לבצע את פעולת העריכה, אנו דוגמים את הדגמים המכוונים עם ההנחיה "[rare_tokens] edit_prompt" (למשל "beikkpic two alls in a restaurant" או "beikkpic a minion").'

התהליך

למרות שזה מעורר תמיהה מדוע שני מאמרים כמעט זהים, מבחינת הפונקציונליות הסופית שלהם, צריכים להגיע מגוגל באותו שבוע, יש, למרות מספר עצום של קווי דמיון בין שתי היוזמות, לפחות הבדל אחד ברור בין UniTune לאימאג'יק - האחרון משתמש בהנחיות בשפה טבעית 'לא דחוסה' כדי להנחות פעולות עריכת תמונות, בעוד ש-UniTune מתאמן באסימונים ייחודיים בסגנון DreamBooth.

לכן, אם היית עורך עם Imagic ורצית לבצע טרנספורמציה מסוג זה...

מתוך הנייר של UniTune - UniTune מעמידה את עצמה מול מסגרת העריכה העצבית המתחרה האהובה על גוגל, SDEdit. התוצאות של UniTune נמצאות בקצה הימני, בעוד המסכה המשוערת נראית בתמונה השנייה משמאל.

.. ב-Imagic, היית קלט "האדם השלישי, יושב ברקע, כמפלצת פרוותית חמודה".

הפקודה המקבילה של UniTune תהיה 'בחור מאחור בתור [x]', שם x היא כל מילה מוזרה וייחודית שנקשרה לקונספט המאומן המזוהה עם דמות המפלצת הפרוותית.

בעוד שמספר תמונות מוזנות ל-DreamBooth או ל-Textual Inversion מתוך כוונה ליצור הפשטה בסגנון deepfake שניתן לפקודה לתנוחות רבות, הן UniTune והן Imagic מזינות במקום תמונה אחת למערכת - התמונה המקורית והבתולית.

זה דומה לאופן שבו פעלו רבים מכלי העריכה המבוססים על GAN של השנים האחרונות - על ידי המרת תמונת קלט לקודים סמויים במרחב הסמוי של ה-GAN ולאחר מכן התייחסות לקודים הללו ושליחתם לחלקים אחרים של ה-GAN. מקום לשינוי (כלומר הזנת תמונה של אדם צעיר כהה שיער והקרנתה דרך קודים סמויים הקשורים ל'זקן' או 'בלונדינית' וכו').

עם זאת, התוצאות, במודל דיפוזיה, ובאמצעות שיטה זו, מדויקות להפליא בהשוואה, והרבה פחות מעורפלות:

תהליך הכוונון העדין

שיטת UniTune בעצם שולחת את התמונה המקורית דרך מודל דיפוזיה עם סט הוראות כיצד יש לשנות אותה, תוך שימוש במאגרים העצומים של נתונים זמינים שהוכשרו למודל. למעשה, אתה יכול לעשות זאת עכשיו עם Stable Diffusion's img2img פונקציונליות - אבל לא בלי עיוות או שינוי כלשהו של חלקי התמונה שהייתם מעדיפים לשמור.

במהלך תהליך UniTune, המערכת היא לכוונןd, כלומר UniTune מאלצת את הדגם לחדש את האימון, כאשר רוב השכבות שלו לא קפואות (ראה להלן). ברוב המקרים, כוונון עדין יטנק את האוברול כללי ערכי אובדן של מודל בעל ביצועים גבוהים, לטובת הזרקה או חידוד של היבט אחר שרצוי ליצור או לשפר.

עם זאת, עם UniTune נראה כי עותק הדגם שהופעל עליו, למרות שהוא עשוי לשקול כמה גיגה-בייט או יותר, יטופל כ"קליפה" חד פעמית, ויושלך בסוף התהליך, לאחר ששירת מטרה אחת. סוג זה של נפח נתונים מזדמן הופך למשבר אחסון יומיומי עבור מעריצי DreamBooth, שהדגמים שלהם, גם כאשר הם גזומים, הם לא פחות מ-2GB לכל נושא.

כמו ב-Imagic, הכוונון הראשי ב-UniTune מתרחש בשתיים התחתונות מתוך שלוש השכבות ב-Image (בסיס 64px, 64px>256px ו-256px>1024px). בניגוד ל-Imagic, החוקרים רואים ערך פוטנציאלי כלשהו באופטימיזציה של הכוונון גם עבור שכבת רזולוציית העל האחרונה והגדולה הזו (אם כי הם לא ניסו זאת עדיין).

עבור השכבה הנמוכה ביותר של 64 פיקסלים, המודל מוטה לכיוון תמונת הבסיס במהלך האימון, כאשר זוגות כפולים מרובים של תמונה/טקסט מוזנים למערכת במשך 128 איטרציות בגודל אצווה של 4, ועם אדפקטור כפונקציית ההפסד, הפועלת בקצב למידה של 0.0001. דרך ה מקודד T5 לבדו מוקפא במהלך כוונון עדין זה, הוא מוקפא גם במהלך אימון ראשוני של Imagen

לאחר מכן חוזרים על הפעולה שלעיל עבור שכבת 64>256 פיקסלים, תוך שימוש באותו הליך הגדלת רעש שהופעל בהדרכה המקורית של Imagen.

דגימה

ישנן שיטות דגימה אפשריות רבות שבאמצעותן ניתן להעלות את השינויים שבוצעו מהמודל המכוונן, כולל הכוונה חינם לסווג (CFG), עמוד התווך גם של דיפוזיה יציבה. CFG מגדיר בעצם את המידה שבה המודל חופשי "לעקוב אחר הדמיון שלו" ולחקור את אפשרויות העיבוד - או לחלופין, בהגדרות נמוכות יותר, את המידה שבה הוא צריך לדבוק בנתוני מקור הקלט, ולבצע שינויים גורפים או דרמטיים פחות. .

כמו היפוך טקסטואלי (קצת פחות עם DreamBooth), UniTune ניתנת להחלת סגנונות גרפיים מובהקים על תמונות מקוריות, כמו גם עריכות פוטוריאליסטיות יותר.

החוקרים ערכו גם ניסויים SDEditטכניקת 'התחלה מאוחרת', שבה מעודדים את המערכת לשמר את הפרטים המקוריים על ידי היותה 'רעש' חלקית בלבד מלכתחילה, אלא שמירה על המאפיינים המהותיים שלה. למרות שהחוקרים השתמשו בזה רק בשכבות הנמוכות ביותר (64px), הם מאמינים שזו יכולה להיות טכניקת דגימה נוספת שימושית בעתיד.

גם החוקרים ניצלו הנחיה להנחיה כטכניקה נוספת מבוססת טקסט לתנאי המודל:

'בהגדרה "הנחיה להנחיה", מצאנו שטכניקה שאנו מכנים הנחיה מהירה מועילה במיוחד לכוונון הנאמנות וההבעה.

'הנחיה מהירה דומה להכוונה חינם של מסווג, אלא שהקו הבסיסי הוא הנחיה שונה במקום המודל הבלתי מותנה. זה מנחה את המודל לכיוון הדלתא בין שתי ההנחיות.'

עם זאת, הדרכה מהירה, קובעים המחברים, הייתה נחוצה רק מדי פעם במקרים בהם CFG לא הצליח להשיג את התוצאה הרצויה.

גישת דגימה חדשה נוספת שנתקלה בה במהלך הפיתוח של UniTune הייתה אינטרפולציה, כאשר אזורי התמונה נבדלים מספיק כך שגם התמונה המקורית וגם התמונה שהשתנתה דומים מאוד בקומפוזיציה, מה שמאפשר להשתמש באינטרפולציה 'נאיבית' יותר.

אינטרפולציה יכולה להפוך את התהליכים המאומצים יותר של UniTune למיותרים במקרים שבהם האזורים שיש לבצע טרנספורמציה הם דיסקרטיים ובעלי שוליים טובים.

המחברים מציעים שאינטרפולציה עשויה לעבוד כל כך טוב, עבור מספר רב של תמונות מקור יעד, עד שניתן להשתמש בה כהגדרת ברירת מחדל, וראו גם שיש לה את הכוח לבצע טרנספורמציות יוצאות דופן במקרים שבהם חסימות מורכבות אינן מתרחשות. צריך לנהל משא ומתן בשיטות אינטנסיביות יותר.

UniTune יכולה לבצע עריכות מקומיות עם או בלי מסכות עריכה, אך יכולה גם להחליט באופן חד צדדי היכן למקם עריכות, עם שילוב יוצא דופן של כוח פרשני ובסיסיות חזקה של נתוני קלט המקור:

בתמונה העליונה ביותר בעמודה השנייה, UniTune, שהופקדה על הכנסת 'רכבת אדומה ברקע', הציבה אותה במיקום מתאים ואותנטי. שימו לב בדוגמאות האחרות כיצד שלמות סמנטית לתמונת המקור נשמרת גם בעיצומם של שינויים יוצאי דופן בתוכן הפיקסלים ובסגנונות הליבה של התמונות.

חֶבִיוֹן

למרות שהאיטרציה הראשונה של כל מערכת חדשה תהיה איטית, ולמרות שזה אפשרי שמעורבות קהילתית או מחויבות תאגידית (זה לא בדרך כלל שניהם) בסופו של דבר יאיץ וייעל שגרה עתירת משאבים, גם UniTune וגם Imagic מבצעות כמה תמרוני למידת מכונה גדולים למדי על מנת ליצור את העריכות המדהימות הללו, וספק אם תהליך צרב משאבים שכזה יכול להיות מופחת לשימוש ביתי, ולא גישה מונעת API (אם כי האחרון עשוי להיות רצוי יותר עבור Google ).

כרגע, הנסיעה הלוך ושוב מקלט לתוצאה היא כ-3 דקות ב-T4 GPU, עם כ-30 שניות נוספות להסקת מסקנות (לפי כל שגרת הסקה). המחברים מודים כי מדובר בהשהיה גבוהה, וכמעט שאינה נחשבת 'אינטראקטיבית', אך הם גם מציינים שהדגם נשאר זמין לעריכות נוספות לאחר כוונון ראשוני, עד שהמשתמש יסיים את התהליך, מה שמקצר את זמן העריכה. .

פורסם לראשונה ב-21 באוקטובר 2022.