בינה מלאכותית

בעיית הקופסה השחורה בלימודי תואר שני: אתגרים ופתרונות מתעוררים

למידת מכונה, תת-קבוצה של AI, כוללת שלושה מרכיבים: אלגוריתמים, נתוני אימון והמודל המתקבל. אלגוריתם, בעצם קבוצה של נהלים, לומד לזהות דפוסים מתוך סט גדול של דוגמאות (נתוני אימון). שיאו של אימון זה הוא מודל למידת מכונה. לדוגמה, אלגוריתם מאומן עם תמונות של כלבים יביא למודל המסוגל לזהות כלבים בתמונות.

קופסה שחורה בלמידת מכונה

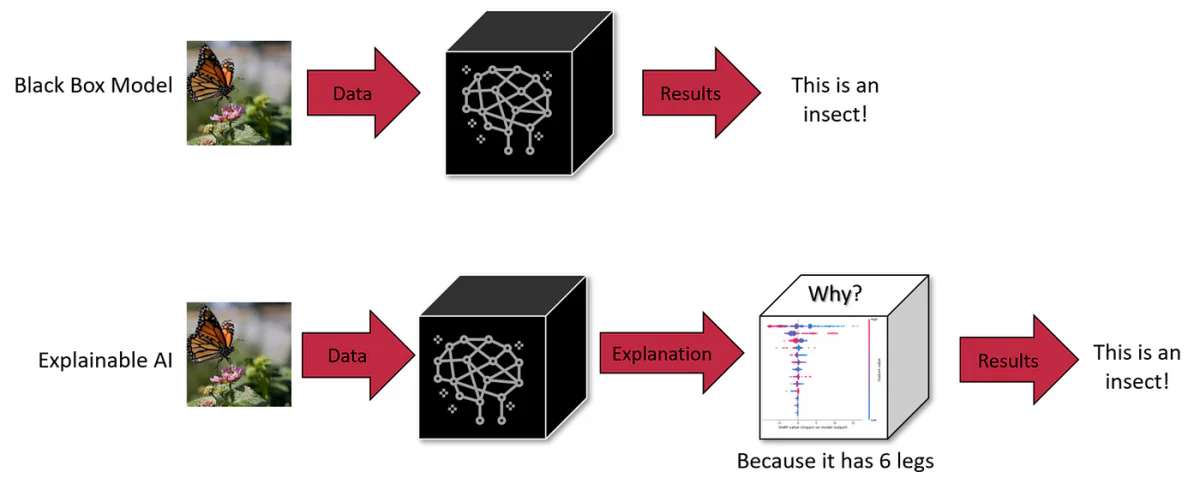

בלמידת מכונה, כל אחד משלושת המרכיבים - אלגוריתם, נתוני אימון או מודל - יכול להיות קופסה שחורה. בעוד שאלגוריתמים ידועים לרוב בציבור, מפתחים עשויים לבחור לשמור את המודל או את נתוני ההדרכה בסוד כדי להגן על קניין רוחני. הערפול הזה מאתגר להבין את תהליך קבלת ההחלטות של ה-AI.

קופסאות שחורות בינה מלאכותית הן מערכות שהפעולה הפנימית שלהן נשארת אטומה או בלתי נראית למשתמשים. משתמשים יכולים להזין נתונים ולקבל פלט, אבל ההיגיון או הקוד שמייצרים את הפלט נשארים מוסתרים. זהו מאפיין נפוץ במערכות בינה מלאכותיות רבות, כולל דגמים גנרטיביים מתקדמים כמו ChatGPT ו-DALL-E 3.

LLMs כגון GPT-4 מהווים אתגר משמעותי: העבודה הפנימית שלהם אטומה במידה רבה, מה שהופך אותם ל"קופסאות שחורות". אטימות כזו היא לא רק פאזל טכני; הוא מציב דאגות בטיחות ואתיות בעולם האמיתי. לדוגמה, אם איננו יכולים להבחין כיצד מערכות אלו מגיעות למסקנות, האם נוכל לסמוך עליהן בתחומים קריטיים כמו אבחונים רפואיים או הערכות פיננסיות?

קנה המידה והמורכבות של לימודי תואר שני

קנה המידה של מודלים אלה מוסיף למורכבותם. קחו למשל את GPT-3 עם 175 מיליארד הפרמטרים שלו, ודגמים חדשים יותר עם טריליונים. כל פרמטר מקיים אינטראקציה בדרכים מורכבות בתוך הרשת העצבית, תורם ליכולות מתעוררות שאינן ניתנות לחיזוי על ידי בחינת רכיבים בודדים בלבד. קנה מידה ומורכבות אלה הופכים את זה כמעט בלתי אפשרי לתפוס את ההיגיון הפנימי שלהם במלואו, מה שמציב מכשול באבחון הטיות או התנהגויות לא רצויות במודלים אלה.

הפשרה: קנה מידה לעומת פרשנות

צמצום היקף ה-LLMs עשוי לשפר את יכולת הפרשנות אך במחיר היכולות המתקדמות שלהם. קנה המידה הוא מה שמאפשר התנהגויות שמודלים קטנים יותר לא יכולים להשיג. זה מציג פשרה אינהרנטית בין קנה מידה, יכולת ופרשנות.

השפעת בעיית הקופסה השחורה של LLM

1. קבלת החלטות פגומה

האטימות בתהליך קבלת ההחלטות של LLMs כמו GPT-3 או BERT יכולה להוביל להטיות ושגיאות שלא אותרו. בתחומים כמו שירותי בריאות או משפט פלילי, שבהם להחלטות יש השלכות מרחיקות לכת, חוסר היכולת לבצע ביקורת על תקינות אתית והגיונית של לימודי LLM היא דאגה גדולה. לדוגמה, אבחון רפואי LLM המסתמך על נתונים מיושנים או מוטים יכול לתת המלצות מזיקות. באופן דומה, תואר שני בתהליכי גיוס עובדים עלולים בטעות להנציח את ההיבטים המגדריים. אופי הקופסה השחורה, אם כן, לא רק מסתיר פגמים אלא יכול להגביר אותם, מה שמחייב גישה פרואקטיבית להגברת השקיפות.

2. יכולת הסתגלות מוגבלת בהקשרים מגוונים

היעדר התובנה לגבי פעולתם הפנימית של LLMs מגביל את יכולת ההסתגלות שלהם. לדוגמה, LLM שכירה עשוי להיות לא יעיל בהערכת מועמדים לתפקיד שמעריך כישורים מעשיים על פני כישורים אקדמיים, בשל חוסר יכולתו להתאים את קריטריוני ההערכה שלו. באופן דומה, LLM רפואי עשוי להיאבק עם אבחנות מחלות נדירות עקב חוסר איזון בנתונים. חוסר הגמישות הזה מדגיש את הצורך בשקיפות לכיול מחדש של LLMs עבור משימות והקשרים ספציפיים.

3. הטיה ופערי ידע

העיבוד של LLMs של נתוני אימון עצומים כפוף למגבלות המוטלות על ידי האלגוריתמים וארכיטקטורות המודל שלהם. לדוגמה, LLM רפואי עשוי להראות הטיות דמוגרפיות אם הוא מאומן על מערכי נתונים לא מאוזנים. כמו כן, מיומנותו של LLM בנושאי נישה עלולה להיות מטעה, ולהוביל לתפוקות שגויות בביטחון עצמי. טיפול בהטיות ובפערי הידע הללו דורש יותר מסתם נתונים נוספים; זה דורש בדיקה של מכניקת העיבוד של המודל.

4. אחריות משפטית ואתית

האופי המעורפל של ה-LLM יוצר תחום אפור משפטי לגבי אחריות לכל נזק שייגרם מהחלטותיהם. אם LLM במסגרת רפואית מספק ייעוץ שגוי המוביל לנזק למטופל, קביעת האחריות הופכת לקשה בגלל האטימות של המודל. אי ודאות משפטית זו מהווה סיכונים עבור גופים הפורסים LLMs באזורים רגישים, המדגישה את הצורך בממשל ברור ושקיפות.

5. בעיות אמון ביישומים רגישים

עבור לימודי תואר שני בשימוש בתחומים קריטיים כמו בריאות ופיננסים, חוסר השקיפות מערער את אמינותם. משתמשים ורגולטורים צריכים להבטיח שהמודלים האלה לא יכילו הטיות או יקבלו החלטות על סמך קריטריונים לא הוגנים. אימות היעדר הטיה בלימודי LLM מחייב הבנה של תהליכי קבלת ההחלטות שלהם, תוך שימת דגש על החשיבות של יכולת ההסבר לפריסה אתית.

6. סיכונים עם נתונים אישיים

LLMs דורשים נתוני הכשרה נרחבים, שעשויים לכלול מידע אישי רגיש. אופי הקופסה השחורה של מודלים אלה מעורר חששות לגבי אופן עיבוד הנתונים והשימוש בהם. לדוגמה, LLM רפואי שהוכשר על רישומי מטופלים מעלה שאלות לגבי פרטיות ושימוש בנתונים. הבטחה שלא נעשה שימוש לרעה בנתונים אישיים או לא מנוצלים דורשת תהליכי טיפול שקופים בנתונים במסגרת המודלים הללו.

פתרונות חדשים לפירוש

כדי להתמודד עם אתגרים אלו, מפתחים טכניקות חדשות. אלה כוללים שיטות קירוב נגד עובדתיות (CF). השיטה הראשונה כוללת הנחיה של LLM לשנות מושג טקסט מסוים תוך שמירה על קונספטים אחרים קבועים. גישה זו, על אף שהיא יעילה, היא עתירת משאבים בזמן מסקנות.

הגישה השנייה כוללת יצירת מרחב הטמעה ייעודי בהנחיית LLM במהלך האימון. רווח זה מתיישר עם גרף סיבתי ועוזר לזהות התאמות המקורבות ל-CFs. שיטה זו דורשת פחות משאבים בזמן הבדיקה והוכחה שהיא מסבירה ביעילות את תחזיות המודל, אפילו ב-LLMs עם מיליארדי פרמטרים.

גישות אלו מדגישות את החשיבות של הסברים סיבתיים במערכות NLP כדי להבטיח בטיחות וביסוס אמון. קירובים קונטר-עובדתיים מספקים דרך לדמיין כיצד טקסט נתון ישתנה אם מושג מסוים בתהליך היצירתי שלו היה שונה, ומסייעים להערכת השפעה סיבתית מעשית של מושגים ברמה גבוהה במודלים של NLP.

צלילה עמוקה: שיטות הסבר וסיבתיות בלימודי LLM

כלי בדיקה וחשיבות תכונה

גישוש היא טכניקה המשמשת לפענוח מה מקודדים הייצוגים הפנימיים במודלים. זה יכול להיות מפוקח או לא מפוקח והוא נועד לקבוע אם מושגים ספציפיים מקודדים במקומות מסוימים ברשת. למרות שהם יעילים במידה מסוימת, בדיקות לא מצליחות לספק הסברים סיבתיים, כפי שהודגשו על ידי Geiger et al. (2021).

כלי חשיבות תכונות, צורה נוספת של שיטת הסבר, מתמקדים לעתים קרובות בתכונות קלט, אם כי שיטות מסוימות המבוססות על גרדיאנט מרחיבות זאת למצבים נסתרים. דוגמה לכך היא שיטת Integrated Gradients, המציעה פרשנות סיבתית על ידי בחינת תשומות בסיס (קונטרה-עובדתיות, CF). למרות התועלת שלהן, השיטות הללו עדיין מתקשות לחבר את הניתוחים שלהן עם מושגים מהעולם האמיתי מעבר למאפייני קלט פשוטים.

שיטות מבוססות התערבות

שיטות מבוססות התערבות כוללות שינוי תשומות או ייצוגים פנימיים כדי ללמוד השפעות על התנהגות המודל. שיטות אלו יכולות ליצור מצבי CF להערכת השפעות סיבתיות, אך לעתים קרובות הן יוצרות תשומות בלתי סבירות או מצבי רשת אלא אם כן נשלטות בקפידה. מודל פרוקסי סיבתי (CPM), בהשראת המושג S-learner, הוא גישה חדשה בתחום זה, המחקה את ההתנהגות של המודל המוסבר תחת תשומות CF. עם זאת, הצורך במסביר מובהק לכל דגם הוא מגבלה עיקרית.

קירוב קונטרה-עובדות

שימוש נרחב ב-counterfactuals בלמידת מכונה להגדלת נתונים, הכוללים הפרעות לגורמים או תוויות שונות. אלה יכולים להיווצר באמצעות עריכה ידנית, החלפת מילות מפתח היוריסטיות או שכתוב אוטומטי של טקסט. עריכה ידנית אמנם מדויקת, אך היא גם גוזלת משאבים. לשיטות המבוססות על מילות מפתח יש מגבלות, וגישות גנרטיביות מציעות איזון בין שטף לכיסוי.

הסברים נאמנים

נאמנות בהסברים מתייחסת לתיאור מדויק של ההיגיון הבסיסי של המודל. אין הגדרה מקובלת אוניברסלית של נאמנות, מה שמוביל לאפיון שלה באמצעות מדדים שונים כמו רגישות, עקביות, הסכם חשיבות תכונה, יציבות וסימולציה. רוב השיטות הללו מתמקדות בהסברים ברמת התכונה ולעיתים קרובות מערבבים מתאם עם סיבתיות. עבודתנו שואפת לספק הסברי מושג ברמה גבוהה, תוך מינוף ספרות הסיבתיות כדי להציע קריטריון אינטואיטיבי: סדר-נאמנות.

התעמקנו במורכבות הטבועה של לימודי LLM, תוך הבנת אופי 'הקופסה השחורה' שלהם ואת האתגרים המשמעותיים שהיא מציבה. מהסיכונים של קבלת החלטות פגומות בתחומים רגישים כמו בריאות ופיננסים וכלה בשאלות האתיות סביב הטיה והגינות, הצורך בשקיפות בלימודי LLM מעולם לא היה ברור יותר.

עתידם של לימודי LLM והשתלבותם בחיי היומיום שלנו ובתהליכי קבלת החלטות קריטיים תלויים ביכולת שלנו להפוך את המודלים הללו לא רק למתקדמים יותר אלא גם מובנים ובעלי אחריות. השאיפה לאפשרות הסבר ופרשנות היא לא רק מאמץ טכני אלא היבט בסיסי של בניית אמון במערכות AI. ככל ש-LLMs ישתלבו יותר בחברה, הדרישה לשקיפות תגדל, לא רק מצד מתרגלי AI אלא מכל משתמש שמקיים אינטראקציה עם מערכות אלו.