Kecerdasan Buatan

Mengubah Emosi dalam Rekaman Video Dengan AI

Para peneliti dari Yunani dan Inggris telah mengembangkan pendekatan pembelajaran mendalam yang baru untuk mengubah ekspresi dan suasana hati yang tampak dari orang-orang dalam rekaman video, sambil menjaga ketepatan gerakan bibir mereka dengan audio asli dengan cara yang tidak dapat dilakukan oleh upaya sebelumnya. .

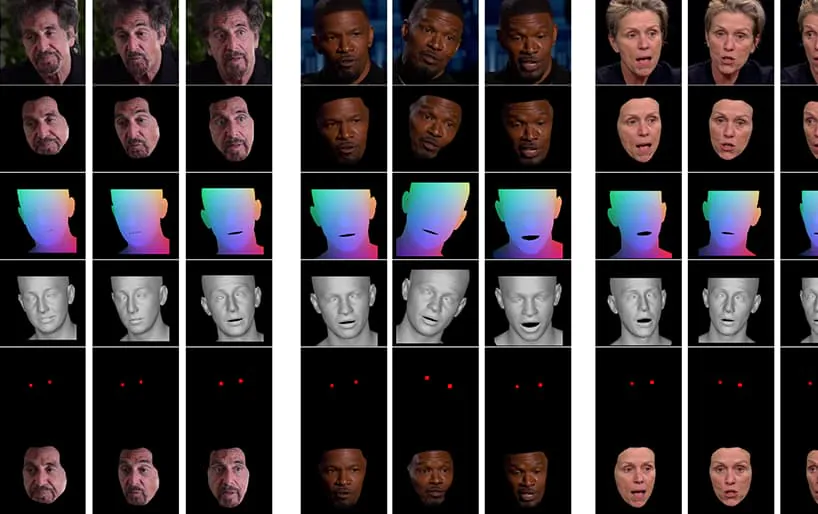

Dari video yang menyertai makalah (disematkan di akhir artikel ini), klip singkat aktor Al Pacino yang ekspresinya diubah secara halus oleh NED, berdasarkan konsep semantik tingkat tinggi yang mendefinisikan ekspresi wajah individu, dan emosi yang terkait. Metode 'Didorong Referensi' di sebelah kanan mengambil emosi yang ditafsirkan dari video sumber dan menerapkannya ke keseluruhan rangkaian video. Sumber: https://www.youtube.com/watch?v=Li6W8pRDMJQ

Bidang khusus ini termasuk dalam kategori berkembang emosi yang dipalsukan, di mana identitas penutur aslinya dipertahankan, tetapi ekspresi dan ekspresi mikronya diubah. Seiring dengan semakin matangnya teknologi AI ini, produksi film dan TV dapat melakukan perubahan halus pada ekspresi aktor – namun juga membuka kategori baru yaitu video deepfake yang 'diubah secara emosi'.

Mengubah Wajah

Ekspresi wajah untuk figur publik, seperti politisi, dikuratori dengan ketat; pada tahun 2016 muncul ekspresi wajah Hillary Clinton di bawah pengawasan media yang intens karena potensi dampak negatifnya terhadap prospek pemilihannya; ekspresi wajah, ternyata, juga a topik yang diminati ke FBI; dan mereka adalah indikator kritis dalam wawancara kerja, menjadikan prospek (jauh) filter 'kontrol ekspresi' langsung sebagai pengembangan yang diinginkan bagi pencari kerja yang mencoba melewati layar awal di Zoom.

Sebuah studi tahun 2005 dari Inggris menegaskan bahwa penampilan wajah mempengaruhi keputusan pemungutan suara, sementara fitur Washington Post 2019 memeriksa penggunaan berbagi klip video 'di luar konteks', yang saat ini merupakan hal terdekat yang dimiliki oleh para pendukung berita palsu untuk benar-benar dapat mengubah bagaimana seorang tokoh publik berperilaku, menanggapi, atau merasakan.

Menuju Manipulasi Ekspresi Neural

Saat ini, kecanggihan dalam memanipulasi afek wajah masih belum sempurna, karena melibatkan penanganan penguraian dr kekusutan konsep tingkat tinggi (seperti sedih, marah, senang, tersenyum) dari konten video sebenarnya. Meskipun arsitektur deepfake tradisional tampaknya mencapai pemisahan ini dengan cukup baik, pencerminan emosi di berbagai identitas masih membutuhkan dua rangkaian wajah pelatihan berisi ekspresi yang cocok untuk setiap identitas.

Contoh umum gambar wajah dalam kumpulan data yang digunakan untuk melatih deepfake. Saat ini, Anda hanya dapat memanipulasi ekspresi wajah seseorang dengan membuat ekspresi khusus ID<>jalur ekspresi di jaringan saraf deepfake. Perangkat lunak deepfake era 2017 tidak memiliki pemahaman intrinsik dan semantik tentang 'senyuman' – perangkat lunak ini hanya memetakan dan mencocokkan perubahan yang dirasakan dalam geometri wajah di kedua subjek.

Apa yang diinginkan, dan belum tercapai dengan sempurna, adalah mengenali bagaimana subjek B (misalnya) tersenyum, dan hanya menciptakan senyum. 'senyum' beralih dalam arsitektur, tanpa perlu memetakannya ke gambar setara subjek A yang sedang tersenyum.

Grafik kertas baru berjudul Neural Emotion Director: Kontrol semantik ekspresi wajah yang mempertahankan ucapan dalam video “in-the-wild”, dan berasal dari para peneliti di School of Electrical & Computer Engineering di National Technical University of Athens, Institute of Computer Science di Foundation for Research and Technology Hellas (FORTH), dan College of Engineering, Mathematics and Physical Sciences di University of Exeter di Inggris.

Tim telah mengembangkan kerangka kerja yang disebut Direktur Emosi Saraf (NED), menggabungkan jaringan terjemahan emosi berbasis 3D, Manipulator Emosi Berbasis 3D.

NED mengambil urutan parameter ekspresi yang diterima dan menerjemahkannya ke domain target. Itu dilatih pada data yang tidak paralel, yang berarti tidak perlu melatih pada kumpulan data di mana setiap identitas memiliki ekspresi wajah yang sesuai.

Video, yang ditampilkan di akhir artikel ini, menjalani serangkaian pengujian di mana NED memaksakan keadaan emosional yang tampak ke rekaman dari kumpulan data YouTube.

Para penulis mengklaim bahwa NED adalah metode berbasis video pertama untuk 'mengarahkan' aktor dalam situasi acak dan tak terduga, dan telah membuat kode tersedia di NED's. halaman proyek.

Metode dan Arsitektur

Sistem dilatih pada dua kumpulan data video besar yang telah dianotasi dengan label 'emosi'.

Output diaktifkan oleh perender wajah video yang merender emosi yang diinginkan ke video menggunakan teknik sintesis gambar wajah tradisional, termasuk segmentasi wajah, penyelarasan dan pencampuran tengara wajah, di mana hanya area wajah yang disintesis, lalu diterapkan ke rekaman asli.

Arsitektur untuk saluran Neural Emotion Detector (NED). Sumber: https://arxiv.org/pdf/2112.00585.pdf

Awalnya, sistem memperoleh pemulihan wajah 3D dan menerapkan penjajaran tengara wajah pada bingkai input untuk mengidentifikasi ekspresi. Setelah ini, parameter ekspresi yang dipulihkan ini diteruskan ke Manipulator Emosi berbasis 3D, dan vektor gaya dihitung dengan menggunakan label semantik (seperti 'bahagia') atau dengan file referensi.

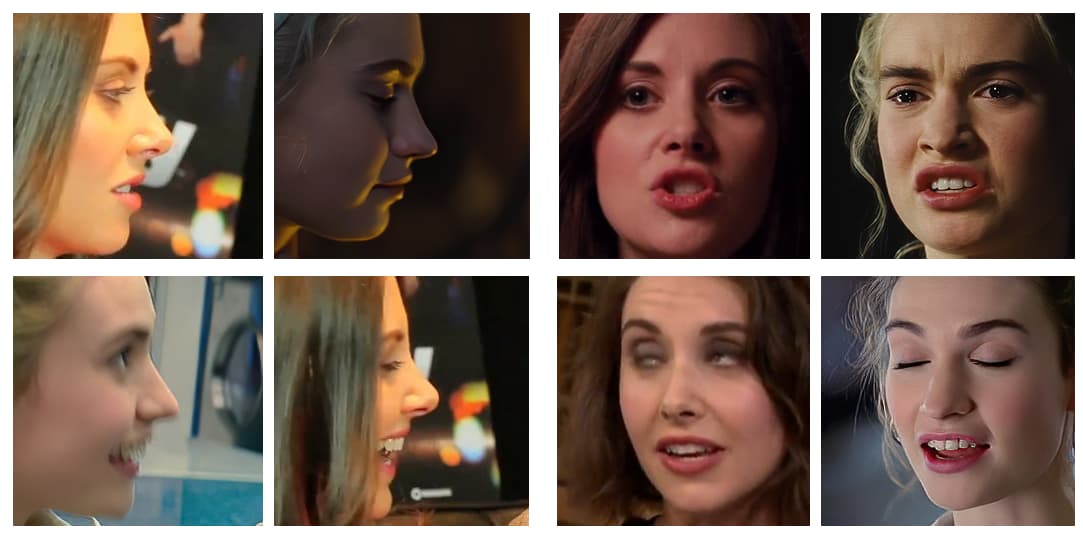

File referensi adalah video yang menggambarkan ekspresi/emosi tertentu yang dikenali, yang kemudian diterapkan ke keseluruhan video target, menukar ekspresi aslinya.

Bentuk wajah 3D akhir yang dihasilkan kemudian digabungkan dengan Normalized Mean Face Coordinate (NMFC) dan gambar mata (titik merah pada gambar di atas), dan diteruskan ke perender saraf, yang melakukan manipulasi akhir.

Hasil

Para peneliti melakukan studi ekstensif, termasuk studi pengguna dan ablasi, untuk mengevaluasi keefektifan metode terhadap pekerjaan sebelumnya, dan menemukan bahwa di sebagian besar kategori, NED mengungguli keadaan terkini dalam sub-sektor manipulasi wajah saraf ini.

Penulis makalah membayangkan bahwa implementasi selanjutnya dari pekerjaan ini, dan alat-alat yang serupa, akan berguna terutama di industri TV dan film, dengan menyatakan:

'Metode kami membuka sejumlah besar kemungkinan baru untuk penerapan teknologi rendering saraf yang berguna, mulai dari pascaproduksi film dan permainan video hingga avatar afektif foto-realistis.'

Ini adalah karya awal di lapangan, tetapi salah satu yang pertama mencoba pemeragaan wajah dengan video daripada gambar diam. Meskipun video pada dasarnya adalah banyak gambar diam yang berjalan bersama dengan sangat cepat, ada pertimbangan temporal yang membuat penerapan transfer emosi sebelumnya menjadi kurang efektif. Dalam video terlampir, dan contoh-contoh dalam makalah, penulis memasukkan perbandingan visual keluaran NED dengan metode-metode terbaru yang sebanding lainnya.

Perbandingan lebih rinci, dan lebih banyak contoh NED, dapat ditemukan di video lengkap di bawah ini:

3 Desember 2021, 18:30 GMT+2 – Atas permintaan salah satu penulis makalah, koreksi dilakukan terkait 'file referensi', yang secara keliru saya nyatakan sebagai foto diam (padahal sebenarnya adalah klip video). Juga perubahan nama Lembaga Ilmu Komputer pada Yayasan Riset dan Teknologi.

3 Desember 2021, 20:50 GMT+2 – Permintaan kedua dari salah satu penulis makalah untuk amandemen lebih lanjut atas nama lembaga yang disebutkan di atas.