Mesterséges Intelligencia

LoReFT: Representation Finetuning for Language Models

A paraméter-hatékony finomhangolási vagy PeFT-módszerek célja a nagy nyelvi modellek hozzáigazítása a kis számú súlyozáshoz szükséges frissítések révén. A létező értelmezhetőségi munkák többsége azonban bebizonyította, hogy a reprezentációk szemantikusan gazdag információkat kódolnak, ami arra utal, hogy jobb és hatékonyabb alternatíva lehet ezen reprezentációk szerkesztése. Az előre betanított nagy modelleket gyakran finomhangolják új tartományokhoz vagy feladatokhoz, és a finomhangolási folyamat során egyetlen alapmodell sokféle feladathoz igazítható, még akkor is, ha csak kis mennyiségű tartományon belüli adat áll rendelkezésre. a modellhez. A teljes modell finomhangolása azonban erőforrás-igényes és költséges, különösen a lényegesen nagyobb számú és paraméterű nyelvi modelleknél.

A paraméter-hatékony finomhangolási vagy PeFT módszerek azt javasolják, hogy a teljes modell finomhangolásával járó magas költségeket a rendelkezésre álló összsúlyok csak kis részének frissítésével kezeljék, ez a folyamat segít csökkenteni az edzési időt és a memóriahasználatot. Ennél is fontosabb, hogy a paraméter-hatékony finomhangolási vagy PeFT módszerek a finomhangoláshoz hasonló teljesítményt mutattak számos gyakorlati beállításban. Az adapterek, a Paraméter-hatékony finomhangolási vagy PeFT módszerek gyakori családja, megtanulnak egy szerkesztést, amely hozzáadható egy további súlykészlethez, amely a fagyasztott alapmodell mellett működik, a legújabb adapterekkel, például a LoRA-val csökkentve a betanítható paraméterek számát súlyfrissítések alacsony rangú közelítések használatával teljes súlyú mátrixok helyett az adapterek betanítása során.

Mivel a korábbi munkák bemutatják, hogy a reprezentációk szerkesztése jobb alternatívája lehet a paraméter-hatékony finomhangolásnak vagy a PeFT módszereknek, ebben a cikkben a reprezentációs finomhangolási vagy ReFT metódusokról fogunk beszélni, amelyek fagyasztott modellen működnek, és megtanuljuk a feladatspecifikus beavatkozások a rejtett reprezentációkra. Ennek a cikknek a célja a ReFt vagy Representation Fine-tuning keretrendszer részletes bemutatása, és megvizsgáljuk a keretrendszer mechanizmusát, módszertanát, architektúráját, valamint összehasonlítását a legmodernebb keretrendszerekkel. Tehát kezdjük.

ReFT: Reprezentációs finomhangolás nyelvi modellekhez

Annak érdekében, hogy az előre betanított nyelvi modelleket új területekre és feladatokra alkalmazzák, a jelenlegi keretrendszerek gyakran finomhangolják ezeket az előre betanított nyelvi modelleket, mivel a végrehajtott finomhangolási folyamat során egyetlen alapmodell többféle feladathoz is adaptálható. ha kis mennyiségű tartományon belüli adattal dolgozik. Bár a finomhangolási folyamat növeli az általános teljesítményt, ez költséges folyamat, különösen, ha a nyelvi modell jelentősen sok paraméterrel rendelkezik. A probléma megoldása és a kapcsolódó költségek csökkentése érdekében PeFT vagy Paraméter-hatékony keretrendszerek finomhangolása A teljes súlynak csak egy töredékét frissíti, ez a folyamat nemcsak az edzési időt, hanem a memóriahasználatot is csökkenti, lehetővé téve a PeFT-keretrendszerek számára, hogy hasonló teljesítményt érjenek el, mint a gyakorlati forgatókönyvekben alkalmazott teljes finomhangolási megközelítésekkel. Az Adapterek, a PeFT-ek gyakori családja, megtanulnak egy szerkesztést, amely hozzáadható egy további súlykészlethez, valamint a súlyok egy részhalmazához, amelyek összhangban működnek az alapmodell fagyasztott súlyokkal. A legújabb adapter keretrendszerek, mint pl LoRA és QLoRA bebizonyították, hogy lehetséges a teljes precíziós adapterek betanítása a csökkentett precíziós modelleken felül a teljesítmény befolyásolása nélkül. Az adapterek általában hatékonyabbak és eredményesebbek más, új modellkomponenseket bevezető módszerekkel összehasonlítva.

A paraméter-hatékony finomhangoló keretrendszerek jelenlegi csúcspontja, hogy a reprezentációk módosítása helyett a súlyokat módosítják. Az értelmezhetőséggel foglalkozó keretrendszerek azonban bebizonyították, hogy a reprezentációk gazdag szemantikai információt kódolnak, ami arra utal, hogy a reprezentációk szerkesztése jobb és hatékonyabb megközelítés lehet a súlyfrissítésekhez képest. Ez a feltevés, hogy a reprezentációk szerkesztése a jobb megközelítés, ez az alapja a ReFT vagy a reprezentáció finomhangolási keretrendszerének, amely beavatkozásokat tanít a modell súlyainak adaptálása helyett, lehetővé téve a modell számára, hogy az összes reprezentáció kis töredékét manipulálja a modell viselkedésének irányítására. a lefelé irányuló feladatok megoldására a következtetés során. A ReFT vagy Representation Fine-tuning módszerek a súlyalapú PeFT vagy Paraméter-hatékony finomhangoló keretrendszerek beugró helyettesítői. A ReFT-megközelítés azokból a legújabb modellekből merít ihletet, amelyek nagy modellértelmezési képességgel dolgoznak, és amelyek beavatkoznak a reprezentációkba, hogy hű oksági mechanizmusokat találjanak, és irányítják a modell viselkedését a következtetés során, ezért tekinthető a reprezentáció-szerkesztési modellek általánosításának. Ugyanerre építve a LoReFT vagy alacsony rangú altér A ReFT a ReFT erős és hatékony példánya, és a ReFT paraméterezése, amely beavatkozik az alacsony rangú vetületi mátrix által átfogott lineáris tér rejtett reprezentációiba, és közvetlenül a DAS-ra épít. vagy Distributed Alignment Search keretrendszer.

Tovább haladva, a teljes finomhangolással ellentétben a PeFT vagy Paraméter-hatékony finomhangolási keretrendszer a modell paramétereinek csak egy töredékét képezi, és a modellt a downstream feladatokhoz tudja igazítani. A paraméter-hatékony finomhangoló keretrendszer három fő kategóriába sorolható:

- Adapter alapú módszerek: Az adapter alapú módszerek további modulokat képeznek, például teljesen összekapcsolt rétegeket az előre betanított modell tetején, fagyasztott súlyokkal. A sorozatos adapterek a többrétegű perceptron vagy MLP és az LM vagy nagy modellfigyelő rétegek közé illesztenek be komponenseket, míg a párhuzamos adapterek modulokat adnak hozzá a meglévő komponensek mellé. Mivel az adapterek olyan új alkatrészeket adnak hozzá, amelyeket nem lehet könnyen a meglévő modellsúlyokba összehajtani, további terhet jelentenek a következtetés során.

- LoRA: A LoRA a legújabb változataival együtt alacsony rangú mátrixokkal közelíti meg az additív súlyokat edzés közben, és nem igényel többletköltséget a következtetés során, mivel a súlyfrissítések beolvaszthatók a modellbe, és ez az oka annak, hogy ezeket tekintjük aktuálisnak. legerősebb PeFT keretrendszer.

- Prompt alapú módszerek: A prompt alapú módszerek véletlenszerűen inicializált lágy tokeneket adnak hozzá a bemenethez, és betanítják a beágyazásaikat, miközben a nyelvi modell súlyát fagyasztva tartják. Az ezen módszerek által kínált teljesítmény gyakran nem kielégítő más PeFT-megközelítésekkel összehasonlítva, és jelentős következtetési általános költséggel is jár.

A súlyok frissítése helyett a ReFT keretrendszer megtanulja a beavatkozásokat a teljes reprezentáció egy kis töredékének módosítására. Ezen túlmenően a reprezentációs tervezéssel és az aktiválási kormányzással kapcsolatos közelmúltbeli munkák bebizonyították, hogy fix irányítóvektorok hozzáadása a maradék adatfolyamhoz elősegítheti az előre betanított nagy modellgenerációk bizonyos fokú ellenőrzését anélkül, hogy erőforrás-igényes lenne. finomhangolás. Más keretrendszerek bebizonyították, hogy a tanult skálázási és fordítási művelettel végzett reprezentációk szerkesztése megkísérli megfelelni, de nem haladja meg a LoRA adapterek által kínált teljesítményt a kevesebb tanult paraméterrel rendelkező feladatok széles skáláján. Ezen túlmenően ezeknek a keretrendszereknek a számos feladatban elért sikere bebizonyította, hogy az előre betanított nyelvi modellek által bevezetett reprezentációk gazdag szemantikával rendelkeznek, bár ezeknek a modelleknek a teljesítménye nem optimális, ami azt eredményezi, hogy a PeFT továbbra is a legkorszerűbb megközelítés. további következtetési teher nélkül.

ReFT : Módszertan és építészet

A stílusmegőrzési folyamat egyszerű megőrzése érdekében a ReFT keretrendszer egy transzformátor alapú nagy modellt feltételez célmodellként, amely képes a tokenek szekvenciájának kontextusba ágyazott megjelenítésére. Egy adott, n számú bemeneti tokennel rendelkező sorozathoz a ReFT keretrendszer először ezeket a bemeneti tokeneket beágyazza a reprezentációk listájába, amely után az m réteg egymás után kiszámítja a rejtett reprezentációk listáját a rejtett reprezentációk előző listájának függvényében. Minden rejtett reprezentáció egy vektor, és a nyelvi modell a végső rejtett reprezentációkat használja az előrejelzések előállításához. A ReFT keretrendszer egyaránt figyelembe veszi a maszkolt nyelvi modelleket és az autoregresszív nyelvi modelleket. A lineáris reprezentáció hipotézise szerint a neurális hálózatokban a fogalmak a reprezentációk lineáris altereiben vannak kódolva. A legújabb modellek ezt az állítást igaznak találták a természetes nyelven, valamint más bemeneti eloszlásokon tanított neurális hálózati modellekben.

Továbbá az értelmezhetőségi vizsgálatokban az alkalmi absztrakciós keretrendszer interchange beavatkozásokat használ a neurális hálózati összetevők szerepének véletlenszerű megállapítására bizonyos viselkedések megvalósítása során. Az interchange intervenció mögött meghúzódó logika az, hogy ha egy reprezentációt úgy rögzítünk, mint egy kontrafaktuális bemenet esetén, és ez a beavatkozás következetesen befolyásolja a modell kimenetét, úgy, ahogyan a ReFT keretrendszer állításai az előállításért felelős komponensről. hogy reprezentáció, akkor a komponens oksági szerepet játszik a viselkedésben. Bár létezik néhány módszer, az elosztott csereintervenció az ideális megközelítés annak tesztelésére, hogy egy fogalom egy reprezentáció lineáris alterében van-e kódolva, amint azt a lineáris reprezentáció hipotézise állítja. Ezenkívül a DAS módszert korábban használták az entitásattribútumok, a hangulat, a nyelvi jellemzők és a matematikai érvelés lineáris reprezentációjának megtalálására a nyelvi modellekben. Számos kísérlet azonban azt mutatta, hogy a DAS módszer rendkívül kifejező, és képes kauzális hatásos altereket találni még akkor is, ha a transzformátornyelvi modellt véletlenszerűen inicializálták, és ezért még nem tanul meg semmilyen feladat-specifikus reprezentációt, ami azt eredményezi, hogy megvitatják, hogy a DAS elég hatékony és felelős-e az értelmezhetőségi feladatokhoz.

A DAS által kínált kifejezőképesség azt sugallja, hogy a megközelítés ideális eszköz lehet a nyelvi modell viselkedésének szabályozására, a kontrollálható generálás és a felelős szerkesztés terén végzett munkája mellett. Ezért a nyelvi modellek lefelé irányuló feladatokhoz való adaptálásához a ReFT keretrendszer az elosztott interchange beavatkozási műveletet használja egy új paraméter-hatékony módszer létrehozásához. Továbbá a ReFT módszer beavatkozások halmaza, és a keretrendszer azt kényszeríti ki, hogy bármely két, ugyanazon a rétegen működő beavatkozásnál a beavatkozási pozíciók diszjunktnak kell lenniük úgy, hogy az összes beavatkozási funkció paraméterei függetlenek maradjanak. Ennek eredményeként a ReFT egy általános keretrendszer, amely magában foglalja a rejtett reprezentációk beavatkozásait a modell előrehaladása során.

ReFT: Kísérletek és eredmények

A meglévő PEFT-keretrendszerekhez viszonyított teljesítményének értékelése érdekében a ReFT-keretrendszer kísérleteket végez négy különböző természetes nyelvi feldolgozási benchmarkon, és több mint 20 adatkészletet fed le, azzal az elsődleges céllal, hogy gazdag képet nyújtson a LoReFT-keretrendszer teljesítményéről különböző forgatókönyvekben. Továbbá, amikor a LoReFT keretrendszert a valós életben implementálják, a fejlesztőknek el kell dönteniük, hogy hány beavatkozást tanuljanak meg, valamint a bemeneti pozíciókat és rétegeket, amelyekre mindegyiket alkalmazni kell. A feladat elvégzéséhez a ReFT keretrendszer négy hiperparamétert hangol.

- A beavatkozáshoz szükséges előtag pozíciók száma.

- A beavatkozáshoz szükséges utótag pozíciók száma.

- Milyen rétegek halmazába kell beavatkozni.

- Meg kell-e kötni a beavatkozási paramétereket ugyanabban a rétegben különböző pozíciókban.

Ezzel a ReFT keretrendszer leegyszerűsíti a hiperparaméteres keresési teret, és csak egy fix további következtetési költséget biztosít, amely nem skálázódik a prompt hosszával.

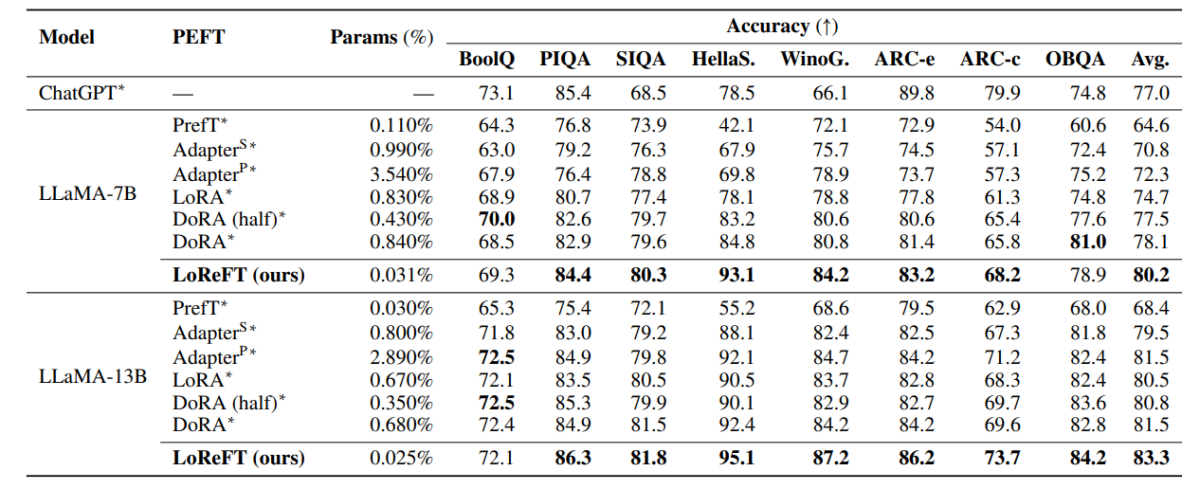

A fenti táblázat összehasonlítja a LLaMA-7B és LLaMA-13B keretrendszerek pontosságát a meglévő PEFT-modellekkel a 8 józan ész adatkészletében. Amint megfigyelhető, a LoReFT-modell tisztességes különbséggel felülmúlja a meglévő PEFT-megközelítéseket, annak ellenére, hogy sokkal kevesebb paraméterrel rendelkezik, és három futtatás átlagos teljesítményét a LoReFT-modell külön paraméter-magokkal jellemezte. A param(%) kiszámítása úgy történik, hogy a betanítható paraméterek számát elosztjuk a nagy alapmodell összes paraméterének számával.

A fenti táblázat összefoglalja az LLaMA-7B és LLaMA-13B keretrendszerek pontossági összehasonlítását a meglévő PEFT-modellekkel 4 különböző aritmetikai érvelési adatkészletben, a keretrendszer három, különböző véletlenszerű magokkal végzett futtatás átlagos teljesítményéről számol be. Amint megfigyelhető, annak ellenére, hogy sokkal kevesebb paraméterrel (%) rendelkezik, a LoReFT keretrendszer jelentős mértékben felülmúlja a meglévő PEFT keretrendszereket.

A fenti táblázat összefoglalja a RoBERTa-base és a RoBERTa-large keretrendszerek pontossági összehasonlítását a meglévő PEFT-modellekkel a GLUE benchmarkon keresztül, a keretrendszer öt futtatás átlagos teljesítményéről számol be különböző véletlenszerű magokkal. Amint megfigyelhető, annak ellenére, hogy sokkal kevesebb paraméterrel (%) rendelkezik, a LoReFT keretrendszer jelentős mértékben felülmúlja a meglévő PEFT keretrendszereket.

Záró gondolatok

Ebben a cikkben a LoReFT-ről beszéltünk, amely a meglévő PEFT-keretrendszerek hatékony alternatívája, amely négy különböző tartomány benchmarkjain keresztül erős teljesítményt ér el, miközben akár 50-szer a korábbi korszerű PEFT-modellek hatékonyságát kínálja. Az előre betanított nagy modelleket gyakran finomhangolják új tartományokhoz vagy feladatokhoz, és a finomhangolási folyamat során egyetlen alapmodell sokféle feladathoz igazítható, még akkor is, ha csak kis mennyiségű tartományon belüli adat áll rendelkezésre. a modellhez. A teljes modell finomhangolása azonban erőforrás-igényes és költséges, különösen a lényegesen nagyobb számú és paraméterű nyelvi modelleknél. A paraméter-hatékony finomhangolási vagy PeFT módszerek azt javasolják, hogy a teljes modell finomhangolásával járó magas költségeket a rendelkezésre álló összsúlyok csak kis részének frissítésével kezeljék, ez a folyamat segít csökkenteni az edzési időt és a memóriahasználatot. Nevezetesen, a LoReFT új, csúcstechnológiás teljesítményt hoz létre a józan ész érvelése, az utasítások követése és a természetes nyelv megértése terén a legerősebb PEFT-ekkel szemben.