Intelligence Artificielle

YOLOv7 : l'algorithme de détection d'objets le plus avancé ?

Le 6 juillet 2022 sera marqué comme un jalon dans l’histoire de l’IA car c’est ce jour-là que YOLOv7 est sorti. Depuis son lancement, le YOLOv7 est le sujet le plus brûlant dans la communauté des développeurs Computer Vision, et pour les bonnes raisons. YOLOv7 est déjà considéré comme une étape importante dans l'industrie de la détection d'objets.

Peu de temps après la L'article YOLOv7 a été publié, il s'est avéré être le modèle de détection d'objections en temps réel le plus rapide et le plus précis. Mais comment YOLOv7 surpasse-t-il ses prédécesseurs ? Qu'est-ce qui rend YOLOv7 si efficace dans l'exécution de tâches de vision par ordinateur ?

Dans cet article, nous allons essayer d'analyser le modèle YOLOv7 et essayer de trouver la réponse à la raison pour laquelle YOLOv7 devient maintenant la norme de l'industrie ? Mais avant de pouvoir répondre à cela, nous devrons jeter un coup d'œil à la brève histoire de la détection d'objets.

Qu'est-ce que la détection d'objets ?

La détection d'objets est une branche de la vision par ordinateur qui identifie et localise des objets dans une image ou un fichier vidéo. La détection d'objets est la pierre angulaire de nombreuses applications, notamment les voitures autonomes, la surveillance surveillée et même la robotique.

Un modèle de détection d'objet peut être classé en deux catégories différentes, détecteurs monocoup, et détecteurs multi-coups.

Détection d'objets en temps réel

Pour vraiment comprendre le fonctionnement de YOLOv7, il est essentiel pour nous de comprendre l'objectif principal de YOLOv7, "Détection d'objets en temps réel ». La détection d'objets en temps réel est un élément clé de la vision par ordinateur moderne. Les modèles de détection d'objets en temps réel tentent d'identifier et de localiser des objets d'intérêt en temps réel. Les modèles de détection d'objets en temps réel ont rendu très efficace pour les développeurs le suivi d'objets d'intérêt dans une image en mouvement comme une vidéo ou une entrée de surveillance en direct.

Les modèles de détection d'objets en temps réel ont essentiellement une longueur d'avance sur les modèles de détection d'images conventionnels. Alors que le premier est utilisé pour suivre les objets dans les fichiers vidéo, le second localise et identifie les objets dans un cadre fixe comme une image.

En conséquence, les modèles de détection d'objets en temps réel sont vraiment efficaces pour l'analyse vidéo, les véhicules autonomes, le comptage d'objets, le suivi multi-objets, et bien plus encore.

Qu'est-ce que YOLO ?

YOLO ou "Vous ne regardez qu'une seule fois» est une famille de modèles de détection d'objets en temps réel. Le concept YOLO a été introduit pour la première fois en 2016 par Joseph Redmon, et il a fait parler de lui presque instantanément car il était beaucoup plus rapide et beaucoup plus précis que les algorithmes de détection d'objets existants. Il ne fallut pas longtemps avant que l'algorithme YOLO ne devienne une norme dans l'industrie de la vision par ordinateur.

Le concept fondamental proposé par l'algorithme YOLO est d'utiliser un réseau de neurones de bout en bout utilisant des boîtes englobantes et des probabilités de classe pour faire des prédictions en temps réel. YOLO était différent du modèle de détection d'objets précédent en ce sens qu'il proposait une approche différente pour effectuer la détection d'objets en réaffectant les classificateurs.

Le changement d'approche a fonctionné car YOLO est rapidement devenu la norme de l'industrie, car l'écart de performances entre lui-même et d'autres algorithmes de détection d'objets en temps réel était important. Mais quelle était la raison pour laquelle YOLO était si efficace ?

Par rapport à YOLO, les algorithmes de détection d'objets utilisaient à l'époque des réseaux de proposition de région pour détecter d'éventuelles régions d'intérêt. Le processus de reconnaissance a ensuite été effectué sur chaque région séparément. En conséquence, ces modèles effectuaient souvent plusieurs itérations sur la même image, d'où un manque de précision et un temps d'exécution plus élevé. D'autre part, l'algorithme YOLO utilise une seule couche entièrement connectée pour effectuer la prédiction en une seule fois.

Comment fonctionne YOLO ?

Trois étapes expliquent le fonctionnement d'un algorithme YOLO.

Recadrage de la détection d'objets en tant que problème de régression unique

Le L'algorithme YOLO tente de recadrer la détection d'objets comme un problème de régression unique, y compris les pixels de l'image, aux probabilités de classe et aux coordonnées de la boîte englobante. Par conséquent, l'algorithme doit regarder l'image une seule fois pour prédire et localiser les objets cibles dans les images.

Raisons l'image à l'échelle mondiale

De plus, lorsque l'algorithme YOLO fait des prédictions, il raisonne globalement l'image. C'est différent des techniques basées sur les propositions de région et de glissement car l'algorithme YOLO voit l'image complète pendant la formation et les tests sur l'ensemble de données, et est capable d'encoder des informations contextuelles sur les classes et leur apparence.

Avant YOLO, Fast R-CNN était l'un des algorithmes de détection d'objets les plus populaires qui ne pouvaient pas voir le contexte plus large de l'image car il confondait les correctifs d'arrière-plan d'une image avec un objet. Comparé à l'algorithme Fast R-CNN, YOLO est 50% plus précis lorsqu'il s'agit d'erreurs d'arrière-plan.

Généralise la représentation des objets

Enfin, l'algorithme YOLO vise également à généraliser les représentations d'objets dans une image. En conséquence, lorsqu'un algorithme YOLO a été exécuté sur un ensemble de données avec des images naturelles et testé pour les résultats, YOLO a surpassé les modèles R-CNN existants par une large marge. C'est parce que YOLO est hautement généralisable, les chances qu'il tombe en panne lorsqu'il est implémenté sur des entrées inattendues ou de nouveaux domaines étaient minces.

YOLOv7 : Quoi de neuf ?

Maintenant que nous avons une compréhension de base de ce que sont les modèles de détection d'objets en temps réel et de l'algorithme YOLO, il est temps de discuter de l'algorithme YOLOv7.

Optimiser le processus de formation

L'algorithme YOLOv7 essaie non seulement d'optimiser l'architecture du modèle, mais il vise également à optimiser le processus de formation. Il vise à utiliser des modules et des méthodes d'optimisation pour améliorer la précision de la détection d'objets, en renforçant le coût de la formation, tout en maintenant le coût des interférences. Ces modules d'optimisation peuvent être appelés sac de cadeaux entraînable.

Affectation d'étiquettes guidée par pas grossier à fin

L'algorithme YOLOv7 prévoit d'utiliser une nouvelle attribution d'étiquettes guidées grossière à fine au lieu de la méthode conventionnelle Attribution dynamique d'étiquettes. Il en est ainsi parce qu'avec l'attribution dynamique d'étiquettes, la formation d'un modèle avec plusieurs couches de sortie pose certains problèmes, le plus courant étant de savoir comment attribuer des cibles dynamiques pour différentes branches et leurs sorties.

Re-paramétrage du modèle

La reparamétrisation du modèle est un concept important dans la détection d'objets, et son utilisation est généralement suivie avec quelques problèmes lors de la formation. L'algorithme YOLOv7 prévoit d'utiliser le concept de chemin de propagation du gradient pour analyser les politiques de reparamétrisation du modèle applicable aux différentes couches du réseau.

Extension et mise à l'échelle composée

L'algorithme YOLOv7 introduit également le méthodes de mise à l'échelle étendue et composée pour utiliser et utiliser efficacement les paramètres et les calculs pour la détection d'objets en temps réel.

YOLOv7 : travaux connexes

Détection d'objets en temps réel

YOLO est actuellement la norme de l'industrie, et la plupart des détecteurs d'objets en temps réel déploient des algorithmes YOLO et FCOS (Fully Convolutional One-Stage Object-Detection). Un détecteur d'objets en temps réel de pointe a généralement les caractéristiques suivantes

- Architecture réseau plus solide et plus rapide.

- Une méthode efficace d'intégration de fonctionnalités.

- Une méthode précise de détection d'objets.

- Une fonction de perte robuste.

- Une méthode efficace d'attribution d'étiquettes.

- Une méthode d'entraînement efficace.

L'algorithme YOLOv7 n'utilise pas de méthodes d'apprentissage et de distillation auto-supervisées qui nécessitent souvent de grandes quantités de données. À l'inverse, l'algorithme YOLOv7 utilise une méthode de sac de cadeaux entraînable.

Re-paramétrage du modèle

Les techniques de reparamétrisation des modèles sont considérées comme une technique d'ensemble qui fusionne plusieurs modules de calcul dans une étape d'interférence. La technique peut être divisée en deux catégories, ensemble au niveau du modèle, et ensemble au niveau du module.

Maintenant, pour obtenir le modèle d'interférence final, la technique de reparamétrisation au niveau du modèle utilise deux pratiques. La première pratique utilise différentes données de formation pour former de nombreux modèles identiques, puis fait la moyenne des poids des modèles formés. Alternativement, l'autre pratique fait la moyenne des poids des modèles au cours de différentes itérations.

La re-paramétrisation au niveau du module gagne récemment en popularité car elle divise un module en différentes branches de module, ou différentes branches identiques pendant la phase de formation, puis procède à l'intégration de ces différentes branches dans un module équivalent tout en interférence.

Cependant, les techniques de re-paramétrage ne peuvent pas être appliquées à tous les types d'architecture. C'est la raison pour laquelle le L'algorithme YOLOv7 utilise de nouvelles techniques de reparamétrisation du modèle pour concevoir des stratégies connexes adapté aux différentes architectures.

Mise à l'échelle du modèle

La mise à l'échelle du modèle est le processus de mise à l'échelle vers le haut ou vers le bas d'un modèle existant afin qu'il s'adapte à différents appareils informatiques. La mise à l'échelle du modèle utilise généralement une variété de facteurs tels que le nombre de couches (profondeur), taille des images d'entrée(RAPIDE), nombre de pyramides d'entités(étape) et le nombre de canaux(largeur). Ces facteurs jouent un rôle crucial pour assurer un compromis équilibré entre les paramètres du réseau, la vitesse d'interférence, le calcul et la précision du modèle.

L'une des méthodes de mise à l'échelle les plus couramment utilisées est NAS ou recherche d'architecture réseau qui recherche automatiquement les facteurs d'échelle appropriés à partir des moteurs de recherche sans règles compliquées. Le principal inconvénient de l'utilisation du NAS est qu'il s'agit d'une approche coûteuse pour rechercher des facteurs de mise à l'échelle appropriés.

Presque tous les modèles de reparamétrisation de modèle analysent indépendamment les facteurs de mise à l'échelle individuels et uniques, et en outre, optimisent même ces facteurs indépendamment. C'est parce que l'architecture NAS fonctionne avec des facteurs de mise à l'échelle non corrélés.

Il convient de noter que les modèles basés sur la concaténation tels que VoVNet or DenseNet modifier la largeur d'entrée de quelques calques lorsque la profondeur des modèles est mise à l'échelle. YOLOv7 fonctionne sur une architecture proposée basée sur la concaténation et utilise donc une méthode de mise à l'échelle composée.

Le chiffre mentionné ci-dessus compare réseaux étendus d'agrégation de couches efficaces (E-ELAN) de différents modèles. La méthode E-ELAN proposée maintient le chemin de transmission de gradient de l'architecture d'origine, mais vise à augmenter la cardinalité des fonctionnalités ajoutées en utilisant la convolution de groupe. Le processus peut améliorer les caractéristiques apprises par différentes cartes et peut en outre rendre l'utilisation des calculs et des paramètres plus efficace.

Architecture YOLOv7

Le modèle YOLOv7 utilise les modèles YOLOv4, YOLO-R et Scaled YOLOv4 comme base. Le YOLOv7 est le résultat des expérimentations menées sur ces modèles pour améliorer les résultats, et rendre le modèle plus précis.

Réseau étendu d'agrégation de couches efficaces ou E-ELAN

E-ELAN est le bloc de construction fondamental du modèle YOLOv7, et il est dérivé de modèles déjà existants sur l'efficacité du réseau, principalement le ÉLAN.

Les principales considérations lors de la conception d'une architecture efficace sont le nombre de paramètres, la densité de calcul et la quantité de calcul. D'autres modèles prennent également en compte des facteurs tels que l'influence du rapport des canaux d'entrée/sortie, les branches du réseau d'architecture, la vitesse d'interférence du réseau, le nombre d'éléments dans les tenseurs du réseau convolutif, etc.

Le CSPVoNet Le modèle considère non seulement les paramètres mentionnés ci-dessus, mais il analyse également le chemin du gradient pour apprendre des fonctionnalités plus diverses en activant les poids des différentes couches. L'approche permet aux interférences d'être beaucoup plus rapides et précises. Le ELAN L'architecture vise à concevoir un réseau efficace pour contrôler le chemin de gradient le plus court et le plus long afin que le réseau puisse être plus efficace dans l'apprentissage et la convergence.

ELAN a déjà atteint un stade stable quel que soit le nombre d'empilements de blocs de calcul et la longueur du chemin de gradient. L'état stable peut être détruit si les blocs de calcul sont empilés de manière illimitée, et le taux d'utilisation des paramètres diminuera. Le l'architecture E-ELAN proposée peut résoudre le problème car elle utilise l'expansion, le brassage et la cardinalité de fusion pour améliorer en permanence la capacité d'apprentissage du réseau tout en conservant le chemin de gradient d'origine.

De plus, en comparant l'architecture d'E-ELAN avec ELAN, la seule différence réside dans le bloc de calcul, tandis que l'architecture de la couche de transition est inchangée.

E-ELAN propose d'étendre la cardinalité des blocs de calcul et d'étendre le canal en utilisant circonvolution de groupe. La carte d'entités sera ensuite calculée et mélangée en groupes selon le paramètre de groupe, puis sera concaténée. Le nombre de canaux dans chaque groupe restera le même que dans l'architecture d'origine. Enfin, les groupes de cartes d'entités seront ajoutés pour effectuer la cardinalité.

Mise à l'échelle du modèle pour les modèles basés sur la concaténation

La mise à l'échelle du modèle aide à ajuster les attributs des modèles qui aide à générer des modèles selon les exigences et à différentes échelles pour répondre aux différentes vitesses d'interférence.

La figure parle de la mise à l'échelle du modèle pour différents modèles basés sur la concaténation. Comme vous pouvez le faire sur les figures (a) et (b), la largeur de sortie du bloc de calcul augmente avec une augmentation de la mise à l'échelle de la profondeur des modèles. Par conséquent, la largeur d'entrée des couches de transmission est augmentée. Si ces méthodes sont implémentées sur une architecture basée sur la concaténation, le processus de mise à l'échelle est effectué en profondeur et est illustré à la figure (c).

On peut donc conclure qu'il n'est pas possible d'analyser les facteurs d'échelle indépendamment pour les modèles basés sur la concaténation, et qu'ils doivent plutôt être considérés ou analysés ensemble. Par conséquent, pour un modèle basé sur la concaténation, il convient d'utiliser la méthode de mise à l'échelle du modèle composé correspondant. De plus, lorsque le facteur de profondeur est mis à l'échelle, le canal de sortie du bloc doit également être mis à l'échelle.

Sac de cadeaux entraînable

Un sac de cadeaux est un terme que les développeurs utilisent pour décrire un ensemble de méthodes ou de techniques qui peuvent modifier la stratégie ou le coût de la formation dans le but d'améliorer la précision du modèle. Alors, quels sont ces sacs de cadeaux pouvant être entraînés dans YOLOv7 ? Regardons.

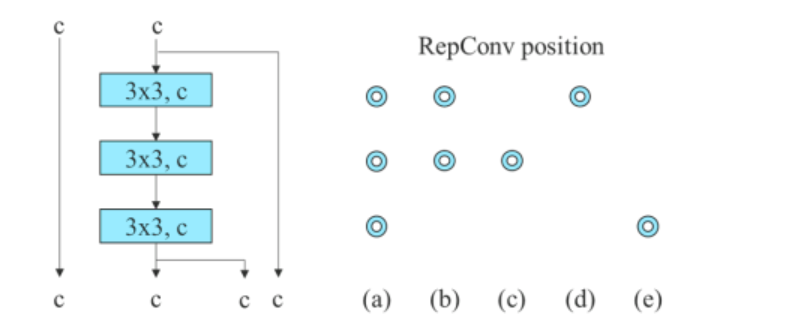

Convolution reparamétrée planifiée

L'algorithme YOLOv7 utilise des chemins de propagation de flux de gradient pour déterminer comment combiner idéalement un réseau avec la convolution reparamétrée. Cette approche de YOLov7 est une tentative de contrer Algorithme RepConv qui, bien qu'il ait fonctionné sereinement sur le modèle VGG, fonctionne mal lorsqu'il est appliqué directement aux modèles DenseNet et ResNet.

Pour identifier les connexions dans une couche convolutive, le L'algorithme RepConv combine la convolution 3 × 3 et la convolution 1 × 1. Si nous analysons l'algorithme, ses performances et l'architecture, nous observerons que RepConv détruit le concaténation dans DenseNet et le résidu dans ResNet.

L'image ci-dessus illustre un modèle reparamétré planifié. On constate que l'algorithme YOLov7 a déterminé qu'une couche du réseau avec des connexions de concaténation ou résiduelles ne devrait pas avoir de connexion d'identité dans l'algorithme RepConv. Par conséquent, il est acceptable de passer à RepConvN sans connexion d'identité.

Grossier pour Auxiliaire et Fin pour Perte de Plomb

Surveillance approfondie est une branche de l'informatique qui trouve souvent son utilité dans le processus de formation des réseaux profonds. Le principe fondamental de la supervision approfondie est qu'elle ajoute une tête auxiliaire supplémentaire dans les couches intermédiaires du réseau ainsi que les poids du réseau peu profond avec la perte d'assistant comme guide. L'algorithme YOLOv7 fait référence à la tête responsable de la sortie finale en tant que tête principale, et la tête auxiliaire est la tête qui aide à l'entraînement.

En continuant, YOLOv7 utilise une méthode différente pour l'attribution d'étiquettes. Classiquement, l'attribution d'étiquettes a été utilisée pour générer des étiquettes en se référant directement à la vérité terrain et sur la base d'un ensemble de règles donné. Cependant, ces dernières années, la distribution et la qualité de l'entrée de prédiction jouent un rôle important pour générer une étiquette fiable. YOLOv7 génère une étiquette logicielle de l'objet en utilisant les prédictions de la boîte englobante et de la vérité terrain.

De plus, la nouvelle méthode d'attribution d'étiquettes de l'algorithme YOLOv7 utilise les prédictions de la tête principale pour guider à la fois la tête principale et la tête auxiliaire. La méthode d'attribution d'étiquettes propose deux stratégies.

Attribueur d'étiquettes guidé par la tête principale

La stratégie effectue des calculs sur la base des résultats de prédiction de la tête principale et de la vérité terrain, puis utilise l'optimisation pour générer des étiquettes souples. Ces étiquettes souples sont ensuite utilisées comme modèle de formation pour la tête principale et la tête auxiliaire.

La stratégie repose sur l'hypothèse que, parce que le responsable principal a une plus grande capacité d'apprentissage, les étiquettes qu'il génère doivent être plus représentatives et corrélées entre la source et la cible.

Assignateur d'étiquettes guidé par tête de plomb grossière à fine

Cette stratégie effectue également des calculs sur la base des résultats de prédiction de la tête principale et de la vérité terrain, puis utilise l'optimisation pour générer des étiquettes souples. Cependant, il y a une différence essentielle. Dans cette stratégie, il existe deux ensembles d'étiquettes souples, niveau grossier, et belle étiquette.

L'étiquette grossière est générée en relâchant les contraintes de l'échantillon positif

processus d'attribution qui traite plus de grilles comme des cibles positives. C'est fait pour éviter le risque de perdre des informations en raison de la force d'apprentissage plus faible de la tête auxiliaire.

La figure ci-dessus explique l'utilisation d'un sac de cadeaux pouvant être entraîné dans l'algorithme YOLOv7. Il représente grossier pour la tête auxiliaire et fin pour la tête principale. Lorsque nous comparons un modèle avec tête auxiliaire (b) avec le modèle normal (a), nous observons que le schéma en (b) a une tête auxiliaire, alors qu'il n'en est pas en (a).

La figure (c) représente l'assignateur d'étiquette indépendant commun tandis que la figure (d) et la figure (e) représentent respectivement l'assignateur guidé principal et l'assignateur guidé principal grossier à fin utilisé par YOLOv7.

Autre sac de cadeaux entraînable

En plus de ceux mentionnés ci-dessus, l'algorithme YOLOv7 utilise des sacs supplémentaires de cadeaux, bien qu'ils n'aient pas été proposés par eux à l'origine. Ils sont

- Normalisation par lots dans la technologie Conv-Bn-Activation : Cette stratégie est utilisée pour connecter une couche convolutive directement à la couche de normalisation par lots.

- Connaissances implicites dans YOLOR : Le YOLOv7 combine la stratégie avec la carte de fonctionnalités convolutive.

- Modèle EMA : Le modèle EMA est utilisé comme modèle de référence final dans YOLOv7, bien que son utilisation principale doive être utilisée dans la méthode de l'enseignant moyen.

YOLOv7 : Expérimentations

Installation expérimentale

L'algorithme YOLOv7 utilise le Ensemble de données Microsoft COCO pour la formation et la validation leur modèle de détection d'objet, et toutes ces expériences n'utilisent pas un modèle pré-entraîné. Les développeurs ont utilisé l'ensemble de données de train 2017 pour la formation et l'ensemble de données de validation 2017 pour sélectionner les hyperparamètres. Enfin, les performances des résultats de détection d'objets YOLOv7 sont comparées aux algorithmes de pointe pour la détection d'objets.

Les développeurs ont conçu un modèle de base pour GPU Edge (YOLOv7-tiny), GPU normal (YOLOv7) et GPU cloud (YOLOv7-W6). De plus, l'algorithme YOLOv7 utilise également un modèle de base pour la mise à l'échelle du modèle en fonction des différentes exigences de service et obtient différents modèles. Pour l'algorithme YOLOv7, la mise à l'échelle de la pile est effectuée sur le cou et les composés proposés sont utilisés pour augmenter la profondeur et la largeur du modèle.

Lignes de base

L'algorithme YOLOv7 utilise les modèles YOLO précédents et l'algorithme de détection d'objets YOLOR comme ligne de base.

La figure ci-dessus compare la ligne de base du modèle YOLOv7 avec d'autres modèles de détection d'objets, et les résultats sont assez évidents. Lorsqu'on le compare avec le Algorithme YOLOv4, YOLOv7 utilise non seulement 75 % de paramètres en moins, mais il utilise également 15 % de calcul en moins et a une précision de 0.4 % supérieure.

Comparaison avec les modèles de détecteurs d'objets de pointe

La figure ci-dessus montre les résultats lorsque YOLOv7 est comparé à des modèles de détection d'objets de pointe pour les GPU mobiles et généraux. On peut observer que la méthode proposée par l'algorithme YOLOv7 a le meilleur score de compromis vitesse-précision.

Étude d'ablation : méthode de mise à l'échelle composée proposée

La figure ci-dessus compare les résultats de l'utilisation de différentes stratégies de mise à l'échelle du modèle. La stratégie de mise à l'échelle du modèle YOLOv7 augmente la profondeur du bloc de calcul de 1.5 fois et la largeur de 1.25 fois.

Comparé à un modèle qui ne fait qu'augmenter la profondeur, le modèle YOLOv7 fonctionne mieux de 0.5 % tout en utilisant moins de paramètres et de puissance de calcul. D'autre part, par rapport aux modèles qui ne font qu'augmenter la profondeur, la précision de YOLOv7 est améliorée de 0.2 %, mais le nombre de paramètres doit être mis à l'échelle de 2.9 % et le calcul de 1.2 %.

Modèle reparamétré planifié proposé

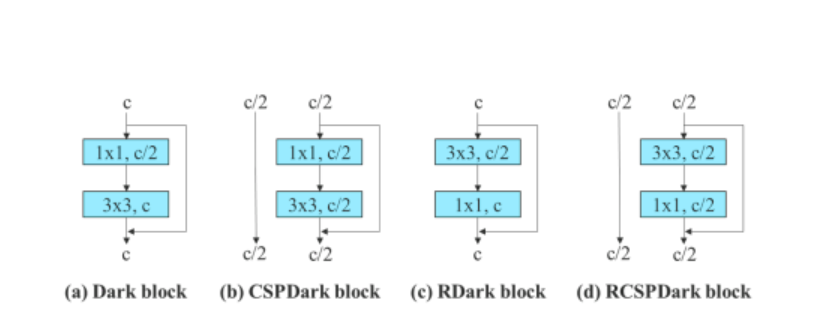

Pour vérifier la généralité de son modèle reparamétré proposé, le L'algorithme YOLOv7 l'utilise sur des modèles basés sur les résidus et sur la concaténation pour la vérification. Pour le processus de vérification, l'algorithme YOLOv7 utilise ELAN à 3 couches pour le modèle basé sur la concaténation et CSPDarknet pour le modèle basé sur les résidus.

Pour le modèle basé sur la concaténation, l'algorithme remplace les couches convolutives 3 × 3 dans l'ELAN à 3 empilements par RepConv. La figure ci-dessous montre la configuration détaillée de RepConv planifiée et ELAN à 3 couches.

De plus, lorsqu'il s'agit du modèle basé sur les résidus, l'algorithme YOLOv7 utilise un bloc sombre inversé car le bloc sombre d'origine n'a pas de bloc de convolution 3 × 3. La figure ci-dessous montre l'architecture du CSPDarknet inversé qui inverse les positions des couches convolutives 3 × 3 et 1 × 1.

Perte d'assistant proposée pour le chef auxiliaire

Pour la perte d'assistant pour la tête auxiliaire, le modèle YOLOv7 compare l'attribution d'étiquettes indépendantes pour les méthodes de tête auxiliaire et de tête principale.

La figure ci-dessus contient les résultats de l'étude sur la tête auxiliaire proposée. On peut voir que la performance globale du modèle augmente avec une augmentation de la perte de l'assistant. De plus, l'attribution d'étiquettes guidée par le plomb proposée par le modèle YOLOv7 est plus performante que les stratégies d'attribution de plomb indépendantes.

Résultats YOLOv7

Sur la base des expériences ci-dessus, voici le résultat des performances de YOLov7 par rapport à d'autres algorithmes de détection d'objets.

La figure ci-dessus compare le modèle YOLOv7 avec d'autres algorithmes de détection d'objets, et on peut clairement observer que le YOLOv7 surpasse les autres modèles de détection d'objection en termes de Précision moyenne (AP) v/s interférence de lot.

De plus, la figure ci-dessous compare les performances de YOLOv7 à d'autres algorithmes de détection d'objection en temps réel. Une fois de plus, YOLOv7 succède à d'autres modèles en termes de performances globales, de précision et d'efficacité.

Voici quelques observations supplémentaires à partir des résultats et des performances de YOLOv7.

- Le YOLOv7-Tiny est le plus petit modèle de la famille YOLO, avec plus de 6 millions de paramètres. Le YOLOv7-Tiny a une précision moyenne de 35.2 % et il surpasse les modèles YOLOv4-Tiny avec des paramètres comparables.

- Le modèle YOLOv7 compte plus de 37 millions de paramètres et surpasse les modèles avec des paramètres plus élevés comme YOLov4.

- Le modèle YOLOv7 a le taux mAP et FPS le plus élevé dans la plage de 5 à 160 FPS.

Conclusion

YOLO ou You Only Look Once est le modèle de détection d'objets de pointe dans la vision par ordinateur moderne. L'algorithme YOLO est connu pour sa grande précision et son efficacité, et par conséquent, il trouve une application étendue dans l'industrie de la détection d'objets en temps réel. Depuis l'introduction du premier algorithme YOLO en 2016, les expériences ont permis aux développeurs d'améliorer continuellement le modèle.

Le modèle YOLOv7 est le dernier né de la famille YOLO, et c'est l'algorithme YOLO le plus puissant à ce jour. Dans cet article, nous avons parlé des principes fondamentaux de YOLOv7 et essayé d'expliquer ce qui rend YOLOv7 si efficace.