Intelligence Artificielle

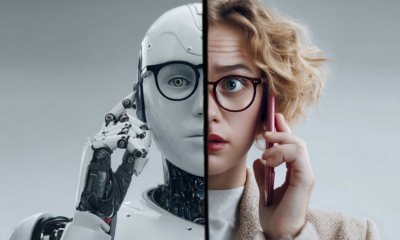

Pourquoi Deepfakes ne peut pas actuellement transmettre la subtilité de l'émotion

Début hier de l'épisode 6 de la Star Wars spin-off Le livre de Boba Fett semble avoir divisé l'opinion des fans. Reçue avec l'approbation générale, il existe une hypothèse répandue sur les réseaux sociaux selon laquelle la recréation bien améliorée d'un Mark Hamill rajeuni (comparé à celle du personnage) comparution antérieure dans la finale de la saison 2 de Le mandalorien en 2020) est le résultat direct de l’embauche par Industrial Light and Magic du praticien amateur des deepfakes Shamook (qui avaient radicalement amélioré leur travail avec un logiciel open source); et que les rendus du personnage doivent être une combinaison de technologie deepfake, peut-être rangée avec CGI.

Les confirmations sont actuellement limitées, bien que Shamook n'ait pas fait grand-chose depuis l'expiration de l'accord de confidentialité contractuel d'ILM. Néanmoins, l'œuvre constitue une amélioration considérable par rapport aux images de synthèse de 2020 ; elle présente une certaine brillance associée aux modèles deepfakes dérivés d'archives ; et, de manière générale, elle est conforme aux meilleures normes visuelles actuelles en matière de deepfakes.

L'autre courant d'opinion des fans est que la nouvelle tentative de « Young Luke » a un ensemble différent de défauts que le précédent. Peut-être le plus révélateur, le manque d'expressivité et les émotions subtiles et pertinentes dans les très longues séquences mettant en vedette la nouvelle récréation de Skywalker sont plus typiques des deepfakes que de CGI; La Verge a décrit le Boba Fett simulation en termes de « visage étrange et vide du visage figé de Mark Hamill en 1983 ».

Quelles que soient les technologies derrière la nouvelle récréation ILM, les transformations deepfake ont un problème fondamental avec la subtilité de l'émotion qui est difficile à résoudre soit par des changements dans l'architecture, soit en améliorant le matériel de formation source, et qui est généralement éludé par les choix judicieux que virale les deepfakers font lors de la sélection d'une vidéo cible.

Limitations de l'alignement facial

Les deux référentiels deepfake FOSS les plus couramment utilisés sont Laboratoire DeepFace (DFL) et Échange de visage, tous deux dérivés de l'anonyme et controversé Code source 2017, avec DFL ayant un énorme avance dans l'industrie des effets visuels, malgré son instrumentalité limitée.

Chacun de ces packages est chargé, dans un premier temps, d'extraire des repères faciaux des visages qu'il a pu identifier à partir du matériel source (c'est-à-dire des trames de vidéos et/ou d'images fixes).

Le réseau d'alignement facial (FAN) en action, à partir du référentiel officiel. Source : https://github.com/1adrianb/face-alignment

DFL et FaceSwap utilisent tous deux le Réseau d'alignement facial (FAN) bibliothèque. FAN peut créer des repères 2D et 3D (voir image ci-dessus) pour les visages extraits. Les repères 3D peuvent largement prendre en compte l'orientation perçue du visage, jusqu'à des profils extrêmes et des angles relativement aigus.

Cependant, il est évident qu'il s'agit de directives très rudimentaires pour rassembler et évaluer les pixels :

Du forum FaceSwap, un indicateur approximatif des repères disponibles pour les linéaments du visage. Source : https://forum.faceswap.dev/viewtopic.php?f=25&t=27

Les traits les plus élémentaires du visage sont autorisés : les yeux peuvent s'élargir et se fermer, tout comme la mâchoire, tandis que les configurations basiques de la bouche (sourire, froncement de sourcils, etc.) peuvent être tracées et adaptées. Le visage peut pivoter dans toutes les directions, jusqu'à environ 200 degrés par rapport à la caméra.

Au-delà de cela, ce sont des clôtures assez grossières pour la manière dont les pixels se comporteront dans ces limites, et représentent les seules directives faciales vraiment mathématiques et précises dans l'ensemble du processus de deepfake. Le processus d'apprentissage lui-même compare simplement la façon dont les pixels sont disposés à l'intérieur ou à proximité de ces limites.

Formation à DeepFaceLab. Source: https://medium.com/geekculture/realistic-deepfakes-with-deepfacelab-530e90bd29f2

Comme il n'y a aucune disposition pour la topologie des sous-parties du visage (convexité et concavité des joues, détails de vieillissement, fossettes, etc.), il n'est même pas possible de tentative pour faire correspondre de telles sous-caractéristiques « subtiles » entre une source (« visage sur lequel tu veux écrire ») et une cible (« visage que vous souhaitez coller ») identité.

Se débrouiller avec des données limitées

Obtenir des données appariées entre deux identités à des fins de formation de deepfakes est pas facile. Plus l'angle que vous devez faire correspondre est inhabituel, plus vous devrez peut-être faire des compromis pour savoir si cette (rare) correspondance d'angle entre les identités A et B présente réellement la même expression.

Proche, mais pas exactement un match.

Dans l'exemple ci-dessus, les deux identités ont une disposition assez similaire, mais c'est aussi proche que cet ensemble de données peut arriver à une correspondance exacte.

Des différences évidentes subsistent : l'angle et l'objectif ne correspondent pas exactement, et l'éclairage non plus ; le sujet A n'a pas les yeux complètement fermés, contrairement au sujet B ; la qualité de l'image et la compression sont pires chez le sujet A ; et d'une certaine manière, le sujet B semble beaucoup plus petit. heureux que le sujet A.

Mais vous savez, c'est tout ce que nous avons, donc nous allons devoir nous entraîner dessus de toute façon.

Parce que ce A> sous-équipé il ou sur-ajustement le

Insuffisance : Si cette correspondance est véritablement minoritaire (c'est-à-dire que l'ensemble de données parent est assez volumineux et ne présente pas souvent les caractéristiques de ces deux photos), elle ne nécessitera pas beaucoup de temps d'apprentissage par rapport à des appariements plus « populaires » (c'est-à-dire faciles/neutres). Par conséquent, cet angle/expression ne sera pas bien représenté dans un deepfake réalisé avec le modèle entraîné.

Sur-ajustement : En désespoir de cause à cause de la rareté des correspondances de données pour un A> si rare dupliquer l'appariement plusieurs fois dans l'ensemble de données, afin qu'il ait une meilleure chance de devenir une fonctionnalité dans le modèle final. Cela conduira à un surajustement, où les vidéos deepfake réalisées avec le modèle sont susceptibles de répéter pédantement les décalages qui sont évidents entre les deux photos, comme la mesure différente dans laquelle les yeux sont fermés.

Dans l'image ci-dessous, nous voyons Vladimir Poutine en train d'être formé à DeepFaceLab pour effectuer un échange avec Kevin Spacey. Ici, la formation est relativement poussée à 160,000 XNUMX itérations.

Source : https://i.imgur.com/OdXHLhU.jpg

L'observateur occasionnel pourrait prétendre que Poutine a l'air un peu, eh bien, plus spacieux que Spacey dans ces échanges de tests. Voyons ce qu'un programme de reconnaissance des émotions en ligne fait de cette discordance d'expressions :

Selon cet oracle particulier, qui analyse une topographie faciale beaucoup plus détaillée que DFL et Faceswap, Spacey est moins en colère, dégoûté et méprisant que le deepfake de Poutine qui en résulte dans ce couple.

Les expressions inégales font partie d'un package intriqué, car les applications deepfakes populaires n'ont pas la capacité d'enregistrer ou de faire correspondre des expressions ou des émotions, sauf tacitement, en tant que mappage pixel>pixel brut.

Pour nous, les différences sont énormes. Nous apprenons à lire les expressions faciales Comme technique de survie fondamentale depuis notre plus jeune âge, nous continuons à nous appuyer sur cette compétence à l'âge adulte pour l'intégration et la progression sociales, l'accouplement et comme cadre d'évaluation continue des menaces. Étant donné notre forte sensibilité aux micro-expressions, les technologies deepfake devront à terme en tenir compte.

Contre le grain

Bien que la révolution du deepfake ait apporté la promesse d'insérer des stars de cinéma « classiques » dans les films et la télévision modernes, l'IA ne peut pas remonter le temps et filmer leurs œuvres classiques avec une définition et une qualité plus compatibles, ce qui est essentiel pour ce cas d'utilisation.

En supposant (et pour nos besoins, peu importe si c'est faux) que le Boba Fett La reconstruction de Hamill était en grande partie le travail d'un modèle deepfake formé, l'ensemble de données du modèle aurait dû exploiter des images de la période proche de la chronologie de l'émission (c'est-à-dire Hamill au début de la trentaine au moment de la production pour Retour du Jedi, 1981-83).

Le film était coup sur du papier Eastman Color Negative 250T 5293/7293, une émulsion 250ASA qui était considérée comme à grain moyen à fin à l'époque, mais qui a été surpassée en clarté, gamme de couleurs et fidélité même à la fin des années 1980. C'est un papier de son temps, et de la portée opératique de Jedi offrait peu de gros plans même à ses principaux acteurs, rendant les questions céréalières encore plus critiques, puisque les visages sources n'occupent qu'une partie du cadre.

Une gamme de scènes de Hamill dans Retour du Jedi (1983).

De plus, une grande partie des séquences chargées d'effets visuels mettant en vedette Hamill auraient été exécutées sur une imprimante optique, augmentant le grain du film. Cependant, l'accès aux archives de Lucasfilm - qui ont vraisemblablement bien pris soin des négatifs maîtres et pourraient offrir des heures de séquences brutes supplémentaires inutilisées - pourrait résoudre ce problème.

Il est parfois possible de couvrir plusieurs années de production d'un acteur afin d'accroître et de diversifier l'ensemble de données sur les deepfakes. Dans le cas de Hamill, les deepfakers sont paralysés par son changement d'apparence après un accident de voiture en 1977, et le fait qu'il a commencé presque immédiatement sa deuxième carrière en tant que doubleur acclamé après Jedi, ce qui rend les sources relativement rares.

Gamme limitée d'émotions?

Si vous souhaitez que votre acteur truqué s'approprie le décor, vous aurez besoin d'images sources présentant une gamme inhabituellement large d'expressions faciales. Il se peut que les seules images disponibles adaptées à l'âge de l'acteur ne présentent pas beaucoup de ces expressions.

Par exemple, au moment où l'arc de l'histoire de Retour du Jedi Le personnage d'Hamill avait largement maîtrisé ses émotions, un développement absolument central dans la mythologie de la franchise originale. Par conséquent, si vous créez un deepfake de Hamill à partir de Jedi données, vous allez devoir travailler avec la gamme plus limitée d'émotions et le comportement facial inhabituel que le rôle de Hamill exigeait de lui à ce moment-là, par rapport à ses entrées précédentes dans la franchise.

Même si vous considérez qu'il y a des moments dans Retour du Jedi là où le personnage de Skywalker est stressé et pourrait fournir du matériel pour une plus grande gamme d'expressions, le matériel du visage dans ces scènes est néanmoins éphémère et soumis au flou de mouvement et au montage rapide typiques des scènes d'action ; donc les données sont assez déséquilibrées.

Généralisation : la fusion des émotions

Si la Boba Fett La récréation de Skywalker est en effet un deepfake, le manque de gamme expressive qui lui a été reproché par certains ne serait pas entièrement dû à un matériel source limité. Le processus de formation encodeur-décodeur des deepfakes cherche un Généralisé modèle qui distille avec succès les caractéristiques centrales de milliers d'images, et peut au moins tentative pour simuler un angle manquant ou rare dans l'ensemble de données.

Sans cette flexibilité, une architecture deepfake consisterait simplement à copier et coller des morphes de base image par image, sans tenir compte ni de l'adaptation temporelle ni du contexte.

Cependant, le douloureux compromis pour cette polyvalence est que la fidélité d'expression est susceptible d'être une victime du processus, et toute expression qui Ces « Subtil » n'est peut-être pas le bon choix. Nous jouons tous avec nos visages comme des orchestres de cent musiciens, et nous sommes bien équipés pour le faire, alors que les logiciels de deepfake manquent sans doute au moins de la section des cordes.

Disparité d'affect dans les expressions

Les mouvements du visage et leurs effets sur nous ne sont pas un langage uniforme sur tous les visages ; le sourcil levé qui semble insouciant sur Roger Moore pourrait paraître moins sophistiqué sur Seth Rogan, tandis que l'attrait séduisant de Marilyn Monroe pourrait se traduire par une émotion plus négative si elle était truquée sur une personne dont le rôle le plus connu est « en colère » ou « mécontent » (comme le personnage d'Aubrey Plaza au cours des sept saisons de Parks and Recreation).

Par conséquent pixel>

Ce qui est sans doute nécessaire, c'est un framework deepfake qui non seulement peut reconnaître des expressions et déduire des émotions, mais a la capacité d'incarner des concepts de haut niveau tels que en colère, séduisant, ennuyé, fatigué, etc., et de catégoriser ces émotions et leurs expressions associées dans chacune des deux identités faciales, plutôt que d'examiner et de reproduire la disposition d'une bouche ou d'une paupière.

Première publication le 3 février 2022. Mise à jour à 7 h 47 EET, attribution de nom incorrecte.