Ingénierie rapide

Comprendre le réglage fin du LLM : adapter de grands modèles de langage à vos besoins uniques

À l'heure actuelle, en septembre 2023, le paysage des grands modèles linguistiques (LLM) est toujours témoin de la montée en puissance de modèles tels que Alpaca, Falcon, Llama 2, GPT-4 et bien d’autres.

Un aspect important pour exploiter le potentiel de ces LLM réside dans le processus de réglage fin, une stratégie qui permet la personnalisation de modèles pré-entraînés pour répondre à des tâches spécifiques avec précision. C’est grâce à cet ajustement précis que ces modèles peuvent véritablement s’aligner sur des exigences individualisées, offrant des solutions à la fois innovantes et adaptées à des besoins uniques.

Cependant, il est essentiel de noter que toutes les possibilités de réglage ne se valent pas. Par exemple, l’accès aux capacités de réglage fin du GPT-4 coûte cher, car il nécessite un abonnement payant relativement plus cher que les autres options disponibles sur le marché. D’un autre côté, le domaine open source regorge d’alternatives qui offrent une voie plus accessible pour exploiter la puissance des grands modèles de langage. Ces options open source démocratisent l’accès à la technologie avancée de l’IA, favorisant l’innovation et l’inclusivité dans le paysage de l’IA en évolution rapide.

Pourquoi la mise au point du LLM est-elle importante ?

Le réglage fin du LLM est plus qu'une amélioration technique ; c'est un aspect crucial du développement du modèle LLM qui permet une application plus spécifique et raffinée dans diverses tâches. Le réglage fin ajuste les modèles pré-entraînés pour mieux s'adapter à des ensembles de données spécifiques, améliorant ainsi leurs performances dans des tâches particulières et garantissant une application plus ciblée. Il met en valeur la capacité remarquable des LLM à s’adapter aux nouvelles données, démontrant une flexibilité vitale dans l’intérêt toujours croissant pour les applications d’IA.

La mise au point de grands modèles de langage ouvre de nombreuses opportunités, leur permettant d'exceller dans des tâches spécifiques allant de l'analyse des sentiments aux revues de littérature médicale. En adaptant le modèle de base à un cas d'utilisation spécifique, nous ouvrons de nouvelles possibilités, améliorant ainsi l'efficacité et la précision du modèle. De plus, cela facilite une utilisation plus économique des ressources du système, car le réglage précis nécessite moins de puissance de calcul que la formation d'un modèle à partir de zéro.

Au fur et à mesure que nous approfondirons ce guide, nous discuterons des subtilités du réglage fin du LLM, vous donnant un aperçu complet basé sur les dernières avancées et les meilleures pratiques dans le domaine.

Réglage fin basé sur les instructions

La phase de mise au point dans le IA générative Le cycle de vie, illustré dans la figure ci-dessous, est caractérisé par l'intégration des entrées et sorties d'instructions, couplée à des exemples de raisonnement étape par étape. Cette approche permet au modèle de générer des réponses non seulement pertinentes, mais également précisément alignées sur les instructions spécifiques qui y sont introduites. C'est au cours de cette phase que les modèles pré-entraînés sont adaptés pour résoudre des tâches et des cas d'utilisation distincts, en utilisant des ensembles de données personnalisés pour améliorer leurs fonctionnalités.

Réglage précis d'une seule tâche

Le réglage fin d'une tâche unique se concentre sur le perfectionnement de l'expertise du modèle dans une tâche spécifique, telle que la synthèse. Cette approche est particulièrement bénéfique pour optimiser les flux de travail impliquant des documents ou des fils de conversation importants, notamment des documents juridiques et des tickets de support client. Il est remarquable que ce réglage fin puisse permettre d’obtenir des améliorations significatives des performances avec un ensemble relativement restreint d’exemples, allant de 500 à 1000 XNUMX, ce qui contraste avec les milliards de jetons utilisés dans la phase de pré-formation.

Fondements du LLM Fine-Tuning LLM : Architecture du transformateur et au-delà

Le parcours de compréhension du réglage fin du LLM commence par une compréhension des éléments fondamentaux qui constituent les LLM. Au cœur de ces modèles se trouve le architecture du transformateur, un réseau neuronal qui exploite les mécanismes d'auto-attention pour donner la priorité au contexte des mots plutôt qu'à leur proximité dans une phrase. Cette approche innovante facilite une compréhension plus approfondie des relations distantes entre les jetons dans l'entrée.

Alors que nous naviguons dans les subtilités des transformateurs, nous rencontrons un processus en plusieurs étapes qui commence par l'encodeur. Cette phase initiale consiste à tokeniser l'entrée et à créer des vecteurs d'intégration qui représentent l'entrée et sa position dans la phrase. Les étapes suivantes impliquent une série de calculs utilisant des matrices appelées Question, Valeuret une ACTIVITES, aboutissant à un score d'auto-attention qui dicte la concentration sur différentes parties de la phrase et divers jetons.

La mise au point constitue une phase critique dans le développement des LLM, un processus qui implique de procéder à des ajustements subtils pour obtenir des résultats plus souhaitables. Cette étape, bien qu'essentielle, présente un ensemble de défis, notamment les exigences de calcul et de stockage liées à la gestion d'un grand nombre de paramètres. Le Parameter Efficient Fine-Tuning (PEFT) propose des techniques permettant de réduire le nombre de paramètres à affiner, simplifiant ainsi le processus de formation.

Pré-formation LLM : établir une base solide

Dans les premières étapes du développement du LLM, la pré-formation occupe une place centrale, en utilisant des transformateurs surparamétrés comme architecture de base. Ce processus implique la modélisation du langage naturel de diverses manières, telles que bidirectionnelles, autorégressives ou séquence à séquence sur des corpus non supervisés à grande échelle. L'objectif ici est de créer une base qui peut être affinée ultérieurement pour des tâches spécifiques en aval grâce à l'introduction d'objectifs spécifiques à chaque tâche.

Une tendance notable dans ce domaine est l’inévitable augmentation de l’échelle des LLM pré-formés, mesurée par le nombre de paramètres. Les données empiriques montrent systématiquement que des modèles plus volumineux associés à davantage de données donnent presque toujours de meilleures performances. Par exemple, le GPT-3, avec ses 175 milliards de paramètres, a établi une référence en matière de génération d'un langage naturel de haute qualité et d'exécution efficace d'un large éventail de tâches zéro-shot.

Mise au point : la voie vers l'adaptation du modèle

Suite à la pré-formation, le LLM est affiné pour s'adapter à des tâches spécifiques. Malgré les performances prometteuses démontrées par l'apprentissage en contexte dans les LLM pré-entraînés tels que GPT-3, le réglage fin reste supérieur dans des contextes spécifiques à une tâche. Cependant, l’approche répandue consistant à affiner tous les paramètres présente des défis, notamment des exigences élevées en matière de calcul et de mémoire, en particulier lorsqu’il s’agit de modèles à grande échelle.

Pour les grands modèles de langage comportant plus d’un milliard de paramètres, une gestion efficace de la RAM GPU est essentielle. Un seul paramètre de modèle avec une précision totale de 32 bits nécessite 4 octets d'espace, ce qui se traduit par une exigence de 4 Go de RAM GPU juste pour charger un modèle de 1 milliard de paramètres. Le processus de formation lui-même nécessite encore plus de mémoire pour s'adapter à divers composants, notamment les états et les gradients de l'optimiseur, ce qui peut nécessiter jusqu'à 80 Go de RAM GPU pour un modèle de cette envergure.

Pour surmonter les limites de la RAM GPU, la quantification est utilisée, une technique qui réduit la précision des paramètres du modèle, diminuant ainsi les besoins en mémoire. Par exemple, modifier la précision de 32 bits à 16 bits peut réduire de moitié la mémoire nécessaire au chargement et à l'entraînement du modèle. Plus loin dans cet article. nous découvrirons Qlora qui utilise le concept de quantification pour le réglage.

Explorer les catégories de méthodes PEFT

Dans le processus de réglage complet des grands modèles linguistiques, il est important de disposer d'une configuration informatique capable de gérer efficacement non seulement les poids de modèle importants, qui pour les modèles les plus avancés atteignent désormais des tailles de plusieurs centaines de gigaoctets, mais également de gérer une série d’autres éléments critiques. Celles-ci incluent l'allocation de mémoire pour les états d'optimisation, la gestion des gradients, les activations avant et la facilitation de la mémoire temporaire au cours des différentes étapes de la procédure de formation.

Méthode additive

Ce type de réglage peut augmenter le modèle pré-entraîné avec des paramètres ou des couches supplémentaires, en se concentrant sur l'entraînement uniquement des paramètres nouvellement ajoutés. Malgré l’augmentation du nombre de paramètres, ces méthodes améliorent le temps de formation et l’efficacité spatiale. La méthode additive est divisée en sous-catégories :

- Adaptateurs RF: Intégration de sous-couches post-transformateur de petits réseaux entièrement connectés, avec des exemples notables étant AdaMix, CouronneA, et Compacteur.

- Invites logicielles: Affiner un segment des intégrations d'entrée du modèle par descente de gradient, avec IPT, réglage du préfixe, et WARP en sont des exemples marquants.

- Autres approches additives: Incluez des techniques telles que LeTS, AttentionFusion et Ladder-Side Tuning.

Méthode sélective

Les PEFT sélectifs affinent un nombre limité de couches supérieures en fonction du type de couche et de la structure interne du modèle. Cette catégorie comprend des méthodes comme BitFit et de LN tuning, qui se concentre sur le réglage d’éléments spécifiques tels que les biais du modèle ou des lignes particulières.

Méthode basée sur la reparamétrisation

Ces méthodes utilisent des représentations de bas rang pour réduire le nombre de paramètres pouvant être entraînés, la plus connue étant l'adaptation de bas rang ou LoRA. Cette méthode exploite une simple décomposition matricielle de bas rang pour paramétrer la mise à jour du poids, démontrant ainsi un réglage fin efficace dans les sous-espaces de bas rang.

1) LoRA (adaptation de bas rang)

LoRA est apparu comme une technique PEFT révolutionnaire, présentée dans un article par Edward J. Hu et autres en 2021. Il opère dans la catégorie de reparamétrage, gelant les poids d'origine du LLM et intégrant de nouvelles matrices de bas rang entraînables dans chaque couche de l'architecture Transformer. Cette approche réduit non seulement le nombre de paramètres pouvant être entraînés, mais diminue également le temps de formation et les ressources informatiques nécessaires, présentant ainsi une alternative plus efficace au réglage fin complet.

Pour comprendre les mécanismes de LoRA, il faut revisiter l'architecture du transformateur où l'invite d'entrée subit une tokenisation et une conversion en vecteurs d'intégration. Ces vecteurs traversent les segments codeurs et/ou décodeurs du transformateur, rencontrant des réseaux d'auto-attention et de rétroaction dont les poids sont pré-entraînés.

LoRA utilise le concept de Décomposition en valeurs singulières (SVD). Essentiellement, SVD disséque une matrice en trois matrices distinctes, dont l'une est une matrice diagonale contenant des valeurs singulières. Ces valeurs singulières sont essentielles car elles évaluent l’importance des différentes dimensions dans les matrices, les valeurs plus grandes indiquant une importance plus élevée et les valeurs plus petites indiquant une importance moindre.

Cette approche permet à LoRA de conserver les caractéristiques essentielles des données tout en réduisant la dimensionnalité, optimisant ainsi le processus de réglage fin.

LoRA intervient dans ce processus, en gelant tous les paramètres du modèle d'origine et en introduisant une paire de « matrices de décomposition des rangs » aux côtés des poids d'origine. Ces matrices plus petites, notées A et B, subissent une formation par apprentissage supervisé.

L'élément central de cette stratégie est le paramètre appelé rang (« r »), qui dicte la taille des matrices de bas rang. Une sélection méticuleuse de « r » peut donner des résultats impressionnants, même avec une valeur plus petite, créant ainsi une matrice de bas rang avec moins de paramètres à entraîner. Cette stratégie a été mise en œuvre efficacement à l'aide de bibliothèques open source telles que HuggingFace Transformers, facilitant le réglage fin de LoRA pour diverses tâches avec une efficacité remarquable.

2) QLoRA : augmenter l'efficacité de LoRA

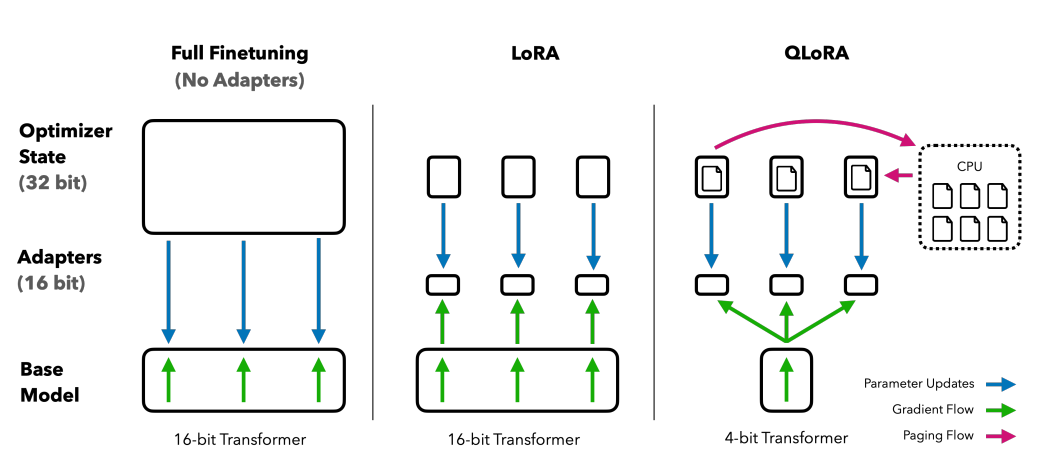

S'appuyant sur les bases posées par LoRA, QLoRA minimise encore davantage les besoins en mémoire. Introduit par Tim Dettmers et autres en 2023, il combine une adaptation de bas rang avec une quantification, en utilisant un format de quantification à 4 bits appelé Flotteur normal or nf4. La quantification est essentiellement un processus qui fait passer les données d'une représentation informationnelle plus élevée à une représentation contenant moins d'informations. Cette approche maintient l'efficacité des méthodes de réglage fin sur 16 bits, en déquantifiant les poids de 4 bits à 16 bits selon les besoins lors des processus de calcul.

Comparaison des méthodes de réglage fin : QLORA améliore LoRA avec une quantification de précision sur 4 bits et des optimiseurs paginés pour la gestion des pics de mémoire

QLoRA exploite NumericFloat4 (nf4), ciblant chaque couche de l'architecture du transformateur, et introduit le concept de double quantification pour réduire davantage l'empreinte mémoire requise pour le réglage fin. Ceci est réalisé en effectuant une quantification sur les constantes déjà quantifiées, une stratégie qui évite les pics de mémoire typiques des points de contrôle de gradient grâce à l'utilisation d'optimiseurs paginés et à une gestion unifiée de la mémoire.

Guanaco, qui est un ensemble optimisé par QLORA, constitue une référence en matière de solutions de chatbot open source. Ses performances, validées par des évaluations humaines et automatisées systématiques, soulignent sa domination et son efficacité dans le domaine.

Les versions 65B et 33B du Guanaco, affinées à l'aide d'une version modifiée du OASST1 ensemble de données, émergent comme de redoutables prétendants aux modèles renommés comme ChatGPT et même GPT-4.

Affinement à l’aide de l’apprentissage par renforcement à partir de la rétroaction humaine

L'apprentissage par renforcement à partir de la rétroaction humaine (RLHF) entre en jeu lors de l'ajustement précis des modèles linguistiques pré-entraînés pour s'aligner plus étroitement sur les valeurs humaines. Ce concept a été introduit par Open AI en 2017, jetant les bases d'une synthèse améliorée des documents et du développement de InstruireGPT.

Au cœur du RLHF se trouve le paradigme de l'apprentissage par renforcement, un type de technique d'apprentissage automatique dans lequel un agent apprend à se comporter dans un sûr, heureux et sain en effectuant actes et recevoir récompenses. C'est une boucle continue de action et de Réactions, où l'agent est incité à faire des choix qui rapporteront la récompense la plus élevée.

En traduisant cela au domaine des modèles de langage, le agent est modèle lui-même, opérant au sein du sûr, heureux et sain d'une fenêtre de contexte donnée et prendre des décisions basées sur Etat, qui est défini par les jetons actuels dans la fenêtre contextuelle. Le "espace d'action" englobe tous les jetons potentiels parmi lesquels le modèle peut choisir, l'objectif étant de sélectionner le jeton qui correspond le plus aux préférences humaines.

Le processus RLHF exploite largement les commentaires humains, en les utilisant pour former un modèle de récompense. Ce modèle joue un rôle crucial en guidant le modèle pré-entraîné pendant le processus de réglage fin, en l'encourageant à générer des résultats plus alignés sur les valeurs humaines. Il s'agit d'un processus dynamique et itératif, dans lequel le modèle apprend à travers une série de « déploiements », terme utilisé pour décrire la séquence d'états et d'actions menant à une récompense dans le contexte de la génération du langage.

L'un des potentiels remarquables du RLHF est sa capacité à favoriser la personnalisation des assistants IA, en les adaptant pour correspondre aux préférences de chaque utilisateur, qu'il s'agisse de son sens de l'humour ou de ses routines quotidiennes. Cela ouvre la voie à la création de systèmes d’IA non seulement techniquement compétents, mais également émotionnellement intelligents, capables de comprendre et de répondre aux nuances de la communication humaine.

Il est toutefois essentiel de noter que le RLHF n’est pas une solution infaillible. Les modèles sont toujours susceptibles de générer des résultats indésirables, reflet des données vastes, souvent non réglementées et biaisées, sur lesquelles ils sont formés.

Conclusion

Le processus de mise au point, une étape cruciale pour exploiter tout le potentiel des LLM tels qu'Alpaca, Falcon et GPT-4, est devenu plus raffiné et ciblé, offrant des solutions sur mesure à un large éventail de tâches.

Nous avons vu le réglage fin d'une tâche unique, spécialisé dans des modèles dans des rôles particuliers, et les méthodes de réglage fin efficace des paramètres (PEFT), notamment LoRA et QLoRA, qui visent à rendre le processus de formation plus efficace et plus rentable. Ces développements ouvrent les portes de fonctionnalités d’IA de haut niveau à un public plus large.

En outre, l'introduction de l'apprentissage par renforcement à partir du feedback humain (RLHF) par Open AI est une étape vers la création de systèmes d'IA qui comprennent et s'alignent plus étroitement sur les valeurs et les préférences humaines, ouvrant la voie à des assistants d'IA qui sont non seulement intelligents mais également sensibles aux besoins de chaque utilisateur. RLHF et PEFT travaillent en synergie pour améliorer la fonctionnalité et l'efficacité des grands modèles linguistiques.

Alors que les entreprises, les entreprises et les particuliers cherchent à intégrer ces LLM affinés dans leurs opérations, ils accueillent essentiellement un avenir dans lequel l'IA est plus qu'un outil ; c'est un partenaire qui comprend et s'adapte aux contextes humains, proposant des solutions innovantes et personnalisées.