Intelligence Artificielle

Diffusion vidéo stable : modèles de diffusion vidéo latente vers de grands ensembles de données

IA générative est une force motrice dans la communauté de l'IA depuis un certain temps déjà, et les progrès réalisés dans le domaine de la modélisation d'images génératives, notamment avec l'utilisation de modèles de diffusion, ont permis aux modèles vidéo génératifs de progresser de manière significative non seulement dans la recherche, mais également en termes de applications du monde réel. Classiquement, les modèles vidéo génératifs sont soit formés à partir de zéro, soit partiellement ou totalement affinés à partir de modèles d'image pré-entraînés avec des couches temporelles supplémentaires, sur un mélange d'ensembles de données d'images et de vidéos.

Faisant progresser les progrès des modèles vidéo génératifs, dans cet article, nous parlerons de la Modèle de diffusion vidéo stable, un modèle de diffusion vidéo latente capable de générer une image de pointe en haute résolution en vidéo et du texte en contenu vidéo. Nous expliquerons comment les modèles de diffusion latente formés pour synthétiser des images 2D ont amélioré les capacités et l'efficacité des modèles vidéo génératifs en ajoutant des couches temporelles et en affinant les modèles sur de petits ensembles de données constitués de vidéos de haute qualité. Nous approfondirons l'architecture et le fonctionnement du modèle de diffusion vidéo stable, évaluerons ses performances sur diverses mesures et les comparerons aux cadres de pointe actuels pour la génération vidéo. Alors, commençons.

Modèle de diffusion vidéo stable et modèles vidéo génératifs : une introduction

Grâce à son potentiel presque illimité, l’IA générative est depuis un certain temps déjà le principal sujet de recherche des praticiens de l’IA et du ML, et ces dernières années ont vu des progrès rapides tant en termes d’efficacité que de performances des modèles d’images génératifs. Les enseignements tirés des modèles d'images génératifs ont permis aux chercheurs et aux développeurs de progresser dans les modèles vidéo génératifs, ce qui a abouti à une fonctionnalité améliorée et à des applications réelles. Cependant, la plupart des recherches visant à améliorer les capacités des modèles vidéo génératifs se concentrent principalement sur la disposition exacte des couches temporelles et spatiales, peu d'attention étant accordée à l'influence de la sélection des bonnes données sur les résultats de ces modèles génératifs.

Grâce aux progrès réalisés par les modèles d’images génératifs, les chercheurs ont observé que l’impact de la distribution des données d’entraînement sur les performances des modèles génératifs est effectivement significatif et incontesté. En outre, les chercheurs ont également observé que le pré-entraînement d'un modèle d'image génératif sur un ensemble de données vaste et diversifié, suivi de son ajustement sur un ensemble de données plus petit et de meilleure qualité, aboutit souvent à une amélioration significative des performances. Traditionnellement, les modèles vidéo génératifs mettent en œuvre les enseignements obtenus à partir de modèles d'images génératifs réussis, et les chercheurs n'ont pas encore étudié l'effet des données, et les stratégies de formation doivent encore être étudiées. Le modèle de diffusion vidéo stable est une tentative d'améliorer les capacités des modèles vidéo génératifs en s'aventurant dans des territoires jusqu'alors inexplorés, en mettant un accent particulier sur la sélection des données.

Les modèles vidéo génératifs récents s'appuient sur des modèles de diffusion et des approches de conditionnement de texte ou de conditionnement d'images pour synthétiser plusieurs images vidéo ou images cohérentes. Les modèles de diffusion sont connus pour leur capacité à apprendre à débruiter progressivement un échantillon de la distribution normale en mettant en œuvre un processus de raffinement itératif, et ils ont fourni des résultats souhaitables sur la vidéo haute résolution et la synthèse texte-image. Utilisant le même principe à la base, le modèle de diffusion vidéo stable entraîne un modèle de diffusion vidéo latente sur son ensemble de données vidéo ainsi que l'utilisation de réseaux contradictoires génératifs ou GAN, et même de modèles autorégressifs dans une certaine mesure.

Le modèle de diffusion vidéo stable suit une stratégie unique jamais mise en œuvre par aucun modèle vidéo génératif car il repose sur des lignes de base de diffusion vidéo latentes avec une architecture fixe et une stratégie de formation fixe suivie d'une évaluation de l'effet de la conservation des données. Le modèle de diffusion vidéo stable vise à apporter les contributions suivantes dans le domaine de la modélisation vidéo générative.

- Présenter un flux de travail de conservation de données systématique et efficace dans le but de transformer une vaste collection d'échantillons vidéo non conservés en un ensemble de données de haute qualité qui est ensuite utilisé par les modèles vidéo génératifs.

- Former des modèles d'image à la vidéo et de texte à la vidéo de pointe qui surpassent les cadres existants.

- Mener des expériences spécifiques à un domaine pour sonder la compréhension 3D et un solide préalable au mouvement du modèle.

Désormais, le modèle de diffusion vidéo stable met en œuvre les enseignements des modèles de diffusion vidéo latente et les techniques de conservation des données au cœur de sa fondation.

Modèles de diffusion vidéo latente

Les modèles de diffusion vidéo latente ou vidéo-LDM suivent l'approche de formation du modèle génératif principal dans un espace latent avec une complexité de calcul réduite, et la plupart des vidéo-LDM implémentent un modèle texte-image pré-entraîné couplé à l'ajout de couches de mélange temporel dans la pré-entraînement. architecture. En conséquence, la plupart des modèles de diffusion vidéo latente entraînent uniquement les couches temporelles ou ignorent complètement le processus de formation, contrairement au modèle de diffusion vidéo stable qui affine l'ensemble du cadre. De plus, pour synthétiser des données texte en vidéo, le modèle de diffusion vidéo stable se conditionne directement sur une invite de texte, et les résultats indiquent que le cadre résultant peut être facilement affiné en une synthèse multi-vues ou un modèle image en vidéo.

Conservation des données

La conservation des données est un composant essentiel non seulement du modèle de diffusion vidéo stable, mais aussi des modèles génératifs dans leur ensemble, car il est essentiel de pré-entraîner de grands modèles sur des ensembles de données à grande échelle pour améliorer les performances dans différentes tâches, notamment la modélisation du langage ou la génération discriminante de texte en image. , et beaucoup plus. La conservation des données a été mise en œuvre avec succès sur des modèles d'images génératifs en exploitant les capacités de représentations langage-image efficaces, bien que de telles discussions n'aient jamais été ciblées pour le développement de modèles vidéo génératifs. Les développeurs sont confrontés à plusieurs obstacles lors de la conservation des données pour les modèles vidéo génératifs, et pour relever ces défis, le modèle de diffusion vidéo stable met en œuvre une stratégie de formation en trois étapes, ce qui entraîne de meilleurs résultats et une augmentation significative des performances.

Curation de données pour une synthèse vidéo de haute qualité

Comme indiqué dans la section précédente, le modèle de diffusion vidéo stable met en œuvre une stratégie de formation en trois étapes, entraînant de meilleurs résultats et une augmentation significative des performances. L'étape I est un pré-entraînement aux images étape qui utilise un modèle de diffusion texte-image 2D. L'étape II est destinée pré-formation vidéo dans lequel le framework s'entraîne sur une grande quantité de données vidéo. Enfin, nous avons le stade III pour mise au point vidéo dans lequel le modèle est affiné sur un petit sous-ensemble de vidéos de haute qualité et haute résolution.

Cependant, avant que le modèle de diffusion vidéo stable ne mette en œuvre ces trois étapes, il est essentiel de traiter et d'annoter les données, car elles servent de base à l'étape II ou à l'étape de pré-formation vidéo, et jouent un rôle essentiel pour garantir un résultat optimal. Pour garantir une efficacité maximale, le framework implémente d'abord un pipeline de détection de coupure en cascade à 3 niveaux variables de FPS ou d'images par seconde, et la nécessité de ce pipeline est démontrée dans l'image suivante.

Ensuite, le modèle de diffusion vidéo stable annote chaque clip vidéo à l'aide de trois méthodes de sous-titrage synthétique différentes. Le tableau suivant compare les ensembles de données utilisés dans le cadre de diffusion stable avant et après le processus de filtration.

Étape I : Pré-formation en image

La première étape du pipeline en trois étapes mis en œuvre dans le modèle de diffusion vidéo stable est le pré-entraînement des images, et pour y parvenir, le cadre initial du modèle de diffusion vidéo stable est fondé sur un modèle de diffusion d'images pré-entraîné, à savoir le Diffusion stable 2.1 modèle qui le dote de représentations visuelles plus fortes.

Étape II : Pré-formation vidéo

La deuxième étape est l'étape de pré-formation vidéo, et elle s'appuie sur les découvertes selon lesquelles l'utilisation de la curation de données dans des modèles d'images génératifs multimodaux aboutit souvent à de meilleurs résultats et à une efficacité accrue ainsi qu'à une puissante génération d'images discriminantes. Cependant, en raison du manque de représentations disponibles sur étagère puissantes similaires pour filtrer les échantillons indésirables pour les modèles vidéo génératifs, le modèle de diffusion vidéo stable s'appuie sur les préférences humaines comme signaux d'entrée pour la création d'un ensemble de données approprié utilisé pour la pré-formation du cadre. La figure suivante démontre l'effet positif de la pré-formation du framework sur un ensemble de données organisé, ce qui contribue à améliorer les performances globales de la pré-formation vidéo sur des ensembles de données plus petits.

Pour être plus précis, le cadre utilise différentes méthodes pour organiser des sous-ensembles de diffusion vidéo latente et considère le classement des modèles LVD formés sur ces ensembles de données. En outre, le framework Stable Video Diffusion constate également que l'utilisation d'ensembles de données organisés pour la formation des frameworks contribue à améliorer les performances du framework et des modèles de diffusion en général. En outre, la stratégie de conservation des données fonctionne également sur des ensembles de données plus vastes, plus pertinents et très pratiques. La figure suivante démontre l'effet positif de la pré-formation du framework sur un ensemble de données organisé, ce qui contribue à améliorer les performances globales de la pré-formation vidéo sur des ensembles de données plus petits.

Étape III : Mise au point de haute qualité

Jusqu'à l'étape II, le framework Stable Video Diffusion se concentre sur l'amélioration des performances avant le pré-entraînement vidéo, et dans la troisième étape, le framework met l'accent sur l'optimisation ou l'amélioration supplémentaire des performances du framework après un réglage fin de la vidéo de haute qualité, et comment le passage du stade II au stade III est réalisé dans le cadre. Au stade III, le cadre s'appuie sur des techniques de formation empruntées à des modèles de diffusion d'images latentes et augmente la résolution des exemples de formation. Pour analyser l'efficacité de cette approche, le framework la compare à trois modèles identiques qui diffèrent uniquement par leur initialisation. Le premier modèle identique a ses poids initialisés et le processus de formation vidéo est ignoré tandis que les deux modèles identiques restants sont initialisés avec les poids empruntés à d'autres modèles vidéo latents.

Résultats et constatations

Il est temps d'examiner comment le framework Stable Video Diffusion fonctionne sur des tâches du monde réel et comment il se compare aux frameworks de pointe actuels. Le framework Stable Video Diffusion utilise d'abord l'approche optimale des données pour former un modèle de base, puis effectue des réglages fins pour générer plusieurs modèles de pointe, où chaque modèle effectue une tâche spécifique.

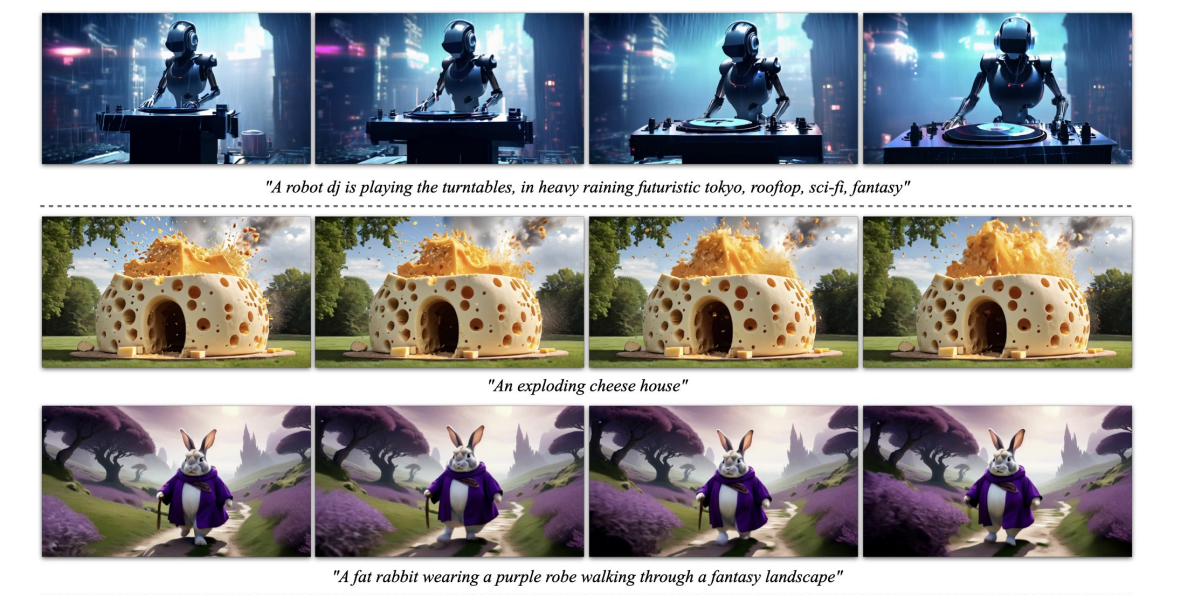

L'image ci-dessus représente l'image haute résolution en échantillons vidéo générés par le framework tandis que la figure suivante démontre la capacité du framework à générer du texte de haute qualité en échantillons vidéo.

Base M pré-entraînéeodèle

Comme indiqué précédemment, le modèle Stable Video Diffusion est construit sur le framework Stable Diffusion 2.1 et, sur la base de découvertes récentes, il était crucial pour les développeurs d'adopter le programme de bruit et d'augmenter le bruit pour obtenir des images avec une meilleure résolution lors de l'entraînement à la diffusion d'images. des modèles. Grâce à cette approche, le modèle de base de diffusion vidéo stable apprend de puissantes représentations de mouvement et, ce faisant, surpasse les modèles de base pour envoyer un SMS à génération vidéo dans un paramètre de prise de vue zéro, et les résultats sont affichés dans le tableau suivant.

Interpolation de trame et génération multi-vues

Le framework Stable Video Diffusion affine le modèle image-vidéo sur des ensembles de données multi-vues pour obtenir plusieurs nouvelles vues d'un objet, et ce modèle est connu sous le nom de SVD-MV ou modèle Stable Video Diffusion-Multi View. Le modèle SVD original est affiné à l'aide de deux ensembles de données de manière à ce que le framework saisisse une seule image et renvoie une séquence d'images à vues multiples en sortie.

Comme on peut le voir dans les images suivantes, le framework Stable Video Diffusion Multi View offre des performances élevées comparables au framework Scratch Multi View de pointe, et les résultats sont une démonstration claire de la capacité de SVD-MV à tirer parti des apprentissages obtenus. à partir du framework SVD original pour la génération d'images multi-vues. En outre, les résultats indiquent également que l'exécution du modèle sur un nombre relativement réduit d'itérations permet d'obtenir des résultats optimaux, comme c'est le cas avec la plupart des modèles affinés à partir du framework SVD.

Dans la figure ci-dessus, les métriques sont indiquées sur le côté gauche et comme on peut le voir, le framework Stable Video Diffusion Multi View surpasse les frameworks Scratch-MV et SD2.1 Multi-View par une marge décente. La deuxième image démontre l'effet du nombre d'itérations de formation sur les performances globales du framework en termes de Clip Score, et les frameworks SVD-MV fournissent des résultats durables.

Réflexions finales

Dans cet article, nous avons parlé de Stable Video Diffusion, un modèle de diffusion vidéo latente capable de générer une image haute résolution en vidéo et du texte en contenu vidéo. Le modèle de diffusion vidéo stable suit une stratégie unique jamais mise en œuvre par aucun modèle vidéo génératif car il repose sur des lignes de base de diffusion vidéo latentes avec une architecture fixe et une stratégie de formation fixe suivie d'une évaluation de l'effet de la conservation des données.

Nous avons expliqué comment les modèles de diffusion latente formés pour synthétiser des images 2D ont amélioré les capacités et l'efficacité de modèles vidéo génératifs en ajoutant des couches temporelles et en affinant les modèles sur de petits ensembles de données constitués de vidéos de haute qualité. Pour collecter les données de pré-formation, le cadre mène une étude de mise à l'échelle et suit des pratiques systématiques de collecte de données, et propose finalement une méthode pour conserver une grande quantité de données vidéo et convertit les vidéos bruitées en données d'entrée adaptées aux modèles vidéo génératifs.

De plus, le framework Stable Video Diffusion utilise trois étapes distinctes de formation de modèles vidéo qui sont analysées indépendamment pour évaluer leur impact sur les performances du framework. Le framework génère finalement une représentation vidéo suffisamment puissante pour affiner les modèles pour une synthèse vidéo optimale, et les résultats sont comparables aux modèles de génération vidéo de pointe déjà utilisés.