Intelligence artificielle

GPT-4o d'OpenAI : le modèle d'IA multimodal qui transforme l'interaction homme-machine

OpenAI a publié son modèle de langage le plus récent et le plus avancé à ce jour – GPT-4o, également connu sous le nom de "Omni" modèle. Ce système d’IA révolutionnaire représente un pas de géant, avec des capacités qui brouillent la frontière entre intelligence humaine et artificielle.

Au cœur de GPT-4o réside sa nature multimodale native, lui permettant de traiter et de générer de manière transparente du contenu à travers du texte, de l'audio, des images et de la vidéo. Cette intégration de plusieurs modalités dans un modèle unique est une première du genre, promettant de remodeler la façon dont nous interagissons avec les assistants IA.

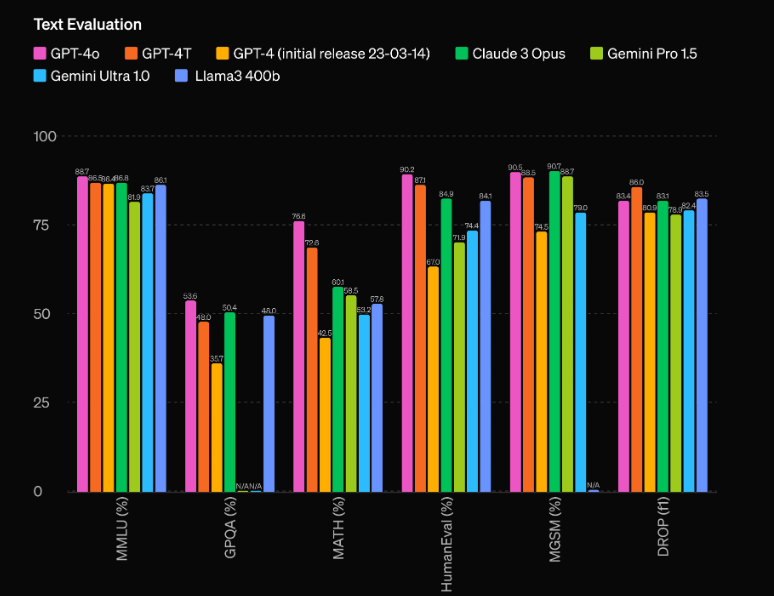

Mais GPT-4o est bien plus qu’un simple système multimodal. Il offre une amélioration stupéfiante des performances par rapport à son prédécesseur, GPT-4, et laisse les modèles concurrents comme Gemini 1.5 Pro, Claude 3 et Llama 3-70B dans la poussière. Examinons plus en détail ce qui rend ce modèle d'IA vraiment révolutionnaire.

Performances et efficacité inégalées

L'un des aspects les plus impressionnants de GPT-4o réside dans ses capacités de performances sans précédent. Selon les évaluations d'OpenAI, le modèle a une avance remarquable de 60 points Elo sur le précédent modèle le plus performant, GPT-4 Turbo. Cet avantage significatif place le GPT-4o dans une catégorie à part, surpassant même les modèles d'IA les plus avancés actuellement disponibles.

Mais les performances brutes ne sont pas le seul domaine dans lequel GPT-4o brille. Le modèle offre également une efficacité impressionnante, fonctionnant à deux fois la vitesse du GPT-4 Turbo tout en coûtant seulement la moitié du prix de fonctionnement. Cette combinaison de performances supérieures et de rentabilité fait de GPT-4o une proposition extrêmement attractive pour les développeurs et les entreprises cherchant à intégrer des capacités d'IA de pointe dans leurs applications.

Capacités multimodales : mélange de texte, d'audio et de vision

L’aspect le plus révolutionnaire de GPT-4o est peut-être sa nature multimodale native, qui lui permet de traiter et de générer de manière transparente du contenu sur plusieurs modalités, notamment le texte, l’audio et la vision. Cette intégration de plusieurs modalités dans un modèle unique est une première en son genre et promet de révolutionner la façon dont nous interagissons avec les assistants IA.

Avec GPT-4o, les utilisateurs peuvent engager des conversations naturelles et en temps réel en utilisant la parole, le modèle reconnaissant et répondant instantanément aux entrées audio. Mais les capacités ne s'arrêtent pas là : GPT-4o peut également interpréter et générer du contenu visuel, ouvrant ainsi un monde de possibilités pour des applications allant de l'analyse et de la génération d'images à la compréhension et à la création de vidéos.

L'une des démonstrations les plus impressionnantes des capacités multimodales de GPT-4o est sa capacité à analyser une scène ou une image en temps réel, décrivant et interprétant avec précision les éléments visuels qu'elle perçoit. Cette fonctionnalité a de profondes implications pour des applications telles que les technologies d'assistance pour les malvoyants, ainsi que dans des domaines tels que la sécurité, la surveillance et l'automatisation.

Mais les capacités multimodales de GPT-4o vont au-delà de la simple compréhension et de la génération de contenu selon différentes modalités. Le modèle peut également mélanger de manière transparente ces modalités, créant ainsi des expériences véritablement immersives et engageantes. Par exemple, lors de la démo en direct d'OpenAI, GPT-4o a pu générer une chanson basée sur les conditions d'entrée, combinant sa compréhension du langage, de la théorie musicale et de la génération audio dans une sortie cohérente et impressionnante.

Utiliser GPT0 avec Python

import openai

# Replace with your actual API key

OPENAI_API_KEY = "your_openai_api_key_here"

# Function to extract the response content

def get_response_content(response_dict, exclude_tokens=None):

if exclude_tokens is None:

exclude_tokens = []

if response_dict and response_dict.get("choices") and len(response_dict["choices"]) > 0:

content = response_dict["choices"][0]["message"]["content"].strip()

if content:

for token in exclude_tokens:

content = content.replace(token, '')

return content

raise ValueError(f"Unable to resolve response: {response_dict}")

# Asynchronous function to send a request to the OpenAI chat API

async def send_openai_chat_request(prompt, model_name, temperature=0.0):

openai.api_key = OPENAI_API_KEY

message = {"role": "user", "content": prompt}

response = await openai.ChatCompletion.acreate(

model=model_name,

messages=[message],

temperature=temperature,

)

return get_response_content(response)

# Example usage

async def main():

prompt = "Hello!"

model_name = "gpt-4o-2024-05-13"

response = await send_openai_chat_request(prompt, model_name)

print(response)

if __name__ == "__main__":

import asyncio

asyncio.run(main())

J'ai:

- Importation du module openai directement au lieu d'utiliser une classe personnalisée.

- Renommé la fonction openai_chat_resolve en get_response_content et apporté quelques modifications mineures à son implémentation.

- Remplacement de la classe AsyncOpenAI par la fonction openai.ChatCompletion.acreate, qui est la méthode asynchrone officielle fournie par la bibliothèque OpenAI Python.

- Ajout d'un exemple de fonction principale qui montre comment utiliser la fonction send_openai_chat_request.

Veuillez noter que vous devez remplacer « your_openai_api_key_here » par votre clé API OpenAI actuelle pour que le code fonctionne correctement.