Intelligence artificielle

Rendu neuronal : NeRF se promène au grand air

Une collaboration entre Google Research et l'Université de Harvard a mis au point une nouvelle méthode pour créer une vidéo neuronale à 360 degrés de scènes complètes à l'aide de Champs de rayonnement neuronal (NeRF). La nouvelle approche rapproche NeRF de l'utilisation abstraite occasionnelle dans n'importe quel environnement, sans se limiter à modèles de table or scénarios intérieurs fermés.

Voir la fin de l'article pour la vidéo complète. Source : https://www.youtube.com/watch?v=YStDS2-Ln1s

Mip-NeRF 360 peut gérer des arrière-plans étendus et des objets «infinis» tels que le ciel, car, contrairement à la plupart des itérations précédentes, il fixe des limites sur la façon dont les rayons lumineux sont interprétés et crée des limites d'attention qui rationalisent les temps d'entraînement autrement longs. Voir la nouvelle vidéo d'accompagnement intégrée à la fin de cet article pour plus d'exemples et un aperçu détaillé du processus.

La nouveau papier est intitulé Mip-NeRF 360 : champs de rayonnement neuronal anticrénelés illimités, et est dirigé par Jon Barron, chercheur principal chez Google Research.

Pour comprendre la percée, il est nécessaire d'avoir une compréhension de base du fonctionnement de la synthèse d'images basée sur le champ de rayonnement neuronal.

Qu'est-ce que NeRF ?

Il est problématique de décrire un réseau NeRF en termes de "vidéo", car il est plus proche d'une réalisation entièrement en 3D mais Basé sur l'IA environnement virtuel, où plusieurs points de vue de photos uniques (y compris des images vidéo) sont utilisés pour assembler une scène qui n'existe techniquement que dans l'espace latent d'un algorithme d'apprentissage automatique – mais à partir de laquelle un nombre extraordinaire de points de vue et de vidéos peuvent être extraits à volonté .

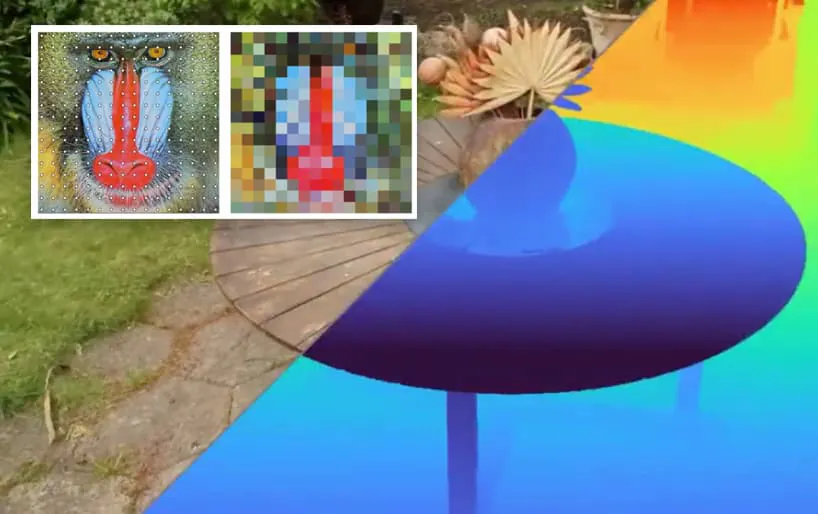

Une représentation des multiples points de capture de la caméra qui fournissent les données que NeRF assemble dans une scène neuronale (photo de droite).

Les informations dérivées des photos contributives sont formées dans une matrice similaire à une matrice traditionnelle grille de voxels dans les flux de travail CGI, en ce sens que chaque point de l'espace 3D se termine par une valeur, ce qui rend la scène navigable.

Une matrice de voxels traditionnelle place les informations de pixel (qui existent normalement dans un contexte 2D, comme la grille de pixels d'un fichier JPEG) dans un espace tridimensionnel. Source : ResearchGate

Après avoir calculé l'espace interstitiel entre les photos (si nécessaire), le chemin de chaque pixel possible de chaque photo contributrice est effectivement "ray-tracé" et se voit attribuer une valeur de couleur, y compris une valeur de transparence (sans laquelle la matrice neurale serait complètement opaque, ou complètement vide).

Comme les grilles de voxels, et contrairement à Espace de coordonnées 3D basé sur CGI, "l'intérieur" d'un objet "fermé" n'existe pas dans une matrice NeRF. Vous pouvez ouvrir un kit de batterie CGI et regarder à l'intérieur, si vous le souhaitez ; mais en ce qui concerne NeRF, l'existence du kit de batterie se termine lorsque la valeur d'opacité de sa surface est égale à '1'.

Une vue plus large d'un pixel

Mip-NeRF 360 est une extension de recherche à partir de mars 2021, qui a effectivement introduit un anti-aliasing efficace dans NeRF sans suréchantillonnage exhaustif.

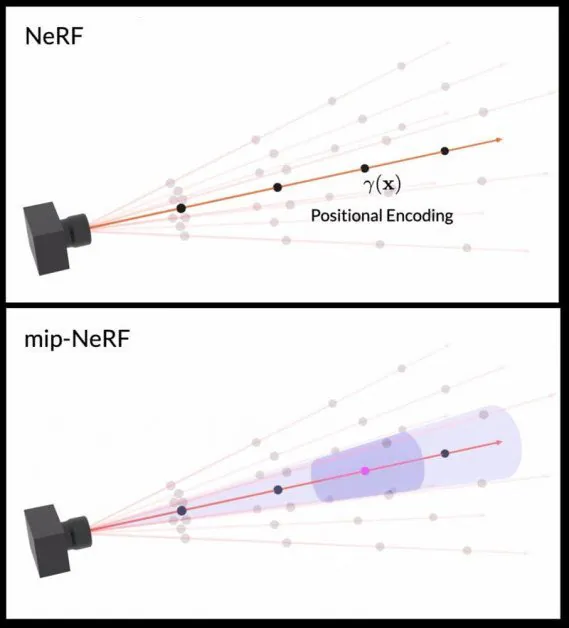

NeRF calcule traditionnellement un seul chemin de pixel, qui est enclin à produire le type de 'jaggies' qui caractérisaient les premiers formats d'image Internet, ainsi que systèmes de jeux antérieurs. Ces bords dentelés ont été résolus par diverses méthodes, impliquant généralement l'échantillonnage de pixels adjacents et la recherche d'une représentation moyenne.

Étant donné que le NeRF traditionnel n'échantillonne qu'un seul chemin de pixel, Mip-NeRF a introduit une zone de captage "conique", comme une torche à faisceau large, qui fournit suffisamment d'informations sur adjacent pixels pour produire un anticrénelage économique avec des détails améliorés.

Le captage de cône conique utilisé par Mip-NeRF est découpé en troncs coniques (image inférieure), qui sont encore "flous" pour créer de vagues espaces gaussiens qui peuvent être utilisés pour calculer la précision et le crénelage d'un pixel. Source : https://www.youtube.com/watch?v=EpH175PY1A0

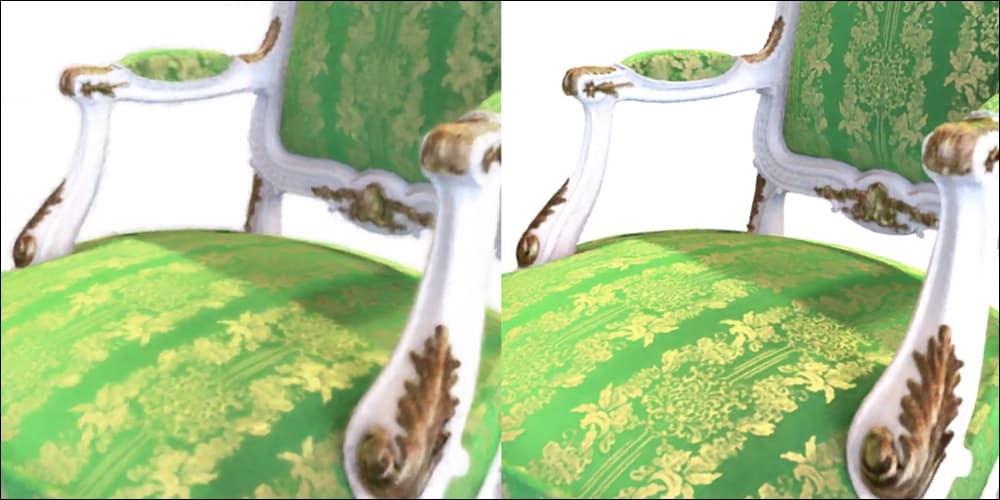

L'amélioration par rapport à une implémentation standard de NeRF était notable :

Mip-NeRF (à droite), publié en mars 2021, fournit des détails améliorés grâce à un pipeline de crénelage plus complet mais économique, plutôt que de simplement « flouter » les pixels pour éviter les bords irréguliers. Source : https://jonbarron.info/mipnerf/

NeRF illimité

L'article de mars a laissé trois problèmes non résolus concernant l'utilisation de Mip-NeRF dans des environnements illimités pouvant inclure des objets très éloignés, y compris le ciel. Le nouvel article résout ce problème en appliquant un À la Kalman warp aux gaussiennes Mip-NeRF.

Deuxièmement, les scènes plus grandes nécessitent une plus grande puissance de traitement et des temps de formation prolongés, ce que Mip-NeRF 360 résout en "distillant" la géométrie de la scène avec une petite "proposition" perceptron multicouche (MLP), qui prélimite la géométrie prédite par un grand standard NeRF MLP. Cela accélère la formation par un facteur de trois.

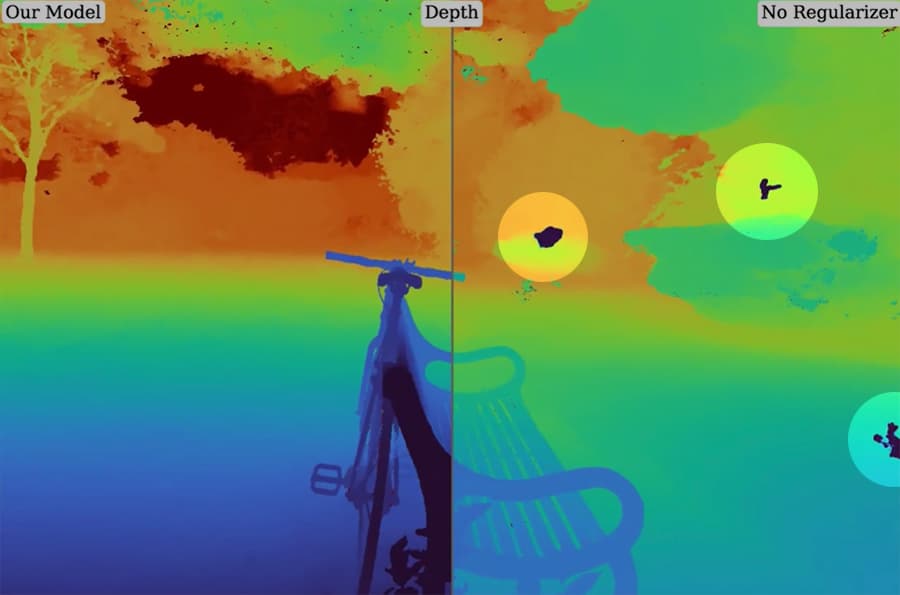

Enfin, les scènes plus grandes ont tendance à rendre ambiguë la discrétisation de la géométrie interprétée, ce qui donne le type d'artefacts avec lesquels les joueurs peuvent être familiers lorsque la sortie du jeu "déchirure". Le nouvel article résout ce problème en créant un nouveau régularisateur pour les intervalles de rayons Mip-NeRF.

Sur la droite, nous voyons des artefacts indésirables dans Mip-NeRF en raison de la difficulté à délimiter une si grande scène. A gauche, on voit que le nouveau régularisateur a suffisamment bien optimisé la scène pour supprimer ces perturbations.

Pour en savoir plus sur le nouveau papier, regardez la vidéo ci-dessous, ainsi que le Présentation vidéo de mars 2021 à Mip-NeRF. Vous pouvez également en savoir plus sur la recherche NeRF en consultant notre couverture jusqu'à présent.

Publié initialement le 25 novembre 2021

21 décembre 2021, 12h25 – Remplacement de la vidéo morte. – MA