Intelligence Artificielle

Agents mobiles : agent d'appareil mobile multimodal autonome avec perception visuelle

L'avènement des grands modèles linguistiques multimodaux (MLLM) a marqué le début d'une nouvelle ère d'agents d'appareils mobiles, capables de comprendre et d'interagir avec le monde à travers le texte, les images et la voix. Ces agents marquent une avancée significative par rapport à l’IA traditionnelle, offrant aux utilisateurs un moyen plus riche et plus intuitif d’interagir avec leurs appareils. En tirant parti du MLLM, ces agents peuvent traiter et synthétiser de grandes quantités d'informations provenant de diverses modalités, ce qui leur permet d'offrir une assistance personnalisée et d'améliorer l'expérience utilisateur d'une manière auparavant inimaginable.

Ces agents s'appuient sur des techniques d'apprentissage automatique de pointe et des capacités avancées de traitement du langage naturel, leur permettant de comprendre et de générer du texte de type humain, ainsi que d'interpréter les données visuelles et auditives avec une précision remarquable. De la reconnaissance d'objets et de scènes dans des images à la compréhension de commandes vocales et à l'analyse de sentiments textuels, ces agents multimodaux sont équipés pour gérer un large éventail d'entrées de manière transparente. Le potentiel de cette technologie est vaste, offrant des services plus sophistiqués et contextuels, tels que des assistants virtuels sensibles aux émotions humaines et des outils pédagogiques qui s'adaptent aux styles d'apprentissage individuels. Ils ont également le potentiel de révolutionner l’accessibilité, en rendant la technologie plus accessible au-delà des barrières linguistiques et sensorielles.

Dans cet article, nous parlerons de Mobile-Agents, un agent de périphérique multimodal autonome qui exploite d'abord la capacité des outils de perception visuelle à identifier et localiser avec précision les éléments visuels et textuels avec l'interface frontale d'une application mobile. En utilisant ce contexte de vision perçu, le cadre Mobile-Agent planifie et décompose la tâche opérationnelle complexe de manière autonome et navigue à travers les applications mobiles à travers des opérations étape par étape. Le cadre Mobile-Agent diffère des solutions existantes car il ne s'appuie pas sur les métadonnées du système mobile ou les fichiers XML des applications mobiles, ce qui permet une adaptabilité améliorée dans divers environnements d'exploitation mobiles d'une manière centrée sur la vision. L'approche suivie par le framework Mobile-Agent élimine le besoin de personnalisations spécifiques au système, ce qui se traduit par des performances améliorées et des exigences informatiques réduites.

Agents mobiles : agent de périphérique mobile multimodal autonome

Dans le monde en évolution rapide de la technologie mobile, un concept pionnier émerge comme étant remarquable : les grands modèles linguistiques, en particulier les grands modèles linguistiques multimodaux ou MLLM, capables de générer un large éventail de textes, d'images, de vidéos et de paroles dans différentes langues. Le développement rapide des frameworks MLLM au cours des dernières années a donné naissance à une nouvelle et puissante application des MLLM : les agents mobiles autonomes. Les agents mobiles autonomes sont des entités logicielles qui agissent, se déplacent et fonctionnent de manière indépendante, sans avoir besoin de commandes humaines directes, conçues pour parcourir des réseaux ou des appareils afin d'accomplir des tâches, collecter des informations ou résoudre des problèmes.

Les agents mobiles sont conçus pour faire fonctionner l'appareil mobile de l'utilisateur sur la base des instructions utilisateur et des visuels de l'écran, une tâche qui nécessite que les agents possèdent à la fois des capacités de compréhension sémantique et de perception visuelle. Cependant, les agents mobiles existants sont loin d'être parfaits car ils sont basés sur de grands modèles de langage multimodaux, et même les cadres MLLM de pointe actuels, y compris GPT-4V, manquent des capacités de perception visuelle nécessaires pour servir d'agent efficace. agent mobile. De plus, bien que les frameworks existants puissent générer des opérations efficaces, ils ont du mal à localiser avec précision la position de ces opérations sur l'écran, ce qui limite les applications et la capacité des agents mobiles à opérer sur des appareils mobiles.

Pour résoudre ce problème, certains frameworks ont choisi d'exploiter les fichiers de présentation de l'interface utilisateur pour aider le GPT-4V ou d'autres MLLM avec des capacités de localisation, certains frameworks parvenant à extraire des positions exploitables à l'écran en accédant aux fichiers XML de l'application alors que d'autres frameworks a choisi d'utiliser le code HTML des applications Web. Comme on peut le constater, la majorité de ces frameworks reposent sur l'accès aux fichiers d'application sous-jacents et locaux, ce qui rend la méthode presque inefficace si le framework ne peut pas accéder à ces fichiers. Pour résoudre ce problème et éliminer la dépendance des agents locaux vis-à-vis des fichiers sous-jacents aux méthodes de localisation, les développeurs ont travaillé sur Mobile-Agent, un agent mobile autonome doté de capacités de perception visuelle impressionnantes. Grâce à son module de perception visuelle, le framework Mobile-Agent utilise des captures d'écran de l'appareil mobile pour localiser avec précision les opérations. Le module de perception visuelle héberge des modèles d'OCR et de détection chargés d'identifier le texte sur l'écran et de décrire le contenu dans une région spécifique de l'écran mobile. Le framework Mobile-Agent utilise des invites soigneusement conçues et facilite une interaction efficace entre les outils et les agents, automatisant ainsi les opérations des appareils mobiles.

En outre, le framework Mobile-Agents vise à exploiter les capacités contextuelles des frameworks MLLM de pointe tels que GPT-4V pour obtenir des capacités d'auto-planification qui permettent au modèle de planifier des tâches en fonction de l'historique des opérations, des instructions de l'utilisateur et des captures d'écran de manière holistique. Pour améliorer encore la capacité de l'agent à identifier les instructions incomplètes et les opérations erronées, le framework Mobile-Agent introduit une méthode d'auto-réflexion. Sous la direction d'invites soigneusement conçues, l'agent réfléchit systématiquement aux opérations incorrectes et invalides et arrête les opérations une fois la tâche ou l'instruction terminée.

Globalement, les contributions du framework Mobile-Agent peuvent être résumées comme suit :

- Mobile-Agent agit comme un agent mobile autonome, utilisant des outils de perception visuelle pour localiser les opérations. Il planifie méthodiquement chaque étape et s'appuie sur l'introspection. Il s'appuie notamment exclusivement sur des captures d'écran de l'appareil, sans aucun code système, ce qui illustre une solution entièrement basée sur des techniques de vision.

- Mobile-Agent présente Mobile-Eval, une référence conçue pour évaluer les agents sur appareils mobiles. Ce benchmark comprend une variété des dix applications mobiles les plus couramment utilisées, ainsi que des instructions intelligentes pour ces applications, classées en trois niveaux de difficulté.

Mobile-Agent : Architecture et Méthodologie

À la base, le framework Mobile-Agent se compose d'un état de l'art Modèle multimodal de langage étendu, le GPT-4V, un module de détection de texte utilisé pour les tâches de localisation de texte. Outre GPT-4V, Mobile-Agent utilise également un module de détection d'icônes pour la localisation des icônes.

Perception visuelle

Comme mentionné précédemment, le GPT-4V MLLM fournit des résultats satisfaisants pour les instructions et les captures d'écran, mais il ne parvient pas à indiquer efficacement l'emplacement où les opérations ont lieu. En raison de cette limitation, le framework Mobile-Agent implémentant le modèle GPT-4V doit s'appuyer sur des outils externes pour aider à la localisation des opérations, facilitant ainsi la sortie des opérations sur l'écran mobile.

Localisation de texte

Le framework Mobile-Agent implémente un outil OCR pour détecter la position du texte correspondant sur l'écran chaque fois que l'agent doit appuyer sur un texte spécifique affiché sur l'écran du mobile. Il existe trois scénarios uniques de localisation de texte.

Scénario 1 : aucun texte spécifié détecté

Question: L'OCR ne parvient pas à détecter le texte spécifié, ce qui peut apparaître dans des images complexes ou en raison des limitations de l'OCR.

Réponse: Demandez à l'agent de :

- Resélectionnez le texte à appuyer, permettant une correction manuelle de l'oubli de l'OCR, ou

- Choisissez une opération alternative, par exemple en utilisant une méthode de saisie différente ou en effectuant une autre action pertinente pour la tâche à accomplir.

Raisonnement: Cette flexibilité est nécessaire pour gérer les inexactitudes ou les hallucinations occasionnelles du GPT-4V, garantissant ainsi que l'agent peut toujours agir efficacement.

Scénario 2 : instance unique du texte spécifié détectée

Opération: Générez automatiquement une action pour cliquer sur les coordonnées centrales de la zone de texte détectée.

Justification: Avec une seule instance détectée, la probabilité d’une identification correcte est élevée, ce qui rend efficace la poursuite d’une action directe.

Scénario 3 : Plusieurs instances du texte spécifié détectées

Évaluation: Tout d’abord, évaluez le nombre d’instances détectées :

De nombreux cas: Indique un écran encombré de contenu similaire, compliquant le processus de sélection.

Action: Demander à l'agent de resélectionner le texte, dans le but d'affiner la sélection ou d'ajuster les paramètres de recherche.

Quelques exemples : Un nombre gérable de détections permet une approche plus nuancée.

Action: Recadrez les régions autour de ces instances, en élargissant les zones de détection de texte vers l'extérieur pour capturer un contexte supplémentaire. Cette expansion garantit que davantage d’informations sont préservées, ce qui facilite la prise de décision.

L'étape suivante: Dessinez des boîtes de détection sur les images recadrées et présentez-les à l'agent. Cette assistance visuelle aide l'agent à décider avec quelle instance interagir, en fonction d'indices contextuels ou des exigences de la tâche.

Cette approche structurée optimise l'interaction entre les résultats de l'OCR et les opérations des agents, améliorant ainsi la fiabilité et l'adaptabilité du système dans la gestion des tâches textuelles dans différents scénarios. L'ensemble du processus est illustré dans l'image suivante.

Localisation des icônes

Le framework Mobile-Agent implémente un outil de détection d'icône pour localiser la position d'une icône lorsque l'agent doit cliquer dessus sur l'écran du mobile. Pour être plus précis, le framework demande d'abord à l'agent de fournir des attributs spécifiques de l'image, notamment la forme et la couleur, puis le framework implémente la méthode Grounding DINO avec l'icône d'invite pour identifier toutes les icônes contenues dans la capture d'écran. Enfin, Mobile-Agent utilise le framework CLIP pour calculer la similarité entre la description de la région de clic, calcule la similarité entre les icônes supprimées et sélectionne la région présentant la similarité la plus élevée pour un clic.

Exécution des instructions

Pour traduire les actions en opérations à l'écran par les agents, le framework Mobile-Agent définit 8 opérations différentes.

- Lancer l'application (nom de l'application) : Lancez l'application désignée à partir de l'interface de bureau.

- Appuyez sur Texte (Étiquette de texte) : Interagissez avec la partie d’écran affichant l’étiquette « Text Label ».

- Interagissez avec l'icône (description de l'icône, emplacement) : Ciblez et appuyez sur la zone d'icône spécifiée, où « Description de l'icône » détaille les attributs tels que la couleur et la forme de l'icône. Choisissez « Emplacement » parmi les options telles que haut, bas, gauche, droite ou centre, en combinant éventuellement deux pour une navigation précise et pour réduire les erreurs.

- Saisir du texte (Saisie de texte) : Saisissez le « Texte de saisie » donné dans le champ de texte actif.

- Faites défiler vers le haut et vers le bas : Naviguez vers le haut ou vers le bas dans le contenu de la présente page.

- Retourner: Revenir à la page précédemment consultée.

- Fermer: Revenez au bureau directement à partir de l’écran actuel.

- Arrêt: Terminez l'opération une fois la tâche accomplie.

Auto-planification

Chaque étape de l'opération est exécutée de manière itérative par le framework, et avant le début de chaque itération, l'utilisateur doit fournir une instruction d'entrée, et le modèle Mobile-Agent utilise l'instruction pour générer une invite système pour l'ensemble du processus. De plus, avant le début de chaque itération, le framework capture une capture d'écran et la transmet à l'agent. L'agent observe ensuite la capture d'écran, l'historique des opérations et les invites du système pour afficher l'étape suivante des opérations.

Auto-réflexion

Au cours de ses opérations, l'agent peut rencontrer des erreurs l'empêchant d'exécuter correctement une commande. Afin d'améliorer le taux d'exécution des instructions, une approche d'auto-évaluation a été mise en œuvre, s'activant dans deux circonstances spécifiques. Initialement, si l'agent exécute une action erronée ou invalide interrompant la progression, par exemple lorsqu'il constate que la capture d'écran reste inchangée après l'opération ou affiche une page incorrecte, il sera invité à envisager des actions alternatives ou à ajuster les paramètres de l'opération existante. Deuxièmement, l'agent peut omettre certains éléments d'une instruction complexe. Une fois que l'agent a exécuté une série d'actions conformément à son plan initial, il sera invité à revoir sa séquence d'actions, la dernière capture d'écran et l'instruction de l'utilisateur afin de déterminer si la tâche a été effectuée. En cas d'incohérences, l'agent est chargé de générer de manière autonome de nouvelles actions pour exécuter l'instruction.

Mobile-Agent : Expériences et Résultats

Pour évaluer ses capacités de manière globale, le framework Mobile-Agent introduit le benchmark Mobile-Eval composé de 10 applications couramment utilisées et conçoit trois instructions pour chaque application. La première opération est simple et ne couvre que les opérations de base de l'application, tandis que la deuxième opération est un peu plus complexe que la première car elle comporte des exigences supplémentaires. Enfin, la troisième opération est la plus complexe de toutes car elle contient des instructions utilisateur abstraites, l'utilisateur ne spécifiant pas explicitement quelle application utiliser ni quelle opération effectuer.

En progressant, pour évaluer les performances sous différents angles, le framework Mobile-Agent conçoit et implémente 4 métriques différentes.

- Su ou Succès : Si l'agent mobile termine les instructions, cela est considéré comme un succès.

- Score de processus ou PS : La métrique Process Score mesure la précision de chaque étape lors de l’exécution des instructions utilisateur et elle est calculée en divisant le nombre d’étapes correctes par le nombre total d’étapes.

- Efficacité relative ou RE : Le score d'efficacité relative est un rapport ou une comparaison entre le nombre d'étapes nécessaires à un humain pour exécuter l'instruction manuellement et le nombre d'étapes nécessaires à l'agent pour exécuter la même instruction.

- Taux d'achèvement ou CR : La métrique du taux d'achèvement divise le nombre d'étapes effectuées par un humain que le framework exécute avec succès par le nombre total d'étapes effectuées par un humain pour terminer l'instruction. La valeur de CR est 1 lorsque l'agent termine l'instruction avec succès.

Les résultats sont démontrés dans la figure suivante.

Initialement, pour les trois tâches données, l'agent mobile a atteint des taux d'achèvement respectifs de 91 %, 82 % et 82 %. Bien que toutes les tâches n'aient pas été parfaitement exécutées, les taux de réussite pour chaque catégorie ont dépassé 90 %. De plus, l'indicateur PS révèle que l'agent mobile affiche systématiquement une forte probabilité d'exécuter des actions précises pour les trois tâches, avec des taux de réussite d'environ 80 %. De plus, selon l'indicateur RE, l'agent mobile affiche une efficacité de 80 % dans l'exécution des opérations, à un niveau comparable à l'optimalité humaine. Ces résultats soulignent collectivement la compétence de l'agent mobile en tant qu'assistant mobile.

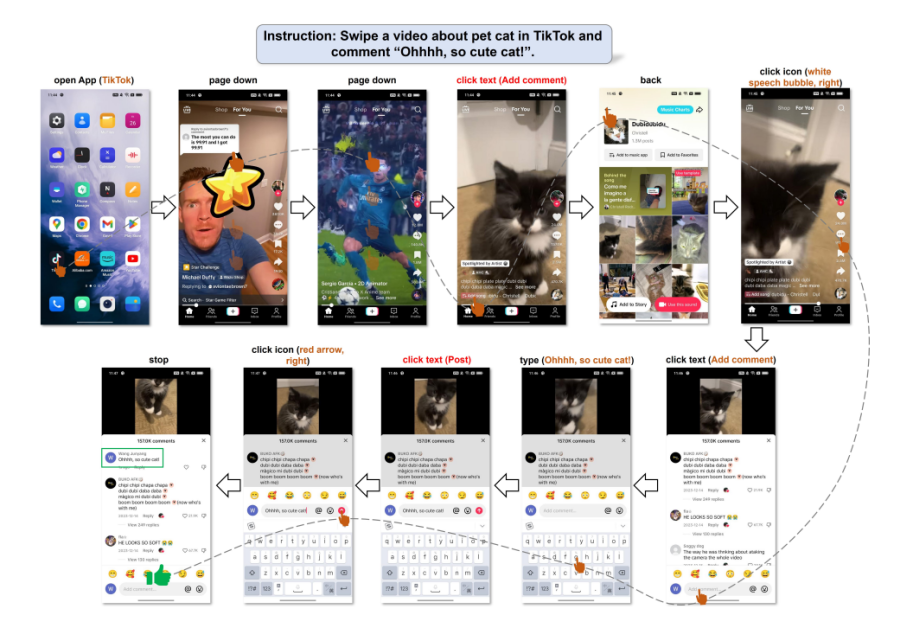

La figure suivante illustre la capacité de l'agent mobile à saisir les commandes de l'utilisateur et à orchestrer ses actions de manière autonome. Même en l'absence de détails opérationnels explicites dans les instructions, l'agent mobile a interprété avec précision les besoins de l'utilisateur et les a convertis en tâches réalisables. Suite à cette compréhension, l'agent a exécuté les instructions via un processus de planification systématique.

Réflexions finales

Dans cet article, nous avons présenté Mobile-Agents, un agent multimodal autonome qui utilise initialement des technologies de perception visuelle pour détecter et localiser précisément les composants visuels et textuels de l'interface d'une application mobile. Dans ce contexte visuel, le framework Mobile-Agent décrit et décompose de manière autonome les tâches complexes en actions gérables, permettant une navigation fluide et progressive dans les applications mobiles. Ce framework se distingue des méthodologies existantes car il ne dépend pas des métadonnées du système mobile ni des fichiers XML des applications mobiles, offrant ainsi une plus grande flexibilité sur différents systèmes d'exploitation mobiles, en privilégiant le traitement visuel. La stratégie employée par le framework Mobile-Agent évite toute adaptation spécifique au système, améliorant ainsi l'efficacité et réduisant les besoins de calcul.