Intelligence artificielle

Mistral AI : établir de nouvelles références au-delà de Llama2 dans l'espace open source

Les grands modèles linguistiques (LLM) ont récemment occupé le devant de la scène, grâce à des acteurs remarquables comme ChatGPT. Lorsque Meta a présenté ses modèles Llama, cela a suscité un regain d'intérêt pour les LLM open source. L'objectif? Créer des LLM open source abordables qui sont aussi performants que les modèles haut de gamme tels que GPT-4, mais sans le prix élevé ni la complexité.

Ce mélange d'abordabilité et d'efficacité a non seulement ouvert de nouvelles voies aux chercheurs et aux développeurs, mais a également ouvert la voie à une nouvelle ère de progrès technologiques dans le traitement du langage naturel.

Récemment, les startups d’IA générative ont bénéficié de financements. Ensemble levé $ 20 millions, visant à façonner l’IA open source. Anthropic a également levé la somme impressionnante de 450 millions de dollars, et Cohere, en partenariat avec Google Cloud, obtenu 270 millions de dollars en juin de cette année.

Introduction au Mistral 7B : taille et disponibilité

Mistral AI, basée à Paris et co-fondée par des anciens de DeepMind et Meta de Google, a annoncé son premier grand modèle de langage : Mistral 7B. Ce modèle peut être facilement téléchargé par n'importe qui depuis GitHub et même via un Torrent de 13.4 Go.

Cette startup a réussi à obtenir un financement de démarrage record avant même de lancer un produit. Le premier mode Mistral AI avec 7 milliards de paramètres dépasse les performances de Llama 2 13B dans tous les tests et bat Llama 1 34B dans de nombreux paramètres.

Comparé à d'autres modèles comme Llama 2, Mistral 7B offre des capacités similaires ou supérieures, mais avec moins de frais de calcul. Bien que les modèles fondamentaux tels que GPT-4 puissent faire plus, ils ont un coût plus élevé et ne sont pas aussi conviviaux car ils sont principalement accessibles via des API.

Lorsqu'il s'agit de tâches de codage, Mistral 7B donne CodeLlama 7B une course pour son argent. De plus, il est suffisamment compact (13.4 Go) pour fonctionner sur des machines standard.

De plus, Mistral 7B Instruct, spécialement conçu pour les ensembles de données pédagogiques sur Étreindre le visage, a montré de belles performances. Il surpasse les autres modèles 7B sur MT-Bench et se tient aux côtés des modèles de chat 13B.

Visage câlin Mistral 7B Exemple

Analyse comparative des performances

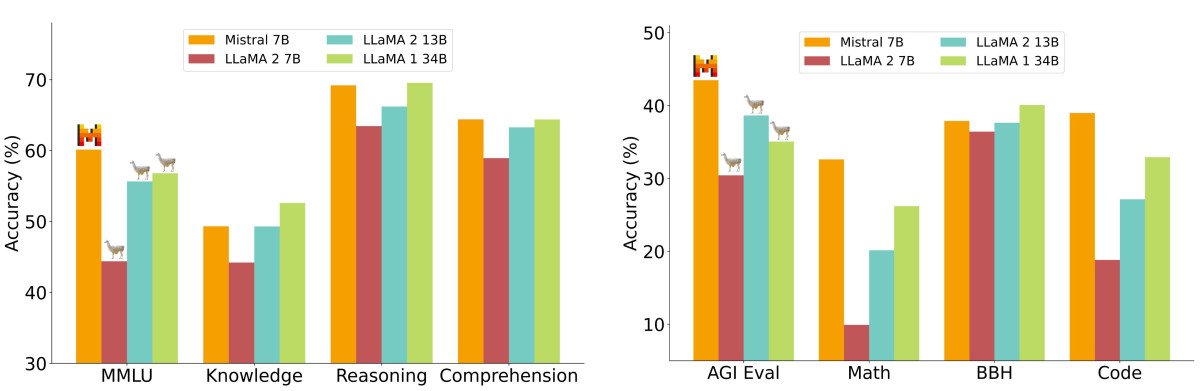

Dans une analyse détaillée des performances, le Mistral 7B a été mesuré par rapport aux modèles de la famille Llama 2. Les résultats étaient clairs : le Mistral 7B a largement surpassé le Llama 2 13B dans tous les critères. En fait, il correspondait aux performances de Llama 34B, se démarquant particulièrement dans les tests de code et de raisonnement.

Les critères ont été organisés en plusieurs catégories, telles que le raisonnement de bon sens, la connaissance du monde, la compréhension écrite, les mathématiques et le code, entre autres. Une observation particulièrement remarquable a été la mesure coût-performance du Mistral 7B, appelée « tailles de modèles équivalentes ». Dans des domaines tels que le raisonnement et la compréhension, Mistral 7B a démontré des performances similaires à celles d'un modèle Llama 2 trois fois plus grand, ce qui signifie des économies potentielles de mémoire et une augmentation du débit. Cependant, dans les tests de connaissances, Mistral 7B s'alignait étroitement avec Llama 2 13B, ce qui est probablement attribué aux limitations de ses paramètres affectant la compression des connaissances.

Qu'est-ce qui rend le modèle Mistral 7B vraiment meilleur que la plupart des autres modèles de langage ?

Simplifier les mécanismes d'attention

Bien que les subtilités des mécanismes d’attention soient techniques, leur idée fondamentale est relativement simple. Imaginez-vous en train de lire un livre et de surligner des phrases importantes ; cela est analogue à la façon dont les mécanismes d’attention « mettent en évidence » ou accordent de l’importance à des points de données spécifiques dans une séquence.

Dans le contexte des modèles de langage, ces mécanismes permettent au modèle de se concentrer sur les parties les plus pertinentes des données d'entrée, garantissant ainsi que la sortie est cohérente et contextuellement précise.

Dans les transformateurs standards, les scores d'attention sont calculés avec la formule :

La formule de ces scores implique une étape cruciale : la multiplication matricielle de Q et K. Le défi ici est qu’à mesure que la longueur de la séquence augmente, les deux matrices s’agrandissent en conséquence, conduisant à un processus de calcul intensif. Ce problème d'évolutivité est l'une des principales raisons pour lesquelles les transformateurs standards peuvent être lents, en particulier lorsqu'il s'agit de longues séquences.

Les mécanismes d'attention aident les modèles à se concentrer sur des parties spécifiques des données d'entrée. Généralement, ces mécanismes utilisent des « têtes » pour gérer cette attention. Plus vous avez de têtes, plus l’attention est spécifique, mais elle devient aussi plus complexe et plus lente. Plongez plus profondément dans les transformateurs et les mécanismes d’attention ici.

Les mécanismes d'attention aident les modèles à se concentrer sur des parties spécifiques des données d'entrée. Généralement, ces mécanismes utilisent des « têtes » pour gérer cette attention. Plus vous avez de têtes, plus l’attention est spécifique, mais elle devient aussi plus complexe et plus lente. Plongez plus profondément dans les transformateurs et les mécanismes d’attention ici.

L'attention multi-requêtes (MQA) accélère les choses en utilisant un seul ensemble de têtes « clé-valeur », mais sacrifie parfois la qualité. Maintenant, vous vous demandez peut-être pourquoi ne pas combiner la rapidité du MQA avec la qualité de l’attention multi-têtes ? C'est là qu'intervient l'attention aux requêtes groupées (GQA).

Attention aux requêtes groupées (GQA)

GQA est une solution intermédiaire. Au lieu d'utiliser un ou plusieurs en-têtes « clé-valeur », il les regroupe. De cette façon, GQA atteint une performance proche de l’attention détaillée multi-têtes mais avec la rapidité de MQA. Pour des modèles comme Mistral, cela signifie des performances efficaces sans trop compromettre la qualité.

Attention à fenêtre coulissante (SWA)

La fenêtre coulissante est une autre méthode utilisée dans le traitement des séquences d’attention. Cette méthode utilise une fenêtre d'attention de taille fixe autour de chaque jeton de la séquence. Avec plusieurs couches empilant cette attention fenêtrée, les couches supérieures finissent par acquérir une perspective plus large, englobant les informations de l'ensemble de l'entrée. Ce mécanisme est analogue aux champs récepteurs observés dans les réseaux de neurones convolutifs (CNN).

D’autre part, « l’attention de la fenêtre glissante dilatée » du modèle Longformer, qui est conceptuellement similaire à la méthode de la fenêtre glissante, ne calcule que quelques diagonales de l’objet. matrice. Ce changement entraîne une augmentation de l'utilisation de la mémoire de manière linéaire plutôt que quadratique, ce qui en fait une méthode plus efficace pour les séquences plus longues.

Problèmes de transparence et de sécurité de Mistral AI dans la décentralisation

Dans son annonce, Mistral AI a également mis l'accent sur la transparence avec la déclaration : « Pas de trucs, pas de données propriétaires ». Mais en même temps, leur seul modèle disponible pour le moment, « Mistral-7B-v0.1 », est un modèle de base pré-entraîné, il peut donc générer une réponse à n'importe quelle requête sans modération, ce qui soulève des problèmes potentiels de sécurité. Alors que des modèles comme GPT et Llama disposent de mécanismes permettant de discerner quand réagir, la nature entièrement décentralisée de Mistral pourrait être exploitée par de mauvais acteurs.

Cependant, la décentralisation des grands modèles linguistiques a ses mérites. Même si certains pourraient en abuser, les gens peuvent exploiter son pouvoir pour le bien de la société et rendre l’intelligence accessible à tous.

Flexibilité de déploiement

L'un des points forts est que Mistral 7B est disponible sous la licence Apache 2.0. Cela signifie qu'il n'y a pas de réels obstacles à son utilisation, que vous l'utilisiez à des fins personnelles, pour une grande entreprise ou même pour une entité gouvernementale. Vous avez juste besoin du bon système pour l’exécuter, ou vous devrez peut-être investir dans des ressources cloud.

Bien qu'il existe d'autres licences telles que la licence MIT plus simple et la coopérative CC BY-SA-4.0, qui imposent des crédits et des licences similaires pour les produits dérivés, Apache 2.0 fournit une base solide pour les projets à grande échelle.

Réflexions finales

L’essor des grands modèles linguistiques open source comme Mistral 7B marque un changement crucial dans l’industrie de l’IA, rendant les modèles linguistiques de haute qualité accessibles à un public plus large. Les approches innovantes de Mistral AI, telles que l'attention aux requêtes groupées et l'attention à fenêtre coulissante, promettent des performances efficaces sans compromettre la qualité.

Si la nature décentralisée de Mistral pose certains défis, sa flexibilité et ses licences open source soulignent le potentiel de démocratisation de l’IA. À mesure que le paysage évolue, l’accent sera inévitablement mis sur l’équilibre entre la puissance de ces modèles et les considérations éthiques et les mécanismes de sécurité.

La prochaine étape pour Mistral ? Le modèle 7B n’était qu’un début. L’équipe vise à lancer prochainement des modèles encore plus grands. Si ces nouveaux modèles correspondent aux performances du 7B, Mistral pourrait rapidement devenir l'un des principaux acteurs de l'industrie, et ce dès leur première année.