Intelligence Artificielle

L'IA multimodale évolue à mesure que ChatGPT gagne en visibilité avec GPT-4V(ision)

Dans le cadre des efforts continus visant à rendre l’IA plus proche des humains, les modèles GPT d’OpenAI n’ont cessé de repousser les limites. GPT-4 est désormais capable d'accepter les invites de texte et d'images.

La multimodalité dans l'IA générative dénote la capacité d'un modèle à produire des sorties variées comme du texte, des images ou de l'audio en fonction de l'entrée. Ces modèles, formés sur des données spécifiques, apprennent des modèles sous-jacents pour générer de nouvelles données similaires, enrichissant ainsi les applications d'IA.

Progrès récents dans l’IA multimodale

Une avancée notable récente dans ce domaine est constatée avec l'intégration de DALL-E 3 dans ChatGPT, une mise à niveau significative de la technologie de conversion texte-image d'OpenAI. Ce mélange permet une interaction plus fluide où ChatGPT aide à créer des invites précises pour DALL-E 3, transformant les idées des utilisateurs en un art vivant généré par l'IA. Ainsi, même si les utilisateurs peuvent interagir directement avec DALL-E 3, la présence de ChatGPT dans le mix rend le processus de création d'art IA beaucoup plus convivial.

En savoir plus sur DALL-E 3 et son intégration avec ChatGPT ici. Cette collaboration met non seulement en valeur les progrès de l’IA multimodale, mais fait également de la création artistique IA un jeu d’enfant pour les utilisateurs.

En juin dernier, Google Health a lancé Med-PaLM M, un modèle génératif multimodal capable d'encoder et d'interpréter diverses données biomédicales. Ce résultat a été obtenu en affinant PaLM-E, un modèle de langage, pour répondre aux besoins des domaines médicaux en utilisant un benchmark open source, MultiMedBench. Ce benchmark se compose de plus d'un million d'échantillons répartis sur 1 types de données biomédicales et 7 tâches telles que la réponse à des questions médicales et la génération de rapports radiologiques.

Diverses industries adoptent des outils d’IA multimodaux innovants pour alimenter l’expansion de leur entreprise, rationaliser leurs opérations et accroître l’engagement des clients. Les progrès dans les capacités de l’IA vocale, vidéo et textuelle propulsent la croissance de l’IA multimodale.

Les entreprises recherchent des applications d'IA multimodales capables de repenser leurs modèles et processus commerciaux, ouvrant ainsi des voies de croissance dans l'écosystème de l'IA générative, des outils de données aux applications d'IA émergentes.

Après le lancement de GPT-4 en mars, certains utilisateurs ont observé une baisse de la qualité de sa réponse au fil du temps, une préoccupation reprise par des développeurs notables et sur les forums d'OpenAI. Initialement rejeté par un OpenAI, un plus tard étude a confirmé le problème. Il a révélé une baisse de la précision de GPT-4 de 97.6 % à 2.4 % entre mars et juin, indiquant une baisse de la qualité des réponses avec les mises à jour ultérieures du modèle.

Le battage médiatique autour IA ouvertes ChatGPT est de retour maintenant. Il est désormais doté d'une fonction de vision GPT-4V, permettant aux utilisateurs de demander à GPT-4 d'analyser les images qu'ils ont fournies. Il s'agit de la fonctionnalité la plus récente ouverte aux utilisateurs.

L’ajout de l’analyse d’images aux grands modèles de langage (LLM) comme GPT-4 est considéré par certains comme un grand pas en avant dans la recherche et le développement de l’IA. Ce type de LLM multimodal ouvre de nouvelles possibilités, en prenant des modèles de langage au-delà du texte pour offrir de nouvelles interfaces et résoudre de nouveaux types de tâches, créant ainsi de nouvelles expériences pour les utilisateurs.

La formation de GPT-4V s'est terminée en 2022, avec un accès anticipé déployé en mars 2023. La fonctionnalité visuelle de GPT-4V est alimentée par la technologie GPT-4. Le processus de formation est resté le même. Initialement, le modèle a été entraîné pour prédire le mot suivant dans un texte à l’aide d’un ensemble de données massif de texte et d’images provenant de diverses sources, notamment Internet.

Plus tard, il a été affiné avec davantage de données, en utilisant une méthode appelée apprentissage par renforcement à partir de la rétroaction humaine (RLHF), pour générer les résultats que les humains préféraient.

Mécanique de vision GPT-4

Les remarquables capacités de langage de vision de GPT-4, bien qu'impressionnantes, reposent sur des méthodes sous-jacentes qui restent à la surface.

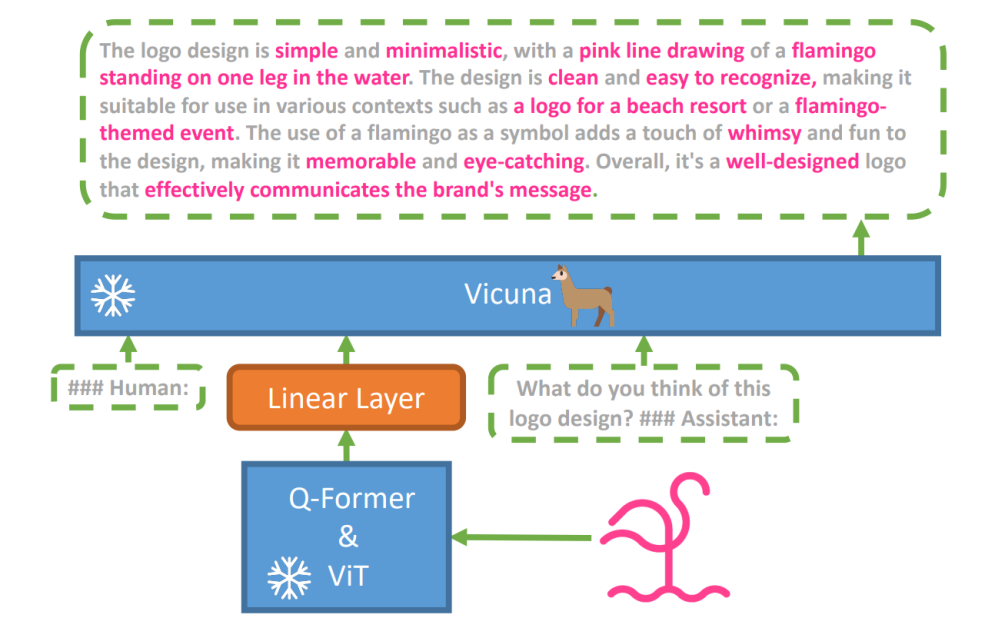

Pour explorer cette hypothèse, un nouveau modèle vision-langage, miniGPT-4 a été introduit, en utilisant un LLM avancé nommé Vicuna. Ce modèle utilise un encodeur de vision avec des composants pré-entraînés pour la perception visuelle, alignant les caractéristiques visuelles codées avec le modèle de langage Vicuna via une seule couche de projection. L'architecture de MiniGPT-4 est simple mais efficace, en mettant l'accent sur l'alignement des fonctionnalités visuelles et linguistiques pour améliorer les capacités de conversation visuelle.

L'architecture de MiniGPT-4 comprend un encodeur de vision avec ViT et Q-Former pré-entraînés, une seule couche de projection linéaire et un grand modèle de langage Vicuna avancé.

La tendance aux modèles de langage autorégressifs dans les tâches de langage visuel s'est également développée, capitalisant sur le transfert intermodal pour partager les connaissances entre les domaines linguistiques et multimodaux.

MiniGPT-4 relie les domaines visuels et linguistiques en alignant les informations visuelles d'un encodeur de vision pré-entraîné avec un LLM avancé. Le modèle utilise Vicuna comme décodeur de langage et suit une approche de formation en deux étapes. Initialement, il est formé sur un vaste ensemble de données de paires image-texte pour acquérir les connaissances vision-langage, suivi d'un réglage fin sur un ensemble de données plus petit et de haute qualité pour améliorer la fiabilité et la convivialité de la génération.

Pour améliorer le caractère naturel et la convivialité du langage généré dans MiniGPT-4, les chercheurs ont développé un processus d'alignement en deux étapes, palliant au manque d'ensembles de données adéquats d'alignement vision-langage. Ils ont organisé un ensemble de données spécialisé à cet effet.

Initialement, le modèle générait des descriptions détaillées des images d'entrée, améliorant les détails à l'aide d'une invite conversationnelle alignée sur le format du modèle de langage Vicuna. Cette étape visait à générer des descriptions d’images plus complètes.

Invite de description initiale de l’image :

###Humain: Décrivez cette image en détail. Donnez autant de détails que possible. Dites tout ce que vous voyez. ###Assistant:

Pour le post-traitement des données, toute incohérence ou erreur dans les descriptions générées a été corrigée à l'aide de ChatGPT, suivie d'une vérification manuelle pour garantir une haute qualité.

Invite de réglage fin de deuxième étape :

###Humain: ###Assistant:

Cette exploration ouvre une fenêtre sur la compréhension des mécanismes de l’IA générative multimodale comme GPT-4, mettant en lumière la façon dont les modalités de vision et de langage peuvent être efficacement intégrées pour générer des résultats cohérents et riches en contexte.

Explorer la vision GPT-4

Déterminer les origines des images avec ChatGPT

GPT-4 Vision améliore la capacité de ChatGPT à analyser les images et à identifier leurs origines géographiques. Cette fonctionnalité fait passer les interactions des utilisateurs d'un simple texte à un mélange de texte et de visuels, devenant ainsi un outil pratique pour ceux qui sont curieux de connaître différents endroits grâce aux données d'image.

Concepts mathématiques complexes

GPT-4 Vision excelle dans l’exploration d’idées mathématiques complexes en analysant des expressions graphiques ou manuscrites. Cette fonctionnalité constitue un outil utile pour les personnes cherchant à résoudre des problèmes mathématiques complexes, faisant de GPT-4 Vision une aide notable dans les domaines éducatifs et académiques.

Conversion d'une entrée manuscrite en codes LaTeX

L'une des capacités remarquables de GPT-4V est sa capacité à traduire des entrées manuscrites en codes LaTeX. Cette fonctionnalité est une aubaine pour les chercheurs, les universitaires et les étudiants qui ont souvent besoin de convertir des expressions mathématiques manuscrites ou d'autres informations techniques au format numérique. La transformation de l'écriture manuscrite en LaTeX élargit l'horizon de la numérisation des documents et simplifie le processus de rédaction technique.

Extraction des détails de la table

GPT-4V démontre ses compétences dans l'extraction de détails à partir de tableaux et dans le traitement des demandes connexes, un atout essentiel dans l'analyse des données. Les utilisateurs peuvent utiliser GPT-4V pour parcourir des tableaux, recueillir des informations clés et résoudre des questions basées sur les données, ce qui en fait un outil robuste pour les analystes de données et autres professionnels.

Comprendre le pointage visuel

La capacité unique du GPT-4V à comprendre le pointage visuel ajoute une nouvelle dimension à l'interaction de l'utilisateur. En comprenant les signaux visuels, GPT-4V peut répondre aux requêtes avec une meilleure compréhension contextuelle.

Création de sites Web simples à l'aide d'un dessin

Motivé par cela Tweet, j'ai tenté de créer une maquette pour le site unite.ai.

Même si le résultat ne correspondait pas tout à fait à ma vision initiale, voici le résultat que j'ai obtenu.

Limites et défauts de GPT-4V (sion)

Pour analyser GPT-4V, l’équipe Open AI a réalisé des évaluations qualitatives et quantitatives. Les tests qualitatifs comprenaient des tests internes et des examens d'experts externes, tandis que les tests quantitatifs mesuraient les refus et l'exactitude des modèles dans divers scénarios tels que l'identification de contenus préjudiciables, la reconnaissance démographique, les problèmes de confidentialité, la géolocalisation, la cybersécurité et les jailbreaks multimodaux.

Pourtant, le modèle n’est pas parfait.

Pour papier met en évidence les limites de GPT-4V, telles que des inférences incorrectes et du texte ou des caractères manquants dans les images. Il peut halluciner ou inventer des faits. En particulier, il n’est pas adapté à l’identification de substances dangereuses dans des images, les identifiant souvent à tort.

En imagerie médicale, le GPT-4V peut fournir des réponses incohérentes et ne connaît pas les pratiques standard, ce qui entraîne des erreurs de diagnostic potentielles.

Performances peu fiables à des fins médicales (Source)

Il ne parvient pas non plus à saisir les nuances de certains symboles de haine et peut générer un contenu inapproprié basé sur les entrées visuelles. OpenAI déconseille d'utiliser GPT-4V pour des interprétations critiques, en particulier dans des contextes médicaux ou sensibles.

Récapitulation

Créé avec Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

L'arrivée de GPT-4 Vision (GPT-4V) apporte un tas de possibilités intéressantes et de nouveaux obstacles à franchir. Avant de le déployer, de nombreux efforts ont été déployés pour garantir que les risques, notamment lorsqu'il s'agit de photos de personnes, soient bien étudiés et réduits. Il est impressionnant de voir à quel point GPT-4V s'est développé, se montrant très prometteur dans des domaines délicats comme la médecine et la science.

Aujourd’hui, de grandes questions sont sur la table. Par exemple, ces modèles devraient-ils être capables d’identifier des personnes célèbres à partir de photos ? Doivent-ils deviner le sexe, la race ou les sentiments d’une personne à partir d’une photo ? Et devrait-il y avoir des ajustements spéciaux pour aider les personnes malvoyantes ? Ces questions ouvrent une boîte de Pandore sur la vie privée, l’équité et la manière dont l’IA devrait s’intégrer dans nos vies, une question sur laquelle tout le monde devrait avoir son mot à dire.