Intelligence Artificielle

Dévaloriser les actions avec des retweets conçus de manière contradictoire

Une collaboration de recherche conjointe entre des universités américaines et IBM a formulé une preuve de concept d'attaque adverse qui est théoriquement capable de provoquer des pertes en bourse, simplement en changeant un mot dans un retweet d'une publication Twitter.

Dans une expérience, les chercheurs ont pu entraver le modèle de prédiction Stocknet avec deux méthodes : une attaque par manipulation et une attaque par concaténation. Source : https://arxiv.org/pdf/2205.01094.pdf

La surface d'attaque d'une attaque contradictoire contre les systèmes de prévision des stocks automatisés et d'apprentissage automatique est qu'un nombre croissant certains d'entre eux s'appuient sur les médias sociaux organiques comme prédicteurs de performance ; et la manipulation de ces données « dans la nature » est un processus qui peut, potentiellement, être formulé de manière fiable.

Outre Twitter, les systèmes de ce type ingèrent des données provenant, entre autres, de Reddit, StockTwits et Yahoo News. La différence entre Twitter et les autres sources réside dans le fait que les retweets sont modifiables, même si les tweets originaux ne le sont pas. En revanche, il est uniquement possible de publier des commentaires ou des publications connexes sur Reddit, ou de commenter et d'évaluer des actions considérées à juste titre comme partisanes et égoïstes par les routines et pratiques de nettoyage des données des systèmes de prédiction boursière basés sur l'apprentissage automatique.

Dans une expérience, sur le Stocknet prédiction modèle, les chercheurs ont pu provoquer des baisses notables de la prévision de la valeur des actions par deux méthodes, dont la plus efficace, l'attaque par manipulation (c'est-à-dire les retweets édités), a pu provoquer les baisses les plus sévères.

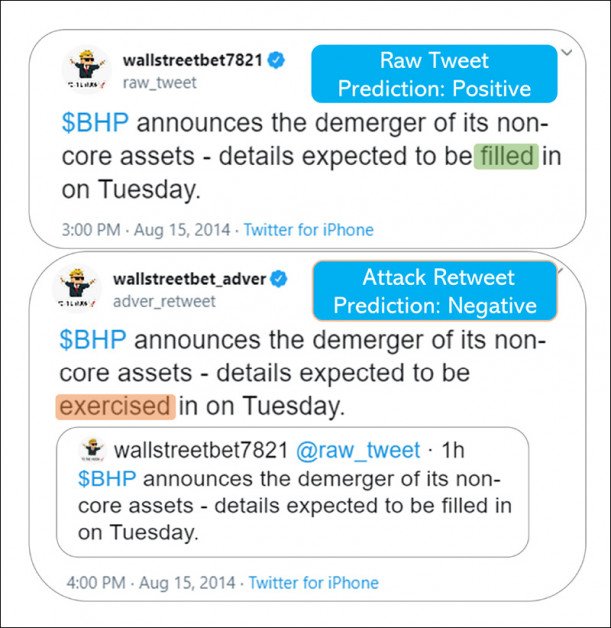

Cela a été réalisé, selon les chercheurs, en simulant une seule substitution dans un retweet provenant d'une source financière Twitter « respectée » :

Les mots comptent. Ici, la différence entre « rempli » et « exercé » (un terme qui n'est pas ouvertement malveillant ou trompeur, mais plutôt classé comme synonyme) a théoriquement coûté des milliers de dollars à un investisseur en dévaluation boursière.

Le papier déclare:

« Nos résultats montrent que la méthode d'attaque proposée peut atteindre des taux de réussite constants et entraîner des pertes monétaires importantes dans la simulation de trading en concaténant simplement un tweet perturbé mais sémantiquement similaire. »

Les chercheurs concluent :

«Ce travail démontre que notre méthode d'attaque contradictoire trompe systématiquement divers modèles de prévisions financières, même avec des contraintes physiques selon lesquelles le tweet brut ne peut pas être modifié. En ajoutant un retweet avec un seul mot remplacé, l'attaque peut entraîner une perte supplémentaire de 32 % pour notre portefeuille d'investissement simulé.

« En étudiant la vulnérabilité du modèle financier, notre objectif est de sensibiliser la communauté financière aux risques du modèle d'IA, afin qu'à l'avenir nous puissions développer une architecture d'IA plus robuste avec intervention humaine. »

Le papier est intitulé Un mot vaut mille dollars : une attaque contradictoire sur les tweets trompe les prévisions boursières, et provient de six chercheurs, originaires de l'Université de l'Illinois à Urbana-Champaign, de l'Université d'État de New York à Buffalo et de l'Université d'État du Michigan, dont trois sont affiliés à IBM.

Mots malheureux

L'article examine si le domaine bien étudié des attaques adverses sur les modèles d'apprentissage profond basés sur du texte est applicable aux modèles de prédiction du marché boursier, dont les prouesses de prévision dépendent de certains facteurs très « humains » qui ne peuvent être déduits que grossièrement à partir de sources de médias sociaux.

Comme le notent les chercheurs, le potentiel de manipulation des médias sociaux pour affecter les cours des actions a été bien démontré, mais pas encore par les méthodes proposées dans le travail ; en 2013 un tweet malveillant revendiqué par les Syriens sur le compte Twitter piraté de l'Associated Press a effacé 136 milliards de dollars de valeur boursière dans environ trois minutes.

La méthode proposée dans le nouveau travail implémente une attaque par concaténation, qui laisse le tweet original intact, tout en le citant incorrectement :

À partir du matériel supplémentaire de l'article, des exemples de retweets contenant des synonymes substitués qui modifient l'intention et la signification du message d'origine, sans le déformer réellement de manière à ce que les humains ou de simples filtres puissent attraper - mais qui peuvent exploiter les algorithmes dans les systèmes de prévision boursière.

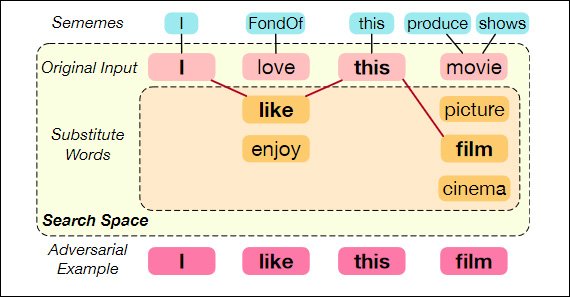

Les chercheurs ont abordé la création de retweets contradictoires comme optimisation combinatoire problème - l'élaboration d'exemples contradictoires capables de tromper un modèle de victime, même avec un vocabulaire très limité.

Substitution de mots à l'aide de sémèmes – « l’unité sémantique minimale des langues humaines ». Source : https://aclanthology.org/2020.acl-main.540.pdf

Le journal constate :

« Dans le cas de Twitter, les adversaires peuvent publier des tweets malveillants conçus pour manipuler des modèles en aval qui les prennent en entrée.

« Nous proposons d'attaquer en publiant des tweets contradictoires sémantiquement similaires sous forme de retweets sur Twitter, afin qu'ils puissent être identifiés comme des informations pertinentes et collectés comme données d'entrée du modèle. »

Pour chaque tweet d'un groupe spécialement sélectionné, les chercheurs ont résolu le problème de sélection des mots sous les contraintes des budgets de mots et de tweets, qui imposent de sévères restrictions en termes de divergence sémantique par rapport au mot original et de substitution d'un mot « malveillant/bénin ».

Les tweets contradictoires sont formulés à partir de tweets pertinents susceptibles d'être intégrés aux systèmes de prédiction boursière en aval. Ils doivent également passer sans encombre le système de modération de contenu de Twitter et ne doivent pas paraître contre-factuels aux yeux d'un observateur humain occasionnel.

Abonnements travail prioritaire (de l'Université d'État du Michigan, en collaboration avec le CSAIL, le MIT et le MIT-IBM Watson AI Lab), les mots sélectionnés dans le tweet cible sont remplacés par des synonymes provenant d'un ensemble limité de possibilités de synonymes, qui doivent tous être sémantiquement très proches du mot original, tout en conservant son « influence corruptrice », sur la base du comportement déduit des systèmes de prédiction du marché boursier.

Les algorithmes utilisés dans les expériences suivantes étaient le solveur Joint Optimization (JO) et le solveur Alternating Greedy Optimization (AGO).

Ensembles de données et expériences

Cette approche a été testée sur un ensemble de données de prédiction d'actions comprenant 10,824 88 exemples de tweets pertinents et d'informations sur les performances du marché pour XNUMX actions entre 2014-2016.

Trois modèles de « victimes » ont été choisis : Stocknet; FinGRU (un dérivé de GRU); et FinLSTM (un dérivé de LSTM).

Les mesures d'évaluation comprenaient le taux de réussite des attaques (ASR) et une baisse du modèle de victime. Score F1 après l'attaque adverse. Les chercheurs ont simulé une Achat-Conservation-Vente à long terme stratégie pour les tests. Profit and Loss (PnL) a également été calculé dans les simulations.

Résultats des expériences. Voir également le premier graphique en haut de cet article.

Sous JO et AGO, l'ASR augmente de 10 % et le score F1 du modèle diminue de 0.1 en moyenne, par rapport à une attaque aléatoire. Les chercheurs notent :

"Une telle baisse de performance est considérée comme significative dans le contexte de la prévision des actions étant donné que la précision de pointe de la prédiction du rendement interjournalier n'est que d'environ 60 %.»

Dans la tranche Profits et pertes de l'attaque (virtuelle) contre Stocknet, les résultats des retweets contradictoires ont également été remarquables :

« Pour chaque simulation, l'investisseur dispose de 10 100 $ (3.2 %) à investir ; les résultats montrent que la méthode d'attaque proposée avec un retweet avec un seul remplacement de mot peut entraîner pour l'investisseur une perte supplémentaire de 75 43 $ (2 %-XNUMX %) pour son portefeuille après environ XNUMX ans. »

Première publication le 4 mai 2022.