Des leaders d'opinion

Décoder les opportunités et les défis pour les agents LLM en IA générative

Nous assistons à une progression des applications d'IA générative alimentées par de grands modèles de langage (LLM), depuis les invites jusqu'à la génération augmentée de récupération (RAG) jusqu'aux agents. On parle beaucoup des agents dans les cercles industriels et de recherche, principalement pour la puissance que cette technologie offre pour transformer les applications d'entreprise et offrir des expériences client supérieures. Il existe des modèles courants de création d’agents qui permettent de faire les premiers pas vers l’intelligence artificielle générale (AGI).

Dans mon précédent articleNous avons vu une échelle d'intelligence des modèles pour la création d'applications LLM. Nous commençons par des invites qui capturent le domaine du problème et utilisent la mémoire interne de LLM pour générer des résultats. Avec RAG, nous enrichissons l'invite avec des connaissances externes issues d'une base de données vectorielle pour contrôler les résultats. Ensuite, en enchaînant les appels LLM, nous pouvons créer des workflows pour réaliser des applications complexes. Les agents vont plus loin en déterminant automatiquement la formation de ces chaînes LLM. Examinons cela en détail.

Agents – Sous le capot

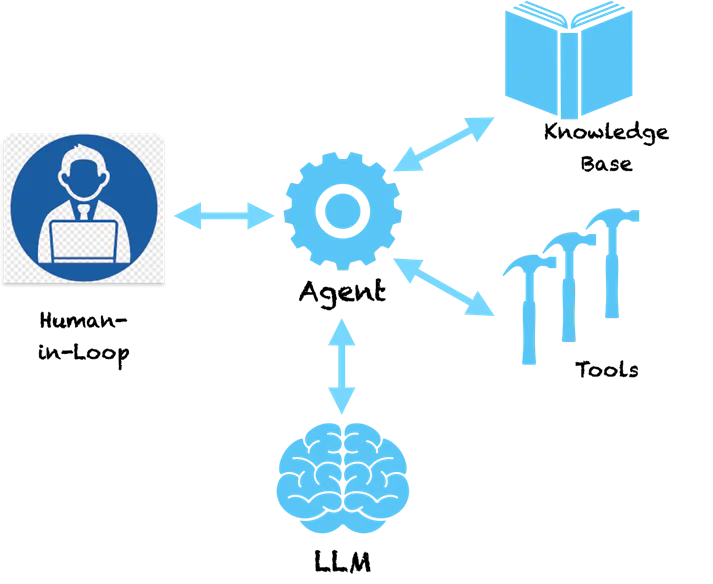

Un principe clé des agents est qu'ils utilisent la compréhension du langage du LLM pour élaborer un plan de résolution d'un problème donné. Le LLM comprend le problème et nous propose une séquence d'étapes pour le résoudre. Mais ce n'est pas tout. Les agents ne sont pas un simple système de soutien qui vous fournira des recommandations pour résoudre le problème, puis vous transmettra le relais pour que vous puissiez suivre les étapes recommandées. Ils disposent des outils nécessaires pour agir. Effrayant, non ?

Si nous posons à un agent une question fondamentale comme celle-ci :

Humain: Quelle entreprise l'inventeur du téléphone a-t-il créée ?

Voici un exemple d’étapes de réflexion qu’un agent peut suivre.

Agent (PENSANT) :

- Pensée : je dois rechercher l’inventeur du téléphone.

- Action: Recherche [inventeur du téléphone]

- Observation : Alexander Graham Bell

- Pensée : je dois rechercher une entreprise fondée par Alexander Graham Bell

- Action: Rechercher [société fondée par Alexander Graham Bell]

- Observation : Alexander Graham Bell a cofondé l'American Telephone and Telegraph Company (AT&T) en 1885.

- Pensée : j’ai trouvé la réponse. Je reviendrai.

Agent (RÉPONSE) : Alexander Graham Bell a cofondé AT&T en 1885

Vous pouvez voir que l'agent suit une manière méthodique de décomposer le problème en sous-problèmes qui peuvent être résolus en prenant des actions spécifiques. Les actions ici sont recommandées par le LLM et nous pouvons les mapper à des outils spécifiques pour mettre en œuvre ces actions. Nous pourrions activer un outil de recherche pour l'agent de telle sorte que lorsqu'il se rend compte que LLM a fourni la recherche en tant qu'action, il appellera cet outil avec les paramètres fournis par le LLM. La recherche ici se fait sur Internet mais peut également être redirigée vers une base de connaissances interne comme une base de données vectorielles. Le système devient désormais autonome et peut trouver comment résoudre des problèmes complexes en suivant une série d'étapes. Des cadres comme LangChaîne et LLaMAIndex vous offrent un moyen simple de créer ces agents et de vous connecter aux outils et à l'API. Amazon a récemment lancé son framework Bedrock Agents qui fournit une interface visuelle pour la conception d'agents.

Sous le capot, les agents suivent un style spécial d'envoi d'invites au LLM qui leur permettent de générer un plan d'action. Le modèle Pensée-Action-Observation ci-dessus est populaire dans un type d'agent appelé ReAct (Reasoning and Acting). D'autres types d'agents incluent MRKL et Plan & Execute, qui diffèrent principalement par leur style d'invite.

Pour les agents plus complexes, les actions peuvent être liées à des outils qui entraînent des modifications dans les systèmes sources. Par exemple, nous pourrions connecter l'agent à un outil qui vérifie le solde des vacances et demande des congés dans un système ERP pour un employé. Nous pourrions maintenant créer un joli chatbot qui interagirait avec les utilisateurs et, via une commande de chat, demanderait un congé dans le système. Fini les écrans complexes pour demander des congés, une interface de chat simple et unifiée. Cela semble excitant !?

Mises en garde et nécessité d’une IA responsable

Et si nous disposions d'un outil qui invoque des transactions boursières à l'aide d'une API pré-autorisée. Vous créez une application dans laquelle l'agent étudie les changements de stock (à l'aide d'outils) et prend des décisions pour vous concernant l'achat et la vente d'actions. Que se passe-t-il si l’agent vend le mauvais titre parce qu’il a halluciné et pris une mauvaise décision ? Étant donné que les LLM sont d'énormes modèles, il est difficile de déterminer pourquoi ils prennent certaines décisions. Les hallucinations sont donc courantes en l'absence de garde-fous appropriés.

Même si les agents sont tous fascinants, vous auriez probablement deviné à quel point ils peuvent être dangereux. S’ils hallucinent et prennent une mauvaise action, cela pourrait entraîner d’énormes pertes financières ou des problèmes majeurs dans les systèmes de l’entreprise. Par conséquent, l’IA responsable devient de la plus haute importance à l’ère des applications basées sur le LLM. Les principes de l'IA responsable autour de la reproductibilité, de la transparence et de la responsabilité tentent de mettre des garde-fous sur les décisions prises par les agents et suggèrent une analyse des risques pour décider quelles actions nécessitent la participation d'un humain. À mesure que des agents plus complexes sont conçus, ils nécessitent davantage de contrôle, de transparence et de responsabilité pour garantir que nous sachions ce qu’ils font.

Pensées de clôture

La capacité des agents à générer un chemin d'étapes logiques avec des actions les rapproche vraiment du raisonnement humain. Leur donner des outils plus puissants peut leur donner des super pouvoirs. Des modèles comme ReAct tentent d'imiter la façon dont les humains résolvent le problème et nous verrons de meilleurs modèles d'agents qui seront pertinents pour des contextes et des domaines spécifiques (banque, assurance, santé, industrie, etc.). L’avenir est là et la technologie derrière les agents est prête à être utilisée. Dans le même temps, nous devons garder une attention particulière aux garde-fous en matière d’IA responsable pour nous assurer que nous ne construisons pas Skynet !