Intelligence Artificielle

Création d'un modèle de langage de style GPT pour une seule question

Des chercheurs chinois ont développé une méthode économique pour créer des systèmes de traitement du langage naturel de type GPT-3 tout en évitant les dépenses de plus en plus prohibitives en temps et en argent impliquées dans la formation d'ensembles de données à volume élevé – une tendance croissante qui, autrement, menace de reléguer à terme ce secteur de l'IA. aux acteurs des FAANG et aux investisseurs de haut niveau.

Le cadre proposé s'appelle Modélisation du langage axée sur les tâches (TLM). Au lieu de former un modèle énorme et complexe sur un vaste corpus de milliards de mots et de milliers d'étiquettes et de classes, TLM forme à la place un modèle beaucoup plus petit qui intègre en fait une requête directement à l'intérieur du modèle.

À gauche, une approche hyperscale typique des modèles linguistiques à volume élevé ; à droite, la méthode slimline de TLM pour explorer un grand corpus linguistique sur une base par sujet ou par question. Source : https://arxiv.org/pdf/2111.04130.pdf

En effet, un algorithme ou un modèle NLP unique est produit afin de répondre à une seule question, au lieu de créer un modèle de langage général énorme et peu maniable qui peut répondre à une plus grande variété de questions.

En testant TLM, les chercheurs ont constaté que la nouvelle approche obtenait des résultats similaires ou meilleurs que les modèles de langage pré-entraînés tels que RoBERTa-Largeet les systèmes NLP hyperscale tels que GPT-3 d'OpenAI, TRILLION Parameter Switch Transformer de Google Modèle, Corée HyperTrèfle, AI21 Labs' Jurassic 1et Microsoft Mégatron-Turing NLG 530B.

Lors d'essais de TLM sur huit ensembles de données de classification dans quatre domaines, les auteurs ont également constaté que le système réduisait les FLOP d'entraînement (opérations en virgule flottante par seconde) requis de deux ordres de grandeur. Les chercheurs espèrent que TLM pourra « démocratiser » un secteur de plus en plus élitiste, avec des modèles de PNL si vastes qu'ils ne peuvent raisonnablement pas être installés localement et se situent, dans le cas de GPT-3, derrière cher et les API à accès limité d'OpenAI et, maintenant, Microsoft Azure.

Les auteurs déclarent que la réduction du temps de formation de deux ordres de grandeur réduit le coût de formation de plus de 1,000 8 GPU pendant une journée à seulement 48 GPU sur XNUMX heures.

Le nouveau système d’ rapport est intitulé PNL à partir de zéro sans préformation à grande échelle : un cadre simple et efficace, et vient de trois chercheurs de l'Université Tsinghua à Pékin et d'un chercheur de la société chinoise de développement d'IA Recurrent AI, Inc.

Des réponses inabordables

Le sables moins coûteux La formation de modèles linguistiques efficaces et polyvalents est de plus en plus considérée comme une « limite thermique » potentielle quant à la mesure dans laquelle une PNL performante et précise peut réellement se diffuser dans la culture.

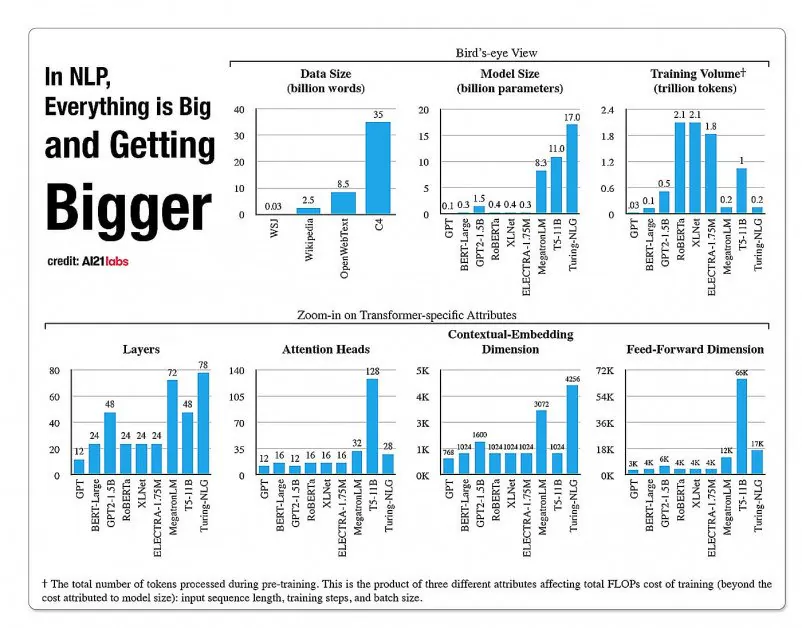

Statistiques sur la croissance des facettes dans les architectures de modèles NLP, à partir d'un rapport de 2020 par A121 Labs. Source : https://arxiv.org/pdf/2004.08900.pdf

En 2019, un chercheur calculé qu'il en coûte 61,440 XNUMX USD pour former les Modèle XLNet (rapporté à l'époque pour battre BERT dans les tâches NLP) sur 2.5 jours sur 512 cœurs sur 64 appareils, tandis que GPT-3 est estimé avoir coûté 12 millions de dollars à former - 200 fois les dépenses de formation de son prédécesseur, GPT-2 (bien que de récentes réestimations prétendent qu'il pourrait être formé maintenant pour à peine 4,600,000 $ sur les GPU cloud les moins chers) .

Sous-ensembles de données basés sur les besoins de la requête

Au lieu de cela, la nouvelle architecture proposée cherche à dériver des classifications, des étiquettes et une généralisation précises en utilisant une requête comme une sorte de filtre pour définir un sous-ensemble d'informations à partir d'une grande base de données linguistique qui sera formée, avec la requête, afin de fournir des réponses. sur un sujet limité.

Les auteurs déclarent:

«TLM est motivé par deux idées clés. Premièrement, les humains maîtrisent une tâche en n'utilisant qu'une petite partie de la connaissance du monde (par exemple, les étudiants n'ont besoin de revoir que quelques chapitres, parmi tous les livres du monde, pour préparer un examen).

Nous émettons l'hypothèse qu'il existe une forte redondance dans le vaste corpus pour une tâche spécifique. Deuxièmement, l'apprentissage sur des données étiquetées supervisées est bien plus efficace en termes de performances en aval que l'optimisation de l'objectif de modélisation du langage sur des données non étiquetées. Sur la base de ces motivations, TLM utilise les données de la tâche comme requêtes pour extraire un petit sous-ensemble du corpus général. Cette opération est suivie de l'optimisation conjointe d'un objectif de tâche supervisée et d'un objectif de modélisation du langage en utilisant à la fois les données extraites et les données de la tâche.

En plus de rendre abordable une formation très efficace sur les modèles de PNL, les auteurs voient un certain nombre d'avantages à l'utilisation de modèles de PNL axés sur les tâches. D'une part, les chercheurs peuvent profiter d'une plus grande flexibilité, avec des stratégies personnalisées pour la longueur des séquences, la tokenisation, le réglage des hyperparamètres et les représentations des données.

Les chercheurs prévoient également le développement de futurs systèmes hybrides qui échangent une pré-formation limitée d'un PLM (qui n'est autrement pas prévue dans l'implémentation actuelle) contre une plus grande polyvalence et une généralisation contre les temps de formation. Ils considèrent le système comme un pas en avant pour l'avancement des méthodes de généralisation à tir zéro dans le domaine.

Tests et résultats

TLM a été testé sur des défis de classification dans huit tâches réparties sur quatre domaines - sciences biomédicales, actualités, revues et informatique. Les tâches ont été divisées en catégories à ressources élevées et à ressources faibles. Les tâches à ressources élevées comprenaient plus de 5,000 XNUMX données de tâche, telles que AGActualités et RCT, entre autres ; les tâches à faibles ressources comprenaient ChemProt et ACL-ARC, ainsi que Hyperpartisan ensemble de données de détection de nouvelles.

Les chercheurs ont développé deux ensembles de formation intitulés Corpus-BERT et Corpus-RoBERTa, ce dernier dix fois plus grand que le premier. Les expériences ont comparé des modèles de langage pré-entraînés généraux BERT (de Google) et ROBERTA (de Facebook) à la nouvelle architecture.

L'article observe que bien que TLM soit une méthode générale, et devrait être plus limitée dans sa portée et son applicabilité que des modèles de pointe plus larges et plus volumineux, elle est capable de fonctionner près des méthodes de réglage fin adaptatives au domaine.

Résultats de la comparaison des performances de TLM par rapport aux ensembles basés sur BERT et RoBERTa. Les résultats répertorient un score F1 moyen sur trois échelles d'entraînement différentes, ainsi que le nombre de paramètres, le calcul d'entraînement total (FLOP) et la taille du corpus d'entraînement.

Les auteurs concluent que le TLM est capable d'obtenir des résultats comparables ou meilleurs que les PLM, avec une réduction substantielle des FLOP nécessaires et ne nécessitant que 1/16e du corpus d'entraînement. À moyenne et grande échelle, TLM peut apparemment améliorer les performances de 0.59 et 0.24 points en moyenne, tout en réduisant la taille des données d'apprentissage de deux ordres de grandeur.

« Ces résultats confirment que le TLM est très précis et bien plus efficace que les PLM. De plus, le TLM gagne en efficacité à plus grande échelle. Cela indique que les PLM à plus grande échelle pourraient avoir été entraînés à stocker des connaissances plus générales, inutiles pour une tâche spécifique. »