Intelligence Artificielle

Matage d'image AI qui comprend les scènes

Dans le documentaire extras accompagnant la sortie DVD 2003 de Alien3 (1992), la légende des effets visuels Richard Edlund se souvient avec horreur du « combat sumo » d'extraction de matte photochimique qui a dominé le travail des effets visuels entre 1930s fin et la fin des années 1980. Edlund a décrit la nature aléatoire du processus comme une « lutte sumo », en comparaison avec les techniques numériques d'écran bleu/vert qui ont pris le dessus au début des années 1990 (et il a revenu à la métaphore depuis).

L'extraction d'un élément de premier plan (comme une personne ou un modèle de vaisseau spatial) d'un arrière-plan, de sorte que l'image découpée puisse être composée dans une plaque d'arrière-plan, était à l'origine réalisée en filmant l'objet de premier plan sur un fond bleu ou vert uniforme.

Procédés d'extraction photochimique laborieux pour un VFX tourné par ILM pour « Le Retour du Jedi » (1983). Source : https://www.youtube.com/watch?v=qwMLOjqPmbQ

Dans le métrage résultant, la couleur d'arrière-plan serait ensuite isolée chimiquement et utilisée comme modèle pour réimprimer l'objet (ou la personne) de premier plan dans un imprimante optique comme un objet « flottant » dans une cellule de film par ailleurs transparente.

Le processus était connu sous le nom de superposition de séparation des couleurs (CSO) - bien que ce terme devienne finalement plus associé au brut « Chromakey » effets vidéo dans la production télévisée à petit budget des années 1970 et 1980, qui ont été obtenus avec des moyens analogiques plutôt que chimiques ou numériques.

Une démonstration de superposition de séparation des couleurs en 1970 pour l'émission pour enfants britannique « Blue Peter ». Source : https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

Dans tous les cas, qu'il s'agisse d'éléments filmiques ou vidéo, les séquences extraites pourront ensuite être insérées dans n'importe quelle autre séquence.

Bien que Disney soit nettement plus cher et propriétaire procédé sodium-vapeur (qui a cliqué sur le jaune, en particulier, et a également été d'utiliser pour le film d'horreur d'Alfred Hitchcock de 1963 Les oiseaux) donnaient une meilleure définition et des mattes plus nettes, l'extraction photochimique restait laborieuse et peu fiable.

Le procédé d'extraction à la vapeur de sodium, propriété exclusive de Disney, nécessitait des arrière-plans proches de l'extrémité jaune du spectre. Ici, Angela Lansbury est suspendue à des câbles pendant le tournage d'une séquence enrichie d'effets visuels pour « Bedknobs and Broomsticks » (1971). Source

Au-delà du tapis numérique

Dans les années 1990, la révolution numérique a supprimé les produits chimiques, mais pas le besoin d'écrans verts. Il était désormais possible de supprimer l'arrière-plan vert (ou de n'importe quelle couleur) simplement en recherchant des pixels dans une plage de tolérance de cette couleur, dans un logiciel d'édition de pixels tel que Photoshop, et une nouvelle génération de suites de composition vidéo qui pouvaient automatiquement éliminer les fonds colorés. Presque toute la nuit, soixante ans de l'industrie de l'impression optique ont été relégués à l'histoire.

Les dix dernières années de recherche sur la vision par ordinateur accélérée par GPU font entrer l’extraction de cache dans une troisième ère, chargeant les chercheurs de développer des systèmes capables d’extraire des caches de haute qualité sans avoir besoin d’écrans verts. Rien que chez Arxiv, les articles liés aux innovations en matière d'extraction de premier plan basée sur l'apprentissage automatique sont hebdomadaires.

Nous mettre dans l'image

Ce centre d'intérêt académique et industriel pour l'extraction de l'IA a déjà eu un impact sur l'espace des consommateurs : des implémentations brutes mais réalisables nous sont familières à tous sous la forme de Zoom et Skype des filtres qui peuvent remplacer nos arrière-plans de salon par des îles tropicales, etc., lors d'appels en vidéoconférence.

Cependant, les meilleurs caches nécessitent toujours un écran vert, car Zoom noté mercredi dernier.

À gauche, un homme devant un écran vert, avec des cheveux bien extraits grâce à la fonction d'arrière-plan virtuel de Zoom. À droite, une femme devant une scène domestique normale, avec des cheveux extraits algorithmiquement, avec moins de précision et des exigences de calcul plus élevées. Source : https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A autre poste de la plate-forme Zoom Support avertit que l'extraction sans écran vert nécessite également une plus grande puissance de calcul dans l'appareil de capture.

La nécessité de le couper

Les améliorations en termes de qualité, de portabilité et d'économie de ressources pour les systèmes d'extraction de matte « dans la nature » (c'est-à-dire l'isolement des personnes sans avoir besoin d'écrans verts) sont pertinentes pour bien plus de secteurs et d'activités que les simples filtres de vidéoconférence.

Pour le développement d'ensembles de données, une meilleure reconnaissance faciale, de la tête entière et du corps entier offre la possibilité de garantir que les éléments d'arrière-plan étrangers ne soient pas intégrés dans les modèles de vision par ordinateur de sujets humains ; une isolation plus précise améliorerait considérablement segmentation sémantique techniques conçues pour distinguer et assimiler des domaines (c'est-à-dire 'chat', 'personne', 'bateau'), et améliorer VAE et transformateursystèmes de synthèse d'images basés sur des algorithmes tels que le nouveau DALL-E2; et de meilleurs algorithmes d'extraction réduiraient le besoin de manuels coûteux rotoscopie dans des pipelines VFX coûteux.

En effet, l'ascendant de multimodal Les méthodologies (généralement texte/image), où un domaine tel que « chat » est codé à la fois comme une image et avec des références textuelles associées, font déjà leur entrée dans le traitement d'images. Un exemple récent est Texte2Live architecture, qui utilise la formation multimodale (texte/image) pour créer des vidéos de, parmi une myriade d'autres possibilités, cygnes de cristal et girafes de verre.

Tapis IA sensible à la scène

De nombreuses recherches sur le maillage automatique basé sur l'IA se sont concentrées sur la reconnaissance des limites et l'évaluation des groupements basés sur les pixels à l'intérieur d'une image ou d'une image vidéo. Cependant, de nouvelles recherches en provenance de Chine proposent un pipeline d'extraction qui améliore la délimitation et la qualité de la matte en tirant parti descriptions textuelles d'une scène (une approche multimodale qui a gagné du terrain dans le secteur de la recherche en vision par ordinateur au cours des 3-4 dernières années), prétendant avoir amélioré les méthodes antérieures de plusieurs façons.

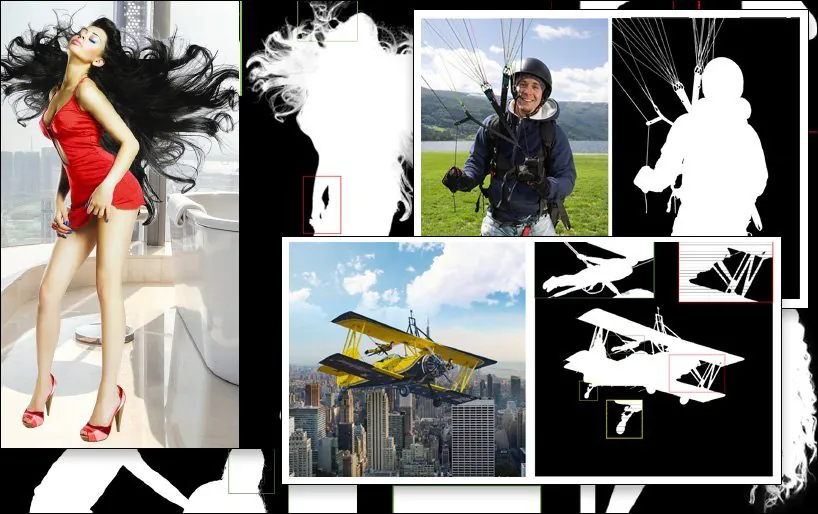

Un exemple d'extraction SPG-IM (dernière image, en bas à droite), comparée aux méthodes antérieures concurrentes. Source : https://arxiv.org/pdf/2204.09276.pdf

Le défi posé au sous-secteur de la recherche sur l'extraction est de produire des flux de travail qui nécessitent un minimum d'annotations manuelles et d'intervention humaine - idéalement, aucune. Outre les implications financières, les chercheurs du nouvel article observent que les annotations et les segmentations manuelles entreprises par des crowdworkers externalisés dans diverses cultures peuvent entraîner l'étiquetage ou même la segmentation des images de différentes manières, conduisant à des algorithmes incohérents et insatisfaisants.

Un exemple de cela est l’interprétation subjective de ce qui définit un « objet de premier plan » :

Extrait du nouvel article : méthodes antérieures LFM et MODNet (« GT » signifie Ground Truth, un résultat « idéal » souvent obtenu manuellement ou par des méthodes non algorithmiques), ont des approches différentes et plus ou moins efficaces de la définition du contenu de premier plan, tandis que la nouvelle méthode SPG-IM délimite plus efficacement le « contenu proche » à travers le contexte de la scène.

Pour résoudre ce problème, les chercheurs ont développé un pipeline en deux étapes intitulé Image guidée par perception situationnelle (SPG-IM). L'architecture d'encodeur/décodeur à deux étages comprend la distillation de la perception situationnelle (SPD) et le matage guidé par la perception situationnelle (SPGM).

Tout d'abord, SPD pré-entraîne les transformations de caractéristiques visuelles en texte, générant des légendes pertinentes pour leurs images associées. Après cela, la prédiction du masque de premier plan est activée en connectant le pipeline à un roman prédiction de saillance technique.

Ensuite, SPGM produit un cache alpha estimé basé sur l'entrée d'image RVB brute et le masque généré obtenu dans le premier module.

L'objectif est le guidage de la perception situationnelle, dans lequel le système a une compréhension contextuelle de la composition de l'image, lui permettant de cadrer - par exemple - le défi d'extraire des cheveux complexes d'un arrière-plan par rapport aux caractéristiques connues d'une tâche aussi spécifique.

Dans l'exemple ci-dessous, SPG-IM comprend que les cordes sont intrinsèques à un « parachute », et MODNet ne parvient pas à conserver ni à définir ces détails. De même, la structure complète de l'équipement de jeu est arbitrairement perdue dans MODNet.

Le nouveau système d’ papier est intitulé Image guidée par perception situationnelle, et provient de chercheurs de l'OPPO Research Institute, de PicUp.ai et de Xmotors.

Caches automatisés intelligents

SPG-IM propose également un réseau de raffinement de transformation focale adaptative (AFT) qui peut traiter les détails locaux et le contexte global séparément, facilitant ainsi les « matières intelligentes ».

Comprendre le contexte de la scène, dans ce cas « fille avec cheval », peut potentiellement rendre l'extraction du premier plan plus facile que les méthodes précédentes.

Le papier déclare:

"Nous pensons que les représentations visuelles de la tâche visuel-textuel, par exemple Sous-titrage d'images : se concentrer sur des signaux sémantiquement plus complets entre a) les objets et b) les objets et leur environnement ambiant afin de générer des descriptions couvrant à la fois les informations globales et les détails locaux. De plus, contrairement à l'annotation coûteuse des pixels du matting d'images, les étiquettes textuelles peuvent être collectées massivement à un coût très faible.

La branche SPD de l'architecture est préformée conjointement avec l'Université du Michigan VirTex Décodeur textuel basé sur un transformateur, qui apprend les représentations visuelles à partir de légendes sémantiquement denses.

VirTex forme conjointement un ConvNet et des transformateurs via des couplets de légende d'image, et transfère les informations obtenues à des tâches de vision en aval telles que la détection d'objets. Source : https://arxiv.org/pdf/2006.06666.pdf

Entre autres tests et études d'ablation, les chercheurs ont testé le SPG-IM par rapport à l'état de l'art trimapeméthodes basées sur Deep Image Matting (FAIBLE), Index Net, Tapis d'image sensible au contexte (CAM), Attention contextuelle guidée (GCA), FBA, et le mappage d'images sémantiques (OUI).

D'autres cadres antérieurs testés comprenaient des approches sans trimap LFM, HAttTapis et MODNetPour une comparaison équitable, les méthodes de test ont été adaptées en fonction des différentes méthodologies ; lorsque le code n'était pas disponible, les techniques du document ont été reproduites à partir de l'architecture décrite.

Le nouveau papier précise :

Notre SPG-IM surpasse largement toutes les méthodes concurrentes sans trimap ([LFM], [HAttMatting] et [MODNet]). Parallèlement, notre modèle affiche également une supériorité remarquable sur les méthodes de pointe (SOTA) basées sur le trimap et guidées par masque, pour les quatre métriques des jeux de données publics (Composition-1K, Distinction-646 et Human-2K), ainsi que sur notre benchmark Multi-Object-1K.

Et continue :

« On constate clairement que notre méthode préserve les détails fins (par exemple, les sites de pointes de cheveux, les textures transparentes et les limites) sans l'aide de la trimap. De plus, comparée à d'autres modèles concurrents sans trimap, notre SPG-IM conserve une meilleure complétude sémantique globale. »

Première publication le 24 avril 2022.