Tehisintellekt

UniTune: Google'i alternatiivne neuraalse pilditöötlustehnika

Tundub, et Google Research ründab tekstipõhist pilditöötlust mitmelt rindelt ja arvatavasti ootab, et näha, mis "võtab". Kuum selle nädala ilmumise järel Imagic paber, on otsingugigant välja pakkunud täiendava latentse difusioonipõhise meetodi, mis võimaldab teha piltidel tekstikäskude abil muidu võimatuid tehisintellektil põhinevaid redigeerimisi, seekord nn. UniTune.

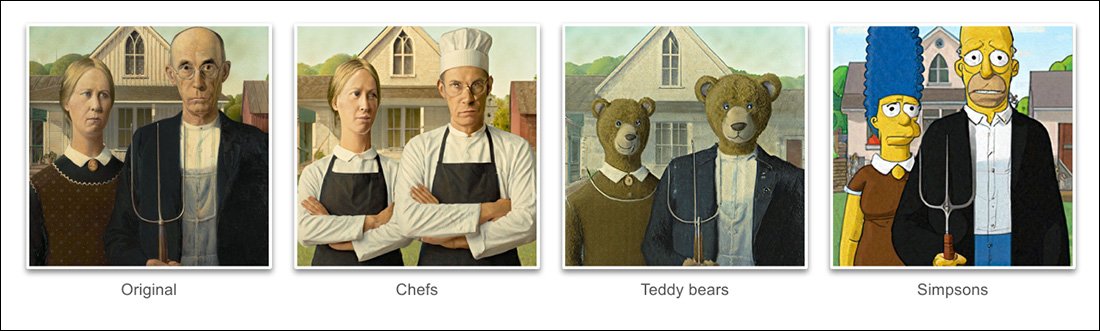

Tuginedes projektis toodud näidetele uus paber, UniTune on saavutanud erakordselt kõrge taseme lahtiharutamine semantiline poos ja idee tegelikust kõva pildi sisust:

UniTune'i semantilise kompositsiooni oskus on suurepärane. Pange tähele, et ülemises pildireas ei ole kahe inimese nägusid moonutanud ülejäänud lähtepildi erakordne teisendus (paremal). Allikas: https://arxiv.org/pdf/2210.09477.pdf

Nagu Stable Diffusioni fännid on nüüdseks õppinud, võib pildi osadele osadele muudatuste tegemine ilma ülejäänud kujutist negatiivselt muutmata olla keeruline, mõnikord võimatu toiming. Kuigi populaarsed distributsioonid nagu AUTOMAATIKA1111 saab luua maske kohalike ja piiratud muudatuste jaoks, protsess on käänuline ja sageli ettearvamatu.

Ilmselge vastus, vähemalt arvutinägemise praktikule, on asetada vahele kiht semantiline segmenteerimine mis suudab ilma kasutaja sekkumiseta pildil olevaid objekte ära tunda ja isoleerida ning viimasel ajal on selle mõttesuunaga seoses tehtud mitmeid uusi algatusi.

Teine võimalus räpane ja segaduses närvikujutise redigeerimise toimingute lukustamiseks on võimalik kasutada OpenAI mõjukat kontrastse keele ja pildi eelkoolitust (CLIP) moodul, mis on latentsete difusioonimudelite (nt DALL-E 2 ja Stable Diffusion) keskmes, et toimida filtrina kohas, kus tekstist pildiks muutev mudel on valmis tõlgendatud renderduse kasutajale tagasi saatma. . Selles kontekstis peaks CLIP toimima valvuri ja kvaliteedikontrolli moodulina, lükates tagasi valesti vormindatud või muul viisil sobimatud renderdused. See on asutamisel (Discord link) Stability.ai DreamStudio API-põhises portaalis.

Kuna aga CLIP on sellise stsenaariumi puhul vaieldamatult nii süüdlane kui ka lahendus (kuna see andis sisuliselt teavet ka pildi arendamise viisist) ja kuna riistvaranõuded võivad ületada lõppkasutajale kohapeal tõenäoliselt saadaval olevat, see lähenemine ei pruugi olla ideaalne.

Tihendatud keel

Kavandatav UniTune peenhäälestab hoopis olemasolevat difusioonimudelit – antud juhul Google’i enda Imagenit, kuigi teadlased väidavad, et meetod ühildub teiste varjatud difusiooniarhitektuuridega – nii, et sellesse süstitakse ainulaadne märk, mille saab välja kutsuda. lisades selle tekstiviipale.

Nimiväärtuses kõlab see nagu Google unistuste putka, mis on praegu Stable Diffusioni fännide ja arendajate kinnisidee, mis suudab olemasolevasse kontrollpunkti sisestada uudseid tegelasi või objekte, sageli vähem kui tunniga, tuginedes vaid käputäiele lähtepiltidele; või muidu nagu Teksti ümberpööramine, mis loob kontrollpunkti jaoks "külgkorvi" failid, mida seejärel käsitletakse nii, nagu oleksid nad algselt mudelisse õpetatud, ja saab kasutada mudeli enda tohutuid ressursse, muutes selle teksti klassifikaatorit, mille tulemuseks on pisike fail (võrreldes DreamBoothi vähemalt 2 GB kärbitud kontrollpunktid).

Tegelikult väidavad teadlased, et UniTune lükkas mõlemad need lähenemisviisid tagasi. Nad leidsid, et Textual Inversion jättis liiga palju olulisi üksikasju välja, samas kui DreamBooth "toimis halvemini ja võttis kauem aega" kui lahendus, mille peale nad lõpuks leppisid.

Sellegipoolest kasutab UniTune sama kapseldatud semantilist "metaprompt"-lähenemist nagu DreamBooth, kusjuures treenitud muudatused on kokku kutsutud koolitaja valitud ainulaadsete sõnadega, mis ei ole vastuolus ühegi terminiga, mis praegu vaevaliselt koolitatud avaliku väljalaske mudelis eksisteerib.

"Redigeerimistoimingu tegemiseks proovime peenhäälestatud mudeleid viipaga "[rare_tokens] edit_prompt" (nt "beikkpic kaks koera restoranis" või "beikkpic a minion").'

Process

Kuigi on mõistatuslik, miks peaksid Google'ilt jõudma samal nädalal kaks peaaegu identset paberit oma lõppfunktsioonide poolest, on vaatamata kahe algatuse suurele hulgale sarnasustele UniTune'i ja Imagicu vahel vähemalt üks selge erinevus – viimane kasutab pilditöötlustoimingute juhtimiseks pakkimata loomuliku keele viipasid, samas kui UniTune treenib ainulaadseid DreamBoothi stiilis märke.

Seega, kui redigeerisite rakendusega Imagic ja sooviksite seda laadi transformatsiooni läbi viia ...

UniTune'i paberist – UniTune seab end vastu Google'i lemmik konkureerivale närvide redigeerimise raamistikule SDEdit. UniTune'i tulemused on paremas servas, samas kui hinnanguline mask on näha teisel pildil vasakult.

.. Imagicus sisestaksite "kolmas isik, kes istub taustal, kui armas karvane koletis".

Samaväärne UniTune'i käsk oleks "Kutt taga kui [x]", Kus x on ükskõik milline imelik ja ainulaadne sõna, mis oli seotud karvase koletise tegelaskujuga seotud peenelt treenitud kontseptsiooniga.

Kui DreamBoothi või Textual Inversioni sisestatakse palju pilte, eesmärgiga luua sügavvõltsitud abstraktsioon, mida saab mitmetesse poosidesse käsutada, siis nii UniTune kui ka Imagic toidavad süsteemi hoopis ühe pildi – algse põlise pildi.

See sarnaneb paljude viimaste aastate GAN-põhiste redigeerimistööriistade toimimisega – teisendades sisendkujutise GAN-i varjatud ruumis varjatud koodideks ja seejärel adresseerides need koodid ja saatnud need varjatud ruumi teistesse osadesse. ruumi muutmiseks (st noore tumedajuukselise pildi sisestamine ja selle projitseerimine läbi varjatud koodide, mis on seotud 'vana' või 'blondiga' jne).

Kuid difusioonimudeli ja selle meetodi tulemused on võrdluses üllatavalt täpsed ja palju vähem mitmetähenduslikud:

Peenhäälestusprotsess

UniTune'i meetod saadab sisuliselt algse pildi difusioonmudeli kaudu koos juhistega selle muutmise kohta, kasutades mudelisse koolitatud tohutuid saadaolevate andmete hoidlaid. Tegelikult saate seda Stable Diffusion'i abil kohe teha img2img funktsionaalsust – kuid mitte ilma kõverdumiseta või mingil moel muutmata pildi osi, mida eelistaksite alles jätta.

UniTune'i protsessi käigus süsteem on hea toond, mis tähendab, et UniTune sunnib mudelit treenimist jätkama, kusjuures enamik selle kihtidest on külmutamata (vt allpool). Enamikul juhtudel muudab peenhäälestus kombinesooni tanki üldine raskesti saavutatud suure jõudlusega mudeli kahjuväärtused, mis eelistavad mõne muu aspekti süstimist või täiustamist, mida soovitakse luua või täiustada.

Kuid UniTune'i puhul näib, et mudelikoopiat, millele on tehtud toimingud, käsitletakse, kuigi see võib kaaluda mitu gigabaiti või rohkem, ühekordselt kasutatava tagatise "kestana" ja visatakse protsessi lõpus kõrvale, kuna see on teeninud ühte eesmärki. Selline juhuslik andmemaht on muutumas igapäevaseks salvestuskriisiks DreamBoothi fännidele, kelle enda mudelid on isegi kärbituna vähemalt 2 GB subjekti kohta.

Nagu ka Imagicu puhul, toimub UniTune'i põhihäälestus Imageni kolmest alumisest kahest kihist (baas 64px, 64px>256px ja 256px>1024px). Erinevalt Imagicust näevad teadlased potentsiaalset väärtust häälestuse optimeerimisel ka selle viimase ja suurima ülieraldusvõimega kihi jaoks (kuigi nad pole seda veel proovinud).

Madalaima 64 piksli suuruse kihi puhul on mudel treeningu ajal kallutatud põhikujutise poole, süsteemi sisestatakse mitu kujutise/teksti duplikaatpaari 128 iteratsiooni jaoks partii suurusega 4 ja Adafaktor kaotusfunktsioonina, mis töötab õppimiskiirusega 0.0001. Kuigi T5 kodeerija üksi on selle peenhäälestuse ajal külmutatud, see külmutatakse ka Imageni esmasel treeningul

Seejärel korratakse ülaltoodud toimingut kihi 64> 256 piksli jaoks, kasutades sama müra suurendamise protseduuri, mida kasutati Imageni algsel koolitusel.

väljavõtteline uuring

On palju võimalikke diskreetimismeetodeid, mille abil tehtud muudatusi saab peenhäälestatud mudelist esile kutsuda, sealhulgas klassifikaatorivaba juhised (CFG), mis on ka stabiilse difusiooni alustala. CFG määratleb põhimõtteliselt, mil määral võib mudel vabalt "järgida oma kujutlusvõimet" ja uurida renderdamisvõimalusi – või madalamate seadistuste korral, mil määral see peaks järgima sisendallika andmeid ja tegema vähem ulatuslikke või dramaatilisi muudatusi. .

Sarnaselt teksti inversiooniga (DreamBoothi puhul veidi vähem), on UniTune'il võimalik rakendada originaalpiltidele erinevaid graafilisi stiile, aga ka fotorealistlikumaid töötlusi.

Teadlased katsetasid ka SDEdit"hilise alguse" tehnika, kus süsteemi julgustatakse säilitama algupäraseid detaile, olles algusest peale ainult osaliselt "müra", kuid pigem säilitab selle põhiomadused. Kuigi teadlased kasutasid seda ainult madalaima kihi puhul (64 pikslit), usuvad nad, et see võib tulevikus olla kasulik täiendav proovivõtutehnika.

Teadlased kasutasid ka ära viip-viipale täiendava tekstipõhise tehnikana mudeli konditsioneerimiseks:

„Kiiba viipamiseks” seadistuses leidsime, et tehnika, mida me kutsume kiireks juhiseks, on eriti kasulik truuduse ja väljendusrikkuse häälestamiseks.

„Kiire juhis on sarnane klassifikaatorivaba juhistele, välja arvatud see, et lähtejoon on tingimusteta mudeli asemel erinev viip. See juhib mudeli kahe viipa vahelise delta suunas.

Kuid autorite sõnul oli kiiret juhendamist vaja ainult aeg-ajalt juhtudel, kui CFG ei saavutanud soovitud tulemust.

Veel üks uudne proovivõtumeetod, millega UniTune'i arendamise käigus kokku puututi, oli interpoleerimine, kus pildi alad on piisavalt erinevad, nii et nii algne kui ka muudetud kujutis on kompositsioonilt väga sarnased, võimaldades kasutada naiivsemat interpolatsiooni.

Interpoleerimine võib muuta UniTune'i suurema pingutusega protsessid üleliigseks juhtudel, kui teisendatavad alad on diskreetsed ja hästi piiritletud.

Autorid viitavad sellele, et interpoleerimine võib potentsiaalselt töötada nii hästi suure hulga sihtallika kujutiste puhul, et seda saaks kasutada vaikeseadena, ja täheldavad ka, et sellel on võim tekitada erakordseid teisendusi juhtudel, kui keerulised oklusioonid ei toimi. tuleb läbi rääkida intensiivsemate meetoditega.

UniTune saab teha kohalikke redigeerimisi redigeerimismaskidega või ilma, kuid võib ka ühepoolselt otsustada, kuhu muudatused paigutada, kasutades ebatavalist kombinatsiooni tõlgendamisvõimest ja lähtesisendandmete tugevast essentsialiseerimisest:

Teise veeru kõige ülemisel pildil on UniTune, mille ülesandeks on lisada "punane rong taustale", asetanud selle sobivasse ja autentsesse asendisse. Pange tähele teistes näidetes, kuidas lähtekujutise semantiline terviklikkus säilib isegi piltide pikslite sisu ja põhistiilide erakordsete muutuste keskel.

Hilinemine

Kuigi iga uue süsteemi esimene iteratsioon saab olema aeglane ja kuigi on võimalik, et kas kogukonna kaasamine või ettevõtte pühendumus (tavaliselt pole see mõlemad) kiirendavad ja optimeerivad ressursimahukat rutiini, teevad nii UniTune kui ka Imagic mõningaid ülesandeid. Nende hämmastavate muudatuste tegemiseks on vaja üsna suuri masinõppemanöövreid ja on küsitav, mil määral saaks sellist ressursinõudvat protsessi kunagi vähendada koduseks kasutuseks, mitte API-põhiseks juurdepääsuks (kuigi viimane võib olla Google'ile soovitavam ).

Praegu on edasi-tagasi teekond sisendist tulemuseni T3 GPU-l umbes 4 minutit ja järelduste tegemiseks kulub umbes 30 sekundit (nagu iga järeldamisrutiini puhul). Autorid tunnistavad, et see on kõrge latentsusaeg ja vaevalt kvalifitseerub interaktiivseks, kuid nad märgivad ka, et mudel jääb pärast esialgset häälestamist edasiseks muutmiseks kättesaadavaks, kuni kasutaja on protsessiga lõpetanud, mis vähendab redigeerimisaega. .

Esmakordselt avaldatud 21.