Tehisintellekt

LoReFT: Representation Finetuning for Language Models

Parameetritõhusad peenhäälestus- või PeFT-meetodid püüavad kohandada suuri keelemudeleid värskenduste kaudu väikesele arvule kaaludele. Enamik olemasolevaid tõlgendamistööd on aga näidanud, et esitused kodeerivad semantilist rikkalikku teavet, mis viitab sellele, et see võib olla parem ja võimsam alternatiiv nende esituste redigeerimiseks. Eelkoolitatud suuri mudeleid häälestatakse sageli uute domeenide või ülesannete jaoks kasutamiseks ning peenhäälestusprotsessi käigus saab üht baasmudelit kohandada paljude ülesannete jaoks isegi siis, kui domeenisiseseid andmeid on vähe. mudeli juurde. Terve mudeli peenhäälestusprotsess on aga ressursse kulukas ja kulukas, eriti oluliselt suurema suuruse ja parameetrite arvuga keelemudelite puhul.

Parameetritõhusad peenhäälestusmeetodid või PeFT meetodid pakuvad kogu mudeli peenhäälestusega seotud suurte kuludega tegelemiseks, värskendades vaid väikest osa saadaolevatest kogukaaludest. See protsess aitab vähendada treeninguaega koos mälukasutusega. Veelgi olulisem on see, et parameetrite tõhus peenhäälestus või PeFT meetodid on mitmes praktilises seades näidanud peenhäälestusega sarnast jõudlust. Adapterid, parameetritõhusate peenhäälestusmeetodite või PeFT-meetodite tavaline perekond, õpivad muudatusi, mida saab lisada täiendavale kaalude komplektile, mis töötavad koos külmutatud baasmudeliga, kuna hiljutised adapterid, nagu LoRA, vähendavad õpitud parameetrite arvu. kaaluvärskendused, kasutades adapterite treenimisel täismassi maatriksite asemel madala astme lähendusi.

Kuna varasemad tööd, mis demonstreerivad esituste redigeerimist, võivad olla parem alternatiiv parameetritõhusatele peenhäälestus- või PeFT-meetoditele, räägime selles artiklis esituse peenhäälestus- või ReFT-meetoditest, mis töötavad külmutatud mudelil, ja õpime ülesandepõhiseid. sekkumised varjatud esitustesse. Selle artikli eesmärk on käsitleda põhjalikult ReFti või esituse peenhäälestuse raamistikku ning me uurime mehhanismi, metoodikat, raamistiku arhitektuuri ja selle võrdlust nüüdisaegsete raamistikega. Nii et alustame.

ReFT: esituse peenhäälestus keelemudelite jaoks

Püüdes rakendada eelkoolitatud keelemudeleid uutele valdkondadele ja ülesannetele, viimistlevad praegused raamistikud neid eelkoolitatud keelemudeleid sageli, kuna rakendatud peenhäälestusprotsessi korral saab üht baasmudelit kohandada erinevate ülesannete jaoks isegi kui töötate väikese hulga domeenisiseste andmetega. Kuigi peenhäälestusprotsess suurendab üldist jõudlust, on see kulukas protsess, eriti kui keelemudelil on märkimisväärselt palju parameetreid. Selle probleemi lahendamiseks ja sellega seotud kulude vähendamiseks kasutage PeFT- või parameetritõhusust raamistike peenhäälestus värskendage vaid väikest osa kogukaaludest – protsess, mis mitte ainult ei vähenda treeninguaega, vaid vähendab ka mälukasutust, võimaldades PeFT-i raamistikel saavutada sarnase jõudluse, võrreldes praktiliste stsenaariumide täieliku peenhäälestusega. Adapterid, tavaline PEFT-de perekond, õpivad muudatuse, mille saab lisada täiendavale kaalukomplektile koos kaalude alamhulgaga, mis toimivad kooskõlas külmutatud kaaludega baasmudeliga. Hiljutised adapterraamistikud nagu LoRA ja QLoRA on näidanud, et täieliku täpsusega adaptereid on võimalik treenida ka vähendatud täpsusega mudelitel, ilma et see mõjutaks jõudlust. Adapterid on tavaliselt tõhusamad ja tõhusamad, kui võrrelda teiste meetoditega, mis juurutavad uusi mudelikomponente.

Praeguse tehnika taseme peamine esiletõst Parameetritõhusate peenhäälestusraamistike puhul on see, et esituste muutmise asemel muudavad nad kaalu. Tõlgendatavusega tegelevad raamistikud on aga näidanud, et esitused kodeerivad rikkalikku semantilist teavet, mis viitab sellele, et esituste redigeerimine võib kaaluvärskendustega võrreldes olla parem ja võimsam lähenemine. See eeldus, et esinduste redigeerimine on parem lähenemisviis, on see, mis moodustab ReFT või esituse peenhäälestusraamistiku aluse, mis treenib sekkumisi, selle asemel, et kohandada mudeli kaalu, võimaldades mudelil manipuleerida väikese osaga kõigist esitustest, püüdes juhtida mudeli käitumist. et lahendada järeldamisülesandeid. ReFT või Representation Peenhäälestusmeetodid on kaalupõhiste PeFT või parameetrite tõhusate peenhäälestusraamistike asendajad. ReFT-lähenemine ammutab inspiratsiooni hiljutistest mudelitest, mis töötavad suure mudeli tõlgendatavusega, mis sekkub esitustesse, et leida tõepäraseid põhjuslikke mehhanisme, ja juhib mudeli käitumist järelduste tegemisel ning seetõttu võib seda vaadelda esituse redigeerimise mudelite üldistusena. Samale tuginedes on LoReFT või madala asetusega alamruum ReFT ReFT tugev ja tõhus eksemplar ning ReFT parameetrite määramine, mis sekkub madala astme projektsioonimaatriksiga hõlmatud lineaarses ruumis peidetud esitustele ja tugineb otse DAS-ile. või hajutatud joonduse otsingu raamistik.

Edasi liikudes, vastupidiselt täielikule peenhäälestamisele, treenib PeFT või parameetrite tõhus peenhäälestuse raamistik vaid väikese osa mudeli parameetritest ja suudab kohandada mudelit allavoolu ülesannetega. Parameetritõhusa peenhäälestusraamistiku võib jagada kolme põhikategooriasse:

- Adapteripõhised meetodid: Adapteripõhised meetodid treenivad täiendavaid mooduleid, nagu täielikult ühendatud kihid külmutatud raskustega eelkoolitatud mudeli peal. Seeriaadapterid sisestavad komponendid mitmekihilise perceptroni või MLP ja LM-i või suurte mudelite tähelepanukihtide vahele, paralleeladapterid aga lisavad mooduleid olemasolevate komponentide kõrvale. Kuna adapterid lisavad uusi komponente, mida ei saa lihtsalt olemasolevate mudelite kaaludesse kokku voltida, on need järelduste tegemisel lisakoormust.

- LoRA: LoRA koos oma viimaste variantidega ligikaudselt lisaraskusi treeningu ajal kasutades madala asetusega maatriksit ja ei nõua järelduste tegemisel lisakulusid, kuna kaaluvärskendusi saab mudelisse liita ja see on põhjus, miks neid peetakse praeguseks. tugevaimad PeFT-raamistikud.

- Viipepõhised meetodid: Viipapõhised meetodid lisavad sisendisse juhuslikult initsialiseeritavad pehmed märgid ja treenivad nende manuseid, hoides samal ajal keelemudeli kaalud külmutatud. Nende meetodite pakutav jõudlus ei ole teiste PeFT-lähenemisviisidega võrreldes sageli rahuldav ja nendega kaasnevad ka märkimisväärsed üldkulud.

Kaalude värskendamise asemel õpib ReFT raamistik sekkumisi, et muuta väikest osa esindustest. Lisaks on hiljutised tööd esituse kavandamise ja aktiveerimisjuhtimise kohta näidanud, et fikseeritud juhtimisvektorite lisamine jääkvoogu võib hõlbustada teatud määral kontrolli eelkoolitatud suurte mudelite põlvkondade üle, ilma et oleks vaja ressursimahukat peenhäälestus. Teised raamistikud on näidanud, et esituste redigeerimine õpitud skaleerimis- ja tõlketoiminguga võib püüda sobitada, kuid mitte ületada LoRA-adapterite pakutavat jõudlust paljude ülesannete puhul, millel on vähem õpitud parameetreid. Lisaks on nende raamistike edu paljudes ülesannetes näidanud, et eelkoolitatud keelemudelite poolt kasutusele võetud esitused kannavad rikkalikku semantikat, kuigi nende mudelite jõudlus ei ole optimaalne, mistõttu PeFT-d jätkavad nüüdisaegse lähenemisviisina. ilma täiendava järelduskoormuseta.

ReFT : Metodoloogia ja arhitektuur

Stiili säilitamise protsessi lihtsana hoidmiseks eeldab ReFT raamistik sihtmudelina trafopõhist suurt mudelit, mis on võimeline tootma märkide jada kontekstuaalset esitust. Antud jada jaoks, millel on n arv sisendmärke, manustab ReFT raamistik need sisendmärgid esituste loendisse, mille järel m kihti arvutavad peidetud esituste loendi järjestikku eelmise peidetud esituste loendi funktsioonina. Iga peidetud esitus on vektor ja keelemudel kasutab ennustuste koostamiseks lõplikke peidetud esitusi. ReFT raamistik võtab arvesse nii maskeeritud keelemudeleid kui ka autoregressiivseid keelemudeleid. Nüüd, vastavalt lineaarse esituse hüpoteesile, on närvivõrkudes mõisted kodeeritud esituste lineaarsetes alamruumides. Hiljutised mudelid on leidnud, et see väide vastab tõele loomuliku keele ja muude sisendjaotustega koolitatud närvivõrgu mudelites.

Veelgi enam, tõlgendatavuse uuringutes kasutab juhuslik abstraktsiooniraamistik vahetussekkumisi, et määrata kindlaks närvivõrgu komponentide roll juhuslikult konkreetse käitumise rakendamisel. Vahetussekkumise taga olev loogika seisneb selles, et kui fikseeritakse esitus sellele, mis see oleks olnud kontrafaktuaalse sisendi puhul, ja see sekkumine mõjutab mudeli väljundit järjepidevalt viisil, nagu ReFT raamistiku väited tootmise eest vastutava komponendi kohta. et esitus, siis mängib komponent käitumises põhjuslikku rolli. Kuigi on olemas mõned meetodid, on hajutatud vahetussekkumine ideaalne lähenemisviis kontrollimaks, kas kontseptsioon on kodeeritud esituse lineaarsesse alamruumi, nagu väidab lineaarse esituse hüpotees. Lisaks on DAS-meetodit varem kasutatud üksuste atribuutide, sentimentide, keeleliste tunnuste ja matemaatiliste arutluste lineaarse esituse leidmiseks keelemudelites. Siiski on mitmed katsed näidanud, et DAS-meetod on väga väljendusrikas ja sellel on võime leida põhjuslikke tõhusaid alamruume isegi siis, kui trafo keelemudel on initsialiseeritud juhuslikult, ning seetõttu ei pea ta veel õppima ülesandespetsiifilisi esitusi, mille tulemuseks on arutada, kas DAS on tõlgendatavusülesannete jaoks piisavalt tõhus ja vastutustundlik.

DAS-i pakutav väljendusvõime viitab sellele, et lähenemine võib olla ideaalne vahend keelemudeli käitumise kontrollimiseks koos kontrollitava genereerimise ja vastutustundliku redigeerimisega. Seetõttu kasutab ReFT raamistik keelemudelite kohandamiseks allavoolu ülesannete jaoks hajutatud vahetussekkumise operatsiooni, et luua uus parameetrite tõhus meetod. Lisaks on ReFT-meetod sekkumiste kogum ja raamistik nõuab, et mis tahes kahe sekkumise korral, mis toimivad samal kihil, peavad sekkumispositsioonid olema mitteühendatud, kusjuures kõigi sekkumisfunktsioonide parameetrid peavad jääma sõltumatuks. Selle tulemusena on ReFT üldine raamistik, mis hõlmab sekkumisi peidetud esitustele mudeli edasisuunamise ajal.

ReFT: katsed ja tulemused

Et hinnata oma toimivust võrreldes olemasolevate PEFT-raamistikega, viib ReFT raamistik läbi katsed nelja erineva loomuliku keele töötlemise etaloniga ja hõlmab üle 20 andmekogumi, mille peamine eesmärk on anda rikkalik pilt LoReFT raamistiku toimimisest erinevates stsenaariumides. Veelgi enam, kui LoReFT-i raamistikku päriselus rakendatakse, peavad arendajad otsustama, mitu sekkumist õppida koos sisendpositsioonide ja kihtidega, millele igaüks neist rakendada. Ülesande täitmiseks häälestab ReFT raamistik neli hüperparameetrit.

- Prefiksi positsioonide arv, millesse sekkuda.

- Sufiksi positsioonide arv sekkumiseks.

- Millisesse kihtide komplekti sekkuda.

- Kas siduda sekkumisparameetrid sama kihi eri positsioonide vahel või mitte.

Seda tehes lihtsustab ReFT-i raamistik hüperparameetrite otsinguruumi ja tagab ainult fikseeritud lisajärelduskulu, mis ei skaleeru viipa pikkusega.

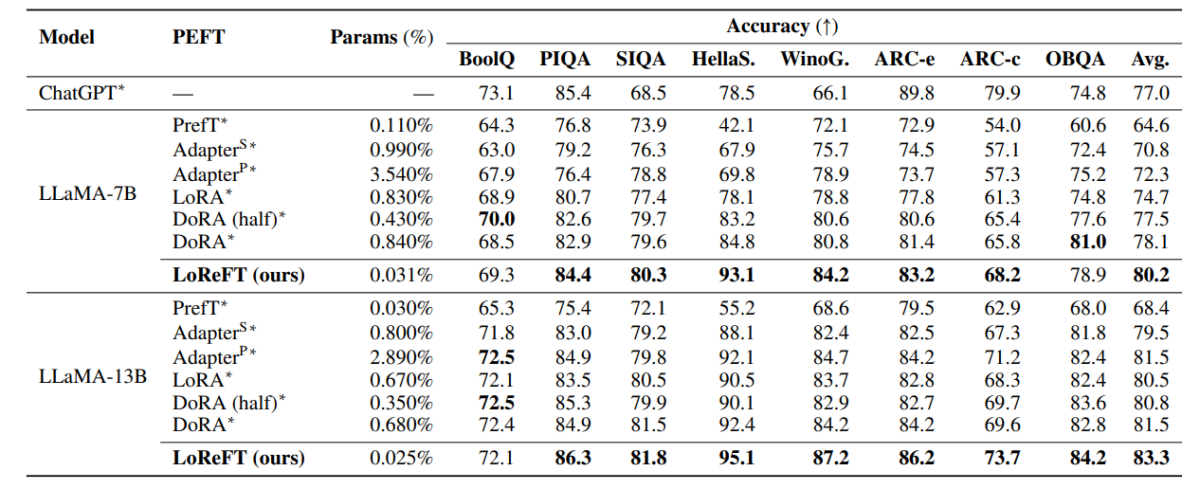

Ülaltoodud tabelis võrreldakse LLaMA-7B ja LLaMA-13B raamistike täpsust olemasolevate PEFT-mudelitega 8 terve mõistuse andmestiku ulatuses. Nagu võib täheldada, ületab LoReFT-mudel olemasolevaid PEFT-lähenemisviise korraliku marginaaliga, hoolimata sellest, et sellel on palju vähem parameetreid, kusjuures LoReFT-mudeli kolme käitamise keskmine jõudlus on esitatud erinevate parameetritega. Parameetri(%) arvutamiseks jagatakse treenitavate parameetrite arv suure baasmudeli koguparameetrite arvuga.

Ülaltoodud tabel võtab kokku LLaMA-7B ja LLaMA-13B raamistike täpsuse võrdluse olemasolevate PEFT-mudelitega nelja erineva aritmeetilise arutlusandmestiku vahel, kusjuures raamistik kajastab kolme erineva juhuslike seemnetega käitamise keskmist jõudlust. Nagu võib täheldada, edestab LoReFT raamistik, hoolimata palju vähemast parameetritest (%) olemasolevaid PEFT raamistikke märkimisväärselt.

Ülaltoodud tabel võtab kokku RoBERTa-base ja RoBERTa-large raamistike täpsuse võrdluse olemasolevate PEFT-mudelitega kogu GLUE võrdlusaluse ulatuses, kusjuures raamistik kajastab viie erinevate juhuslike seemnetega käitamise keskmist jõudlust. Nagu võib täheldada, edestab LoReFT raamistik, hoolimata palju vähemast parameetritest (%) olemasolevaid PEFT raamistikke märkimisväärselt.

Final Thoughts

Selles artiklis oleme rääkinud LoReFT-st, võimsast alternatiivist olemasolevatele PEFT-raamistikele, mis saavutab tugeva jõudluse nelja erineva valdkonna võrdlusaluste lõikes, pakkudes samal ajal kuni 50-kordset tõhusust, mida pakuvad varasemad tipptasemel PEFT-mudelid. Eelkoolitatud suuri mudeleid häälestatakse sageli uute domeenide või ülesannete jaoks kasutamiseks ning peenhäälestusprotsessi käigus saab üht baasmudelit kohandada paljude ülesannete jaoks isegi siis, kui domeenisiseseid andmeid on vähe. mudeli juurde. Terve mudeli peenhäälestusprotsess on aga ressursse kulukas ja kulukas, eriti oluliselt suurema suuruse ja parameetrite arvuga keelemudelite puhul. Parameetritõhusad peenhäälestusmeetodid või PeFT meetodid pakuvad kogu mudeli peenhäälestusega seotud suurte kuludega tegelemiseks, värskendades vaid väikest osa saadaolevatest kogukaaludest. See protsess aitab vähendada treeninguaega koos mälukasutusega. LoReFT loob uue tipptasemel jõudluse tervemõistusliku arutlemise, juhiste järgimise ja loomuliku keele mõistmise osas tugevaimate PEFTide taustal.