Inteligencia Artificial

StyleTTS 2: Texto a voz a nivel humano con modelos de lenguaje de voz de gran tamaño

Debido al aumento de los enfoques de síntesis de voz natural y sintética, uno de los principales logros que la industria de la IA ha logrado en los últimos años es sintetizar eficazmente marcos de texto a voz con aplicaciones potenciales en diferentes industrias, incluidos audiolibros, asistentes virtuales, voz. -sobre narraciones y más, con algunos modos de última generación que brindan rendimiento y eficiencia a nivel humano en una amplia gama de tareas relacionadas con el habla. Sin embargo, a pesar de su sólido desempeño, todavía hay margen de mejora para las tareas gracias al habla expresiva y diversa, la necesidad de una gran cantidad de datos de entrenamiento para optimizar los marcos de texto a voz de zero-shot y la solidez de los textos OOD o fuera de distribución. desarrolladores trabajen en un marco de texto a voz más robusto y accesible.

En este artículo, hablaremos sobre StyleTTS-2, un marco de texto a voz robusto e innovador que se basa en los cimientos del marco StyleTTS y tiene como objetivo presentar el siguiente paso hacia sistemas de texto a voz de última generación. El marco StyleTTS2 modela estilos de voz como variables aleatorias latentes y utiliza un modelo de difusión probabilística para muestrear estos estilos de voz o variables aleatorias, lo que permite que el marco StyleTTS2 sintetice discurso realista de manera efectiva sin utilizar entradas de audio de referencia. Debido a este enfoque, el marco StyleTTS2 puede ofrecer mejores resultados y muestra una alta eficiencia en comparación con los marcos de texto a voz más modernos, pero también puede aprovechar la diversa síntesis de voz que ofrecen los marcos de modelos de difusión. Discutiremos el marco StyleTTS2 con mayor detalle y hablaremos sobre su arquitectura y metodología, al mismo tiempo que veremos los resultados logrados por el marco. Entonces empecemos.

StyleTTS2 para síntesis de texto a voz: introducción

StyleTTS2 es un modelo innovador de síntesis de texto a voz que da el siguiente paso hacia la creación de marcos TTS a nivel humano y se basa en StyleTTS, un texto basado en estilos para modelo generativo del habla. El marco StyleTTS2 modela estilos de voz como variables aleatorias latentes y utiliza un modelo de difusión probabilística para muestrear estos estilos de voz o variables aleatorias, lo que permite que el marco StyleTTS2 sintetice discurso realista de manera efectiva sin utilizar entradas de audio de referencia. Modelar estilos como variables aleatorias latentes es lo que separa el marco StyleTTS2 de su predecesor, el marco StyleTTS, y tiene como objetivo generar el estilo de voz más adecuado para el texto de entrada sin necesidad de una entrada de audio de referencia, y es capaz de lograr difusiones latentes efectivas mientras se toma ventaja de las diversas capacidades de síntesis de voz que ofrece modelos de difusión. Además, el marco StyleTTS2 también emplea SLM grande o modelo de lenguaje del habla previamente entrenado como discriminadores como el marco WavLM, y lo combina con su propio enfoque novedoso de modelado de duración diferencial para entrenar el marco de un extremo a otro y, en última instancia, generar un habla con mayor naturalidad. Gracias al enfoque que sigue, el marco StyleTTS2 supera a los marcos de última generación actuales para tareas de generación de voz y es uno de los marcos más eficientes para el entrenamiento previo de modelos de voz a gran escala en configuración de disparo cero para tareas de adaptación del hablante.

A continuación, para ofrecer síntesis de texto a voz a nivel humano, el marco StyleTTs2 incorpora lo aprendido de trabajos existentes, incluidos modelos de difusión para síntesis de voz y modelos de lenguaje de voz de gran tamaño. Los modelos de difusión se utilizan generalmente para tareas de síntesis de voz gracias a sus capacidades para un control detallado del habla y diversas capacidades de muestreo de voz. Sin embargo, los modelos de difusión no son tan eficientes como los marcos no iterativos basados en GAN y una de las principales razones de esto es el requisito de muestrear representaciones latentes, formas de onda y espectrogramas de fusión de forma iterativa hasta la duración objetivo del habla.

Por otro lado, trabajos recientes sobre modelos de lenguaje de voz grandes han indicado su capacidad para mejorar la calidad de las tareas de generación de texto a voz y adaptarse bien al hablante. Los modelos de lenguaje de voz grandes generalmente convierten la entrada de texto en representaciones cuantificadas o continuas derivadas de marcos de lenguaje de voz previamente entrenados para tareas de reconstrucción de voz. Sin embargo, las características de estos modelos de lenguaje de voz no están optimizadas para la síntesis de voz directamente. Por el contrario, el marco StyleTTS2 aprovecha el conocimiento adquirido por los grandes marcos SLM que utilizan entrenamiento adversario para sintetizar las características de los modelos de lenguaje de voz sin usar mapas de espacio latente y, por lo tanto, aprende directamente un espacio latente optimizado para la síntesis de voz.

StyleTTS2: Arquitectura y Metodología

En esencia, StyleTTS2 se basa en su predecesor, el marco StyleTTS, que es un marco de texto a voz no autorregresivo que utiliza un codificador de estilo para derivar un vector de estilo a partir del audio de referencia, permitiendo así la generación de voz expresiva y natural. El vector de estilo utilizado en el marco StyleTTS se incorpora directamente al codificador, la duración y los predictores mediante el uso de AdaIN o Normalización de instancia adaptativa, lo que permite que el modelo StyleTTS genere salidas de voz con prosodia, duración e incluso emociones variables. El marco StyleTTS consta de 8 modelos en total que se dividen en tres categorías.

- Modelos Acústicos o Sistema de Generación de Voz con un codificador de estilo, un codificador de texto y un decodificador de voz.

- Un sistema de predicción de texto a voz que utiliza predictores de prosodia y duración.

- Un sistema de utilidad que incluye un alineador de texto, un extractor de tono y un discriminador con fines de capacitación.

Gracias a su enfoque, el marco StyleTTS ofrece un rendimiento de vanguardia relacionado con la síntesis de voz diversa y controlable. Sin embargo, este rendimiento tiene sus inconvenientes, como la degradación de la calidad de la muestra, limitaciones expresivas y dependencia de aplicaciones que obstaculizan el habla en tiempo real.

Mejorando el marco StyleTTS, el modelo StyleTTS2 da como resultado una expresión expresiva mejorada. texto a voz tareas con un mejor rendimiento fuera de distribución y una alta calidad a nivel humano. El marco StyleTTS2 utiliza un proceso de entrenamiento de extremo a extremo que optimiza los diferentes componentes con entrenamiento adversario y síntesis directa de formas de onda de forma conjunta. A diferencia del marco StyleTTS, el marco StyleTTS2 modela el estilo de voz como una variable latente y lo muestrea mediante modelos de difusión, generando así diversas muestras de voz sin utilizar un audio de referencia. Echemos un vistazo detallado a estos componentes.

Entrenamiento de principio a fin para la interferencia

En el marco StyleTTS2, se utiliza un enfoque de entrenamiento de extremo a extremo para optimizar varios componentes de texto a voz para detectar interferencias sin tener que depender de componentes fijos. El marco StyleTTS2 logra esto modificando el decodificador para generar la forma de onda directamente desde el vector de estilo, las curvas de tono y energía y las representaciones alineadas. Luego, el marco elimina la última capa de proyección del decodificador y la reemplaza con un decodificador de forma de onda. El marco StyleTTS2 utiliza dos codificadores: un decodificador basado en HifiGAN para generar la forma de onda directamente y un decodificador basado en iSTFT para producir fase y magnitud que se convierten en formas de onda para una interferencia y un entrenamiento más rápidos.

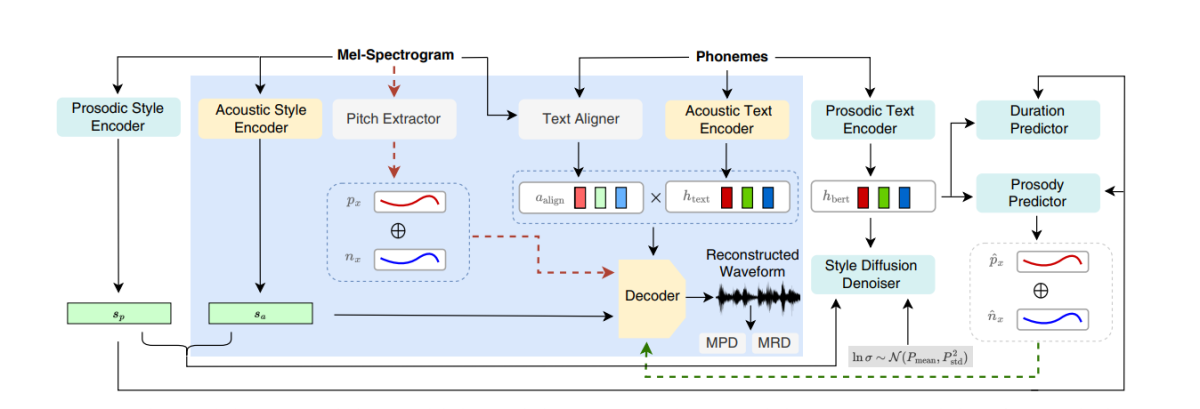

La figura anterior representa los modelos acústicos utilizados para el preentrenamiento y el entrenamiento conjunto. Para reducir el tiempo de entrenamiento, primero se optimizan los módulos en la fase de preentrenamiento y luego se optimizan todos los componentes menos el extractor de tono durante el entrenamiento conjunto. La razón por la que el entrenamiento conjunto no optimiza el extractor de tono es porque se utiliza para proporcionar la verdad básica para las curvas de tono.

La figura anterior representa el entrenamiento adversario del Modelo de Habla y Lenguaje y la interferencia con el marco WavLM previamente entrenado pero no sintonizado previamente. El proceso difiere del mencionado anteriormente porque puede tomar diferentes textos de entrada pero acumula los gradientes para actualizar los parámetros en cada lote.

Difusión de estilo

El marco StyleTTS2 tiene como objetivo modelar el habla como una distribución condicional a través de una variable latente que sigue la distribución condicional, y esta variable se llama estilo de habla generalizada y representa cualquier característica en la muestra de habla más allá del alcance de cualquier contenido fonético, incluido el estrés léxico. prosodia, velocidad del habla e incluso transiciones de formantes.

Discriminadores del modelo de habla y lenguaje

Los modelos de habla y lenguaje son reconocidos por sus habilidades generales para codificar información valiosa en una amplia gama de aspectos semánticos y acústicos, y las representaciones SLM tradicionalmente han podido imitar las percepciones humanas para evaluar la calidad del habla sintetizada generada. El marco StyleTTS2 utiliza un enfoque de entrenamiento adversario para utilizar la capacidad de los codificadores SLM para realizar tareas generativas y emplea un marco WavLM de 12 capas como discriminador. Este enfoque permite que el marco permita la capacitación sobre textos OOD o fuera de distribución que pueden ayudar a mejorar el rendimiento. Además, para evitar problemas de sobreajuste, el marco toma muestras de textos OOD y de distribución con igual probabilidad.

Modelado de duración diferenciable

Tradicionalmente, se utiliza un predictor de duración en marcos de texto a voz que produce duraciones de fonemas, pero los métodos de muestreo superior que utilizan estos predictores de duración a menudo bloquean el flujo de gradiente durante el proceso de entrenamiento E2E, y el marco NaturalSpeech emplea un muestreador basado en la atención para niveles humanos. conversión de texto a voz. Sin embargo, el marco StyleTTS2 encuentra que este enfoque es inestable durante el entrenamiento adversario porque StyleTTS2 entrena utilizando un muestreo ascendente diferenciable con diferentes entrenamientos adversarios sin la pérdida de términos adicionales debido a la falta de coincidencia en la longitud debido a las desviaciones. Aunque el uso de un enfoque de distorsión temporal suave y dinámica puede ayudar a mitigar este desajuste, usarlo no solo es costoso desde el punto de vista computacional, sino que su estabilidad también es una preocupación cuando se trabaja con objetivos adversarios o tareas de reconstrucción de fusión. Por lo tanto, para lograr un rendimiento a nivel humano con entrenamiento adversario y estabilizar el proceso de entrenamiento, el marco StyleTTC2 utiliza un enfoque de muestreo ascendente no paramétrico. El muestreo ascendente gaussiano es un enfoque popular de muestreo ascendente no paramétrico para convertir las duraciones previstas, aunque tiene sus limitaciones gracias a la longitud fija de los núcleos gaussianos predeterminada. Esta restricción para el muestreo superior gaussiano limita su capacidad para modelar con precisión alineaciones con diferentes longitudes.

Para enfrentar esta limitación, el marco StyleTTC2 propone utilizar un nuevo enfoque de muestreo ascendente no paramétrico sin ninguna capacitación adicional y capaz de tener en cuenta diferentes longitudes de las alineaciones. Para cada fonema, el marco StyleTTC2 modela la alineación como una variable aleatoria e indica el índice del marco del habla con el que se alinea el fonema.

Capacitación y evaluación de modelos

El marco StyleTTC2 se entrena y experimenta en tres conjuntos de datos: VCTK, LibriTTS y LJSpeech. El componente de un solo altavoz del marco StyleTTS2 se entrena utilizando el conjunto de datos LJSpeech que contiene aproximadamente más de 13,000 12,500 muestras de audio divididas en 100 500 muestras de entrenamiento, 24 muestras de validación y casi 44,000 muestras de prueba, con un tiempo de ejecución combinado de casi 100 horas. El componente de múltiples hablantes del marco se entrena en el conjunto de datos VCTK que consta de más de 43,500 100 clips de audio con más de 500 hablantes nativos individuales con diferentes acentos y se divide en 250 1,150 muestras de entrenamiento, XNUMX muestras de validación y casi XNUMX muestras de prueba. Finalmente, para equipar el marco con capacidades de adaptación de disparo cero, el marco se entrena en el conjunto de datos combinado de LibriTTS que consta de clips de audio que suman un total de aproximadamente XNUMX horas de audio con más de XNUMX parlantes individuales. Para evaluar su desempeño, el modelo emplea dos métricas: MOS-N o Puntuación media de opinión de naturalidad, y MUSGO o Puntuación media de opinión de similitud.

Resultados

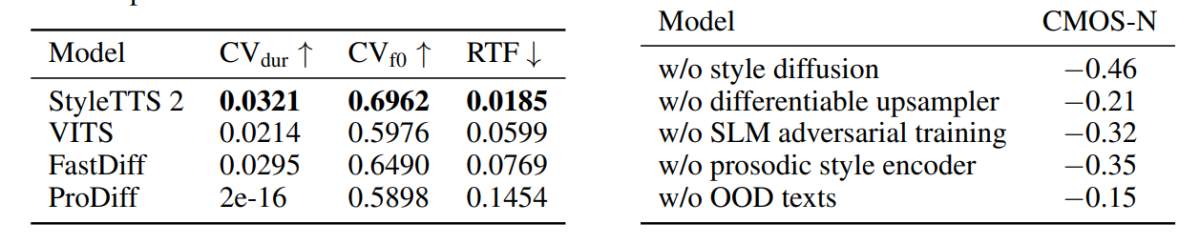

El enfoque y la metodología utilizados en el marco StyleTTS2 se muestran en su rendimiento, ya que el modelo supera a varios marcos TTS de última generación, especialmente en el conjunto de datos NaturalSpeech y en ruta, estableciendo un nuevo estándar para el conjunto de datos. Además, el marco StyleTTS2 supera al marco VITS de última generación en el conjunto de datos VCTK, y los resultados se demuestran en la siguiente figura.

El modelo StyleTTS2 también supera a los modelos anteriores en el conjunto de datos LJSpeech y no muestra ningún grado de degradación de la calidad en textos OOD o fuera de distribución como lo muestran los marcos anteriores en las mismas métricas. Además, en la configuración de disparo cero, el modelo StyleTTC2 supera al marco Vall-E existente en naturalidad, aunque se queda atrás en términos de similitud. Sin embargo, vale la pena señalar que el marco StyleTTS2 es capaz de lograr un rendimiento competitivo a pesar de entrenar solo con 245 horas de muestras de audio en comparación con más de 60 horas de entrenamiento para el marco Vall-E, lo que demuestra que StyleTTC2 es una alternativa eficiente en datos. a los grandes métodos de preentrenamiento existentes como los que se utilizan en la Vall-E.

Avanzando, debido a la falta de datos de texto de audio etiquetados con emociones, el marco StyleTTC2 utiliza el modelo GPT-4 para generar más de 500 instancias en diferentes emociones para la visualización de vectores de estilo que el marco crea usando su difusión .

En la primera figura, los estilos emocionales en respuesta a los sentimientos del texto ingresado se ilustran mediante los vectores de estilo del modelo LJSpeech y demuestra la capacidad del marco StyleTTC2 para sintetizar el habla expresiva con emociones variadas. La segunda figura muestra distintos grupos formados por cada uno de los cinco altavoces individuales, lo que representa una amplia gama de diversidad procedente de un único archivo de audio. La figura final demuestra el grupo de emociones del hablante 1 y revela que, a pesar de algunas superposiciones, los grupos basados en emociones son prominentes, lo que indica la posibilidad de manipular la melodía emocional de un hablante independientemente de la muestra de audio de referencia y su tono de entrada. . A pesar de utilizar un enfoque basado en difusión, el marco StyleTTS2 logra superar a los marcos de última generación existentes, incluidos VITS, ProDiff y FastDiff.

Conclusión

En este artículo, hemos hablado sobre StyleTTS2, un marco de texto a voz novedoso, robusto e innovador que se basa en los cimientos del marco StyleTTS y tiene como objetivo presentar el siguiente paso hacia sistemas de texto a voz de última generación. El marco StyleTTS2 modela los estilos de voz como variables aleatorias latentes y utiliza un modelo de difusión probabilística para muestrear estos estilos de voz o variables aleatorias, lo que permite que el marco StyleTTS2 sintetice discursos realistas de forma eficaz sin utilizar entradas de audio de referencia. El marco StyleTTS2 utiliza difusión de estilos y discriminadores SLM. para lograr un rendimiento a nivel humano en tareas de texto a voz y logra superar los marcos de trabajo de última generación existentes en una amplia gama de tareas de voz.