Inteligencia Artificial

Menos es más: Por qué recuperar menos documentos puede mejorar las respuestas de la IA

Recuperación-Generación Aumentada (RAG) Es un enfoque para construir sistemas de IA que combina un modelo de lenguaje con una fuente de conocimiento externa. En pocas palabras, la IA primero busca documentos relevantes (como artículos o páginas web) relacionados con la consulta del usuario y luego los utiliza para generar una respuesta más precisa. Este método ha sido reconocido por ayudar a... modelos de lenguaje grande (LLM) Mantenerse objetivo y reducir las alucinaciones basando sus respuestas en datos reales.

Intuitivamente, se podría pensar que cuantos más documentos recupere una IA, mejor informada será su respuesta. Sin embargo, investigaciones recientes sugieren un giro sorprendente: al proporcionar información a una IA, a veces menos es más.

Menos documentos, mejores respuestas

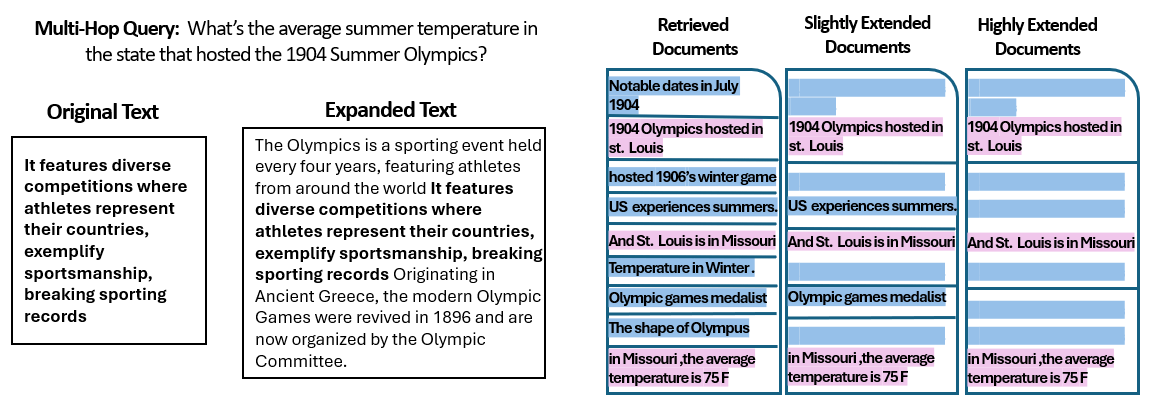

A nuevo estudio Por investigadores de la Universidad Hebrea de Jerusalén exploraron cómo la número La cantidad de documentos entregados a un sistema RAG afecta su rendimiento. Fundamentalmente, mantuvieron constante la cantidad total de texto; es decir, si se proporcionaban menos documentos, estos se expandían ligeramente para ocupar la misma longitud que muchos otros. De esta manera, cualquier diferencia de rendimiento podía atribuirse a la cantidad de documentos, en lugar de simplemente a una entrada más corta.

Los investigadores utilizaron un conjunto de datos de preguntas y respuestas (MuSiQue) con preguntas de trivia, cada una emparejada originalmente con 20 párrafos de Wikipedia (solo unos pocos contienen la respuesta, ya que el resto son distractores). Al reducir el número de documentos de 20 a solo 2-4 realmente relevantes, y añadirles contexto adicional para mantener una longitud consistente, crearon escenarios donde la IA tenía menos material que considerar, pero aún así aproximadamente la misma cantidad de palabras para leer.

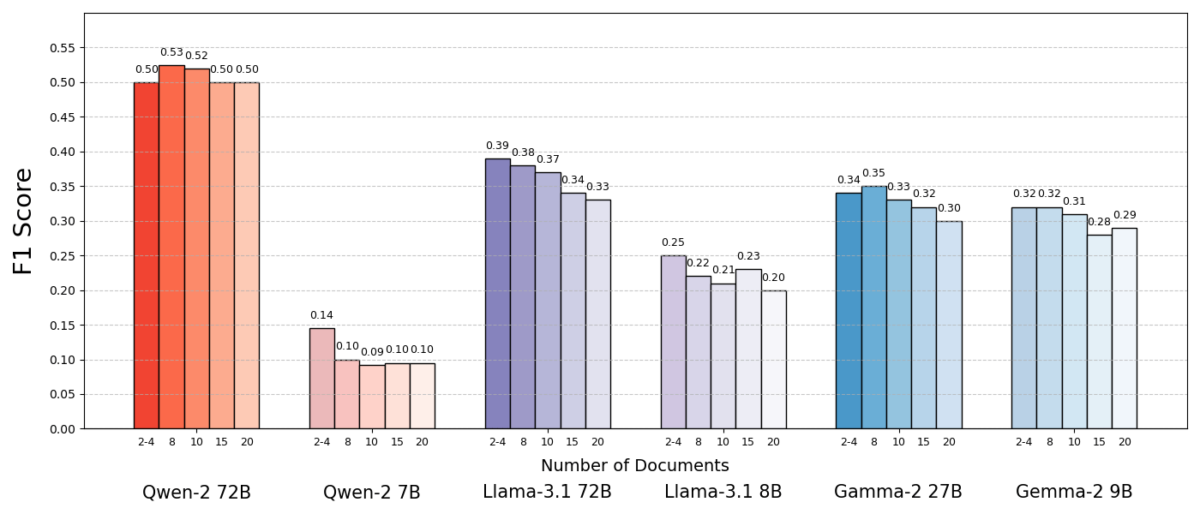

Los resultados fueron sorprendentes. En la mayoría de los casos, los modelos de IA respondieron con mayor precisión al recibir menos documentos en lugar del conjunto completo. El rendimiento mejoró significativamente, en algunos casos hasta en un 10 % de precisión (puntuación F1) cuando el sistema utilizó solo unos pocos documentos de apoyo en lugar de una gran colección. Esta mejora, contraria a la intuición, se observó en varios modelos de lenguaje de código abierto, incluyendo variantes de Llama de Meta y otros, lo que indica que el fenómeno no está ligado a un único modelo de IA.

Un modelo (Qwen-2) fue una notable excepción que gestionó varios documentos sin una disminución en la puntuación, pero casi todos los modelos probados obtuvieron mejores resultados con menos documentos en general. En otras palabras, añadir más material de referencia además de las piezas clave relevantes en realidad perjudicó su rendimiento con más frecuencia que lo benefició.

Fuente: Levy et al.

¿Por qué es tan sorprendente? Normalmente, los sistemas RAG se diseñan bajo la premisa de que recuperar una gama más amplia de información solo puede beneficiar a la IA; después de todo, si la respuesta no está en los primeros documentos, podría estar en el décimo o vigésimo.

Este estudio invierte el guion, demostrando que acumular documentos adicionales indiscriminadamente puede ser contraproducente. Incluso manteniendo constante la longitud total del texto, la mera presencia de numerosos documentos diferentes (cada uno con su propio contexto y peculiaridades) dificultó aún más la tarea de responder preguntas para la IA. Parece que, a partir de cierto punto, cada documento adicional introducía más ruido que señal, confundiendo al modelo y dificultando su capacidad para extraer la respuesta correcta.

Por qué menos puede ser más en RAG

Este resultado de "menos es más" cobra sentido al considerar cómo los modelos de lenguaje de IA procesan la información. Cuando una IA recibe solo los documentos más relevantes, el contexto que ve está enfocado y libre de distracciones, como un estudiante al que se le asignan solo las páginas adecuadas para estudiar.

En el estudio, los modelos obtuvieron resultados significativamente mejores cuando solo se les proporcionó la documentación de apoyo, eliminando el material irrelevante. El contexto restante no solo fue más breve, sino también más claro: contenía datos que apuntaban directamente a la respuesta y nada más. Con menos documentos que gestionar, el modelo pudo dedicar toda su atención a la información pertinente, lo que redujo la probabilidad de distracciones o confusiones.

Por otro lado, al recuperar muchos documentos, la IA tuvo que filtrar una mezcla de contenido relevante e irrelevante. A menudo, estos documentos adicionales eran similares pero no relacionados: podían compartir un tema o palabras clave con la consulta, pero no contener la respuesta. Este tipo de contenido puede confundir al modelo. La IA podría desperdiciar esfuerzo intentando conectar documentos que no conducen a una respuesta correcta o, peor aún, podría combinar información de múltiples fuentes incorrectamente. Esto aumenta el riesgo de alucinaciones: casos en los que la IA genera una respuesta que parece plausible, pero que no se basa en ninguna fuente.

En esencia, introducir demasiados documentos en el modelo puede diluir la información útil e introducir detalles contradictorios, lo que hace más difícil para la IA decidir qué es verdad.

Curiosamente, los investigadores descubrieron que si los documentos adicionales eran obviamente irrelevantes (por ejemplo, texto aleatorio sin relación), los modelos eran más eficaces al ignorarlos. El verdadero problema radica en datos que distraen pero que parecen relevantes: cuando todos los textos recuperados tratan temas similares, la IA asume que debería usarlos todos y puede tener dificultades para identificar qué detalles son realmente importantes. Esto concuerda con la observación del estudio de que Los distractores aleatorios causaron menos confusión que los distractores realistas En la entrada. La IA puede filtrar información sin sentido, pero la información sutilmente fuera de tema es una trampa ingeniosa: se cuela bajo la apariencia de relevancia y desvía la respuesta. Al reducir el número de documentos a solo los verdaderamente necesarios, evitamos tender estas trampas desde el principio.

También existe una ventaja práctica: recuperar y procesar menos documentos reduce la sobrecarga computacional de un sistema RAG. Cada documento que se extrae debe analizarse (integrarse, leerse y procesarse por el modelo), lo que consume tiempo y recursos computacionales. Eliminar documentos superfluos aumenta la eficiencia del sistema: puede encontrar respuestas más rápido y a menor costo. En escenarios donde la precisión mejora al centrarse en menos fuentes, obtenemos una situación beneficiosa para todos: mejores respuestas y un proceso más ágil y eficiente.

Fuente: Levy et al.

Repensando RAG: Direcciones futuras

Esta nueva evidencia de que la calidad suele superar a la cantidad en la recuperación tiene importantes implicaciones para el futuro de los sistemas de IA que se basan en conocimiento externo. Sugiere que los diseñadores de sistemas RAG deberían priorizar el filtrado y la clasificación inteligente de documentos sobre el volumen. En lugar de buscar 100 posibles pasajes y esperar que la respuesta esté escondida, sería más sensato buscar solo los más relevantes.

Los autores del estudio enfatizan la necesidad de que los métodos de recuperación logren un equilibrio entre la relevancia y la diversidad en la información que proporcionan a un modelo. En otras palabras, queremos proporcionar suficiente cobertura del tema para responder a la pregunta, pero no tanto como para que los datos principales queden ahogados en un mar de texto superfluo.

En el futuro, es probable que los investigadores exploren técnicas que ayuden a los modelos de IA a gestionar múltiples documentos con mayor fluidez. Un enfoque consiste en desarrollar mejores sistemas de recuperación o reclasificación que puedan identificar qué documentos realmente aportan valor y cuáles solo introducen conflicto. Otro enfoque es mejorar los propios modelos lingüísticos: si un modelo (como Qwen-2) lograra gestionar numerosos documentos sin perder precisión, examinar cómo se entrenó o estructuró podría ofrecer pistas para fortalecer otros modelos. Quizás los futuros modelos lingüísticos a gran escala incorporen mecanismos para reconocer cuándo dos fuentes dicen lo mismo (o se contradicen) y se enfoquen en consecuencia. El objetivo sería permitir que los modelos utilicen una amplia variedad de fuentes sin caer en la confusión, obteniendo así lo mejor de ambos mundos (amplitud de la información y claridad de enfoque).

También vale la pena señalar que, como Los sistemas de IA obtienen ventanas de contexto más grandes (la capacidad de leer más texto a la vez), simplemente añadir más datos a la instrucción no es una solución milagrosa. Un contexto más amplio no implica automáticamente una mejor comprensión. Este estudio demuestra que, incluso si una IA puede leer técnicamente 50 páginas a la vez, proporcionarle 50 páginas de información de calidad mixta puede no producir un buen resultado. El modelo se beneficia de contar con contenido relevante y seleccionado con el que trabajar, en lugar de un volcado indiscriminado. De hecho, la recuperación inteligente puede volverse aún más crucial en la era de las ventanas de contexto gigantes, para garantizar que la capacidad adicional se utilice para conocimiento valioso en lugar de para el ruido.

Los hallazgos de “Más documentos, misma longitud” (El artículo, acertadamente titulado) incentiva una reevaluación de nuestras suposiciones en la investigación de IA. A veces, alimentar a una IA con todos los datos disponibles no es tan efectivo como creemos. Al centrarnos en la información más relevante, no solo mejoramos la precisión de las respuestas generadas por la IA, sino que también hacemos que los sistemas sean más eficientes y más confiables. Es una lección contradictoria, pero con ramificaciones interesantes: los futuros sistemas RAG podrían ser más inteligentes y eficientes al seleccionar cuidadosamente menos documentos, pero de mejor calidad, para recuperar.