Τεχνητή νοημοσύνη

OLMo: Ενίσχυση της Επιστήμης των Γλωσσικών Μοντέλων

Η ανάπτυξη και η πρόοδος των γλωσσικών μοντέλων τα τελευταία χρόνια έχουν σημαδέψει την παρουσία τους σχεδόν παντού, όχι μόνο στην έρευνα NLP αλλά και σε εμπορικές προσφορές και σε πραγματικές εφαρμογές. Ωστόσο, η άνοδος της εμπορικής ζήτησης για γλωσσικά μοντέλα έχει, ως ένα βαθμό, εμποδίσει την ανάπτυξη της κοινότητας. Αυτό οφείλεται στο γεγονός ότι η πλειονότητα των μοντέλων τελευταίας τεχνολογίας και ικανών μοντέλων βρίσκονται πίσω από ιδιόκτητες διεπαφές, καθιστώντας αδύνατη την πρόσβαση της κοινότητας ανάπτυξης σε ζωτικές λεπτομέρειες της αρχιτεκτονικής, των δεδομένων και των διαδικασιών ανάπτυξης της εκπαίδευσης. Είναι πλέον αναμφισβήτητο ότι αυτή η εκπαίδευση και οι δομικές λεπτομέρειες είναι ζωτικής σημασίας για τις ερευνητικές μελέτες, συμπεριλαμβανομένης της πρόσβασης στους πιθανούς κινδύνους και τις προκαταλήψεις τους, δημιουργώντας έτσι την απαίτηση για την ερευνητική κοινότητα να έχει πρόσβαση σε ένα πραγματικά ανοιχτό και ισχυρό γλωσσικό μοντέλο.

Για να ικανοποιήσουν αυτήν την απαίτηση, οι προγραμματιστές δημιούργησαν το OLMo, ένα υπερσύγχρονο, πραγματικά ανοιχτό γλωσσικό πλαίσιο μοντέλου. Αυτό το πλαίσιο επιτρέπει στους ερευνητές να χρησιμοποιούν το OLMo για να δημιουργήσουν και να μελετήσουν μοντέλα γλώσσας. Σε αντίθεση με τα περισσότερα μοντέλα γλώσσας τελευταίας τεχνολογίας, τα οποία έχουν κυκλοφορήσει μόνο κώδικα διεπαφής και βάρη μοντέλων, το πλαίσιο OLMo είναι πραγματικά ανοιχτού κώδικα, με δημόσια προσβάσιμο κώδικα αξιολόγησης, μεθόδους εκπαίδευσης και δεδομένα εκπαίδευσης. Ο πρωταρχικός στόχος του OLMo είναι να ενδυναμώσει και να ενισχύσει την ανοιχτή ερευνητική κοινότητα και τη συνεχή ανάπτυξη γλωσσικών μοντέλων.

Σε αυτό το άρθρο, θα συζητήσουμε λεπτομερώς το πλαίσιο OLMo, εξετάζοντας την αρχιτεκτονική, τη μεθοδολογία και την απόδοσή του σε σύγκριση με τα τρέχοντα πλαίσια τελευταίας τεχνολογίας. Λοιπόν, ας ξεκινήσουμε.

OLMo: Ενίσχυση της Επιστήμης των Γλωσσικών Μοντέλων

Το γλωσσικό μοντέλο είναι αναμφισβήτητα η πιο δημοφιλής τάση τα τελευταία χρόνια, όχι μόνο στην κοινότητα AI και ML αλλά και σε ολόκληρη τη βιομηχανία τεχνολογίας, λόγω των αξιοσημείωτων δυνατοτήτων του στην εκτέλεση εργασιών στον πραγματικό κόσμο με ανθρώπινη απόδοση. Το ChatGPT είναι ένα χαρακτηριστικό παράδειγμα των πιθανών μοντέλων γλώσσας, με σημαντικούς παίκτες στον κλάδο της τεχνολογίας να εξερευνούν την ενσωμάτωση γλωσσικών μοντέλων με τα προϊόντα τους.

Το NLP, ή η Επεξεργασία Φυσικής Γλώσσας, είναι ένας από τους κλάδους που έχει χρησιμοποιήσει εκτενώς γλωσσικά μοντέλα τα τελευταία χρόνια. Ωστόσο, από τότε που η βιομηχανία άρχισε να χρησιμοποιεί ανθρώπινο σχολιασμό για ευθυγράμμιση και μεγάλης κλίμακας προεκπαίδευση, τα γλωσσικά μοντέλα έχουν γίνει μάρτυρες ταχείας ενίσχυσης της εμπορικής τους βιωσιμότητας, με αποτέλεσμα η πλειονότητα των πλαισίων γλώσσας και NLP τελευταίας τεχνολογίας να έχουν περιοριστεί ιδιόκτητες διεπαφές, με την κοινότητα ανάπτυξης να μην έχει πρόσβαση σε ζωτικές λεπτομέρειες.

Για να διασφαλιστεί η πρόοδος των γλωσσικών μοντέλων, το OLMo, ένα υπερσύγχρονο, πραγματικά ανοιχτό γλωσσικό μοντέλο, προσφέρει στους προγραμματιστές ένα πλαίσιο για να δημιουργήσουν, να μελετήσουν και να προωθήσουν την ανάπτυξη γλωσσικών μοντέλων. Παρέχει επίσης στους ερευνητές πρόσβαση στον κώδικα εκπαίδευσης και αξιολόγησης, τη μεθοδολογία εκπαίδευσης, τα δεδομένα εκπαίδευσης, τα αρχεία καταγραφής εκπαίδευσης και τα ενδιάμεσα σημεία ελέγχου μοντέλων. Τα υπάρχοντα μοντέλα τελευταίας τεχνολογίας έχουν διαφορετικούς βαθμούς διαφάνειας, ενώ το μοντέλο OLMo έχει κυκλοφορήσει ολόκληρο το πλαίσιο, από την εκπαίδευση έως τα δεδομένα και τα εργαλεία αξιολόγησης, μειώνοντας έτσι το χάσμα απόδοσης σε σύγκριση με μοντέλα τελευταίας τεχνολογίας όπως το μοντέλο LLaMA2.

Για τη μοντελοποίηση και την εκπαίδευση, το πλαίσιο OLMo περιλαμβάνει τον κώδικα εκπαίδευσης, τα πλήρη βάρη μοντέλων, τις εκτομές, τα αρχεία καταγραφής προπόνησης και τις μετρήσεις εκπαίδευσης με τη μορφή κώδικα διεπαφής, καθώς και αρχεία καταγραφής Weights & Biases. Για ανάλυση και δημιουργία δεδομένων, το πλαίσιο OLMo περιλαμβάνει τα πλήρη δεδομένα εκπαίδευσης που χρησιμοποιούνται για τα μοντέλα Dolma και WIMBD του AI2, μαζί με τον κώδικα που παράγει τα δεδομένα εκπαίδευσης. Για σκοπούς αξιολόγησης, το πλαίσιο OLMo περιλαμβάνει το μοντέλο Catwalk του AI2 για αξιολόγηση κατάντη και το μοντέλο Paloma για αξιολόγηση βάσει αμηχανίας.

OLMo : Μοντέλο και Αρχιτεκτονική

Το μοντέλο OLMo υιοθετεί μια αρχιτεκτονική μετασχηματιστή μόνο για αποκωδικοποιητή που βασίζεται στα Συστήματα Επεξεργασίας Νευρωνικών Πληροφοριών και παρέχει δύο μοντέλα με 1 δισεκατομμύριο και 7 δισεκατομμύρια παραμέτρους αντίστοιχα, με ένα μοντέλο 65 δισεκατομμυρίων παραμέτρων υπό ανάπτυξη.

Η αρχιτεκτονική του πλαισίου OLMo προσφέρει αρκετές βελτιώσεις σε σχέση με τα πλαίσια, συμπεριλαμβανομένου του στοιχείου μετασχηματιστή βανίλιας στην αρχιτεκτονική τους, συμπεριλαμβανομένης της πρόσφατης τεχνολογίας μεγάλα γλωσσικά μοντέλα όπως OpenLM, Falcon, LLaMA και PalM. Το παρακάτω σχήμα συγκρίνει το μοντέλο OLMo με 7 δισεκατομμύρια παραμέτρους με πρόσφατα LLM που λειτουργούν σε σχεδόν ίσο αριθμό παραμέτρων.

Το πλαίσιο OLMo επιλέγει τις υπερπαραμέτρους βελτιστοποιώντας το μοντέλο για την απόδοση εκπαίδευσης στο υλικό, ενώ ταυτόχρονα ελαχιστοποιεί τον κίνδυνο αργής απόκλισης και αιχμών απώλειας. Τούτου λεχθέντος, οι κύριες αλλαγές που εφαρμόζονται από το πλαίσιο OLMo που διακρίνεται από την αρχιτεκτονική του μετασχηματιστή βανίλιας είναι οι εξής:

Χωρίς προκαταλήψεις

Σε αντίθεση με τα μοντέλα Falcon, PalM, LLaMA και άλλα γλωσσικά μοντέλα, το πλαίσιο OLMo δεν περιλαμβάνει καμία προκατάληψη στην αρχιτεκτονική του για να βελτιώσει τη σταθερότητα της προπόνησης.

Κανόνας μη παραμετρικού επιπέδου

Το πλαίσιο OLMo εφαρμόζει τη μη παραμετρική διατύπωση του κανόνα στρώματος στην αρχιτεκτονική του. Το Non-Parametric Layer Norm δεν προσφέρει μετασχηματισμό συγγένειας εντός του κανόνα, δηλαδή δεν προσφέρει κανένα προσαρμοστικό κέρδος ή προκατάληψη. Το Non-Parametric Layer Norm όχι μόνο προσφέρει περισσότερη ασφάλεια από τα Parametric Layer Norms, αλλά είναι και πιο γρήγορο.

Λειτουργία ενεργοποίησης SwiGLU

Όπως η πλειονότητα των μοντέλων γλώσσας όπως η PaLM και η LLaMA, το πλαίσιο OLMo περιλαμβάνει τη συνάρτηση ενεργοποίησης SwiGLU στην αρχιτεκτονική του αντί για τη λειτουργία ενεργοποίησης ReLU και αυξάνει το κρυφό μέγεθος ενεργοποίησης στο πλησιέστερο πολλαπλάσιο του 128 για να βελτιώσει την απόδοση.

RoPE ή Rotary Position Embeddings

Τα μοντέλα OLMo ακολουθούν τα μοντέλα LLaMA και PaLM και ανταλλάσσουν τις απόλυτες ενσωματώσεις θέσης με RoPE ή Rotary Position Embeddings.

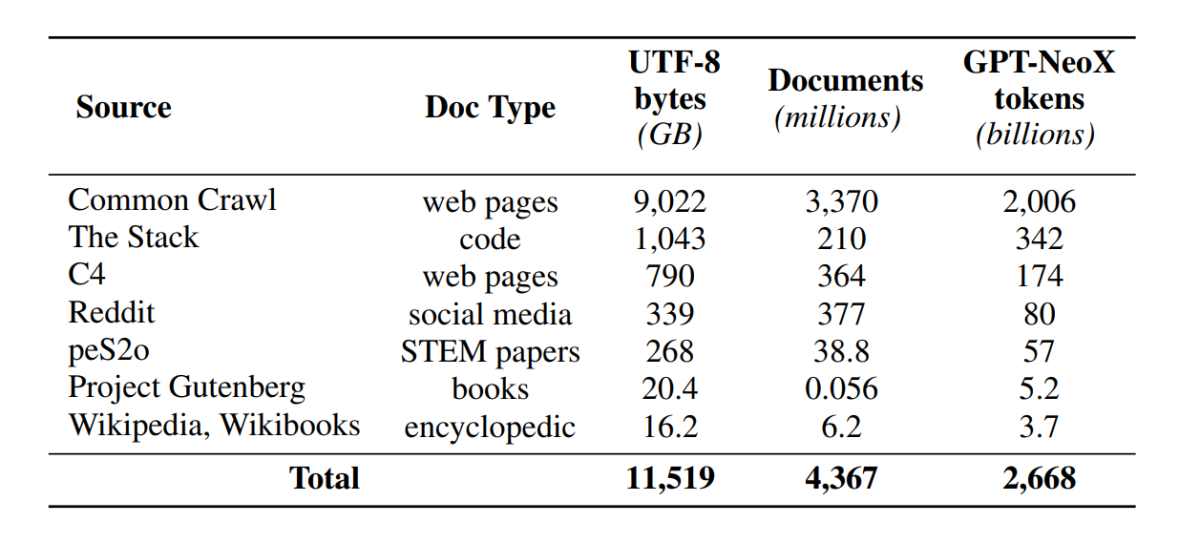

Προπόνηση με Ντολμά

Παρόλο που η κοινότητα ανάπτυξης έχει τώρα βελτιωμένη πρόσβαση στις παραμέτρους μοντέλων, οι πόρτες πρόσβασης σε σύνολα δεδομένων πριν από την εκπαίδευση παραμένουν κλειστές, καθώς τα δεδομένα προεκπαίδευσης δεν δημοσιεύονται μαζί με τα κλειστά μοντέλα ούτε παράλληλα με τα ανοιχτά μοντέλα. Επιπλέον, τα τεχνικά έγγραφα που καλύπτουν τέτοια δεδομένα συχνά στερούνται ζωτικής σημασίας λεπτομέρειες που απαιτούνται για την πλήρη κατανόηση και αναπαραγωγή του μοντέλου. Το οδόφραγμα καθιστά δύσκολη την προώθηση της έρευνας σε ορισμένα θέματα του γλωσσικό μοντέλο έρευνα, συμπεριλαμβανομένης της κατανόησης του τρόπου με τον οποίο τα δεδομένα εκπαίδευσης επηρεάζουν τις δυνατότητες και τους περιορισμούς του μοντέλου. Το πλαίσιο OLMo δημιούργησε και κυκλοφόρησε το προεκπαιδευτικό του σύνολο δεδομένων, το Dolma, για να διευκολύνει την ανοιχτή έρευνα σχετικά με την προεκπαίδευση του γλωσσικού μοντέλου. Το σύνολο δεδομένων Dolma είναι μια συλλογή πολλών πηγών και ποικίλη με περισσότερα από 3 τρισεκατομμύρια διακριτικά σε 5 δισεκατομμύρια έγγραφα που συλλέγονται από 7 διαφορετικές πηγές που χρησιμοποιούνται συνήθως από ισχυρά μεγάλης κλίμακας LLM για προεκπαίδευση και είναι προσβάσιμα στο ευρύ κοινό. Η σύνθεση του συνόλου δεδομένων Dolma συνοψίζεται στον παρακάτω πίνακα.

Το σύνολο δεδομένων Dolma δημιουργείται χρησιμοποιώντας μια διοχέτευση 5 στοιχείων: φιλτράρισμα γλώσσας, φιλτράρισμα ποιότητας, φιλτράρισμα περιεχομένου, μίξη πολλαπλών πηγών, αντιγραφή και δημιουργία διακριτικών. Η OLMo κυκλοφόρησε επίσης την αναφορά Dolma που παρέχει περισσότερες πληροφορίες για τις αρχές σχεδιασμού και τις λεπτομέρειες κατασκευής μαζί με μια πιο λεπτομερή περίληψη περιεχομένου. Το μοντέλο χρησιμοποιεί επίσης τα εργαλεία επιμέλειας δεδομένων υψηλής απόδοσης για να επιτρέψει την εύκολη και γρήγορη επιμέλεια των σωμάτων δεδομένων πριν από την εκπαίδευση. Η αξιολόγηση του μοντέλου ακολουθεί μια στρατηγική δύο σταδίων, που ξεκινά με την ηλεκτρονική αξιολόγηση για τη λήψη αποφάσεων κατά την εκπαίδευση του μοντέλου και μια τελική αξιολόγηση εκτός σύνδεσης για μια συγκεντρωτική αξιολόγηση από σημεία ελέγχου μοντέλων. Για αξιολόγηση εκτός σύνδεσης, το OLMo χρησιμοποιεί το πλαίσιο Catwalk, το δημοσίως διαθέσιμο εργαλείο αξιολόγησης που έχει πρόσβαση σε μια ευρεία ποικιλία συνόλων δεδομένων και μορφών εργασιών. Το πλαίσιο χρησιμοποιεί το Catwalk για την αξιολόγηση κατάντη καθώς και την εσωτερική αξιολόγηση μοντελοποίησης γλώσσας στο νέο μας σημείο αναφοράς περί αμηχανίας, την Paloma. Στη συνέχεια, το OLMo το συγκρίνει με διάφορα δημόσια μοντέλα χρησιμοποιώντας τη γραμμή σταθερής αξιολόγησης, τόσο για την αξιολόγηση κατάντη όσο και για την αξιολόγηση της αμηχανίας.

Το OLMo εκτελεί διάφορες μετρήσεις αξιολόγησης σχετικά με την αρχιτεκτονική του μοντέλου, την προετοιμασία, τους βελτιστοποιητές, το πρόγραμμα ρυθμών εκμάθησης και τα μείγματα δεδομένων κατά την εκπαίδευση του μοντέλου. Οι προγραμματιστές το αποκαλούν "διαδικτυακή αξιολόγηση" του OLMo, καθώς είναι μια επανάληψη εντός βρόχου σε κάθε 1000 βήματα εκπαίδευσης (ή ~4B κουπόνια εκπαίδευσης) για να δώσει ένα πρώιμο και συνεχές σήμα για την ποιότητα του μοντέλου που εκπαιδεύεται. Η ρύθμιση αυτών των αξιολογήσεων εξαρτάται από την πλειονότητα των βασικών εργασιών και ρυθμίσεων πειράματος που χρησιμοποιούνται για την αξιολόγησή μας εκτός σύνδεσης. Το OLMo στοχεύει όχι μόνο σε συγκρίσεις του OLMo-7B με άλλα μοντέλα για καλύτερη απόδοση, αλλά και να δείξει πώς επιτρέπει πληρέστερη και πιο ελεγχόμενη επιστημονική αξιολόγηση. Το OLMo-7B είναι το μεγαλύτερο μοντέλο γλώσσας με σαφή απολύμανση για αξιολόγηση αμηχανίας.

Εκπαίδευση OLMo

Είναι σημαντικό να σημειωθεί ότι τα μοντέλα του πλαισίου OLMo εκπαιδεύονται χρησιμοποιώντας τη στρατηγική βελτιστοποίησης ZeRO, η οποία παρέχεται από το πλαίσιο FSDP μέσω του PyTorch και, με αυτόν τον τρόπο, μειώνει σημαντικά την κατανάλωση μνήμης GPU κατανέμοντας τα βάρη των μοντέλων σε GPU. Με αυτό, στην κλίμακα 7B, η εκπαίδευση μπορεί να γίνει με μέγεθος μικρο-παρτίδας 4096 διακριτικών ανά GPU στο υλικό μας. Το πλαίσιο εκπαίδευσης για τα μοντέλα OLMo-1B και -7B χρησιμοποιεί ένα καθολικά σταθερό μέγεθος παρτίδας περίπου 4M διακριτικών (2048 περιπτώσεις η καθεμία με μήκος ακολουθίας 2048 διακριτικών). Για το μοντέλο OLMo-65B (που βρίσκεται αυτήν τη στιγμή σε εκπαίδευση), οι προγραμματιστές χρησιμοποιούν μια προθέρμανση μεγέθους παρτίδας που ξεκινά από περίπου 2M διακριτικά (1024 περιπτώσεις), διπλασιάζοντας κάθε 100B διακριτικά μέχρι περίπου 16M διακριτικά (8192 περιπτώσεις).

Για να βελτιώσουμε την απόδοση, χρησιμοποιούμε εκπαίδευση μεικτής ακρίβειας (Micikevicius et al., 2017) μέσω των ενσωματωμένων ρυθμίσεων του FSDP και της μονάδας ενισχυτή του PyTorch. Το τελευταίο διασφαλίζει ότι ορισμένες λειτουργίες όπως το softmax εκτελούνται πάντα με πλήρη ακρίβεια για βελτίωση της σταθερότητας, ενώ όλες οι άλλες λειτουργίες εκτελούνται με μισή ακρίβεια με τη μορφή bfloat16. Κάτω από τις συγκεκριμένες ρυθμίσεις μας, τα βάρη μοιρασμένων μοντέλων και η κατάσταση του βελτιστοποιού τοπικά σε κάθε GPU διατηρούνται με πλήρη ακρίβεια. Τα βάρη σε κάθε μπλοκ μετασχηματιστή μεταφέρονται σε μορφή bfloat16 μόνο όταν οι παράμετροι πλήρους μεγέθους υλοποιούνται σε κάθε GPU κατά τη διάρκεια των περασμάτων προς τα εμπρός και προς τα πίσω. Οι διαβαθμίσεις μειώνονται σε όλες τις GPU με πλήρη ακρίβεια.

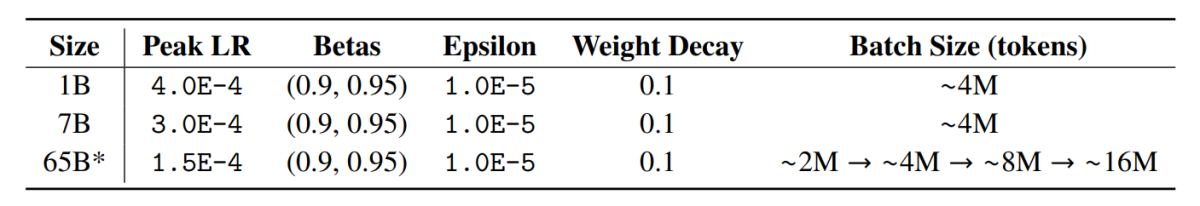

Optimizer

Το πλαίσιο OLMo χρησιμοποιεί το βελτιστοποιητή AdamW με τις ακόλουθες υπερπαραμέτρους.

Για όλα τα μεγέθη μοντέλων, ο ρυθμός εκμάθησης θερμαίνεται γραμμικά στα πρώτα 5000 βήματα (~21 B διακριτικά) σε μια μέγιστη τιμή και στη συνέχεια μειώνεται γραμμικά με την αντίστροφη τετραγωνική ρίζα του αριθμού βημάτων στον καθορισμένο ελάχιστο ρυθμό εκμάθησης. Μετά την περίοδο προθέρμανσης, το μοντέλο ψαλιδίζει τις διαβαθμίσεις έτσι ώστε η συνολική l-norm των διαβαθμίσεων παραμέτρων να μην υπερβαίνει το 1.0. Ο παρακάτω πίνακας δίνει μια σύγκριση των ρυθμίσεων του βελτιστοποιητή μας στην κλίμακα 7Β με εκείνες από άλλα πρόσφατα LM που χρησιμοποίησαν επίσης το AdamW.

Δεδομένα εκπαίδευσης

Η εκπαίδευση περιλαμβάνει το tokenizing στιγμιότυπα εκπαίδευσης με λέξη και το BPE tokenizer για το μοντέλο του κομματιού πρότασης μετά την προσθήκη ενός ειδικού διακριτικού EOS στο τέλος κάθε εγγράφου και, στη συνέχεια, ομαδοποιούμε διαδοχικά κομμάτια 2048 διακριτικών για να σχηματίσουμε στιγμιότυπα εκπαίδευσης. Οι περιπτώσεις προπόνησης ανακατεύονται με τον ίδιο ακριβώς τρόπο για κάθε διαδρομή προπόνησης. Η σειρά δεδομένων και η ακριβής σύνθεση κάθε παρτίδας εκπαίδευσης μπορούν να ανακατασκευαστούν από τα αντικείμενα που κυκλοφορούμε. Όλα τα μοντέλα OLMo που κυκλοφόρησαν έχουν εκπαιδευτεί σε τουλάχιστον 2T tokens (μία εποχή πάνω από τα δεδομένα προπόνησής τους) και μερικά εκπαιδεύτηκαν πέρα από αυτό ξεκινώντας μια δεύτερη εποχή πάνω από τα δεδομένα με διαφορετική σειρά ανακάτευσης. Δεδομένου του μικρού όγκου δεδομένων που επαναλαμβάνεται, θα πρέπει να έχει αμελητέα επίδραση.

Αποτελέσματα

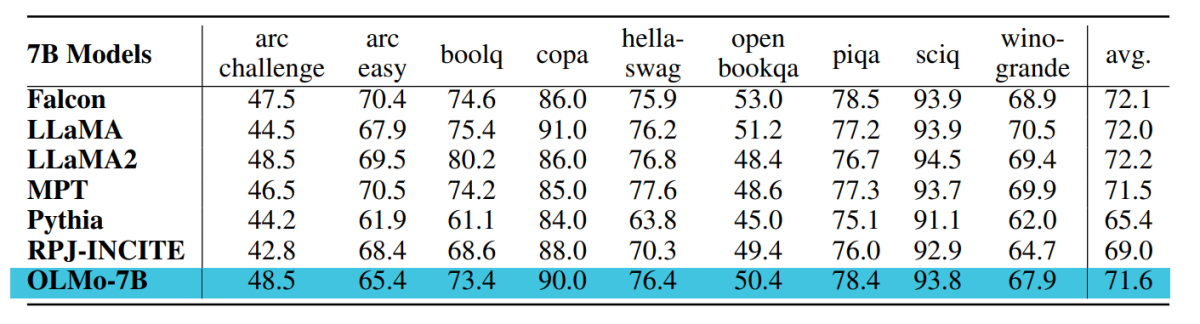

Το σημείο ελέγχου που χρησιμοποιείται για την αξιολόγηση του OLMo-7B εκπαιδεύεται έως και 2.46T token στο σύνολο δεδομένων Dolma με το γραμμικό πρόγραμμα αποσύνθεσης του ρυθμού εκμάθησης που αναφέρθηκε προηγουμένως. Ο περαιτέρω συντονισμός αυτού του σημείου ελέγχου στο σύνολο δεδομένων Dolma για 1000 βήματα με γραμμικά μειωμένο ρυθμό εκμάθησης στο 0 αυξάνει περαιτέρω την απόδοση του μοντέλου σε σουίτες αξιολόγησης αμηχανίας και τελικής εργασίας που περιγράφηκαν παραπάνω. Για την τελική αξιολόγηση, οι προγραμματιστές συνέκριναν το OLMo με άλλα διαθέσιμα στο κοινό μοντέλα – LLaMA-7B, LLaMA2-7B, Pythia-6.9B, Falcon-7B και RPJ-INCITE-7B.

Κατάντη αξιολόγηση

Η βασική σουίτα αξιολόγησης κατάντη συνοψίζεται στον παρακάτω πίνακα.

Πραγματοποιούμε αξιολόγηση μηδενικής βολής με προσέγγιση κατάταξης σε όλες τις περιπτώσεις. Σε αυτή την προσέγγιση, ο υποψήφιος συμπληρώσεις κειμένου (π.χ. διαφορετικές επιλογές πολλαπλών επιλογών) ταξινομούνται βάσει πιθανότητας (συνήθως κανονικοποιούνται από κάποιον παράγοντα κανονικοποίησης) και αναφέρεται η ακρίβεια της πρόβλεψης.

Ενώ το Catwalk χρησιμοποιεί αρκετές τυπικές μεθόδους κανονικοποίησης πιθανοφάνειας, όπως η κανονικοποίηση ανά διακριτικό και η κανονικοποίηση ανά χαρακτήρα, οι στρατηγικές κανονικοποίησης που εφαρμόζονται επιλέγονται ξεχωριστά για κάθε σύνολο δεδομένων και περιλαμβάνουν την άνευ όρων πιθανοφάνεια της απάντησης. Πιο συγκεκριμένα, αυτό δεν περιελάμβανε καμία κανονικοποίηση για τις εργασίες arc και openbookqa, κανονικοποίηση ανά διακριτικό για τις εργασίες hellaswag, piqa και winogrande, και καμία κανονικοποίηση για τις εργασίες boolq, copa και sciq (δηλαδή, εργασίες σε μια διατύπωση κοντά σε μια εργασία πρόβλεψης ενός διακριτικού).

Το παρακάτω σχήμα δείχνει την πρόοδο της βαθμολογίας ακρίβειας για τις εννέα βασικές τελικές εργασίες. Μπορεί να συναχθεί ότι υπάρχει μια γενικά αυξανόμενη τάση στον αριθμό ακρίβειας για όλες τις εργασίες, εκτός από το OBQA, καθώς το OLMo-7B εκπαιδεύεται περαιτέρω σε περισσότερα διακριτικά. Ένα απότομο ανοδικό τικ στην ακρίβεια πολλών εργασιών μεταξύ του τελευταίου και του δεύτερου έως το τελευταίο βήμα μας δείχνει το όφελος της γραμμικής μείωσης του LR στο 0 στα τελευταία 1000 βήματα προπόνησης. Για παράδειγμα, στην περίπτωση των εγγενών αξιολογήσεων, η Paloma επιχειρηματολογεί μέσω μιας σειράς αναλύσεων, από την επιθεώρηση της απόδοσης σε κάθε τομέα ξεχωριστά μέχρι πιο συνοπτικά αποτελέσματα σε συνδυασμούς τομέων. Αναφέρουμε αποτελέσματα σε δύο επίπεδα ευαισθησίας: τη συνολική απόδοση σε 11 από τις 18 πηγές στο Paloma, καθώς και πιο λεπτομερή αποτελέσματα για καθεμία από αυτές τις πηγές ξεχωριστά.

Τελικές Σκέψεις

Σε αυτό το άρθρο, μιλήσαμε για το OLMo, ένα μοντέλο πραγματικά ανοιχτής γλώσσας τελευταίας τεχνολογίας που προσφέρει στους προγραμματιστές ένα πλαίσιο για να δημιουργήσουν, να μελετήσουν και να προωθήσουν την ανάπτυξη μοντέλων γλώσσας, παρέχοντας στους ερευνητές πρόσβαση στον κώδικα εκπαίδευσης και αξιολόγησης, στη μεθοδολογία εκπαίδευσης, δεδομένα εκπαίδευσης, αρχεία καταγραφής εκπαίδευσης και σημεία ελέγχου ενδιάμεσων μοντέλων. Τα υπάρχοντα μοντέλα τελευταίας τεχνολογίας έχουν διαφορετικούς βαθμούς διαφάνειας, ενώ το μοντέλο OLMo έχει κυκλοφορήσει ολόκληρο το πλαίσιο από την εκπαίδευση έως τα δεδομένα και τα εργαλεία αξιολόγησης, μειώνοντας έτσι το χάσμα στην απόδοση σε σύγκριση με μοντέλα τελευταίας τεχνολογίας όπως το μοντέλο LLaMA2.