Κυβερνασφάλεια

Πώς να ασφαλίσετε τα δεδομένα εκπαίδευσης AI

Η τεχνητή νοημοσύνη (AI) χρειάζεται δεδομένα και πολλά από αυτά. Η συλλογή των απαραίτητων πληροφοριών δεν είναι πάντα μια πρόκληση στο σημερινό περιβάλλον, με πολλά διαθέσιμα δημόσια σύνολα δεδομένων και τόσα πολλά δεδομένα που παράγονται καθημερινά. Η διασφάλισή του όμως είναι άλλο θέμα.

Το τεράστιο μέγεθος των συνόλων δεδομένων εκπαίδευσης AI και ο αντίκτυπος των μοντέλων AI προσελκύουν την προσοχή των εγκληματιών στον κυβερνοχώρο. Καθώς η εξάρτηση από την τεχνητή νοημοσύνη αυξάνεται, οι ομάδες που αναπτύσσουν αυτήν την τεχνολογία θα πρέπει να είναι προσεκτικές για να διασφαλίσουν ότι διατηρούν ασφαλή τα δεδομένα εκπαίδευσής τους.

Γιατί τα δεδομένα εκπαίδευσης AI χρειάζονται καλύτερη ασφάλεια

Τα δεδομένα που χρησιμοποιείτε για να εκπαιδεύσετε ένα μοντέλο AI μπορεί να αντικατοπτρίζουν πραγματικούς ανθρώπους, επιχειρήσεις ή γεγονότα. Ως εκ τούτου, θα μπορούσατε να διαχειρίζεστε έναν σημαντικό αριθμό πληροφοριών προσωπικής ταυτοποίησης (PII), οι οποίες θα προκαλούσαν σημαντικές παραβιάσεις του απορρήτου εάν εκτεθούν. Το 2023, η Microsoft υπέστη ένα τέτοιο περιστατικό, εκθέτοντας κατά λάθος 38 terabytes προσωπικών πληροφοριών κατά τη διάρκεια ενός ερευνητικού προγράμματος AI.

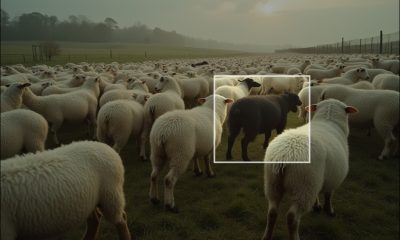

Τα σύνολα δεδομένων εκπαίδευσης AI μπορεί επίσης να είναι ευάλωτα σε πιο επιβλαβείς επιθέσεις αντιπάλου. Οι εγκληματίες του κυβερνοχώρου μπορούν να αλλάξουν την αξιοπιστία ενός μοντέλου μηχανικής μάθησης χειραγωγώντας τα δεδομένα εκπαίδευσής του, εάν μπορούν να αποκτήσουν πρόσβαση σε αυτό. Είναι ένας τύπος επίθεσης γνωστός ως δηλητηρίαση δεδομένων και οι προγραμματιστές τεχνητής νοημοσύνης μπορεί να μην παρατηρήσουν τα αποτελέσματα μέχρι να είναι πολύ αργά.

Η έρευνα δείχνει ότι η δηλητηρίαση μόλις 0.001% ενός συνόλου δεδομένων είναι αρκετό για να διαφθείρει ένα μοντέλο AI. Χωρίς τις κατάλληλες προστασίες, μια επίθεση όπως αυτή θα μπορούσε να οδηγήσει σε σοβαρές επιπτώσεις μόλις το μοντέλο δει την εφαρμογή σε πραγματικό κόσμο. Για παράδειγμα, ένας κατεστραμμένος αλγόριθμος αυτοοδήγησης μπορεί να μην παρατηρήσει τους πεζούς. Εναλλακτικά, ένα εργαλείο τεχνητής νοημοσύνης σάρωσης βιογραφικού μπορεί να παράγει μεροληπτικά αποτελέσματα.

Σε λιγότερο σοβαρές περιπτώσεις, οι επιτιθέμενοι θα μπορούσαν να κλέψουν ιδιόκτητες πληροφορίες από ένα σύνολο δεδομένων εκπαίδευσης σε μια πράξη βιομηχανικής κατασκοπείας. Μπορούν επίσης να κλειδώσουν εξουσιοδοτημένους χρήστες από τη βάση δεδομένων και να απαιτήσουν λύτρα.

Καθώς η τεχνητή νοημοσύνη γίνεται ολοένα και πιο σημαντική για τη ζωή και τις επιχειρήσεις, οι εγκληματίες στον κυβερνοχώρο θα κερδίζουν περισσότερα από τη στόχευση των βάσεων δεδομένων εκπαίδευσης. Όλοι αυτοί οι κίνδυνοι, με τη σειρά τους, γίνονται επιπρόσθετα ανησυχητικοί.

5 βήματα για την ασφάλεια των δεδομένων εκπαίδευσης AI

Υπό το φως αυτών των απειλών, λάβετε σοβαρά υπόψη την ασφάλεια όταν εκπαιδεύετε μοντέλα τεχνητής νοημοσύνης. Ακολουθούν πέντε βήματα που πρέπει να ακολουθήσετε για να προστατεύσετε τα δεδομένα εκπαίδευσης AI.

1. Ελαχιστοποιήστε τις ευαίσθητες πληροφορίες στα σύνολα δεδομένων εκπαίδευσης

Ένα από τα πιο σημαντικά μέτρα είναι να αφαιρέσετε τον όγκο των ευαίσθητων λεπτομερειών στο σύνολο δεδομένων εκπαίδευσης. Όσο λιγότερα PII ή άλλες πολύτιμες πληροφορίες υπάρχουν στη βάση δεδομένων σας, τόσο λιγότερος στόχος είναι για τους χάκερ. Μια παραβίαση θα έχει επίσης λιγότερο αντίκτυπο εάν συμβεί σε αυτά τα σενάρια.

Τα μοντέλα τεχνητής νοημοσύνης συχνά δεν χρειάζεται να χρησιμοποιούν πληροφορίες πραγματικού κόσμου κατά τη φάση της εκπαίδευσης. Τα συνθετικά δεδομένα είναι μια πολύτιμη εναλλακτική λύση. Τα μοντέλα που έχουν εκπαιδευτεί σε συνθετικά δεδομένα μπορούν να είναι σαν να μην είναι πιο ακριβές από άλλα, επομένως δεν χρειάζεται να ανησυχείτε για ζητήματα απόδοσης. Απλώς βεβαιωθείτε ότι το σύνολο δεδομένων που δημιουργείται μοιάζει και λειτουργεί με δεδομένα πραγματικού κόσμου.

Εναλλακτικά, μπορείτε να καθαρίσετε υπάρχοντα σύνολα δεδομένων ευαίσθητων λεπτομερειών, όπως ονόματα ατόμων, διευθύνσεις και οικονομικές πληροφορίες. Όταν τέτοιοι παράγοντες είναι απαραίτητοι για το μοντέλο σας, εξετάστε το ενδεχόμενο να τους αντικαταστήσετε με εικονικά δεδομένα stand-in ή να τα ανταλλάξετε μεταξύ των εγγραφών.

2. Περιορίστε την πρόσβαση στα δεδομένα εκπαίδευσης

Αφού συντάξετε το εκπαιδευτικό σας σύνολο δεδομένων, πρέπει να περιορίσετε την πρόσβαση σε αυτό. Ακολουθήστε την αρχή του ελάχιστου προνομίου, η οποία ορίζει ότι οποιοσδήποτε χρήστης ή πρόγραμμα θα πρέπει να έχει πρόσβαση μόνο σε ό,τι είναι απαραίτητο για να ολοκληρώσει σωστά την εργασία του. Όποιος δεν συμμετέχει στη διαδικασία εκπαίδευσης δεν χρειάζεται να δει ή να αλληλεπιδράσει με τη βάση δεδομένων.

Θυμηθείτε ότι οι περιορισμοί προνομίων είναι αποτελεσματικοί μόνο εάν εφαρμόσετε επίσης έναν αξιόπιστο τρόπο επαλήθευσης των χρηστών. Το όνομα χρήστη και ο κωδικός πρόσβασης δεν αρκούν. Ο έλεγχος ταυτότητας πολλαπλών παραγόντων (MFA) είναι απαραίτητος, καθώς σταματά 80% έως 90% όλων των επιθέσεων έναντι των λογαριασμών, αλλά δεν είναι όλες οι μέθοδοι MFA ίσες. Το MFA που βασίζεται σε κείμενο και σε εφαρμογές είναι γενικά πιο ασφαλές από τις εναλλακτικές λύσεις που βασίζονται σε email.

Φροντίστε να περιορίσετε το λογισμικό και τις συσκευές, όχι μόνο τους χρήστες. Τα μόνα εργαλεία με πρόσβαση στη βάση δεδομένων εκπαίδευσης θα πρέπει να είναι το ίδιο το μοντέλο AI και τυχόν προγράμματα που χρησιμοποιείτε για τη διαχείριση αυτών των πληροφοριών κατά τη διάρκεια της εκπαίδευσης.

3. Κρυπτογράφηση και δημιουργία αντιγράφων ασφαλείας δεδομένων

Η κρυπτογράφηση είναι ένα άλλο κρίσιμο προστατευτικό μέτρο. Αν και δεν μπορούν όλοι οι αλγόριθμοι μηχανικής εκμάθησης να εκπαιδεύονται ενεργά σε κρυπτογραφημένα δεδομένα, μπορείτε να τα κρυπτογραφήσετε και να τα αποκρυπτογραφήσετε κατά την ανάλυση. Στη συνέχεια, μπορείτε να το κρυπτογραφήσετε ξανά μόλις τελειώσετε. Εναλλακτικά, κοιτάξτε σε δομές μοντέλων που μπορούν να αναλύουν πληροφορίες ενώ είναι κρυπτογραφημένες.

Είναι σημαντικό να διατηρείτε αντίγραφα ασφαλείας των δεδομένων προπόνησής σας σε περίπτωση που συμβεί κάτι. Τα αντίγραφα ασφαλείας πρέπει να βρίσκονται σε διαφορετική τοποθεσία από το κύριο αντίγραφο. Ανάλογα με το πόσο κρίσιμο είναι το σύνολο δεδομένων σας, μπορεί να χρειαστεί να διατηρήσετε ένα αντίγραφο ασφαλείας εκτός σύνδεσης και ένα στο cloud. Θυμηθείτε να κρυπτογραφήσετε όλα τα αντίγραφα ασφαλείας.

Όσον αφορά την κρυπτογράφηση, επιλέξτε τη μέθοδο που χρησιμοποιείτε προσεκτικά. Τα υψηλότερα πρότυπα είναι πάντα προτιμότερα, αλλά ίσως θελήσετε να εξετάσετε αλγόριθμους κρυπτογραφίας ανθεκτικούς σε κβαντικά, καθώς αυξάνεται ο κίνδυνος κβαντικών επιθέσεων.

4. Πρόσβαση και χρήση της οθόνης

Ακόμα κι αν ακολουθήσετε αυτά τα άλλα βήματα, οι εγκληματίες του κυβερνοχώρου μπορούν να ξεπεράσουν τις άμυνές σας. Κατά συνέπεια, πρέπει να παρακολουθείτε συνεχώς τα μοτίβα πρόσβασης και χρήσης με τα δεδομένα εκπαίδευσης AI.

Μια αυτοματοποιημένη λύση παρακολούθησης είναι πιθανώς απαραίτητη εδώ, καθώς λίγοι οργανισμοί έχουν τα επίπεδα προσωπικού για να παρακολουθούν για ύποπτες δραστηριότητες όλο το εικοσιτετράωρο. Ο αυτοματισμός είναι επίσης πολύ πιο γρήγορος στο να ενεργεί όταν συμβαίνει κάτι ασυνήθιστο, κάτι που οδηγεί σε 2.22 $ χαμηλότερο κόστος παραβίασης δεδομένων κατά μέσο όρο από ταχύτερες, πιο αποτελεσματικές απαντήσεις.

Καταγράψτε κάθε φορά που κάποιος ή κάτι αποκτά πρόσβαση στο σύνολο δεδομένων, ζητά πρόσβαση σε αυτό, το αλλάζει ή αλληλεπιδρά με άλλο τρόπο με αυτό. Εκτός από την παρακολούθηση πιθανών παραβιάσεων σε αυτήν τη δραστηριότητα, να την ελέγχετε τακτικά για μεγαλύτερες τάσεις. Η συμπεριφορά των εξουσιοδοτημένων χρηστών μπορεί να αλλάξει με την πάροδο του χρόνου, γεγονός που μπορεί να απαιτήσει αλλαγή στα δικαιώματα πρόσβασής σας ή στα βιομετρικά στοιχεία συμπεριφοράς, εάν χρησιμοποιείτε ένα τέτοιο σύστημα.

5. Επαναξιολογήστε τακτικά τους κινδύνους

Ομοίως, οι ομάδες προγραμματιστών τεχνητής νοημοσύνης πρέπει να συνειδητοποιήσουν ότι η ασφάλεια στον κυβερνοχώρο είναι μια συνεχής διαδικασία και όχι μια εφάπαξ επιδιόρθωση. Οι μέθοδοι επίθεσης εξελίσσονται γρήγορα — ορισμένα τρωτά σημεία και απειλές μπορεί να ξεφύγουν πριν τα παρατηρήσετε. Ο μόνος τρόπος για να παραμείνετε ασφαλείς είναι να επαναξιολογείτε τακτικά τη στάση ασφαλείας σας.

Τουλάχιστον μία φορά το χρόνο, ελέγχετε το μοντέλο τεχνητής νοημοσύνης, τα δεδομένα εκπαίδευσής του και τυχόν περιστατικά ασφαλείας που επηρέασαν κάποιο από αυτά. Ελέγξτε το σύνολο δεδομένων και τον αλγόριθμο για να βεβαιωθείτε ότι λειτουργεί σωστά και ότι δεν υπάρχουν δηλητηριασμένα, παραπλανητικά ή άλλως επιβλαβή δεδομένα. Προσαρμόστε τους ελέγχους ασφαλείας σας όπως είναι απαραίτητο σε οτιδήποτε ασυνήθιστο παρατηρήσετε.

Η δοκιμή διείσδυσης, όπου οι ειδικοί σε θέματα ασφάλειας δοκιμάζουν τις άμυνές σας προσπαθώντας να τις ξεπεράσετε, είναι επίσης επωφελής. Όλα αλλά Το 17% των επαγγελματιών της κυβερνοασφάλειας τεστ στυλό τουλάχιστον μία φορά το χρόνο και το 72% όσων το κάνουν λένε ότι πιστεύουν ότι σταμάτησε μια παραβίαση στον οργανισμό τους.

Η κυβερνοασφάλεια είναι το κλειδί για την ασφαλή ανάπτυξη AI

Η ηθική και ασφαλής ανάπτυξη τεχνητής νοημοσύνης γίνεται ολοένα και πιο σημαντική καθώς τα πιθανά ζητήματα σχετικά με την εξάρτηση από τη μηχανική μάθηση γίνονται πιο εμφανή. Η διασφάλιση της βάσης δεδομένων εκπαίδευσης είναι ένα κρίσιμο βήμα για την ικανοποίηση αυτής της ζήτησης.

Τα δεδομένα εκπαίδευσης AI είναι πολύ πολύτιμα και ευάλωτα για να αγνοηθούν οι κίνδυνοι στον κυβερνοχώρο. Ακολουθήστε αυτά τα πέντε βήματα σήμερα για να διατηρήσετε το μοντέλο σας και το σύνολο δεδομένων του ασφαλή.