Άμεση Μηχανική

Κατανόηση του LLM Fine-Tuning: Προσαρμογή μεγάλων μοντέλων γλώσσας στις μοναδικές σας απαιτήσεις

Καθώς βρισκόμαστε τον Σεπτέμβριο του 2023, το τοπίο των Μεγάλων Γλωσσικών Μοντέλων (LLM) εξακολουθεί να παρακολουθεί την άνοδο των μοντέλων, συμπεριλαμβανομένων των Alpaca, Falcon, Λάμα 2, GPT-4 και πολλά άλλα.

Μια σημαντική πτυχή της αξιοποίησης των δυνατοτήτων αυτών των LLM έγκειται στη διαδικασία τελειοποίησης, μια στρατηγική που επιτρέπει την προσαρμογή προεκπαιδευμένων μοντέλων για την κάλυψη συγκεκριμένων εργασιών με ακρίβεια. Μέσω αυτής της τελειοποίησης, αυτά τα μοντέλα μπορούν πραγματικά να ευθυγραμμιστούν με εξατομικευμένες απαιτήσεις, προσφέροντας λύσεις που είναι καινοτόμες και προσαρμοσμένες στις μοναδικές ανάγκες.

Ωστόσο, είναι σημαντικό να σημειωθεί ότι δεν δημιουργούνται όλοι οι δρόμοι τελειοποίησης ίσοι. Για παράδειγμα, η πρόσβαση στις δυνατότητες λεπτομέρειας του GPT-4 έρχεται με μεγάλη τιμή, απαιτώντας μια συνδρομή επί πληρωμή που είναι σχετικά πιο ακριβή σε σύγκριση με άλλες διαθέσιμες επιλογές στην αγορά. Από την άλλη πλευρά, ο τομέας ανοιχτού κώδικα είναι γεμάτος με εναλλακτικές λύσεις που προσφέρουν μια πιο προσιτή διαδρομή για την αξιοποίηση της δύναμης των μεγάλων μοντέλων γλώσσας. Αυτές οι επιλογές ανοιχτού κώδικα εκδημοκρατίζουν την πρόσβαση σε προηγμένη τεχνολογία AI, ενισχύοντας την καινοτομία και την ένταξη στο ταχέως εξελισσόμενο τοπίο της τεχνητής νοημοσύνης.

Γιατί είναι σημαντική η τελειοποίηση του LLM;

Η τελειοποίηση του LLM είναι κάτι περισσότερο από μια τεχνική βελτίωση. Είναι μια κρίσιμη πτυχή της ανάπτυξης μοντέλων LLM που επιτρέπει μια πιο συγκεκριμένη και εκλεπτυσμένη εφαρμογή σε διάφορες εργασίες. Η λεπτή ρύθμιση προσαρμόζει τα προεκπαιδευμένα μοντέλα ώστε να ταιριάζουν καλύτερα σε συγκεκριμένα σύνολα δεδομένων, βελτιώνοντας την απόδοσή τους σε συγκεκριμένες εργασίες και διασφαλίζοντας μια πιο στοχευμένη εφαρμογή. Αναδεικνύει την αξιοσημείωτη ικανότητα των LLM να προσαρμόζονται σε νέα δεδομένα, επιδεικνύοντας ευελιξία που είναι ζωτικής σημασίας για το συνεχώς αυξανόμενο ενδιαφέρον για εφαρμογές τεχνητής νοημοσύνης.

Η ακριβής ρύθμιση μοντέλων μεγάλων γλωσσών ανοίγει πολλές ευκαιρίες, επιτρέποντάς τους να διακριθούν σε συγκεκριμένες εργασίες που κυμαίνονται από την ανάλυση συναισθήματος έως τις ανασκοπήσεις ιατρικής βιβλιογραφίας. Συντονίζοντας το βασικό μοντέλο σε μια συγκεκριμένη περίπτωση χρήσης, ξεκλειδώνουμε νέες δυνατότητες, ενισχύοντας την αποτελεσματικότητα και την ακρίβεια του μοντέλου. Επιπλέον, διευκολύνει την πιο οικονομική χρήση των πόρων του συστήματος, καθώς η λεπτομέρεια απαιτεί λιγότερη υπολογιστική ισχύ σε σύγκριση με την εκπαίδευση ενός μοντέλου από την αρχή.

Καθώς προχωράμε βαθύτερα σε αυτόν τον οδηγό, θα συζητήσουμε τις περιπλοκές της μικρορύθμισης LLM, δίνοντάς σας μια ολοκληρωμένη επισκόπηση που βασίζεται στις τελευταίες εξελίξεις και τις βέλτιστες πρακτικές στον τομέα.

Βελτιωμένος συντονισμός βάσει οδηγιών

Η φάση τελειοποίησης στο Παραγωγική τεχνητή νοημοσύνη Ο κύκλος ζωής, που απεικονίζεται στο παρακάτω σχήμα, χαρακτηρίζεται από την ενοποίηση εισόδων και εξόδων εντολών, σε συνδυασμό με παραδείγματα συλλογισμού βήμα προς βήμα. Αυτή η προσέγγιση διευκολύνει το μοντέλο στη δημιουργία απαντήσεων που όχι μόνο είναι σχετικές αλλά και ευθυγραμμισμένες ακριβώς με τις συγκεκριμένες οδηγίες που τροφοδοτούνται σε αυτό. Κατά τη διάρκεια αυτής της φάσης τα προεκπαιδευμένα μοντέλα προσαρμόζονται για την επίλυση διαφορετικών εργασιών και περιπτώσεων χρήσης, χρησιμοποιώντας εξατομικευμένα σύνολα δεδομένων για τη βελτίωση της λειτουργικότητάς τους.

Βελτιστοποίηση μίας εργασίας

Η λεπτομέρεια μιας εργασίας εστιάζει στην εξάσκηση της τεχνογνωσίας του μοντέλου σε μια συγκεκριμένη εργασία, όπως η σύνοψη. Αυτή η προσέγγιση είναι ιδιαίτερα επωφελής για τη βελτιστοποίηση των ροών εργασίας που περιλαμβάνουν σημαντικά έγγραφα ή νήματα συνομιλίας, συμπεριλαμβανομένων νομικών εγγράφων και εισιτηρίων υποστήριξης πελατών. Είναι αξιοσημείωτο ότι αυτή η λεπτομέρεια μπορεί να επιτύχει σημαντικές βελτιώσεις απόδοσης με ένα σχετικά μικρό σύνολο παραδειγμάτων, που κυμαίνονται από 500 έως 1000, σε αντίθεση με τα δισεκατομμύρια μάρκες που χρησιμοποιούνται στη φάση της προεκπαίδευσης.

Θεμέλια του LLM Fine-Tuning LLM: Transformer Architecture and Beyond

Το ταξίδι κατανόησης της τελειοποίησης του LLM ξεκινά με την κατανόηση των θεμελιωδών στοιχείων που αποτελούν τα LLM. Στην καρδιά αυτών των μοντέλων βρίσκεται το αρχιτεκτονική μετασχηματιστή, ένα νευρωνικό δίκτυο που αξιοποιεί μηχανισμούς αυτοπροσοχής για να δώσει προτεραιότητα στο πλαίσιο των λέξεων έναντι της εγγύτητάς τους σε μια πρόταση. Αυτή η καινοτόμος προσέγγιση διευκολύνει τη βαθύτερη κατανόηση των απομακρυσμένων σχέσεων μεταξύ των διακριτικών στην είσοδο.

Καθώς περιηγούμαστε στις περιπλοκές των μετασχηματιστών, συναντάμε μια διαδικασία πολλαπλών βημάτων που ξεκινά με τον κωδικοποιητή. Αυτή η αρχική φάση περιλαμβάνει τον προσδιορισμό της εισόδου και τη δημιουργία ενσωμάτωσης διανυσμάτων που αντιπροσωπεύουν την είσοδο και τη θέση της στην πρόταση. Τα επόμενα στάδια περιλαμβάνουν μια σειρά υπολογισμών χρησιμοποιώντας πίνακες γνωστούς ως Απορία, αξία, να Κλειδί, με αποκορύφωμα μια βαθμολογία αυτοπροσοχής που υπαγορεύει την εστίαση σε διάφορα μέρη της πρότασης και σε διάφορα διακριτικά.

Η τελειοποίηση αποτελεί μια κρίσιμη φάση στην ανάπτυξη των LLM, μια διαδικασία που συνεπάγεται την πραγματοποίηση λεπτών προσαρμογών για την επίτευξη πιο επιθυμητών αποτελεσμάτων. Αυτό το στάδιο, αν και είναι απαραίτητο, παρουσιάζει ένα σύνολο προκλήσεων, συμπεριλαμβανομένων των απαιτήσεων υπολογισμού και αποθήκευσης για τη διαχείριση ενός τεράστιου αριθμού παραμέτρων. Το Parameter Efficient Fine-Tuning (PEFT) προσφέρει τεχνικές για τη μείωση του αριθμού των παραμέτρων που πρέπει να τελειοποιηθούν, απλοποιώντας έτσι τη διαδικασία εκπαίδευσης.

LLM Pre-Training: Δημιουργία μιας ισχυρής βάσης

Στα αρχικά στάδια της ανάπτυξης του LLM, η προεκπαίδευση βρίσκεται στο επίκεντρο, χρησιμοποιώντας υπερπαραμετροποιημένους μετασχηματιστές ως βασική αρχιτεκτονική. Αυτή η διαδικασία περιλαμβάνει τη μοντελοποίηση της φυσικής γλώσσας με διάφορους τρόπους, όπως αμφίδρομη, αυτοπαλινδρομική ή αλληλουχία σε ακολουθία σε μεγάλης κλίμακας μη εποπτευόμενα σώματα. Ο στόχος εδώ είναι να δημιουργηθεί μια βάση που μπορεί να βελτιωθεί αργότερα για συγκεκριμένες εργασίες κατάντη μέσω της εισαγωγής στόχων για συγκεκριμένες εργασίες.

Μια αξιοσημείωτη τάση σε αυτόν τον τομέα είναι η αναπόφευκτη αύξηση της κλίμακας των προεκπαιδευμένων LLMs, που μετράται με τον αριθμό των παραμέτρων. Τα εμπειρικά δεδομένα δείχνουν σταθερά ότι τα μεγαλύτερα μοντέλα σε συνδυασμό με περισσότερα δεδομένα αποδίδουν σχεδόν πάντα καλύτερη απόδοση. Για παράδειγμα, το GPT-3, με τις 175 δισεκατομμύρια παραμέτρους του, έχει θέσει ένα σημείο αναφοράς στη δημιουργία φυσικής γλώσσας υψηλής ποιότητας και στην εκτέλεση μιας ευρείας σειράς εργασιών μηδενικής βολής με επιδεξιότητα.

Fine-Tuning: The Path to Model Adaptation

Μετά την προεκπαίδευση, το LLM υποβάλλεται σε τελειοποίηση για να προσαρμοστεί σε συγκεκριμένες εργασίες. Παρά την πολλά υποσχόμενη απόδοση που δείχνει η εκμάθηση εντός του πλαισίου σε προεκπαιδευμένα LLM όπως το GPT-3, η τελειοποίηση παραμένει ανώτερη σε ρυθμίσεις που αφορούν συγκεκριμένες εργασίες. Ωστόσο, η διαδεδομένη προσέγγιση της πλήρους μικρορύθμισης παραμέτρων παρουσιάζει προκλήσεις, συμπεριλαμβανομένων των υψηλών απαιτήσεων υπολογισμού και μνήμης, ειδικά όταν πρόκειται για μοντέλα μεγάλης κλίμακας.

Για μοντέλα μεγάλων γλωσσών με περισσότερες από ένα δισεκατομμύριο παραμέτρους, η αποτελεσματική διαχείριση της μνήμης RAM GPU είναι ζωτικής σημασίας. Μια μεμονωμένη παράμετρος μοντέλου με πλήρη ακρίβεια 32 bit απαιτεί 4 byte χώρου, που μεταφράζεται σε απαίτηση 4 GB μνήμης GPU RAM μόνο για τη φόρτωση ενός μοντέλου παραμέτρων 1 δισεκατομμυρίου. Η πραγματική διαδικασία εκπαίδευσης απαιτεί ακόμη περισσότερη μνήμη για να φιλοξενήσει διάφορα στοιχεία, συμπεριλαμβανομένων των καταστάσεων και των κλίσεων βελτιστοποίησης, που πιθανώς απαιτούν έως και 80 GB μνήμης GPU RAM για ένα μοντέλο αυτής της κλίμακας.

Για την πλοήγηση στους περιορισμούς της μνήμης RAM GPU, χρησιμοποιείται η κβαντοποίηση, η οποία είναι μια τεχνική που μειώνει την ακρίβεια των παραμέτρων του μοντέλου, μειώνοντας έτσι τις απαιτήσεις μνήμης. Για παράδειγμα, η αλλαγή της ακρίβειας από 32-bit σε 16-bit μπορεί να μειώσει στο μισό τη μνήμη που απαιτείται τόσο για τη φόρτωση όσο και για την εκπαίδευση του μοντέλου. Αργότερα σε αυτό το άρθρο. θα μάθουμε για την Qlora η οποία χρησιμοποιεί την έννοια της κβαντοποίησης για συντονισμό.

Εξερευνώντας τις Κατηγορίες των Μεθόδων PEFT

Στη διαδικασία πλήρους προσαρμογής των μοντέλων μεγάλων γλωσσών, είναι σημαντικό να έχετε μια υπολογιστική ρύθμιση που να μπορεί να χειριστεί αποτελεσματικά όχι μόνο τα σημαντικά βάρη μοντέλων, τα οποία για τα πιο προηγμένα μοντέλα φτάνουν τώρα σε μεγέθη εκατοντάδων gigabyte, αλλά και να διαχειριστεί μια σειρά από άλλα κρίσιμα στοιχεία. Αυτά περιλαμβάνουν την κατανομή μνήμης για καταστάσεις βελτιστοποίησης, τη διαχείριση κλίσεων, τις προωθητικές ενεργοποιήσεις και τη διευκόλυνση της προσωρινής μνήμης κατά τη διάρκεια διαφόρων σταδίων της διαδικασίας εκπαίδευσης.

Προσθετική Μέθοδος

Αυτός ο τύπος συντονισμού μπορεί να αυξήσει το προεκπαιδευμένο μοντέλο με πρόσθετες παραμέτρους ή επίπεδα, εστιάζοντας στην εκπαίδευση μόνο των παραμέτρων που προστέθηκαν πρόσφατα. Παρά την αύξηση του αριθμού παραμέτρων, αυτές οι μέθοδοι ενισχύουν την απόδοση χρόνου και χώρου προπόνησης. Η προσθετική μέθοδος χωρίζεται περαιτέρω σε υποκατηγορίες:

- Προσαρμογείς: Ενσωμάτωση μικρών πλήρως συνδεδεμένων δικτύων μετά από υποστρώματα μετασχηματιστών, με αξιοσημείωτα παραδείγματα AdaMix, Σουηδικό νόμισμακαι Συμπιεστής.

- Soft Prompts: Βελτιστοποίηση ενός τμήματος των ενσωματώσεων εισόδου του μοντέλου μέσω gradient descent, με IPT, συντονισμός προθέματος, και το WARP είναι εξέχοντα παραδείγματα.

- Άλλες προσθετικές προσεγγίσεις: Συμπεριλάβετε τεχνικές όπως το LeTS, το AttentionFusion και το Ladder-Side Tuning.

Επιλεκτική Μέθοδος

Τα επιλεκτικά PEFT ρυθμίζουν με ακρίβεια έναν περιορισμένο αριθμό ανώτερων στρωμάτων με βάση τον τύπο του στρώματος και τη δομή της εσωτερικής του μοντέλου. Αυτή η κατηγορία περιλαμβάνει μεθόδους όπως BitFit και LN συντονισμός, που εστιάζουν στον συντονισμό συγκεκριμένων στοιχείων, όπως προκαταλήψεις μοντέλων ή συγκεκριμένες σειρές.

Μέθοδος με βάση την επαναπαραμετροποίηση

Αυτές οι μέθοδοι χρησιμοποιούν αναπαραστάσεις χαμηλής κατάταξης για να μειώσουν τον αριθμό των εκπαιδεύσιμων παραμέτρων, με τις πιο γνωστές να είναι η Low-Rank Adaptation ή LoRA. Αυτή η μέθοδος αξιοποιεί μια απλή αποσύνθεση μήτρας χαμηλής κατάταξης για την παραμετροποίηση της ενημέρωσης βάρους, επιδεικνύοντας αποτελεσματική λεπτομέρεια σε υποχώρους χαμηλής κατάταξης.

1) LoRA (Προσαρμογή χαμηλής βαθμίδας)

Το LoRA αναδείχθηκε ως μια πρωτοποριακή τεχνική PEFT, που εισήχθη σε ένα άρθρο του Ο Edward J. Hu και άλλοι το 2021. Λειτουργεί εντός της κατηγορίας επαναπαραμετροποίησης, παγώνοντας τα αρχικά βάρη του LLM και ενσωματώνοντας νέους εκπαιδεύσιμους πίνακες χαμηλής κατάταξης σε κάθε επίπεδο της αρχιτεκτονικής του Transformer. Αυτή η προσέγγιση όχι μόνο περιορίζει τον αριθμό των εκπαιδεύσιμων παραμέτρων, αλλά μειώνει επίσης τον απαιτούμενο χρόνο εκπαίδευσης και τους υπολογιστικούς πόρους, παρουσιάζοντας έτσι μια πιο αποτελεσματική εναλλακτική λύση για την πλήρη μικρορύθμιση.

Για να κατανοήσουμε τη μηχανική του LoRA, πρέπει να επανεξετάσουμε την αρχιτεκτονική του μετασχηματιστή όπου η προτροπή εισόδου υφίσταται διακριτοποίηση και μετατροπή σε διανύσματα ενσωμάτωσης. Αυτά τα διανύσματα διασχίζουν τα τμήματα κωδικοποιητή και/ή αποκωδικοποιητή του μετασχηματιστή, συναντώντας δίκτυα αυτοπροσοχής και τροφοδοσίας των οποίων τα βάρη είναι προεκπαιδευμένα.

Το LoRA χρησιμοποιεί την έννοια του Αποσύνθεση μοναδικής τιμής (SVD). Ουσιαστικά, το SVD ανατέμνει έναν πίνακα σε τρεις διακριτούς πίνακες, ένας από τους οποίους είναι ένας διαγώνιος πίνακας που φιλοξενεί μοναδικές τιμές. Αυτές οι μοναδικές τιμές είναι καθοριστικές καθώς μετρούν τη σημασία των διαφορετικών διαστάσεων στους πίνακες, με τις μεγαλύτερες τιμές να υποδεικνύουν μεγαλύτερη σημασία και τις μικρότερες να υποδηλώνουν μικρότερη σημασία.

Αυτή η προσέγγιση επιτρέπει στο LoRA να διατηρήσει τα βασικά χαρακτηριστικά των δεδομένων μειώνοντας ταυτόχρονα τη διαστασιολόγηση, βελτιστοποιώντας έτσι τη διαδικασία λεπτομέρειας.

Το LoRA παρεμβαίνει σε αυτή τη διαδικασία, παγώνοντας όλες τις παραμέτρους του αρχικού μοντέλου και εισάγοντας ένα ζεύγος «πίνακες αποσύνθεσης κατάταξης» μαζί με τα αρχικά βάρη. Αυτοί οι μικρότεροι πίνακες, που δηλώνονται ως Α και Β, υποβάλλονται σε εκπαίδευση μέσω εποπτευόμενης μάθησης.

Το βασικό στοιχείο σε αυτή τη στρατηγική είναι η παράμετρος που ονομάζεται rank ('r'), η οποία υπαγορεύει το μέγεθος των πινάκων χαμηλής κατάταξης. Μια σχολαστική επιλογή του 'r' μπορεί να αποφέρει εντυπωσιακά αποτελέσματα, ακόμη και με μικρότερη τιμή, δημιουργώντας έτσι έναν πίνακα χαμηλής κατάταξης με λιγότερες παραμέτρους για εκπαίδευση. Αυτή η στρατηγική έχει εφαρμοστεί αποτελεσματικά χρησιμοποιώντας βιβλιοθήκες ανοιχτού κώδικα, όπως το HuggingFace Transformers, διευκολύνοντας τη λεπτομέρεια του LoRA για διάφορες εργασίες με αξιοσημείωτη αποτελεσματικότητα.

2) QLoRA: Ανεβάζοντας την αποτελεσματικότητα του LoRA υψηλότερη

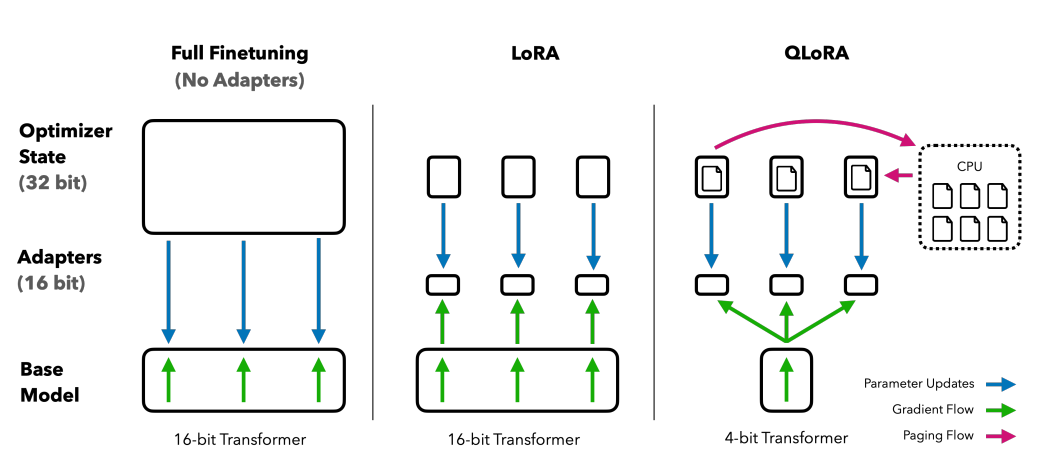

Χτίζοντας στα θεμέλια που έθεσε η LoRA, το QLoRA ελαχιστοποιεί περαιτέρω τις απαιτήσεις μνήμης. Εισήχθη από Ο Tim Dettmers και άλλοι το 2023, συνδυάζει προσαρμογή χαμηλής τάξης με κβαντισμό, χρησιμοποιώντας μια μορφή κβαντισμού 4 bit που ονομάζεται NormalFloat or nf4. Η κβαντοποίηση είναι ουσιαστικά μια διαδικασία που μεταφέρει δεδομένα από μια υψηλότερη πληροφοριακή αναπαράσταση σε μια με λιγότερες πληροφορίες. Αυτή η προσέγγιση διατηρεί την αποτελεσματικότητα των μεθόδων λεπτομέρειας 16-bit, μειώνοντας τα βάρη των 4-bit σε 16-bit, όπως απαιτείται κατά τις υπολογιστικές διαδικασίες.

Σύγκριση μεθόδων λεπτομέρειας: Το QLORA ενισχύει το LoRA με κβαντισμό ακριβείας 4-bit και βελτιστοποιητές σελιδοποίησης για διαχείριση αιχμής μνήμης

Το QLoRA αξιοποιεί το NumericFloat4 (nf4), στοχεύοντας κάθε επίπεδο στην αρχιτεκτονική του μετασχηματιστή και εισάγει την έννοια της διπλής κβαντοποίησης για περαιτέρω συρρίκνωση του αποτυπώματος μνήμης που απαιτείται για τη λεπτομέρεια. Αυτό επιτυγχάνεται με την εκτέλεση κβαντοποίησης στις ήδη κβαντισμένες σταθερές, μια στρατηγική που αποτρέπει τις τυπικές αιχμές της μνήμης σημείων ελέγχου κλίσης μέσω της χρήσης σελιδοποιημένων βελτιστοποιητών και ενοποιημένης διαχείρισης μνήμης.

Γκουανάκο, το οποίο είναι ένα σύνολο συντονισμένο με QLORA, θέτει ένα σημείο αναφοράς στις λύσεις chatbot ανοιχτού κώδικα. Η απόδοσή του, επικυρωμένη μέσω συστηματικών ανθρώπινων και αυτοματοποιημένων αξιολογήσεων, υπογραμμίζει την κυριαρχία και την αποτελεσματικότητά του στον τομέα.

Οι εκδόσεις 65B και 33B του Guanaco, βελτιστοποιημένες χρησιμοποιώντας μια τροποποιημένη έκδοση του OASST1 δεδομένων, αναδεικνύονται ως τρομεροί υποψήφιοι για διάσημα μοντέλα όπως ChatGPT ακόμα και GPT-4.

Βελτιστοποίηση με χρήση Ενισχυτικής μάθησης από την ανθρώπινη ανατροφοδότηση

Η Ενισχυτική Μάθηση από την Ανθρώπινη Ανάδραση (RLHF) παίζει ρόλο όταν τελειοποιούνται τα προεκπαιδευμένα γλωσσικά μοντέλα ώστε να ευθυγραμμίζονται πιο στενά με τις ανθρώπινες αξίες. Αυτή η ιδέα εισήχθη από το Open AI το 2017 θέτοντας τα θεμέλια για βελτιωμένη σύνοψη εγγράφων και την ανάπτυξη InstructGPT.

Στον πυρήνα του RLHF βρίσκεται το παράδειγμα ενισχυτικής μάθησης, ένας τύπος τεχνικής μηχανικής μάθησης όπου αντιπρόσωπος μαθαίνει πώς να συμπεριφέρεται σε ένα θετική ατμόσφαιρα με την εκτέλεση ενεργειών και λήψη ανταμοιβές. Είναι ένας συνεχής βρόχος του δράση και ανατροφοδότηση, όπου ο πράκτορας έχει κίνητρα να κάνει επιλογές που θα αποφέρουν την υψηλότερη ανταμοιβή.

Μεταφράζοντας αυτό στη σφαίρα των γλωσσικών μοντέλων, το αντιπρόσωπος είναι το μοντέλο η ίδια, που λειτουργεί εντός του θετική ατμόσφαιρα ενός δεδομένου παραθύρου περιβάλλοντος και λήψη αποφάσεων με βάση το κατάσταση, το οποίο ορίζεται από τα τρέχοντα διακριτικά στο παράθυρο περιβάλλοντος. Ο "χώρο δράσηςΠεριλαμβάνει όλα τα πιθανά διακριτικά από τα οποία μπορεί να επιλέξει το μοντέλο, με στόχο να επιλέξει το διακριτικό που ευθυγραμμίζεται περισσότερο με τις ανθρώπινες προτιμήσεις.

Η διαδικασία RLHF αξιοποιεί την ανθρώπινη ανατροφοδότηση εκτενώς, χρησιμοποιώντας την για να εκπαιδεύσει ένα μοντέλο ανταμοιβής. Αυτό το μοντέλο διαδραματίζει κρίσιμο ρόλο στην καθοδήγηση του προεκπαιδευμένου μοντέλου κατά τη διαδικασία λεπτομέρειας, ενθαρρύνοντάς το να παράγει αποτελέσματα που είναι πιο ευθυγραμμισμένα με τις ανθρώπινες αξίες. Πρόκειται για μια δυναμική και επαναληπτική διαδικασία, όπου το μοντέλο μαθαίνει μέσω μιας σειράς «κυκλοφοριών», ένας όρος που χρησιμοποιείται για να περιγράψει την αλληλουχία καταστάσεων και ενεργειών που οδηγούν σε ανταμοιβή στο πλαίσιο της δημιουργίας γλώσσας.

Μία από τις αξιοσημείωτες δυνατότητες του RLHF είναι η ικανότητά του να ενισχύει την εξατομίκευση σε βοηθούς AI, προσαρμόζοντάς τους έτσι ώστε να ανταποκρίνονται στις προτιμήσεις των μεμονωμένων χρηστών, είτε πρόκειται για την αίσθηση του χιούμορ τους είτε για τις καθημερινές ρουτίνες τους. Ανοίγει δρόμους για τη δημιουργία συστημάτων τεχνητής νοημοσύνης που δεν είναι μόνο τεχνικά ικανά αλλά και συναισθηματικά έξυπνα, ικανά να κατανοούν και να ανταποκρίνονται σε αποχρώσεις της ανθρώπινης επικοινωνίας.

Ωστόσο, είναι σημαντικό να σημειωθεί ότι το RLHF δεν είναι μια αλάνθαστη λύση. Τα μοντέλα εξακολουθούν να είναι επιρρεπή στη δημιουργία ανεπιθύμητων αποτελεσμάτων, μια αντανάκλαση των τεράστιων και συχνά μη ρυθμιζόμενων και προκατειλημμένων δεδομένων στα οποία εκπαιδεύονται.

Συμπέρασμα

Η διαδικασία τελειοποίησης, ένα κρίσιμο βήμα για την αξιοποίηση του πλήρους δυναμικού των LLMs όπως τα Alpaca, Falcon και GPT-4, έχει γίνει πιο εκλεπτυσμένη και εστιασμένη, προσφέροντας προσαρμοσμένες λύσεις σε ένα ευρύ φάσμα εργασιών.

Έχουμε δει τη λεπτομέρεια μιας εργασίας, η οποία ειδικεύεται σε μοντέλα σε συγκεκριμένους ρόλους, και μεθόδους Παραμετρικού Αποτελεσματικού Συντονισμού (PEFT), συμπεριλαμβανομένων των LoRA και QLoRA, οι οποίες στοχεύουν να κάνουν τη διαδικασία εκπαίδευσης πιο αποτελεσματική και οικονομικά αποδοτική. Αυτές οι εξελίξεις ανοίγουν πόρτες σε λειτουργίες τεχνητής νοημοσύνης υψηλού επιπέδου για ένα ευρύτερο κοινό.

Επιπλέον, η εισαγωγή του Reinforcement Learning from Human Feedback (RLHF) από την Open AI είναι ένα βήμα προς τη δημιουργία συστημάτων τεχνητής νοημοσύνης που κατανοούν και ευθυγραμμίζονται περισσότερο με τις ανθρώπινες αξίες και προτιμήσεις, θέτοντας τη βάση για βοηθούς τεχνητής νοημοσύνης που δεν είναι μόνο έξυπνοι αλλά και ευαίσθητοι. ανάγκες του μεμονωμένου χρήστη. Τόσο το RLHF όσο και το PEFT λειτουργούν σε συνέργεια για να βελτιώσουν τη λειτουργικότητα και την αποτελεσματικότητα των Μεγάλων Γλωσσικών Μοντέλων.

Καθώς οι επιχειρήσεις, οι επιχειρήσεις και τα άτομα προσπαθούν να ενσωματώσουν αυτά τα τελειοποιημένα LLM στις δραστηριότητές τους, υποδέχονται ουσιαστικά ένα μέλλον όπου η τεχνητή νοημοσύνη είναι κάτι περισσότερο από ένα εργαλείο. είναι ένας συνεργάτης που κατανοεί και προσαρμόζεται στα ανθρώπινα πλαίσια, προσφέροντας λύσεις που είναι καινοτόμες και εξατομικευμένες.