Kunstig intelligens

StyleTTS 2: Tekst-til-tale på menneskeligt niveau med store talesprogmodeller

På grund af en stigning i naturlige og syntetiske talesyntesetilgange er en af de største resultater, AI-industrien har opnået i de sidste par år, at effektivt syntetisere tekst-til-tale-rammer med potentielle applikationer på tværs af forskellige industrier, herunder lydbøger, virtuelle assistenter, stemme -over fortællinger og mere, med nogle avancerede tilstande, der leverer ydeevne og effektivitet på menneskeligt niveau på tværs af en bred vifte af talerelaterede opgaver. På trods af deres stærke ydeevne er der dog stadig plads til forbedringer for opgaver takket være udtryksfuld og forskelligartet tale, krav om en stor mængde træningsdata til optimering af nul-skuds tekst til tale rammer og robusthed for OOD eller Out of Distribution-tekster, der fører udviklere til at arbejde på en mere robust og tilgængelig tekst til tale-ramme.

I denne artikel vil vi tale om StyleTTS-2, en robust og innovativ tekst-til-tale-ramme, der er bygget på grundlaget for StyleTTS-rammeværket, og har til formål at præsentere det næste skridt hen imod state-of-the-art tekst-til-tale-systemer. StyleTTS2-rammen modellerer talestile som latente tilfældige variabler og bruger en probabilistisk diffusionsmodel til at sample disse talestilarter eller tilfældige variabler, hvilket gør det muligt for StyleTTS2-rammen at syntetisere realistisk tale effektivt uden at bruge referencelyd-input. På grund af tilgangen er StyleTTS2-rammeværket i stand til at levere bedre resultater og viser høj effektivitet sammenlignet med det nuværende moderne tekst-til-tale-framework, men er også i stand til at drage fordel af den mangfoldige talesyntese, der tilbydes af diffusionsmodelrammer. Vi vil diskutere StyleTTS2-rammen mere detaljeret og tale om dens arkitektur og metodologi, mens vi også ser på de resultater, som rammen opnår. Så lad os komme i gang.

StyleTTS2 for tekst til tale syntese: en introduktion

StyleTTS2 er en innovativ tekst-til-tale-syntesemodel, der tager det næste skridt i retning af at bygge TTS-rammer på menneskeligt niveau, og den er bygget på StyleTTS, en stilbaseret tekst til talegenererende model. StyleTTS2-rammen modellerer talestile som latente tilfældige variabler og bruger en probabilistisk diffusionsmodel til at sample disse talestilarter eller tilfældige variabler, hvilket gør det muligt for StyleTTS2-rammen at syntetisere realistisk tale effektivt uden at bruge referencelyd-input. Modellering af stilarter som latente tilfældige variabler er det, der adskiller StyleTTS2-rammeværket fra dets forgænger, StyleTTS-rammeværket, og sigter mod at generere den bedst egnede talestil til inputteksten uden behov for en referencelyd-input, og er i stand til at opnå effektive latente diffusioner, mens du tager fordel af de forskellige talesyntese-funktioner, som tilbydes af diffusionsmodeller. Derudover anvender StyleTTS2-rammeværket også fortrænede store SLM- eller Speech Language Model som diskriminatorer som WavLM-rammeværket, og kobler det med sin egen nye modelleringsmetode med differentiel varighed for at træne rammen ende til anden og i sidste ende generere tale med øget naturlighed. Takket være den tilgang, den følger, udkonkurrerer StyleTTS2-rammeværket de nuværende state-of-the-art rammer for talegenereringsopgaver og er en af de mest effektive rammer til fortræning af store talemodeller i nul-shot-indstilling til højttalertilpasningsopgaver.

For at levere tekst på menneskeligt niveau til talesyntese, inkorporerer StyleTTs2-rammen læringen fra eksisterende værker, herunder diffusionsmodeller til talesyntese og store talesprogsmodeller. Diffusionsmodeller bruges normalt til talesynteseopgaver takket være deres evner til finkornet talekontrol og forskellige taleprøvetagningsmuligheder. Imidlertid er diffusionsmodeller ikke så effektive som GAN-baserede ikke-iterative rammer, og en væsentlig årsag til dette er kravet om at sample latente repræsentationer, bølgeformer og mel-spektrogrammer iterativt til målvarigheden af talen.

På den anden side har nyere værker omkring store talesprogmodeller vist deres evne til at forbedre kvaliteten af tekst til talegenereringsopgaver og tilpasse sig godt til taleren. Store talesprogmodeller konverterer typisk tekstinput enten til kvantificerede eller kontinuerlige repræsentationer afledt af forudtrænede talesprogsrammer til talerekonstruktionsopgaver. Funktionerne i disse talesprogmodeller er dog ikke optimeret til direkte talesyntese. I modsætning hertil udnytter StyleTTS2-rammeværket den viden, der er opnået af store SLM-rammer, der bruger modstridende træning til at syntetisere talesprogmodellers funktioner uden at bruge latente rumkort, og derfor optimerede det latente rum direkte ved at lære en talesyntese.

StyleTTS2: Arkitektur og metode

I sin kerne er StyleTTS2 bygget på sin forgænger, StyleTTS-rammeværket, som er et ikke-autoregressiv tekst-til-tale-rammeværk, der gør brug af en stilkoder til at udlede en stilvektor fra referencelyden, og dermed tillade udtryksfuld og naturlig talegenerering. Stilvektoren, der bruges i StyleTTS-rammen, er inkorporeret direkte i indkoderen, varigheden og forudsigelserne ved at gøre brug af AdaIN eller Adaptive Instance Normalization, hvilket gør det muligt for StyleTTS-modellen at generere taleoutput med varierende prosodi, varighed og endda følelser. StyleTTS rammeværket består af i alt 8 modeller, der er opdelt i tre kategorier

- Akustiske modeller eller talegenereringssystem med en stilkoder, en tekstkoder og en taledekoder.

- Et tekst-til-tale-forudsigelsessystem, der gør brug af prosodi og varighedsforudsigere.

- Et hjælpesystem, der inkluderer en tekstjustering, en tonehøjdeudtrækker og en diskriminator til træningsformål.

Takket være sin tilgang leverer StyleTTS-rammeværket den nyeste præstation relateret til kontrollerbar og forskelligartet talesyntese. Denne ydeevne har dog sine ulemper som forringelse af prøvekvaliteten, udtryksmæssige begrænsninger og afhængighed af talehæmmende applikationer i realtid.

StyleTTS2-modellen forbedrer StyleTTS-rammen og resulterer i forbedret udtryksevne tekst til tale opgaver med en forbedret ydeevne uden for distribution og en høj kvalitet på menneskeligt niveau. StyleTTS2-rammen gør brug af en ende til ende træningsproces, der optimerer de forskellige komponenter med modstridende træning og direkte bølgeformsyntese i fællesskab. I modsætning til StyleTTS frameworket modellerer StyleTTS2 frameworket talestilen som en latent variabel og sampler den via diffusionsmodeller og genererer således forskellige taleeksempler uden brug af en referencelyd. Lad os se nærmere på disse komponenter.

End-to-end træning for interferens

I StyleTTS2-rammeværket bruges en ende-til-ende-træningstilgang til at optimere forskellige tekst-til-tale-komponenter til interferens uden at skulle stole på faste komponenter. StyleTTS2-rammeværket opnår dette ved at modificere dekoderen til at generere bølgeformen direkte fra stilvektoren, pitch- og energikurverne og justerede repræsentationer. Rammeværket fjerner derefter det sidste projektionslag af dekoderen og erstatter det med en bølgeformsdekoder. StyleTTS2-strukturen gør brug af to encodere: HifiGAN-baseret dekoder til at generere bølgeformen direkte, og en iSTFT-baseret dekoder til at producere fase og størrelse, der konverteres til bølgeformer for hurtigere interferens og træning.

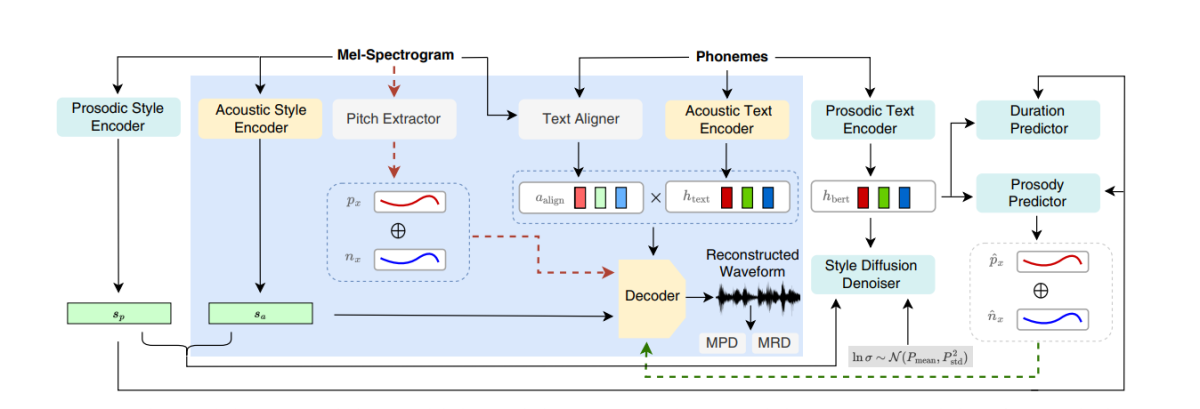

Ovenstående figur repræsenterer de akustiske modeller, der anvendes til fortræning og fællestræning. For at reducere træningstiden optimeres modulerne først i præ-træningsfasen efterfulgt af optimering af alle komponenter minus pitch extractor under fælles træning. Grunden til, at fællestræning ikke optimerer pitch-ekstrakteren, er, fordi den bruges til at give grunden til pitch-kurver.

Ovenstående figur repræsenterer talesprogmodellens modstridende træning og interferens med WavLM-rammen forudtrænet, men ikke forudindstillet. Processen adskiller sig fra den ovenfor nævnte, da den kan tage forskellige inputtekster, men akkumulerer gradienterne for at opdatere parametrene i hver batch.

Stilspredning

StyleTTS2-rammen har til formål at modellere tale som en betinget fordeling gennem en latent variabel, der følger den betingede fordeling, og denne variabel kaldes den generaliserede talestil og repræsenterer enhver karakteristik i taleeksemplet uden for omfanget af ethvert fonetisk indhold, herunder leksikalsk stress, prosodi, talehastighed og endda formantovergange.

Talesprogmodeldiskriminatorer

Talesprogmodeller er kendt for deres generelle evner til at kode værdifuld information om en lang række semantiske og akustiske aspekter, og SLM-repræsentationer har traditionelt været i stand til at efterligne menneskelige opfattelser for at evaluere kvaliteten af den genererede syntetiserede tale. StyleTTS2-rammeværket bruger en modstridende træningstilgang til at udnytte SLM-kodernes evne til at udføre generative opgaver og anvender en 12-lags WavLM-ramme som diskriminator. Denne tilgang tillader rammerne at muliggøre træning i OOD- eller Out Of Distribution-tekster, der kan hjælpe med at forbedre ydeevnen. For at forhindre problemer med overtilpasning prøver rammen desuden OOD-tekster og in-distribution med lige stor sandsynlighed.

Differentierbar varighedsmodellering

Traditionelt bruges en varighedsprædiktor i tekst-til-tale rammer, der producerer fonemvarigheder, men de opsamplingsmetoder, som disse varighedsprædiktorer bruger, blokerer ofte gradientflowet under E2E-træningsprocessen, og NaturalSpeech-rammen anvender en opmærksomhedsbaseret upsampler til menneskeligt niveau tekst til tale konvertering. StyleTTS2-rammen finder dog, at denne tilgang er ustabil under modstridende træning, fordi StyleTTS2 træner ved hjælp af differentierbar upsampling med forskellig modstridende træning uden tab af ekstra vilkår på grund af mismatch i længden på grund af afvigelser. Selvom brugen af en blød dynamisk tidsforskydningstilgang kan hjælpe med at afbøde dette misforhold, er det ikke kun beregningsmæssigt dyrt, men dets stabilitet er også et problem, når man arbejder med modstridende mål eller mel-rekonstruktionsopgaver. Derfor, for at opnå præstation på menneskeligt niveau med modstridende træning og stabilisere træningsprocessen, bruger StyleTTC2-rammen en ikke-parametrisk upsampling-tilgang. Gaussisk upsampling er en populær ikke-parametrisk upsampling-tilgang til konvertering af de forudsagte varigheder, selvom den har sine begrænsninger takket være den faste længde af Gauss-kernerne, der er forudbestemt. Denne begrænsning for Gaussisk upsampling begrænser dens evne til nøjagtigt at modellere justeringer med forskellige længder.

For at støde på denne begrænsning foreslår StyleTTC2-rammen at bruge en ny ikke-parametrisk upsampling-tilgang uden yderligere træning og i stand til at tage højde for varierende længder af justeringerne. For hvert fonem modellerer StyleTTC2-rammeværket justeringen som en tilfældig variabel og angiver indekset for den taleramme, som fonemet stemmer overens med.

Modeltræning og evaluering

StyleTTC2-rammen trænes og eksperimenteres på tre datasæt: VCTK, LibriTTS og LJSpeech. Enkelthøjttalerkomponenten i StyleTTS2-rammeværket trænes ved hjælp af LJSpeech-datasættet, der indeholder omkring 13,000+ lydprøver opdelt i 12,500 træningsprøver, 100 valideringsprøver og næsten 500 testprøver, med deres kombinerede køretid på i alt næsten 24 timer. Multihøjttalerkomponenten i rammeværket trænes på VCTK-datasættet, der består af over 44,000 lydklip med over 100 individuelle modersmål med varierende accenter, og er opdelt i 43,500 træningsprøver, 100 valideringsprøver og næsten 500 testprøver. Endelig, for at udstyre rammeværket med nul-shot tilpasningsmuligheder, trænes rammeværket på det kombinerede LibriTTS-datasæt, der består af lydklip på i alt omkring 250 timers lyd med over 1,150 individuelle højttalere. For at evaluere dens ydeevne anvender modellen to metrics: MOS-N eller Gennemsnitlig Meningsscore af Naturlighed, og MOS eller gennemsnitlig meningsscore for lighed.

Resultater

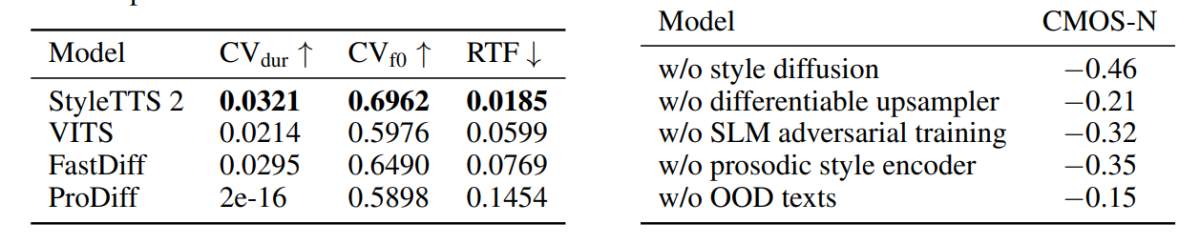

Den tilgang og metodologi, der bruges i StyleTTS2-rammeværket, vises i dens ydeevne, da modellen udkonkurrerer adskillige avancerede TTS-rammeværker, især på NaturalSpeech-datasættet, og undervejs sætter en ny standard for datasættet. Ydermere overgår StyleTTS2-rammeværket det avancerede VITS-rammeværk på VCTK-datasættet, og resultaterne er vist i følgende figur.

StyleTTS2-modellen udkonkurrerer også tidligere modeller på LJSpeech-datasættet, og den viser ikke nogen grad af kvalitetsforringelse på OOD- eller Out of Distribution-tekster, som vist af tidligere rammer på de samme metrikker. Derudover overgår StyleTTC2-modellen i nul-shot-indstilling den eksisterende Vall-E-ramme i naturlighed, selvom den falder bagud med hensyn til lighed. Det er dog værd at bemærke, at StyleTTS2-rammeværket er i stand til at opnå konkurrencedygtig præstation på trods af kun træning på 245 timers lydeksempler sammenlignet med over 60 timers træning for Vall-E-rammeværket, hvilket beviser, at StyleTTC2 er et dataeffektivt alternativ til eksisterende store fortræningsmetoder som brugt i Vall-E.

På grund af manglen på følelsesmærkede lydtekstdata bruger StyleTTC2-rammeværket GPT-4-modellen til at generere over 500 forekomster på tværs af forskellige følelser til visualisering af stilvektorer, som rammeværket skaber ved hjælp af sin diffusion proces.

I den første figur er emotionelle stilarter som svar på inputtekstfølelser illustreret af stilvektorerne fra LJSpeech-modellen, og det demonstrerer StyleTTC2-rammens evne til at syntetisere ekspressiv tale med varierede følelser. Den anden figur viser distinkte klynger for hver af de fem individuelle højttalere, hvilket viser en bred vifte af mangfoldighed hentet fra en enkelt lydfil. Den sidste figur demonstrerer den løse klynge af følelser fra højttaler 1 og afslører, at på trods af nogle overlapninger er følelsesbaserede klynger fremtrædende, hvilket indikerer muligheden for at manipulere den følelsesmæssige melodi af en højttaler uanset referencelydeksemplet og dens inputtone . På trods af brugen af en diffusionsbaseret tilgang formår StyleTTS2-rammeværket at udkonkurrere eksisterende state of the art-rammeværker, herunder VITS, ProDiff og FastDiff.

Afsluttende tanker

I denne artikel har vi talt om StyleTTS2, en ny, robust og innovativ tekst-til-tale-ramme, der er bygget på grundlaget for StyleTTS-rammeværket, og har til formål at præsentere det næste skridt hen imod state-of-the-art tekst-til-tale-systemer. StyleTTS2-rammeværket modellerer talestile som latente tilfældige variabler og bruger en probabilistisk diffusionsmodel til at sample disse talestilarter eller tilfældige variabler, hvilket gør det muligt for StyleTTS2-rammeværket at syntetisere realistisk tale effektivt uden at bruge referencelyd-input. StyleTTS2-rammeværket bruger stildiffusion og SLM-diskriminatorer at opnå præstationer på menneskeligt niveau på tekst-til-tale-opgaver og formår at udkonkurrere eksisterende state of the art-rammer på en bred vifte af taleopgaver.