Kunstig intelligens

Less Is More: Hvorfor hentning af færre dokumenter kan forbedre AI-svar

Retrieval-Augmented Generation (RAG) er en tilgang til at bygge AI-systemer, der kombinerer en sprogmodel med en ekstern videnskilde. Enkelt sagt søger AI først efter relevante dokumenter (såsom artikler eller websider) relateret til en brugers forespørgsel og bruger derefter disse dokumenter til at generere et mere præcist svar. Denne metode er blevet fejret for at hjælpe store sprogmodeller (LLM'er) forbliv faktuelle og reducere hallucinationer ved at basere deres svar på rigtige data.

Intuitivt kunne man tro, at jo flere dokumenter en AI henter, jo bedre informeret vil svaret være. Nyere forskning tyder dog på et overraskende twist: Når det kommer til at fodre information til en AI, er mindre nogle gange mere.

Færre dokumenter, bedre svar

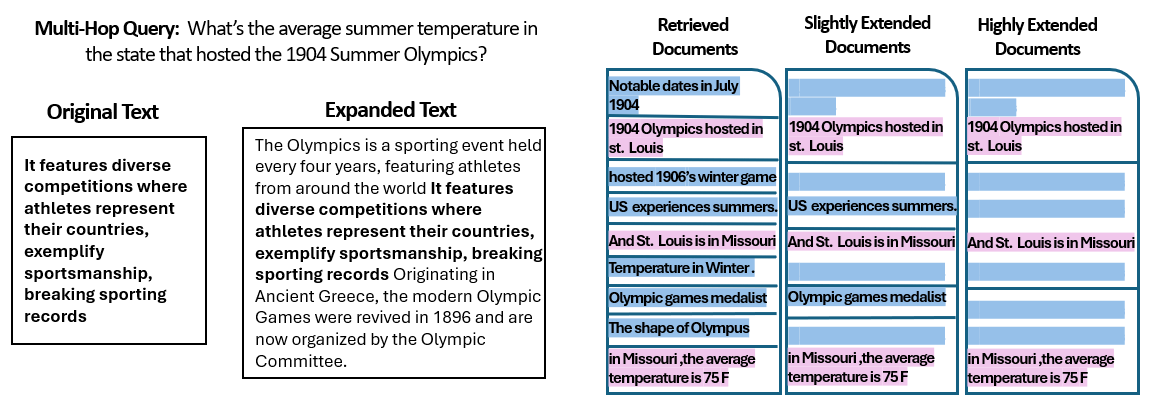

A ny undersøgelse af forskere ved det hebraiske universitet i Jerusalem undersøgt, hvordan nummer af dokumenter givet til et RAG-system påvirker dets ydeevne. Det er afgørende, at de holdt den samlede mængde tekst konstant - hvilket betyder, at hvis færre dokumenter blev leveret, blev disse dokumenter udvidet en smule til at fylde samme længde som mange dokumenter ville. På denne måde kan eventuelle præstationsforskelle tilskrives mængden af dokumenter i stedet for blot at have et kortere input.

Forskerne brugte et datasæt til besvarelse af spørgsmål (MuSiQue) med trivia-spørgsmål, hver oprindeligt parret med 20 Wikipedia-afsnit (hvoraf kun nogle få faktisk indeholder svaret, mens resten er distraktorer). Ved at trimme antallet af dokumenter fra 20 ned til kun de 2-4 virkelig relevante – og udfylde dem med lidt ekstra kontekst for at opretholde en ensartet længde – skabte de scenarier, hvor AI havde færre stykker materiale at overveje, men stadig nogenlunde det samme samlede antal ord at læse.

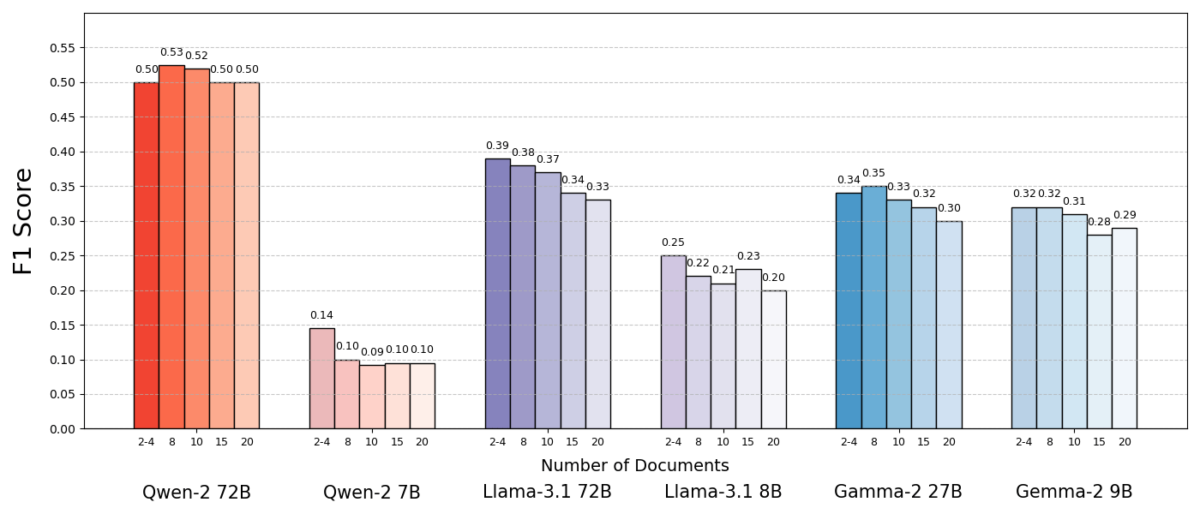

Resultaterne var slående. I de fleste tilfælde svarede AI-modellerne mere præcist, når de fik færre dokumenter frem for det fulde sæt. Ydeevnen forbedredes markant – i nogle tilfælde med op til 10 % i nøjagtighed (F1-score), når systemet kun brugte en håndfuld støttedokumenter i stedet for en stor samling. Dette kontraintuitive boost blev observeret på tværs af flere forskellige open source-sprogmodeller, inklusive varianter af Metas Llama og andre, hvilket indikerer, at fænomenet ikke er bundet til en enkelt AI-model.

En model (Qwen-2) var en bemærkelsesværdig undtagelse, der håndterede flere dokumenter uden et fald i score, men næsten alle de testede modeller klarede sig bedre med færre dokumenter generelt. Med andre ord, tilføjelse af mere referencemateriale ud over de vigtigste relevante stykker skadede faktisk deres præstation oftere, end det hjalp.

Kilde: Levy et al.

Hvorfor er det sådan en overraskelse? Typisk er RAG-systemer designet under den antagelse, at hentning af et bredere stykke information kun kan hjælpe AI'en - trods alt, hvis svaret ikke er i de første par dokumenter, kan det være i det tiende eller tyvende.

Denne undersøgelse vender det script og viser, at vilkårlig ophobning af ekstra dokumenter kan give bagslag. Selv når den samlede tekstlængde blev holdt konstant, gjorde blot tilstedeværelsen af mange forskellige dokumenter (hver med deres egen kontekst og særheder) opgaven med at besvare spørgsmål mere udfordrende for AI. Det ser ud til, at ud over et vist punkt introducerede hvert ekstra dokument mere støj end signal, hvilket forvirrede modellen og svækkede dens evne til at udtrække det korrekte svar.

Hvorfor mindre kan være mere i RAG

Dette "less is more"-resultat giver mening, når vi overvejer, hvordan AI-sprogmodeller behandler information. Når en AI kun får de mest relevante dokumenter, er konteksten, den ser, fokuseret og fri for forstyrrelser, ligesom en studerende, der har fået de helt rigtige sider til at studere.

I undersøgelsen klarede modeller sig markant bedre, når de kun fik de understøttende dokumenter, med irrelevant materiale fjernet. Den resterende kontekst var ikke kun kortere, men også renere – den indeholdt fakta, der direkte pegede på svaret og intet andet. Med færre dokumenter at jonglere med, kunne modellen vie sin fulde opmærksomhed til den relevante information, hvilket gør den mindre tilbøjelig til at blive forvirret eller forvirret.

På den anden side, når mange dokumenter blev hentet, skulle AI'en gennemse en blanding af relevant og irrelevant indhold. Ofte var disse ekstra dokumenter "lignende, men ikke-relaterede" - de deler måske et emne eller nøgleord med forespørgslen, men indeholder faktisk ikke svaret. Sådant indhold kan vildlede modellen. AI kan spilde kræfter på at forsøge at forbinde prikker på tværs af dokumenter, der faktisk ikke fører til et korrekt svar, eller endnu værre, det kan flette oplysninger fra flere kilder forkert. Dette øger risikoen for hallucinationer - tilfælde, hvor AI genererer et svar, der lyder plausibelt, men som ikke er baseret på en enkelt kilde.

I bund og grund kan tilførsel af for mange dokumenter til modellen fortynde den nyttige information og introducere modstridende detaljer, hvilket gør det sværere for AI at afgøre, hvad der er sandt.

Interessant nok fandt forskerne ud af, at hvis de ekstra dokumenter åbenlyst var irrelevante (for eksempel tilfældig ikke-relateret tekst), var modellerne bedre til at ignorere dem. Det virkelige problem kommer fra distraherende data, der ser relevante ud: når alle de hentede tekster handler om lignende emner, antager AI, at den skal bruge dem alle, og det kan være svært at se, hvilke detaljer der faktisk er vigtige. Dette stemmer overens med undersøgelsens observation tilfældige distraktorer forårsagede mindre forvirring end realistiske distraktorer i inputtet. AI kan bortfiltrere åbenlyst nonsens, men subtilt off-topic information er en smart fælde – den sniger sig ind under dække af relevans og afsporer svaret. Ved at reducere antallet af dokumenter til kun de virkelig nødvendige, undgår vi at sætte disse fælder i første omgang.

Der er også en praktisk fordel: Hentning og behandling af færre dokumenter reducerer de beregningsmæssige overhead for et RAG-system. Hvert dokument, der bliver trukket ind, skal analyseres (indlejret, læst og behandlet af modellen), som bruger tid og computerressourcer. Eliminering af overflødige dokumenter gør systemet mere effektivt – det kan finde svar hurtigere og til lavere omkostninger. I scenarier, hvor nøjagtigheden er forbedret ved at fokusere på færre kilder, får vi en win-win: bedre svar og en slankere, mere effektiv proces.

Kilde: Levy et al.

Rethinking RAG: Future Directions

Dette nye bevis på, at kvalitet ofte slår kvantitet ved genfinding, har vigtige konsekvenser for fremtiden for AI-systemer, der er afhængige af ekstern viden. Det foreslår, at designere af RAG-systemer bør prioritere smart filtrering og rangering af dokumenter over ren volumen. I stedet for at hente 100 mulige passager og håbe, at svaret er begravet derinde et sted, kan det være klogere kun at hente de øverste få yderst relevante.

Studiets forfattere understreger behovet for genfindingsmetoder for at "skabe en balance mellem relevans og mangfoldighed" i den information, de leverer til en model. Vi ønsker med andre ord at give nok dækning af emnet til at besvare spørgsmålet, men ikke så meget, at kernefakta druknes i et hav af uvedkommende tekst.

Fremover vil forskere sandsynligvis udforske teknikker, der hjælper AI-modeller med at håndtere flere dokumenter mere yndefuldt. En tilgang er at udvikle bedre retrieversystemer eller re-rankere, der kan identificere, hvilke dokumenter der virkelig tilføjer værdi, og hvilke der kun introducerer konflikt. En anden vinkel er at forbedre selve sprogmodellerne: Hvis en model (som Qwen-2) formåede at klare mange dokumenter uden at miste nøjagtigheden, kunne en undersøgelse af, hvordan den blev trænet eller struktureret, give fingerpeg til at gøre andre modeller mere robuste. Måske vil fremtidige store sprogmodeller inkorporere mekanismer til at genkende, når to kilder siger det samme (eller modsiger hinanden) og fokusere i overensstemmelse hermed. Målet ville være at gøre det muligt for modeller at bruge et rigt udvalg af kilder uden at blive offer for forvirring - effektivt at få det bedste fra begge verdener (bredde af information og klarhed i fokus).

Det er også værd at bemærke, at som AI-systemer får større kontekstvinduer (evnen til at læse mere tekst på én gang), blot at dumpe flere data i prompten er ikke en sølvkugle. Større kontekst betyder ikke automatisk bedre forståelse. Denne undersøgelse viser, at selvom en AI teknisk set kan læse 50 sider ad gangen, giver det måske ikke et godt resultat at give den 50 siders information af blandet kvalitet. Modellen drager stadig fordel af at have kurateret, relevant indhold at arbejde med, frem for et vilkårligt dump. Faktisk kan intelligent hentning blive endnu mere afgørende i æraen med gigantiske kontekstvinduer – for at sikre, at den ekstra kapacitet bruges til værdifuld viden frem for støj.

Resultaterne fra "Flere dokumenter, samme længde" (den passende titel) tilskynder til en genundersøgelse af vores antagelser inden for AI-forskning. Nogle gange er det ikke så effektivt at fodre en AI med alle de data, vi har, som vi tror. Ved at fokusere på de mest relevante informationer forbedrer vi ikke kun nøjagtigheden af AI-genererede svar, men gør også systemerne mere effektive og nemmere at stole på. Det er en kontraintuitiv lektion, men en med spændende konsekvenser: Fremtidige RAG-systemer kan være både smartere og slankere ved omhyggeligt at vælge færre, bedre dokumenter at hente.