Intel·ligència Artificial

UniTune: tècnica d'edició d'imatges neuronals alternativa de Google

Sembla que Google Research està atacant l'edició d'imatges basada en text des de diversos fronts i, presumiblement, a l'espera de veure què passa. Calent a la pista del llançament d'aquesta setmana Paper màgic, el gegant de la cerca ha proposat un mètode addicional basat en la difusió latent per dur a terme edicions basades en IA a les imatges mitjançant ordres de text, aquesta vegada anomenades UniTune.

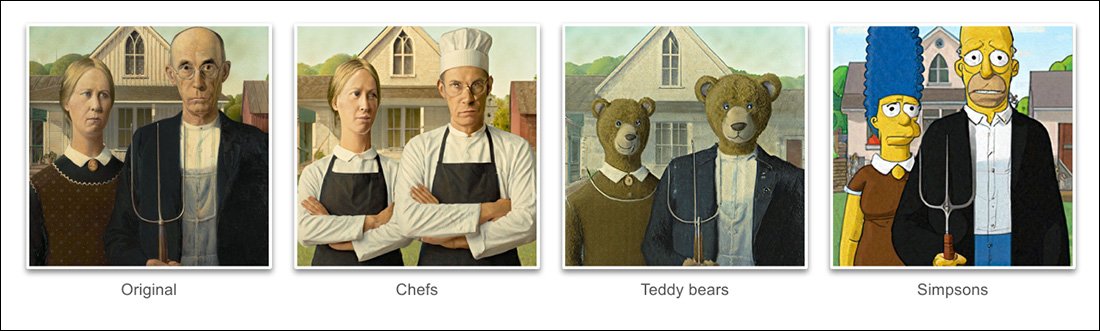

A partir dels exemples donats en el projecte nou document, UniTune ha aconseguit un grau extraordinari de desenredament de la postura i la idea semàntica del contingut real d'imatge dur:

El domini de la composició semàntica d'UniTune és excepcional. Observeu com a la fila superior d'imatges, les cares de les dues persones no s'han vist distorsionades per l'extraordinària transformació de la resta de la imatge d'origen (dreta). Font: https://arxiv.org/pdf/2210.09477.pdf

Com ja hauran après els fans de Stable Diffusion, aplicar edicions a seccions parcials d'una imatge sense alterar negativament la resta de la imatge pot ser una operació complicada, de vegades impossible. Tot i que distribucions populars com ara AUTOMÀTIC1111 pot crear màscares per a edicions locals i restringides, el procés és tortuós i sovint impredictible.

La resposta òbvia, almenys per a un practicant de visió per ordinador, és interposar una capa de segmentació semàntica que és capaç de reconèixer i aïllar objectes en una imatge sense la intervenció de l'usuari i, de fet, darrerament hi ha hagut diverses iniciatives noves en aquesta línia de pensament.

Un altre possibilitat per bloquejar les operacions d'edició d'imatges neuronals desordenades i enredades és aprofitar l'influent entrenament previ a la imatge contrastiva d'OpenAI (CLIP), que es troba al centre dels models de difusió latent com DALL-E 2 i Stable Diffusion, per actuar com a filtre en el punt en què un model de text a imatge està preparat per enviar un render interpretat a l'usuari. . En aquest context, CLIP hauria d'actuar com a mòdul sentinella i de control de qualitat, rebutjant els renders malformats o inadequats. Això és a punt de ser instituït (Enllaç de Discord) al portal impulsat per l'API DreamStudio de Stability.ai.

No obstant això, com que CLIP és, sens dubte, el culpable i la solució en aquest escenari (perquè essencialment també va informar de la forma en què va evolucionar la imatge) i com que els requisits de maquinari poden superar el que és probable que estigui disponible localment per a un usuari final, aquest enfocament pot no ser ideal.

Llenguatge comprimit

En canvi, l'UniTune proposat "afina" un model de difusió existent, en aquest cas, la pròpia Imagen de Google, tot i que els investigadors afirmen que el mètode és compatible amb altres arquitectures de difusió latent, de manera que s'hi injecta un testimoni únic que es pot convocar. inclòs-lo en un missatge de text.

A primera vista, això sona a Google DreamBooth, actualment una obsessió entre els fans i desenvolupadors de Stable Diffusion, que poden injectar personatges o objectes nous en un punt de control existent, sovint en menys d'una hora, basant-se en un grapat d'imatges font; o bé com Inversió textual, que crea fitxers "sidecar" per a un punt de control, que després es tracten com si fossin entrenats originalment en el model, i pot aprofitar els grans recursos del model modificant el seu classificador de text, donant lloc a un fitxer petit (en comparació amb el mínim de 2 GB de punts de control de DreamBooth).

De fet, afirmen els investigadors, UniTune va rebutjar ambdós enfocaments. Van trobar que Textual Inversion ometia massa detalls importants, mentre que DreamBooth "va tenir pitjor rendiment i va trigar més" que la solució que finalment es van establir.

No obstant això, UniTune utilitza el mateix enfocament semàntic "metaprompt" encapsulat que DreamBooth, amb canvis entrenats convocats per paraules úniques escollides per l'entrenador, que no xocaran amb els termes que existeixen actualment en un model de llançament públic entrenat laboriosament.

"Per dur a terme l'operació d'edició, mostrem els models afinats amb el missatge "[rare_tokens] edit_prompt" (per exemple, "beikkpic two dogs in a restaurant" o "beikkpic a minion").'

El Procés

Tot i que és desconcertant per què dos documents gairebé idèntics, pel que fa a la seva funcionalitat final, haurien d'arribar de Google la mateixa setmana, hi ha, malgrat un gran nombre de similituds entre les dues iniciatives, almenys una clara diferència entre UniTune i Imagic: aquest últim utilitza indicacions de llenguatge natural "sense comprimir" per guiar les operacions d'edició d'imatges, mentre que UniTune entrena amb fitxes d'estil DreamBooth únics.

Per tant, si estàveu editant amb Imagic i volgués fer una transformació d'aquesta naturalesa...

Del document d'UniTune: UniTune s'oposa al marc d'edició neuronal rival favorit de Google, SDEdit. Els resultats d'UniTune es troben a l'extrem dret, mentre que la màscara estimada es veu a la segona imatge des de l'esquerra.

.. a Imagic, introduïu "la tercera persona, asseguda al fons, com un simpàtic monstre pelut".

La comanda UniTune equivalent seria "El noi del darrere com [x]", On x és qualsevol paraula estranya i única que estava lligada al concepte ben entrenat associat al personatge del monstre pelut.

Mentre que diverses imatges s'alimenten a DreamBooth o Textual Inversion amb la intenció de crear una abstracció d'estil deepfake que es pot ordenar en moltes posicions, tant UniTune com Imagic alimenten una sola imatge al sistema: la imatge original i prístina.

Això és similar a la manera com han funcionat moltes de les eines d'edició basades en GAN dels darrers anys: convertint una imatge d'entrada en codis latents a l'espai latent del GAN i després adreçant aquests codis i enviant-los a altres parts de la latent. espai per a la modificació (és a dir, introduir una imatge d'una persona jove de cabell fosc i projectar-la a través de codis latents associats a "vell" o "rossa", etc.).

No obstant això, els resultats, en un model de difusió, i per aquest mètode, són bastant sorprenentment precisos en comparació i molt menys ambigus:

El procés d'afinació

El mètode UniTune bàsicament envia la imatge original a través d'un model de difusió amb un conjunt d'instruccions sobre com s'ha de modificar, utilitzant els amplis repositoris de dades disponibles entrenats al model. De fet, podeu fer-ho ara mateix amb Stable Diffusion's img2img funcionalitat, però no sense deformar o canviar d'alguna manera les parts de la imatge que preferiu mantenir.

Durant el procés UniTune, el sistema és afinard, és a dir que UniTune obliga el model a reprendre l'entrenament, amb la majoria de les seves capes descongelades (vegeu més avall). En la majoria dels casos, l'ajustament fi tancarà el conjunt general els valors de pèrdua d'un model d'alt rendiment que s'ha guanyat amb esforç a favor d'injectar o refinar algun altre aspecte que es vol crear o millorar.

No obstant això, amb UniTune sembla que el model de còpia sobre el qual s'actua, tot i que pot pesar diversos gigabytes o més, es tractarà com una "carella" col·lateral d'un sol ús i es descartarà al final del procés, havent servit un únic objectiu. Aquest tipus de tonatge de dades casual s'està convertint en una crisi d'emmagatzematge diària per als fans de DreamBooth, els models dels quals, fins i tot quan es podan, no són menys de 2 GB per subjecte.

Igual que amb Imagic, l'ajustament principal d'UniTune es produeix a les dues capes inferiors de les tres capes d'Imagen (base 64px, 64px>256px i 256px>1024px). A diferència d'Imagic, els investigadors veuen un valor potencial en l'optimització de l'afinació també per a aquesta darrera i més gran capa de superresolució (tot i que encara no ho han intentat).

Per a la capa més baixa de 64 píxels, el model està esbiaixat cap a la imatge base durant l'entrenament, amb múltiples parells duplicats d'imatge/text introduïts al sistema durant 128 iteracions amb una mida de lot de 4 i amb Adafactor com a funció de pèrdua, que funciona a una taxa d'aprenentatge de 0.0001. Encara que el Codificador T5 només es congela durant aquesta posada a punt, també es congela durant la formació primària d'Image

A continuació, es repeteix l'operació anterior per a la capa de 64>256 px, utilitzant el mateix procediment d'augment de soroll emprat a l'entrenament original d'Imagen.

mostreig

Hi ha molts mètodes de mostreig possibles mitjançant els quals es poden obtenir els canvis fets a partir del model ajustat, inclosa la guia gratuïta del classificador (CFG), un puntal també de Stable Diffusion. CFG defineix bàsicament fins a quin punt el model és lliure de "seguir la seva imaginació" i explorar les possibilitats de renderització, o bé, en configuracions més baixes, fins a quin punt hauria d'adherir-se a les dades d'origen d'entrada i fer canvis menys radicals o dramàtics. .

Igual que Textual Inversion (una mica menys amb DreamBooth), UniTune és capaç d'aplicar diferents estils gràfics a imatges originals, així com edicions més fotorealistes.

Els investigadors també van experimentar SDEditLa tècnica d''inici tardà', on s'anima el sistema a preservar els detalls originals en ser només parcialment 'sorollós' des del principi, però més aviat mantenint les seves característiques essencials. Tot i que els investigadors només van utilitzar això a la capa més baixa (64 px), creuen que podria ser una tècnica de mostreig addicional útil en el futur.

Els investigadors també van explotar prompte per demanar com a tècnica addicional basada en text per condicionar el model:

"A l'entorn "de sol·licitud a indicació", hem trobat que una tècnica que anomenem guia ràpida és especialment útil per afinar la fidelitat i l'expressivitat.

"La guia ràpida és similar a la guia gratuïta de classificador, excepte que la línia de base és una indicació diferent en lloc del model no condicionat. Això guia el model cap al delta entre les dues indicacions.'

Tanmateix, afirmen els autors, només es necessitava una orientació ràpida de tant en tant en els casos en què CFG no va aconseguir el resultat desitjat.

Un altre nou enfocament de mostreig que es va trobar durant el desenvolupament d'UniTune va ser la interpolació, on les àrees de la imatge són prou diferents perquè tant la imatge original com la imatge alterada siguin molt semblants en composició, la qual cosa permet utilitzar una interpolació més "naïf".

La interpolació pot fer que els processos de major esforç d'UniTune siguin redundants en els casos en què les àrees a transformar siguin discretes i ben marginades.

Els autors suggereixen que la interpolació podria funcionar tan bé, per a un gran nombre d'imatges d'origen objectiu, que es podria utilitzar com a paràmetre predeterminat, i també observen que té el poder d'efectuar transformacions extraordinàries en els casos en què les oclusions complexes no ho fan. s'han de negociar amb mètodes més intensius.

UniTune pot realitzar edicions locals amb o sense màscares d'edició, però també pot decidir unilateralment on col·locar les edicions, amb una combinació inusual de poder interpretatiu i essencialització robusta de les dades d'entrada d'origen:

A la imatge superior de la segona columna, UniTune, encarregada d'inserir un "tren vermell al fons" l'ha col·locat en una posició adequada i autèntica. Observeu en els altres exemples com es manté la integritat semàntica de la imatge font fins i tot enmig de canvis extraordinaris en el contingut de píxels i els estils bàsics de les imatges.

Latència

Tot i que la primera iteració de qualsevol sistema nou serà lenta, i encara que és possible que la participació de la comunitat o el compromís corporatiu (normalment no són tots dos) eventualment s'accelera i optimitzi una rutina amb molts recursos, tant UniTune com Imagic estan realitzant algunes maniobres d'aprenentatge automàtic força importants per tal de crear aquestes edicions sorprenents, i és qüestionable fins a quin punt un procés tan famós de recursos es podria reduir a l'ús domèstic, en lloc de l'accés basat en API (tot i que aquest últim pot ser més desitjable per a Google ).

De moment, el viatge d'anada i tornada des de l'entrada fins al resultat és d'uns 3 minuts en una GPU T4, amb uns 30 segons addicionals per a la inferència (segons qualsevol rutina d'inferència). Els autors admeten que es tracta d'una latència alta i difícilment es qualifica com a "interactiu", però també assenyalen que el model es manté disponible per a més edicions un cop ajustat inicialment, fins que l'usuari acabi amb el procés, la qual cosa redueix el temps d'edició. .

Publicat per primera vegada el 21 d'octubre de 2022.