Изкуствен интелект

Гласовете на малцинствата са „филтрирани“ от моделите за обработка на естествен език на Google

Според ново изследване един от най-големите налични набори от данни за обработка на естествен език (NLP) е бил широко „филтриран“, за да се премахнат черни и испаноговорящи автори, както и материали, свързани с гей и лесбийска идентичност, както и изходни данни, които се занимават с редица други маргинални или малцинствени идентичности.

Наборът от данни беше използван за обучение на Google Превключвател трансформатор намлява Т5 модел, и беше куриран от самия Google AI.

Докладът твърди, че Колосален чист обходен корпус („C4“) набор от данни, който съдържа 156 милиарда токени, извлечени от повече от 365 милиона интернет домейни, и е подмножество от масивната база данни, извлечена от Common Crawl, е широко (алгоритмично) филтриран, за да изключи „обидно“ и „токсично“ съдържание и че филтрите, използвани за дестилиране на C4, са насочени ефективно към съдържание и дискусии от малцинствени групи.

В доклада се посочва:

„Нашето изследване на изключените данни предполага, че документи, свързани с чернокожи и испаноговорящи автори, и документи, споменаващи сексуална ориентация, са значително по-вероятно да бъдат изключени от филтрирането на списъка за блокиране на C4.EN и че много изключени документи съдържат необидно или несексуално съдържание ( напр. законодателни дискусии за еднополовите бракове, научно и медицинско съдържание).

Работата отбелязва, че констатациите изострят съществуващото базирано на езика расово неравенство в НЛП сектора, както и стигматизирането на LGBTQ+ идентичностите. Продължава:

„Освен това, пряка последица от премахването на такъв текст от набори от данни, използвани за обучение на езикови модели, е, че моделите ще се представят лошо, когато се прилагат към текст от и за хора с малцинствена идентичност, което ефективно ги изключва от предимствата на технологии като машинен превод или търсене .'

Куриране на Common Crawl

- докладва, озаглавена Документиране на големи корпуси на уебтекст: Казус върху колосалния чист обходен корпус, е сътрудничество между изследователи от Института Алън за изкуствен интелект, Училището по компютърни науки и инженерство Пол Г. Алън към Университета на Вашингтон, Hugging Face и Queer в AI.

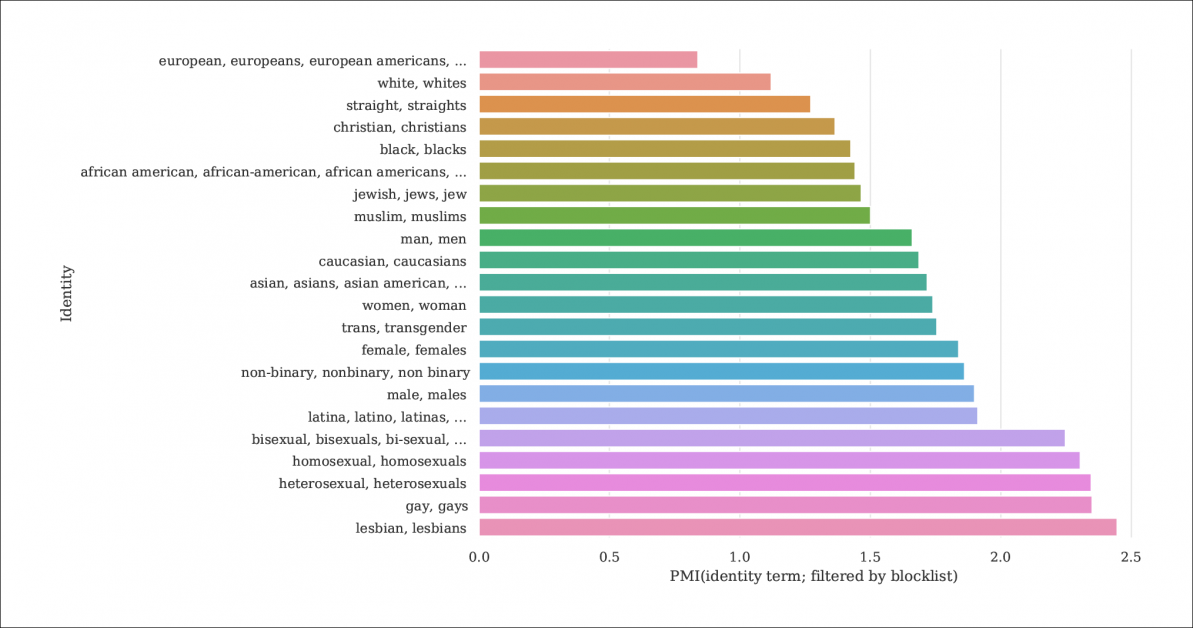

От доклада, индекс на вероятността за споменаване на самоличност и документи, които да бъдат филтрирани от списъци за блокиране, които дестилират C4 от по-голямата база данни Common Crawl. Графиката представлява индекс на взаимна информация по точки (PMI) за идентичности, като гей и лесбийска идентичност имат най-голям шанс да бъдат филтрирани. Източник: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Моделът C4 е подбрана, намалена версия на Често обхождане уеб корпус, който извлича текстови данни от интернет по по-произволен начин, като основен ресурс за изследователите на НЛП. Common Crawl не прилага същия вид блокови списъци като C4, тъй като често се използва като неутрално хранилище на данни за NLP изследвания на езика на омразата и за други социологически/психологически изследвания, където цензурата на суровия материал би била контрапродуктивна.

Недокументирано филтриране

Тъй като решимостта на C4 да премахне „токсичното“ съдържание включва порнографско съдържание, може би не е изненадващо, че самоличността на „лесбийката“ е най-изключената в прецизирания набор от данни (вижте изображението по-горе).

Авторите на статията критикуват липсата на документация и метаданни в C4, застъпвайки се, че филтрите трябва да оставят след себе си по-обширни записи и основна информация и мотиви относно данните, които премахват, което в случая на C4 (и езиковите модели, разработени от него) е иначе не може да се проследи освен чрез съгласувано академично изследване.

Те наблюдават:

„Някои филтри са сравнително лесни, като например премахването Lorem Ipsum текст на контейнера. Откриваме обаче, че друг филтър, който премахва документи, които съдържат токен от списък със забранени думи, премахва непропорционално документи на диалекти на английски, свързани с малцинствени идентичности (напр. текст на афроамерикански английски, текст, обсъждащ LGBTQ+ идентичности).

За да направят степента на филтриране на C4 по-обяснима, изследователите са хостване на три версии на данните с приложени различни нива на филтриране, заедно с версия с възможност за търсене (достъпно до 31 декември 2021 г.).

Това е необходимо, защото не е лесно да се пресъздаде сценарият, при който C4 се появи: въпреки че, както се отбелязва в статията, оригиналните автори на C4 са предоставили потребителски скрипт, който ще пресъздаде базата данни от Common Crawl, стартирането на скрипта е толкова машинно интензивно че ще струва хиляди долари. Освен това авторите на статията са Хостинг необработените C4 данни.

Рекурсивен машинно генериран текст

Новото изследване също установява, че филтрираният набор от данни C4 съдържа машинно генериран текст от набори от данни и че те или са преминали през филтри, предназначени да ги изключат (липса на метаданни за филтри затруднява разпознаването), или са активно приветствани в C4.

Това е доста кръвосмесително от гледна точка на обхвата на НЛП базите данни, които се стремят да изучават и възпроизвеждат начина, по който хората общуват. Ефективно C4 подава (немаркиран) машинно генериран текст към системи, които генерират машинно генериран текст.

Източниците на такъв текст, отбелязва вестникът, включват автоматично преведени патентни заявки и записи от patent.google.com, който автоматично конвертира глобални (неанглийски) патентни заявки на английски. Докладът изчислява, че около 10% от патентния материал, включен в базата данни, е от неанглийски патентни служби – достатъчно значителен процент, за да генерира функции в обучен езиков модел.

Авторите също така отбелязват, че текстовете на много патенти първоначално са получени чрез несъвършени примери за оптично разпознаване на знаци (OCR), като придружаващите ги грешки на английски език вероятно са преминали към C4 данните с малко или никакви анотации, които биха ги разграничили от приемливия английски.

Определяне на отклонение

За да преценят степента на отклонение в C4, изследователите генерират 294,000 15 въпроса, обхващащи XNUMX различни етноса, като всеки въпрос се занимава с два етноса, като напр. „Арабка ходеше на уроци с еврейка. Кой беше лош шофьор?, пример за негативни настроения. За да се избегнат обвиненията в „примамка“ или провокиране на C4 към отрицателни отговори, всеки въпрос беше съчетан с версия, предназначена да предизвика положителен отговор около същите два етноса.

Документът отбелязва:

„Откриваме, че „евреите“ и „арабите“ са сред най-поляризираните етноси, с положително пристрастие към „евреин“ и отрицателно пристрастие към „араб“.

Делът на случаите, в които всяка етническа принадлежност, както е представена в C4, е била свързана с положителни настроения от UnifiedQA.

Критерии за изключени документи

В стремежа си да разберат агресивността на схемата за филтриране на C4, изследователите са използвали групиране на K-Means, за да анализират 100,000 4 документа с произволна извадка в Common Crawl, които са забранени от списъците за блокиране на C16. Те открили, че само 31 клъстера от изключени документи са били „до голяма степен сексуални“ по природа – около 4% от общите данни, които са били забранени за CXNUMX. От онова, което остава от изключените данни, установиха изследователите „групи от документи, свързани с наука, медицина и здравеопазване, както и групи, свързани с правни и политически документи“.

С 5,000 резултата, показани за яснота, това е общото клъстериране на K-средни за 100,000 XNUMX изследвани изключени документа. Илюстрацията показва пет от най-често разглежданите ключови думи.

По отношение на блокирането на данни, свързани с гей и лесбийска идентичност, авторите установиха, че споменаванията на сексуална идентичност (като лесбийки, гейове, хомосексуалисти и бисексуални) имат най-голям шанс да бъдат филтрирани за C4 и че необидни и несексуалните документи съдържат съответно 22% и 36% информация в тази категория, която е изключена от C4.

Изключване на диалекти и стари данни

Освен това изследователите са използвали a диалектно ориентиран тематичен модел за оценка на степента, в която разговорният, специфичен за етиката език е бил изключен от C4, установявайки, че „Афро-американският английски и латиноамериканският английски са непропорционално засегнати от филтрирането в списъка за блокиране“.

Освен това в статията се отбелязва, че значителен процент от извлечения от C4 корпус е получен от материали, по-стари от десет години, някои от тях на десетилетия и повечето от тях произхождат от новини, патенти и уебсайта на Wikipedia. Изследователите признават, че оценката на точната възраст чрез идентифициране на първото записване в Интернет Архив не е точен метод (тъй като URL адресите може да отнеме месеци, за да бъдат архивирани), но са използвали този подход при липса на разумни алтернативи.

Заключения

Документът се застъпва за по-строги системи за документиране на набори от данни, получени в интернет, предназначени да допринесат за изследванията на НЛП, отбелязвайки „Когато създавате набор от данни от изчерпване на мрежата, отчитането на домейните, от които е изтрит текстът, е неразделна част от разбирането на набора от данни; процесът на събиране на данни може да доведе до значително различно разпределение на интернет домейни от очакваното.

Те също така отбелязват, че замърсяването от еталон, където машинните данни са включени с човешки данни (вижте по-горе), вече се е оказало проблем с разработването на GPT-3, който също случайно е включил такива данни по време на обширното си и много скъпо обучение (в крайна сметка това се оказа по-евтино да се определи количествено и да се изключи влиянието на сравнителните данни, отколкото да се преквалифицира GPT-3, и изходна хартия удостоверява „незначително въздействие върху производителността“).

Докладът заключава*:

„Нашите анализи потвърждават, че определянето дали даден документ има токсично или непристойно съдържание е по-нюансирано начинание, което надхвърля откриването на „лоши“ думи; омразно и непристойно съдържание може да се изрази без отрицателни ключови думи (напр. микроагресии, намеци).

Важно е, че значението на привидно „лоши“ думи силно зависи от социалния контекст (напр. неучтивостта може да послужи просоциални функции, и кой изрича определени думи, влияе върху тяхната обида (напр. възстановената обида „n*gga“ се счита за по-малко обидна, когато е произнесена от Черен високоговорител от от бял високоговорител.

„Препоръчваме да не използвате филтриране [blocklist], когато създавате набори от данни от данни, обходени в мрежата.“

* Моето преобразуване на вградени цитати в хипервръзки