Изкуствен интелект

LoReFT: Фина настройка на представянето за езикови модели

Параметрно ефективната фина настройка или методите на PeFT се стремят да адаптират големи езикови модели чрез актуализации към малък брой тегла. По-голямата част от съществуващата работа по интерпретация обаче показа, че представянията кодират семантично богата информация, което предполага, че може да е по-добра и по-мощна алтернатива за редактиране на тези представяния. Предварително обучените големи модели често са фино настроени, за да бъдат използвани за нови домейни или задачи, и по време на процеса на фина настройка единичен базов модел може да бъде адаптиран към голямо разнообразие от задачи дори само с малки количества налични данни в домейна към модела. Процесът на фина настройка на цял модел обаче отнема ресурси и е скъп, особено за езикови модели със значително по-голям брой размери и параметри.

Параметрно ефективната фина настройка или методите PeFT предлагат да се справят с високите разходи, свързани с фината настройка на целия модел чрез актуализиране само на малка част от наличните общи тегла, процес, който помага за намаляване на времето за обучение заедно с използването на паметта. По-важното е, че параметрно ефективната фина настройка или методите PeFT са показали подобна производителност на фината настройка в няколко практически настройки. Адаптерите, често срещано семейство от методи за фина настройка с ефективни параметри или PeFT, научават редакция, която може да бъде добавена към допълнителен набор от тегла, които работят заедно със замразения базов модел, като последните адаптери като LoRA намаляват броя на обучаемите параметри в наученото актуализации на теглото чрез използване на приближения с нисък ранг вместо матрици с пълно тегло при обучение на адаптерите.

С предишни работи, демонстриращи редактиране на представяния, може да бъде по-добра алтернатива на параметрно ефективната фина настройка или PeFT методи, в тази статия ще говорим за методи за фина настройка на представяне или ReFT, които работят върху замразен модел и ще научим специфични за задачата интервенции върху скрити репрезентации. Тази статия има за цел да покрие в дълбочина рамката за фина настройка на ReFt или представянето и ние изследваме механизма, методологията, архитектурата на рамката заедно с нейното сравнение с най-съвременните рамки. Така че да започваме.

ReFT: Фина настройка на представянето за езикови модели

В опит да приемат предварително обучени езикови модели за нови домейни и задачи, настоящите рамки прецизират често тези предварително обучени езикови модели, тъй като с внедрения процес на фина настройка единичен базов модел може да бъде адаптиран дори към различни задачи когато работите с малко количество данни в домейна. Въпреки че процесът на фина настройка повишава цялостната производителност, това е скъп процес, особено ако езиковият модел има значително голям брой параметри. За да се справите с този проблем и да намалите свързаните с това разходи, PeFT или Parameter-efficient рамки за фина настройка актуализирайте само малка част от общите тегла, процес, който не само намалява времето за обучение, но също така намалява използването на паметта, позволявайки на рамките на PeFT да постигнат подобна производителност в сравнение с подходите за пълна фина настройка в практически сценарии. Адаптерите, често срещано семейство от PeFTs, работят чрез изучаване на редакция, която може да бъде добавена към допълнителен набор от тежести заедно с подгрупа от тежести, които работят в унисон с базовия модел със замразени тежести. Скорошни адаптерни рамки като LoRA и QLoRA демонстрираха, че е възможно да се обучат адаптери с пълна точност върху модели с намалена точност, без това да повлияе на производителността. Адаптерите обикновено са по-ефективни и ефективни в сравнение с други методи, които въвеждат нови компоненти на модела.

Основен акцент на текущото състояние на техниката Параметрно-ефективни рамки за фина настройка е, че вместо да модифицират представяния, те модифицират тегла. Въпреки това, рамки, занимаващи се с интерпретируемостта, показаха, че представянията кодират богата семантична информация, което предполага, че редактирането на представяния може да бъде по-добър и по-мощен подход в сравнение с актуализациите на теглото. Това предположение, че редактирането на представяния е по-добрият подход, е това, което формира основата на ReFT или рамката за фина настройка на представянето, която обучава интервенции, вместо да адаптира теглата на модела, позволявайки на модела да манипулира малка част от всички представяния в опит да управлява поведението на модела за решаване на задачи надолу по веригата по време на извод. ReFT или методите за фина настройка на представянето са незаменими заместители на базирани на тегло PeFT или рамки за фина настройка с ефективни параметри. Подходът ReFT черпи вдъхновение от скорошни модели, работещи с голяма интерпретируемост на модела, който се намесва в представянията, за да намери верни причинно-следствени механизми и насочва поведението на модела по време на извод, и следователно може да се разглежда като обобщение на моделите за редактиране на представяне. Изграждайки същото, LoReFT или подпространство от нисък ранг ReFT е силен и ефективен екземпляр на ReFT и е параметризация на ReFT, която се намесва върху скрити представяния в линейното пространство, обхванато от проекционна матрица от нисък ранг, и надгражда директно върху DAS или рамка за търсене на разпределено подравняване.

Движейки се, за разлика от пълната фина настройка, PeFT или рамката за фина настройка, ефективна от параметрите, обучава само малка част от параметрите на модела и успява да адаптира модела към задачи надолу по веригата. Параметрно ефективната рамка за фина настройка може да бъде класифицирана в три основни категории:

- Базирани на адаптер методи: Базираните на адаптери методи обучават допълнителни модули като напълно свързани слоеве върху предварително обучения модел със замразени тежести. Серийните адаптери вмъкват компоненти между многослойния персептрон или MLP и LM или слоевете за внимание на голям модел, докато паралелните адаптери добавят модули заедно със съществуващите компоненти. Тъй като адаптерите добавят нови компоненти, които не могат лесно да бъдат сгънати в съществуващи моделни тежести, те представляват допълнителна тежест по време на извода.

- LoRA: LoRA заедно със своите скорошни варианти приближават допълнителни тегла по време на обучение чрез използване на матрици от нисък ранг и не изискват допълнителни разходи по време на извод, тъй като актуализациите на теглото могат да бъдат обединени в модела и това е причината, поради която те се считат за текущи най-силните PeFT рамки.

- Методи, базирани на подкана: Методите, базирани на подкана, добавят меки токени, които се инициализират на случаен принцип във входа, и обучават техните вграждания, като същевременно запазват теглата на езиковия модел замразени. Производителността, предлагана от тези методи, често не е задоволителна, когато се сравнява с други PeFT подходи, и те също носят значителни режийни разходи за изводи.

Вместо да актуализира теглата, ReFT рамката научава интервенции за модифициране на малка част от общите представяния. Освен това, неотдавнашни разработки по инженерство на представяне и управление на активирането показаха, че добавянето на фиксирани управляващи вектори към остатъчния поток може да улесни известна степен на контрол върху предварително обучените поколения големи модели, без да изисква интензивни ресурси фина настройка. Други рамки са показали, че редактирането на представяния с научена операция за мащабиране и транслация може да се опита да съвпадне, но не и да надмине производителността, предлагана от LoRA адаптерите при широк набор от задачи с по-малко научени параметри. Освен това, успехът на тези рамки в редица задачи показа, че представянията, въведени от предварително обучени езикови модели, носят богата семантика, въпреки че производителността на тези модели е неоптимална, което води до продължаване на PeFT като най-съвременния подход без допълнителна тежест за изводи.

ReFT: Методология и архитектура

За да запази процеса на запазване на стила прост, рамката ReFT приема голям модел, базиран на трансформатор, като свой целеви модел, който е способен да произвежда контекстуализирано представяне на последователност от токени. За дадена последователност с n брой входни токени ReFT рамката първо вгражда тези входни токени в списък от представяния, след което m слоя изчисляват последователно списъка със скрити представяния като функция на предишния списък със скрити представяния. Всяко скрито представяне е вектор и езиковият модел използва окончателните скрити представяния, за да създаде прогнозите. Рамката ReFT разглежда както маскирани езикови модели, така и авторегресивни езикови модели. Сега, според хипотезата за линейното представяне, в невронните мрежи концепциите са кодирани в линейните подпространства на представянията. Последните модели установиха, че това твърдение е вярно в моделите на невронни мрежи, обучени на естествен език, заедно с други входни разпределения.

Освен това, в проучванията за интерпретируемост, случайната рамка на абстракция използва интервенции за обмен, за да установи небрежно ролята на компонентите на невронната мрежа при прилагане на определени поведения. Логиката зад интервенцията за обмен е, че ако някой фиксира представяне на това, което би било за съпоставителен вход, и тази намеса засяга изхода на модела последователно по начина, по който твърденията, направени от рамката ReFT относно компонента, отговорен за производството това представяне, тогава компонентът играе причинно-следствена роля в поведението. Въпреки че има няколко метода, интервенцията за разпределен обмен е идеалният подход за тестване дали дадена концепция е кодирана в линейно подпространство на представяне, както се твърди от хипотезата за линейно представяне. Освен това, методът DAS е бил използван преди това за намиране на линейно представяне в езикови модели на атрибути на обекти, настроения, езикови характеристики и математически разсъждения. Няколко експеримента обаче показаха, че DAS методът е силно експресивен и притежава способността да намира причинно-следствени ефективни подпространства, дори когато езиковият модел на трансформатора е инициализиран на случаен принцип и следователно тепърва ще се учи на всякакви специфични за задачата представяния, което води до дебат дали DAS е ефективен и достатъчно отговорен за задачи по тълкуване.

Експресивността, предлагана от DAS, предполага, че подходът може да бъде идеален инструмент за контролиране на поведението на езиковия модел, заедно с неговата работа по контролируемо генериране и отговорно редактиране. Следователно, за да адаптира езиковите модели за задачи надолу по веригата, рамката ReFT използва операцията за намеса на разпределен обмен, за да направи нов метод с ефективен параметър. Освен това, методът ReFT е набор от интервенции и рамката налага, че за всеки две интервенции, които работят на един и същ слой, позициите на интервенция трябва да бъдат разделени, като параметрите на всички интервенционни функции остават независими. В резултат на това ReFT е обща рамка, която обхваща интервенции върху скрити представяния по време на преминаването напред на модела.

ReFT: Експерименти и резултати

За да оцени своята производителност спрямо съществуващите рамки PEFT, рамката ReFT провежда експерименти в четири различни бенчмарка за обработка на естествен език и обхваща над 20 набора от данни, като основната цел е да предостави богата картина на това как рамката LoReFT се представя в различни сценарии. Освен това, когато LoReFT рамката се внедри в реалния живот, разработчиците трябва да решат колко интервенции да научат заедно с входните позиции и слоеве, върху които да приложат всяка от тях. За да изпълни задачата, рамката ReFT настройва четири хиперпараметъра.

- Броят позиции на префикса, върху които да се намеси.

- Броят позиции на суфикса, върху които да се намеси.

- Върху какъв набор от слоеве да се намеси.

- Дали да се обвържат или не параметрите за намеса в различни позиции в един и същи слой.

Правейки това, рамката ReFT опростява пространството за търсене на хиперпараметри и осигурява само фиксирани допълнителни разходи за извод, които не се мащабират с дължината на подканата.

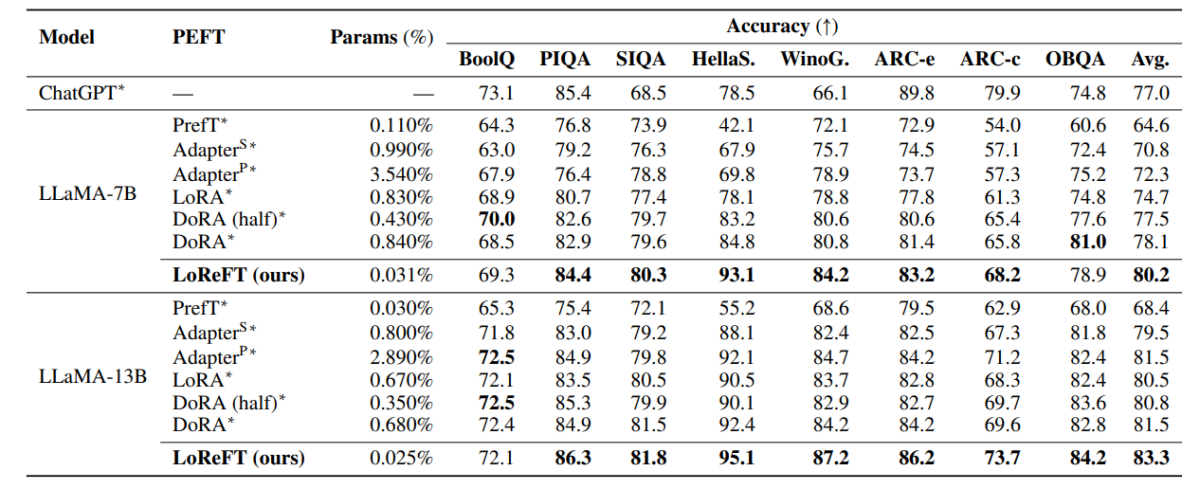

Таблицата по-горе сравнява точността на рамките LLaMA-7B и LLaMA-13B спрямо съществуващите PEFT модели в 8 набора от данни за разумни разсъждения. Както може да се види, моделът LoReFT превъзхожда съществуващите подходи на PEFT с прилична разлика, въпреки че има много по-малко параметри, като средната производителност на три изпълнения се отчита с различни начални параметри за модела LoReFT. Param(%) се изчислява чрез разделяне на броя на обучаемите параметри на броя на общите параметри на основния голям модел.

Таблицата по-горе обобщава сравнението на точността на рамките на LLaMA-7B и LLaMA-13B спрямо съществуващите PEFT модели в 4 различни набора от данни за аритметично разсъждение, като рамката отчита средната производителност на три изпълнения с различни произволни семена. Както може да се види, въпреки че има много по-малко параметри (%), LoReFT рамката превъзхожда съществуващите PEFT рамки със значителна разлика.

Таблицата по-горе обобщава сравнението на точността на RoBERTa-base и RoBERTa-large frameworks срещу съществуващи PEFT модели в GLUE бенчмарка, като рамката отчита средната производителност на пет изпълнения с различни произволни семена. Както може да се види, въпреки че има много по-малко параметри (%), LoReFT рамката превъзхожда съществуващите PEFT рамки със значителна разлика.

Заключителни мисли

В тази статия говорихме за LoReFT, мощна алтернатива на съществуващите PEFT рамки, която постига силна производителност при бенчмаркове от четири различни домейна, като същевременно предлага до 50 пъти ефективността, предлагана от предишните най-съвременни PEFT модели. Предварително обучените големи модели често са фино настроени, за да бъдат използвани за нови домейни или задачи, и по време на процеса на фина настройка единичен базов модел може да бъде адаптиран към голямо разнообразие от задачи дори само с малки количества налични данни в домейна към модела. Процесът на фина настройка на цял модел обаче отнема ресурси и е скъп, особено за езикови модели със значително по-голям брой размери и параметри. Параметрно ефективната фина настройка или методите PeFT предлагат да се справят с високите разходи, свързани с фината настройка на целия модел чрез актуализиране само на малка част от наличните общи тегла, процес, който помага за намаляване на времето за обучение заедно с използването на паметта. За отбелязване е, че LoReFT установява ново най-съвременно представяне на разумни разсъждения, следване на инструкции и разбиране на естествен език срещу най-силните PEFT.