موجه الهندسة

فهم الضبط الدقيق للماجستير في القانون: تصميم نماذج لغوية كبيرة وفقًا لمتطلباتك الفريدة

بينما نقف في سبتمبر 2023، لا يزال مشهد النماذج اللغوية الكبيرة (LLMs) يشهد ظهور النماذج بما في ذلك Alpaca وFalcon و اللاما 2وGPT-4 وغيرها الكثير.

يكمن أحد الجوانب المهمة للاستفادة من إمكانات حاملي شهادات LLM في عملية الضبط الدقيق، وهي استراتيجية تسمح بتخصيص النماذج المدربة مسبقًا لتلبية مهام محددة بدقة. ومن خلال هذا الضبط الدقيق، يمكن لهذه النماذج أن تتوافق حقًا مع المتطلبات الفردية، وتقدم حلولًا مبتكرة ومصممة خصيصًا لتلبية الاحتياجات الفريدة.

ومع ذلك، فمن الضروري ملاحظة أنه ليست كل طرق الضبط الدقيق متساوية. على سبيل المثال، يأتي الوصول إلى إمكانيات الضبط الدقيق لـ GPT-4 بسعر أعلى، ويتطلب اشتراكًا مدفوعًا أغلى نسبيًا مقارنة بالخيارات الأخرى المتاحة في السوق. ومن ناحية أخرى، فإن المجال مفتوح المصدر يعج بالبدائل التي توفر مسارًا أكثر سهولة لتسخير قوة نماذج اللغات الكبيرة. تعمل هذه الخيارات مفتوحة المصدر على إضفاء الطابع الديمقراطي على الوصول إلى تكنولوجيا الذكاء الاصطناعي المتقدمة، وتعزيز الابتكار والشمولية في مشهد الذكاء الاصطناعي سريع التطور.

لماذا يعد الضبط الدقيق لـ LLM مهمًا؟

يعد الضبط الدقيق لـ LLM أكثر من مجرد تحسين تقني؛ إنه جانب حاسم في تطوير نموذج LLM الذي يسمح بتطبيق أكثر تحديدًا ودقة في المهام المختلفة. يعمل الضبط الدقيق على ضبط النماذج المدربة مسبقًا لتناسب مجموعات بيانات محددة بشكل أفضل، مما يعزز أدائها في مهام معينة ويضمن تطبيقًا أكثر استهدافًا. إنه يبرز القدرة الرائعة لـ LLMs على التكيف مع البيانات الجديدة، مما يعرض المرونة التي تعتبر حيوية في الاهتمام المتزايد باستمرار بتطبيقات الذكاء الاصطناعي.

يفتح الضبط الدقيق لنماذج اللغات الكبيرة الكثير من الفرص، مما يسمح لهم بالتفوق في مهام محددة تتراوح من تحليل المشاعر إلى مراجعة الأدبيات الطبية. من خلال ضبط النموذج الأساسي على حالة استخدام محددة، فإننا نفتح إمكانيات جديدة، مما يعزز كفاءة النموذج ودقته. علاوة على ذلك، فإنه يسهل الاستخدام الأكثر اقتصادا لموارد النظام، حيث يتطلب الضبط الدقيق قوة حسابية أقل مقارنة بتدريب النموذج من الصفر.

بينما نتعمق في هذا الدليل، سنناقش تعقيدات الضبط الدقيق لـ LLM، مما يمنحك نظرة شاملة تعتمد على أحدث التطورات وأفضل الممارسات في هذا المجال.

الضبط الدقيق القائم على التعليمات

مرحلة الضبط الدقيق في الذكاء الاصطناعي التوليدي وتتميز دورة الحياة، الموضحة في الشكل أدناه، بتكامل مدخلات ومخرجات التعليمات، مقترنة بأمثلة للاستدلال خطوة بخطوة. يسهل هذا النهج النموذج في توليد استجابات ليست ذات صلة فحسب، بل تتماشى أيضًا بدقة مع التعليمات المحددة التي يتم إدخالها فيه. خلال هذه المرحلة يتم تكييف النماذج المدربة مسبقًا لحل المهام وحالات الاستخدام المتميزة، وذلك باستخدام مجموعات البيانات المخصصة لتعزيز وظائفها.

الضبط الدقيق لمهمة واحدة

يركز الضبط الدقيق للمهمة الواحدة على صقل خبرة النموذج في مهمة محددة، مثل التلخيص. يعد هذا الأسلوب مفيدًا بشكل خاص في تحسين سير العمل الذي يتضمن مستندات كبيرة أو سلاسل محادثات، بما في ذلك المستندات القانونية وتذاكر دعم العملاء. ومن اللافت للنظر أن هذا الضبط الدقيق يمكن أن يحقق تحسينات كبيرة في الأداء من خلال مجموعة صغيرة نسبيًا من الأمثلة، تتراوح من 500 إلى 1000، على النقيض من مليارات الرموز المميزة المستخدمة في مرحلة ما قبل التدريب.

أسس LLM الضبط الدقيق LLM: هندسة المحولات وما بعدها

تبدأ رحلة فهم الضبط الدقيق لـ LLM بفهم العناصر الأساسية التي تشكل LLM. في قلب هذه النماذج يكمن هندسة المحولات، وهي شبكة عصبية تعمل على تعزيز آليات الاهتمام الذاتي لإعطاء الأولوية لسياق الكلمات على مدى قربها في الجملة. يسهل هذا النهج المبتكر فهمًا أعمق للعلاقات البعيدة بين الرموز المميزة في الإدخال.

بينما نتنقل عبر تعقيدات المحولات، نواجه عملية متعددة الخطوات تبدأ بالمشفر. تتضمن هذه المرحلة الأولية ترميز المدخلات وإنشاء ناقلات التضمين التي تمثل المدخلات وموضعها في الجملة. تتضمن المراحل اللاحقة سلسلة من الحسابات باستخدام المصفوفات المعروفة باسم سؤال, بعد التخفيضو القفل، وبلغت ذروتها في درجة الاهتمام الذاتي التي تملي التركيز على أجزاء مختلفة من الجملة والرموز المختلفة.

يمثل الضبط الدقيق مرحلة حرجة في تطوير LLMs، وهي عملية تستلزم إجراء تعديلات دقيقة لتحقيق المزيد من المخرجات المرغوبة. هذه المرحلة، على الرغم من أهميتها، تقدم مجموعة من التحديات، بما في ذلك المتطلبات الحسابية والتخزينية للتعامل مع عدد كبير من المعلمات. يوفر الضبط الدقيق الفعال للمعلمات (PEFT) تقنيات لتقليل عدد المعلمات المطلوب ضبطها بدقة، وبالتالي تبسيط عملية التدريب.

التدريب المسبق للماجستير في القانون: إنشاء قاعدة قوية

في المراحل الأولى من تطوير LLM، يحتل التدريب المسبق مركز الصدارة، وذلك باستخدام المحولات ذات المعلمات الزائدة كبنية أساسية. تتضمن هذه العملية نمذجة اللغة الطبيعية بطرق مختلفة مثل ثنائية الاتجاه، أو الانحدار الذاتي، أو التسلسل إلى التسلسل على نطاق واسع غير خاضع للرقابة. الهدف هنا هو إنشاء قاعدة يمكن ضبطها لاحقًا لمهام محددة في المراحل النهائية من خلال تقديم أهداف خاصة بالمهمة.

وهناك اتجاه جدير بالملاحظة في هذا المجال وهو الزيادة الحتمية في حجم ماجستير إدارة الأعمال المدربين مسبقًا، والذي يتم قياسه بعدد المعلمات. تظهر البيانات التجريبية باستمرار أن النماذج الأكبر حجمًا المقترنة بمزيد من البيانات تؤدي دائمًا إلى أداء أفضل. على سبيل المثال، وضع GPT-3، بمعلماته البالغ عددها 175 مليارًا، معيارًا في توليد لغة طبيعية عالية الجودة وتنفيذ مجموعة واسعة من المهام الصفرية بكفاءة.

الضبط الدقيق: الطريق إلى التكيف مع النموذج

بعد التدريب المسبق، يخضع برنامج LLM للضبط الدقيق للتكيف مع مهام محددة. على الرغم من الأداء الواعد الذي أظهره التعلم في السياق في ماجستير إدارة الأعمال المدربين مسبقًا مثل GPT-3، يظل الضبط الدقيق متفوقًا في الإعدادات الخاصة بالمهمة. ومع ذلك، فإن النهج السائد المتمثل في الضبط الدقيق للمعلمات بالكامل يمثل تحديات، بما في ذلك المتطلبات الحسابية والذاكرة العالية، خاصة عند التعامل مع النماذج واسعة النطاق.

بالنسبة لنماذج اللغات الكبيرة التي تحتوي على أكثر من مليار معلمة، تعد الإدارة الفعالة لذاكرة الوصول العشوائي GPU أمرًا محوريًا. تتطلب معلمة نموذج واحد بدقة 32 بت الكاملة 4 بايت من المساحة، وهو ما يترجم إلى متطلبات 4 جيجابايت من ذاكرة الوصول العشوائي GPU فقط لتحميل نموذج معلمة يحتوي على مليار واحد. تتطلب عملية التدريب الفعلية المزيد من الذاكرة لاستيعاب المكونات المختلفة بما في ذلك حالات المحسن والتدرجات، مما قد يتطلب ما يصل إلى 1 جيجابايت من ذاكرة الوصول العشوائي GPU لنموذج بهذا المقياس.

للتغلب على قيود ذاكرة الوصول العشوائي GPU، يتم استخدام التكميم وهي تقنية تقلل من دقة معلمات النموذج، وبالتالي تقليل متطلبات الذاكرة. على سبيل المثال، يمكن أن يؤدي تغيير الدقة من 32 بت إلى 16 بت إلى خفض الذاكرة اللازمة لتحميل النموذج وتدريبه إلى النصف. في وقت لاحق في هذه المقالة. سوف نتعرف على Qlora الذي يستخدم مفهوم التكميم للضبط.

استكشاف فئات أساليب PEFT

في عملية الضبط الدقيق لنماذج اللغات الكبيرة بشكل كامل، من المهم أن يكون لديك إعداد حسابي يمكنه التعامل بكفاءة ليس فقط مع أوزان النماذج الكبيرة، والتي تصل الآن بالنسبة للنماذج الأكثر تقدمًا إلى أحجام تصل إلى مئات الجيجابايت، ولكن أيضًا إدارة سلسلة من العناصر الحاسمة الأخرى. يتضمن ذلك تخصيص الذاكرة لحالات المُحسّن، وإدارة التدرجات، والتنشيط الأمامي، وتسهيل الذاكرة المؤقتة خلال المراحل المختلفة من إجراءات التدريب.

الطريقة المضافة

يمكن لهذا النوع من الضبط زيادة النموذج المُدرب مسبقًا بمعلمات أو طبقات إضافية، مع التركيز على تدريب المعلمات المضافة حديثًا فقط. على الرغم من زيادة عدد المعلمات، تعمل هذه الأساليب على تحسين وقت التدريب وكفاءة المساحة. تنقسم الطريقة المضافة أيضًا إلى فئات فرعية:

- محولات: دمج شبكات صغيرة متصلة بالكامل بعد الطبقات الفرعية للمحولات، مع وجود أمثلة بارزة AdaMix, كرون أ، والضاغطة.

- المطالبات الناعمة: ضبط جزء من تضمينات مدخلات النموذج من خلال النسب المتدرج، مع IPT, ضبط البادئة، و WARP من الأمثلة البارزة.

- طرق إضافية أخرى: قم بتضمين تقنيات مثل LeTS وAttentionFusion وLadder-Side Tuning.

الطريقة الانتقائية

تقوم PEFTs الانتقائية بضبط عدد محدود من الطبقات العليا بناءً على نوع الطبقة وبنية النموذج الداخلي. تتضمن هذه الفئة أساليب مثل بيتفيت و LN ضبط، والتي تركز على ضبط عناصر محددة مثل تحيزات النموذج أو صفوف معينة.

الطريقة القائمة على إعادة القياس

تستخدم هذه الأساليب تمثيلات منخفضة الرتبة لتقليل عدد المعلمات القابلة للتدريب، وأشهرها هو Low-Rank Adaptation أو LoRA. تستفيد هذه الطريقة من تحليل مصفوفة بسيط منخفض الرتبة لتحديد معلمات تحديث الوزن، مما يوضح الضبط الدقيق الفعال في المساحات الفرعية ذات الرتبة المنخفضة.

1) LoRA (التكيف ذو الرتبة المنخفضة)

ظهرت LoRA كتقنية PEFT رائدة، تم تقديمها في ورقة بحثية بواسطة إدوارد ج. هو وآخرون في عام 2021. إنه يعمل ضمن فئة إعادة المعلمة، حيث يقوم بتجميد الأوزان الأصلية لـ LLM ودمج مصفوفات جديدة منخفضة الرتبة قابلة للتدريب في كل طبقة من بنية المحولات. لا يؤدي هذا النهج إلى تقليص عدد المعلمات القابلة للتدريب فحسب، بل يقلل أيضًا من وقت التدريب والموارد الحسابية اللازمة، وبالتالي يقدم بديلاً أكثر كفاءة للضبط الدقيق الكامل.

لفهم آليات LoRA، يجب على المرء إعادة النظر في بنية المحولات حيث يخضع موجه الإدخال للترميز والتحويل إلى ناقلات التضمين. تعبر هذه المتجهات عبر قطاعات التشفير و/أو وحدة فك التشفير للمحول، وتواجه شبكات الاهتمام الذاتي والتغذية الأمامية التي تم تدريب أوزانها مسبقًا.

يستخدم LoRA مفهوم تحليل القيمة الفردية (SVD). بشكل أساسي، يقوم SVD بتشريح المصفوفة إلى ثلاث مصفوفات متميزة، إحداها عبارة عن مصفوفة قطرية تحتوي على قيم فردية. تعتبر هذه القيم المفردة محورية لأنها تقيس أهمية الأبعاد المختلفة في المصفوفات، حيث تشير القيم الأكبر إلى أهمية أعلى وتشير القيم الأصغر إلى أهمية أقل.

يسمح هذا النهج لـ LoRA بالحفاظ على الخصائص الأساسية للبيانات مع تقليل الأبعاد، وبالتالي تحسين عملية الضبط الدقيق.

تتدخل LoRA في هذه العملية، حيث تقوم بتجميد جميع معلمات النموذج الأصلي وإدخال زوج من "مصفوفات تحليل الرتب" إلى جانب الأوزان الأصلية. تخضع هذه المصفوفات الأصغر حجمًا، والمشار إليها بـ A وB، للتدريب من خلال التعلم الخاضع للإشراف.

العنصر المحوري في هذه الإستراتيجية هو المعلمة التي تسمى الرتبة ('r')، والتي تحدد حجم المصفوفات ذات الرتبة المنخفضة. يمكن أن يؤدي الاختيار الدقيق لـ 'r' إلى نتائج مبهرة، حتى مع قيمة أصغر، وبالتالي إنشاء مصفوفة منخفضة الرتبة مع عدد أقل من المعلمات للتدريب. تم تنفيذ هذه الإستراتيجية بشكل فعال باستخدام مكتبات مفتوحة المصدر مثل HuggingFace Transformers، مما يسهل ضبط LoRA لمختلف المهام بكفاءة ملحوظة.

2) QLoRA: رفع كفاءة LoRA إلى أعلى

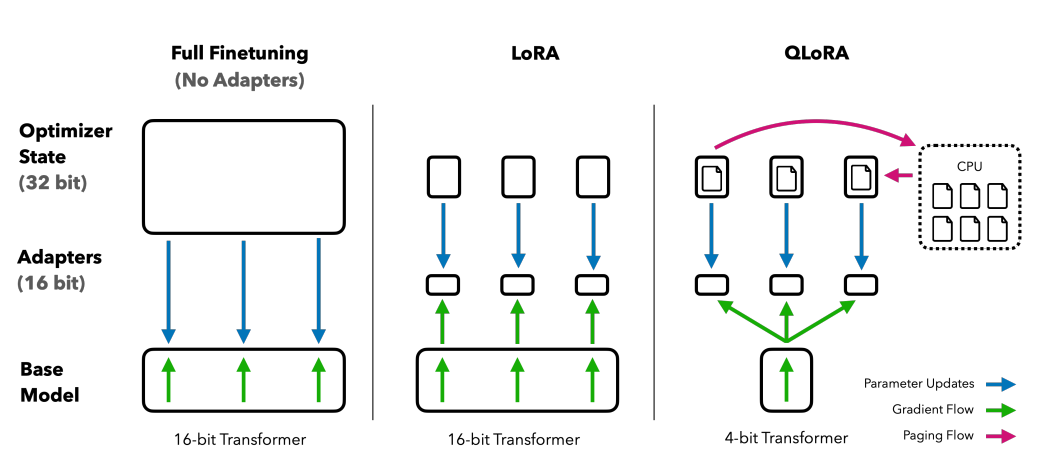

بناءً على الأساس الذي وضعته LoRA، تعمل QLoRA على تقليل متطلبات الذاكرة. تم تقديمه بواسطة تيم ديتميرز وآخرون في عام 2023، فهو يجمع بين التكيف ذو الرتبة المنخفضة مع التكميم، باستخدام تنسيق تكميم 4 بت يسمى NormalFloat or nf4. التكميم هو في الأساس عملية تقوم بنقل البيانات من تمثيل معلوماتي أعلى إلى تمثيل يحتوي على معلومات أقل. يحافظ هذا الأسلوب على فعالية أساليب الضبط الدقيق لـ 16 بت، مما يؤدي إلى تقليص أوزان 4 بت إلى 16 بت كما هو مطلوب أثناء العمليات الحسابية.

مقارنة طرق الضبط الدقيق: تعمل QLORA على تحسين LoRA من خلال تكميم دقة 4 بت ومحسنات مقسمة إلى صفحات لإدارة زيادة الذاكرة

تستفيد تقنية QLoRA من NumericFloat4 (nf4)، التي تستهدف كل طبقة في بنية المحولات، وتقدم مفهوم التكميم المزدوج لتقليص مساحة الذاكرة المطلوبة للضبط الدقيق. يتم تحقيق ذلك من خلال إجراء التكميم على الثوابت الكمية بالفعل، وهي استراتيجية تتجنب ارتفاعات ذاكرة نقاط التفتيش التدرجية النموذجية من خلال استخدام أدوات التحسين المقسمة إلى صفحات وإدارة الذاكرة الموحدة.

غوناق، وهي مجموعة مضبوطة بتقنية QLORA، تضع معيارًا في حلول برامج الدردشة مفتوحة المصدر. ويؤكد أدائها، الذي تم التحقق من صحته من خلال التقييمات البشرية والآلية المنهجية، هيمنتها وكفاءتها في هذا المجال.

تم ضبط الإصدارين 65B و33B من Guanaco بدقة باستخدام نسخة معدلة من OASST1 مجموعة البيانات، تظهر كمنافسين هائلين لنماذج مشهورة مثل شات جي بي تي وحتى GPT-4.

الضبط الدقيق باستخدام التعلم المعزز من ردود الفعل البشرية

يتم تفعيل التعلم المعزز من الملاحظات الإنسانية (RLHF) عند ضبط نماذج اللغة المدربة مسبقًا لتتوافق بشكل أوثق مع القيم الإنسانية. تم تقديم هذا المفهوم بواسطة Open AI في عام 2017 مما وضع الأساس لتحسين تلخيص المستندات وتطويرها تعليمات.

في جوهر RLHF يوجد نموذج التعلم المعزز، وهو نوع من تقنيات التعلم الآلي حيث وكيل يتعلم كيفية التصرف في بيئة عن طريق أداء الإجراءات والاستلام المكافآت. إنها حلقة مستمرة من عمل و ردود الفعل، حيث يتم تحفيز الوكيل على اتخاذ الخيارات التي من شأنها أن تسفر عن أعلى مكافأة.

ترجمة هذا إلى عالم نماذج اللغة، وكيل هل نموذج نفسها، وتعمل داخل بيئة لنافذة سياق معين واتخاذ القرارات بناءً على حالة، والذي يتم تعريفه بواسطة الرموز المميزة الحالية في نافذة السياق. ال "مساحة العمل"يشمل جميع الرموز المميزة المحتملة التي يمكن للنموذج الاختيار من بينها، بهدف تحديد الرمز المميز الذي يتوافق بشكل وثيق مع التفضيلات البشرية.

تعمل عملية RLHF على تعزيز ردود الفعل البشرية على نطاق واسع، واستخدامها لتدريب نموذج المكافأة. ويلعب هذا النموذج دورًا حاسمًا في توجيه النموذج المُدرب مسبقًا أثناء عملية الضبط الدقيق، وتشجيعه على توليد مخرجات أكثر توافقًا مع القيم الإنسانية. إنها عملية ديناميكية ومتكررة، حيث يتعلم النموذج من خلال سلسلة من "الطرح"، وهو مصطلح يستخدم لوصف تسلسل الحالات والإجراءات التي تؤدي إلى المكافأة في سياق توليد اللغة.

إحدى الإمكانات الرائعة لـ RLHF هي قدرتها على تعزيز التخصيص في مساعدي الذكاء الاصطناعي، وتخصيصهم ليتوافقوا مع تفضيلات المستخدمين الفردية، سواء كان ذلك حس الفكاهة أو الروتين اليومي. إنه يفتح آفاقًا لإنشاء أنظمة ذكاء اصطناعي ليست فقط ذات كفاءة تقنية ولكنها أيضًا ذكية عاطفيًا، وقادرة على فهم الفروق الدقيقة في التواصل البشري والاستجابة لها.

ومع ذلك، من الضروري ملاحظة أن RLHF ليس حلاً مضمونًا. لا تزال النماذج عرضة لتوليد مخرجات غير مرغوب فيها، وهو ما يعكس البيانات الضخمة وغير المنظمة والمتحيزة في كثير من الأحيان التي تم تدريبها عليها.

الخاتمة

أصبحت عملية الضبط الدقيق، وهي خطوة حاسمة في الاستفادة من الإمكانات الكاملة لمجالس LLM مثل Alpaca وFalcon وGPT-4، أكثر دقة وتركيزًا، وتقدم حلولاً مخصصة لمجموعة واسعة من المهام.

لقد رأينا الضبط الدقيق للمهمة الواحدة، والذي يتخصص في النماذج في أدوار معينة، وطرق الضبط الدقيق لكفاءة المعلمات (PEFT) بما في ذلك LoRA وQLoRA، والتي تهدف إلى جعل عملية التدريب أكثر كفاءة وفعالية من حيث التكلفة. تفتح هذه التطورات الأبواب أمام وظائف الذكاء الاصطناعي عالية المستوى لجمهور أوسع.

علاوة على ذلك، يعد تقديم التعلم المعزز من ردود الفعل البشرية (RLHF) بواسطة Open AI خطوة نحو إنشاء أنظمة ذكاء اصطناعي تفهم وتتوافق بشكل أوثق مع القيم والتفضيلات الإنسانية، مما يمهد الطريق لمساعدي الذكاء الاصطناعي الذين ليسوا أذكياء فحسب، بل حساسين أيضًا احتياجات المستخدم الفردية. يعمل كل من RLHF وPEFT بشكل تآزري لتحسين وظائف وكفاءة نماذج اللغات الكبيرة.

نظرًا لأن الشركات والمؤسسات والأفراد يتطلعون إلى دمج حاملي شهادة الماجستير في القانون في عملياتهم، فإنهم يرحبون بشكل أساسي بمستقبل يكون فيه الذكاء الاصطناعي أكثر من مجرد أداة؛ إنه شريك يفهم السياقات البشرية ويتكيف معها، ويقدم حلولاً مبتكرة وشخصية.