زاوية أندرسون

وهم "تنزيل المزيد من الملصقات!" في أبحاث الذكاء الاصطناعي

إن وجهة النظر الشائعة في أبحاث التعلم الآلي الحالية هي أن التعلم الآلي نفسه يمكن أن يكون تستخدم لتحسين جودة تعليقات مجموعات بيانات الذكاء الاصطناعي - وخاصةً تعليقات الصور المُخصصة للاستخدام في نماذج الرؤية واللغة (VLMs). هذا النهج من التفكير مدفوعٌ بـ التكلفة العالية من التعليقات البشرية، والعبء الإضافي المتمثل في الإشراف أداء المشرح.

يمكن القول أن هذا هو ما يعادل الذكاء الاصطناعي في أوائل العقد الأول من القرن الحادي والعشرين ميم "تنزيل المزيد من ذاكرة الوصول العشوائي"، الذي سخر من فكرة أن أحد قيود الأجهزة يمكن حله باستخدام إصلاح يعتمد على البرمجيات.

إنها أيضًا قضية لا تحظى بالاهتمام الكافي؛ فبينما تجتذب نماذج الذكاء الاصطناعي الجديدة اهتمامًا واسع النطاق في كل من المجالين العام والتجاري، غالبًا ما تبدو التعليقات التوضيحية وكأنها تفاصيل تافهة في خطوط أنابيب التعلم الآلي، وتطغى عليها الإثارة المحيطة بالأطر الأوسع.

في الحقيقة، قدرة أنظمة التعلم الآلي على التعرف على الأنماط وإعادة إنتاجها (حالة الاستخدام المركزية لجميع أنظمة الذكاء الاصطناعي تقريبًا) تابع حول جودة واتساق التعليقات التوضيحية في العالم الحقيقي - العلامات والعبارات التي تم إنشاؤها أو الحكم عليها من قبل أشخاص حقيقيين، وغالبًا ما يصدرون أحكامًا ذاتية حول نقاط البيانات الفردية في ظروف غير مثالية.

حتمًا، لا يمكن للأنظمة التي تسعى إلى مراقبة وإعادة إنتاج الأنماط في سلوك المعلق (وبالتالي استبدال المعلقين البشريين وتسهيل وضع العلامات الدقيقة على نطاق واسع) أن تأمل في الأداء الجيد على البيانات لست الواردة في الأمثلة المأخوذة من مراقبين بشريين. لا شيء "متشابه" هو نفسه تمامًا، ويظل التكافؤ بين المجالات أمرًا ملاحقة إشكالية في رؤية الكمبيوتر.

يتعين على "التعامل مع البيانات الأولية" أن يتوقف في مكان ما، وفي هذه الحالة، يتوقف الأمر عند هذا الحد تمامًا ــ حيث يقوم المخيخ البشري بإجراء نوع من التمييز الذاتي من أجل ترميز البيانات لنظام اصطناعي.

تجارة RAG

حتى وقت قريب، ربما كانت الأخطاء الناجمة عن التعليقات التوضيحية غير المنسقة لمجموعات البيانات تُعتبر أضرارًا جانبية مقبولة في سياق النتائج غير الكاملة ولكن القابلة للتسويق والتي يتم الحصول عليها من أنظمة الذكاء الاصطناعي التوليدية.

في الواقع، أجريت دراسة هذا العام فقط من سنغافورة وخلص أن الهلوسة - أي المناسبات التي تخترع فيها أنظمة الذكاء الاصطناعي أشياء تقوض نوايانا - هي أمر لا مفر منه، ومرتبطة بالهندسة المعمارية المفاهيمية لمثل هذه الأنظمة.

لمواجهة هذا ، العوامل القائمة على RAG أصبحت الخوارزميات - التي يمكنها "التحقق" من الحقائق من خلال عمليات البحث على الإنترنت - شائعة الاستخدام في الأبحاث والحلول التجارية التطبيقية. ومع ذلك، فإنها تزيد من تكلفة الموارد ووقت استجابة الاستعلامات؛ بالإضافة إلى ذلك، لا تستطيع المعلومات الجديدة المطبقة على نموذج مُدرَّب منافسة الروابط الأكثر تعقيدًا وتشابكًا التي تميز الطبقات الأصلية في النموذج المُدرَّب.

ومن ثم، سيكون من الأفضل لو كانت بيانات التعليقات التوضيحية التي تشكل هذه النماذج أقل عيوباً إلى حد كبير في المقام الأول، حتى ولو لم تكن مثالية (وليس أقلها لأن هذا النشاط يتعدى على مجال الذاتية البشرية).

إعادة البابا

تُسلِّط ورقة بحثية جديدة من ألمانيا الضوء على المشاكل الناجمة عن الاعتماد على مجموعات بيانات قديمة واسعة الاستخدام، مع التركيز بشكل خاص على دقة وموثوقية تسميات الصور. وتشير نتائج الباحثين إلى أن أخطاء التسميات في المعايير المرجعية قد تُخفي أو تُشوِّه الهلوسة في نماذج الرؤية واللغة.

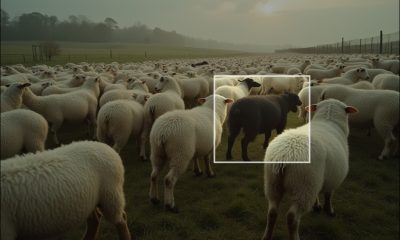

من الورقة البحثية الجديدة، بعض الأمثلة التي فشلت فيها التعليقات التوضيحية الأصلية في تحديد الكائنات بشكل صحيح في مجموعة بيانات MSCOCO للصور. عالجت المراجعة اليدوية التي أجراها الباحثون لمجموعة بيانات POPE المرجعية هذه العيوب، موضحةً تكلفة توفير المال على معالجة التعليقات التوضيحية. المصدر: https://arxiv.org/pdf/2504.15707

تخيل أن يُعرض على نموذج صورة لمشهد شارع، ويُسأل عما إذا كانت هناك دراجة هوائية فيه. يجيب النموذج: نعم إذا كانت مجموعة البيانات المرجعية تشير إلى عدم وجود دراجة، فسيتم وضع علامة على النموذج خاطئ. ولكن إذا كانت الدراجة مرئي بوضوح في الصورة، ولم يُلاحظ أثناء الشرح، فإن إجابة النموذج صحيحة، ويُعتبر المعيار المرجعي فاشلاً. يمكن أن تتراكم أخطاء كهذه في مجموعة البيانات، مما يُعطي صورة مشوهة عن النماذج الدقيقة والنماذج المعرضة للخداع.

وهكذا، عندما يتم التعامل مع التعليقات التوضيحية غير الصحيحة أو الغامضة على أنها حقائق أساسية، فقد تبدو النماذج وكأنها تعاني من الهلوسة عندما تكون صحيحة، أو تبدو دقيقة عندما لا تكون كذلك، مما يؤدي إلى تشويه كل من قياس الهلوسة وتصنيف أداء النموذج، ويجعل من الصعب تشخيص المشكلة أو معالجتها على وجه اليقين.

تتناول الورقة الجديدة معيارًا يستخدم على نطاق واسع يسمى تقييم فحص الكائنات القائم على الاقتراع (POPE)، والذي يختبر ما إذا كانت نماذج الرؤية واللغة قادرة على تحديد ما هو موجود أو غير موجود في الصورة بشكل صحيح.

يعتمد POPE على تسميات من المؤثرين Microsoft COCO: الكائنات الشائعة في السياق مجموعة بيانات (MSCOCO)، وهي عبارة عن مجموعة من الصور الموضحة والتي تم التعامل معها منذ فترة طويلة على أنها تقدم مستوى جيدًا من دقة التوضيح.

يقوم POPE بتقييم هلوسة الأشياء في نماذج اللغة البصرية الكبيرة من خلال إعادة صياغة المشكلة على أنها مهمة التصنيف الثنائيبدلاً من تحليل التسميات التوضيحية المولدة، يطرح النظام أسئلة بسيطة نعم لا أسئلة للنموذج حول ما إذا كانت هناك كائنات محددة موجودة في الصورة، باستخدام قوالب مثل 'هل يوجد في الصورة؟.

أمثلة على هلوسة الأشياء في نماذج الرؤية واللغة. تشير العلامات المكتوبة بخط عريض إلى الأشياء المُشار إليها في التعليقات التوضيحية الأصلية، بينما تشير العلامات الحمراء إلى الأشياء التي هلوست بها النماذج. يعكس المثال الأيسر تقييمًا تقليديًا قائمًا على التعليمات، بينما الأمثلة الثلاثة على اليمين مستمدة من متغيرات مختلفة من معايير POPE. المصدر: https://aclanthology.org/2023.emnlp-main.20.pdf

الأشياء الحقيقية الأساسية (الإجابة: نعم) مقترنة بأشياء غير موجودة تم أخذ عينات منها (الإجابة: لا)، تم اختيارها من خلال عشوائية، متكررة (شعبي)، أو على أساس التواجد المشترك (الخصومة) استراتيجيات. يسمح هذا الإعداد بتقييم أكثر استقرارًا وسرعةً وتلقائيةً للهلوسة دون الاعتماد على تحليلات معقدة مبنية على قواعد للتسميات التوضيحية.

مؤلفو ورقة جديدة - بعنوان RePOPE: تأثير أخطاء التعليقات التوضيحية على معيار POPE - تحدي الدقة المفترضة لـ POPE من خلال إعادة التحقق من العلامات الموجودة على صور المعيار المرجعي (على سبيل المثال، MSCOCO) - واكتشاف أن عددًا مفاجئًا منها خاطئ أو غير واضح.

أمثلة من مجموعة بيانات MSCOCO لعام 2014. المصدر: https://arxiv.org/pdf/1405.0312

تؤدي هذه الأخطاء إلى تغيير طريقة تصنيف النماذج، حيث تتخلف بعض النماذج التي حققت أداءً جيدًا في البداية عند الحكم عليها مقابل التصنيفات المصححة.

في الاختبارات، قام المؤلفون بتقييم مجموعة من نماذج الرؤية واللغة ذات الوزن المفتوح على كل من معيار POPE الأصلي ومعيارهم المعاد تسميته إعادة البابا الإصدار.

وفقًا للورقة البحثية، أدت التعليقات التوضيحية المصححة إلى تغييرات ملحوظة في تصنيفات النماذج، وخاصة في F1 النتائج، مع انخفاض العديد من النماذج عالية الأداء تحت POPE في موضعها تحت RePOPE.

يزعم المؤلفون أن هذا التحول يوضح المدى الذي يمكن أن تؤدي به أخطاء التعليقات التوضيحية إلى إخفاء سلوك الهلوسة الفعلي للنماذج، ويقدمون RePOPE كأداة أكثر موثوقية لتقييم ضعف الهلوسة.

وفي مثال آخر من الورقة البحثية الجديدة، نرى كيف فشلت تعليقات POPE الأصلية في تمييز الأشياء الدقيقة، مثل الشخص الذي يجلس بجانب مقصورة الترام في الصورة اليمنى، أو الكرسي الذي يحجبه لاعب التنس في الصورة الثانية من اليسار.

الطريقة والاختبارات

أعاد الباحثون تسمية جميع التعليقات التوضيحية في مجموعة بيانات MSCOCO الأصلية، مع تعيين مُصنِّفين بشريين لكل عينة بيانات. وفي حال وجود غموض حول جودة التعليقات التوضيحية الأصلية (كما في الأمثلة أدناه)، تم استبعاد هذه النتائج من جولة الاختبار.

الحالات الغامضة، حيث تعكس تناقضات التصنيف في POPE حدودًا غير واضحة للفئات. على سبيل المثال، تم تصنيف دمية دب على أنها دب، أو دراجة نارية على أنها دراجة هوائية، أو مركبات المطار على أنها سيارات. تم استبعاد هذه الحالات من RePOPE نظرًا للطبيعة الذاتية لهذه التصنيفات، بالإضافة إلى تناقضات تصنيفات MSCOCO الأصلية.

تقول الورقة:

"لقد أغفل المعلقون الأصليون الأشخاص في الخلفية أو خلف الزجاج، حيث يخفي لاعب التنس "الكراسي" في الخلفية، وتحتوي سلطة الكرنب على شريط صغير مرئي فقط من الجزر.

بالنسبة لبعض الكائنات، تتباين تعليقات COCO تباينًا كبيرًا، ويرجع ذلك على الأرجح إلى اختلاف تعريفات تلك الكائنات التي استخدمها المشروحون الأصليون. يعتمد تصنيف "دمية الدب" على أنها "دب"، أو الدراجة النارية على أنها "دراجة" آلية، أو مركبة المطار على أنها "سيارة" على تعريفات محددة، مما يؤدي إلى تباينات في تعليقات POPE الأساسية. لذلك، نُصنف أزواج الصور والأسئلة المقابلة على أنها "غامضة".

نتائج إعادة الشرح: وُزِّعت الأسئلة الإيجابية عبر جميع متغيرات POPE الثلاثة. من بين الأسئلة التي وُضِّحت "نعم" في POPE، وُجِد أن 9.3% منها غير صحيحة، و13.8% منها مُصنَّفة على أنها غامضة. أما بالنسبة لأسئلة "لا"، فقد وُضِعَتْ عليها أخطاء في التسمية، و1.7% منها غامضة.

قام المؤلفون بتقييم مجموعة من نماذج الوزن المفتوح على POPE وRePOPE، عبر هياكل وأحجام نماذج متنوعة. وشملت النماذج المختارة بعض الهياكل الرائدة على أوبن في إل إم لوحة المتصدرين: InternVL2.5 (8B/26B/38B/78B and 8B-MPO/26B-MPO); لافا-نيكست; فيكونيا; ميسترال 7 ب; اللاما نوع من الجمال; LLaVA-OneVision; أوفيس 2 (1ب/2ب/4ب/8ب)؛ بالي جيما-3ب، و بالي جيما 2 (3ب/10ب).

النتائج الأولية: يؤدي ارتفاع معدل الخطأ في العلامات الإيجابية الأصلية إلى انخفاض حاد في النتائج الإيجابية الحقيقية في جميع النماذج. تتفاوت النتائج الإيجابية الكاذبة بين المجموعات الفرعية، حيث تتضاعف تقريبًا في المجموعة الفرعية العشوائية، لكنها تبقى ثابتة إلى حد كبير في المجموعة الفرعية الشائعة، وتُظهر انخفاضًا طفيفًا في المجموعة الفرعية المعادية. لإعادة التصنيف تأثير كبير على التصنيفات القائمة على F1. كما أن نماذج مثل Ovis2-4B وOvis2-8B، والتي حققت أداءً جيدًا في الانقسامات الشائعة والعدائية في POPE، تتصدر أيضًا المجموعة الفرعية العشوائية في RePOPE. يُرجى الرجوع إلى ملف PDF المصدر للحصول على دقة أفضل.

توضح الرسوم البيانية للنتائج أعلاه كيفية تغير عدد النتائج الإيجابية الحقيقية والإيجابية الكاذبة بعد تصحيح العلامات في المعيار المرجعي.

انخفضت الإيجابيات الحقيقية في جميع النماذج، مما يدل على أنها كانت تُنسب إليها الإجابات الصحيحة في كثير من الأحيان عندما كانت تلك الإجابات صحيحة فقط تحت تسميات خاطئة، في حين اتبعت الإيجابيات الكاذبة نمطًا أكثر تنوعًا.

في النسخة "العشوائية" من POPE، تظهر نتائج إيجابية كاذبة تقريبًا مضاعف في العديد من النماذج، يُشير ذلك إلى وجود عدد كبير من الأشياء المُصنّفة على أنها هلوسات في الصور، لكنها غُيّبت في التعليقات التوضيحية الأصلية. في هذه الحالة، كانت العديد من أخطاء النماذج المفترضة أخطاءً في تصنيف مجموعات البيانات.

بالنسبة للنسخة "المُعادية" من اختبار POPE، حيث كانت الأسئلة مبنية على أشياء تتكرر بشكل متكرر، انخفضت الإيجابيات الخاطئة. وهذا يعكس على الأرجح احتمالية أكبر بأن يكون الشيء الذي يُفترض أنه غائب هو في الواقع في الصورة لكنه غادر غير مصنف.

وعلى الرغم من أن هذه التحولات أثرت على الدقة والتذكر، فإن تصنيفات النماذج ظلت مستقرة نسبيًا لكلا المقياسين.

كانت درجة F1 - مقياس التقييم الرئيسي لـ POPE - أكثر حساسيةً لتصحيحات التصنيف. في المجموعة الفرعية العشوائية، تراجعت النماذج التي احتلت مرتبةً قريبةً من الأعلى تصنيفًا تحت التصنيفات الأصلية، مثل InternVL2.5-8B و-26B، إلى أدنى مستوى عند تقييمها باستخدام RePOPE. بينما ارتفعت نماذج أخرى، مثل Ovis2-4B و-8B، إلى القمة.

وقد ظهر نمط مماثل في درجات الدقة، على الرغم من أن المؤلفين لاحظوا أن هذه الدرجات قد تكون متحيزة الآن، حيث تحتوي مجموعة البيانات المصححة على عدد غير متساوٍ من الأمثلة الإيجابية والسلبية.

يجادل المؤلفون بأن التأثير القوي لأخطاء التعليقات التوضيحية على نتائج المعايير يُبرز الحاجة إلى بيانات عالية الجودة. ولدعم تقييم أكثر موثوقية للهلوسة المتعلقة بالأشياء، قاموا بما يلي: تم إصدار العلامات المصححة في جيثب.

ومع ذلك، يلاحظون أن إعادة التصنيف هذه لا تعالج تشبع المعيار بشكل كامل، حيث لا تزال العديد من النماذج تحقق معدلات إيجابية وسلبية حقيقية أعلى من 90%. ويقترحون معايير إضافية، مثل داش-بييجب استخدام ، الذي يستخدم مجموعة أكثر تحديًا من الأمثلة السلبية، جنبًا إلى جنب مع RePOPE.

الخاتمة

كانت هذه التجربة مُمكنة بفضل صغر حجم مجموعة البيانات المعنية. يتطلب إثبات الفرضية نفسها على مجموعات بيانات ضخمة العمل على أجزاء محدودة للغاية من البيانات؛ ففي مجموعات البيانات الضخمة شديدة التنوع، قد يكون من شبه المستحيل عزل مجموعات مُمثلة إحصائيًا ومتماسكة دلاليًا، مما قد يُشوّه النتائج.

حتى لو كان ذلك ممكنًا، فما الحل في ظلّ التطورات الحديثة؟ يعود الجدل حتمًا نحو الحاجة إلى شروح بشرية أفضل وأكثر شمولًا.

في هذا الصدد، تُعتبر "الأفضل" و"الأكثر وفرة" مشكلتين منفصلتين بحد ذاتهما، إذ يُمكن الحصول على كمية أكبر من التعليقات التوضيحية من خلال اقتصادات المنافسة الشرسة مثل Amazon Mechanical Turk (AMT). من الواضح أن هذا... استغلالية محتملة الاقتصاد الفرعي في كثير من الأحيان يؤدي إلى نتائج رديئة.

كبديل، يُمكن توزيع مهام التعليقات التوضيحية على المناطق الاقتصادية حيث يُنتج الإنفاق نفسه كمية أكبر من التعليقات التوضيحية. مع ذلك، كلما ابتعد المُعلّق عن حالة الاستخدام المُرادة للنموذج الذي ستُشكّل تسمياته، قلّ احتمال توافق النموذج الناتج مع احتياجات أو توقعات المجال المُستهدف.

وهذا ما يجعل هذا الأمر أحد التحديات الأكثر استمراراً والتي لم يتم حلها بعد في اقتصاديات تطوير التعلم الآلي.

نُشر لأول مرة يوم الأربعاء 23 أبريل 2025