الذكاء الاصطناعي

MINT-1T: توسيع نطاق البيانات متعددة الوسائط مفتوحة المصدر بمعدل 10x

يتطلب تدريب النماذج متعددة الوسائط الكبيرة (LMMs) مجموعات بيانات واسعة النطاق مع تسلسلات متداخلة من الصور والنصوص في شكل حر. على الرغم من تطور نماذج LMM مفتوحة المصدر بسرعة، لا يزال هناك نقص كبير في مجموعات البيانات المتداخلة متعددة الوسائط على نطاق واسع والتي تكون مفتوحة المصدر. ولا يمكن المبالغة في أهمية مجموعات البيانات هذه، لأنها تشكل الأساس لإنشاء أنظمة ذكاء اصطناعي متقدمة قادرة على فهم المحتوى وتوليده عبر طرائق مختلفة. وبدون إمدادات كافية من مجموعات البيانات الشاملة والمتداخلة، فإن إمكانية تطوير نماذج LMM أكثر تطوراً وقدرة ستتعرض للعرقلة بشكل كبير. تمكن مجموعات البيانات هذه النماذج من التعلم من مجموعة متنوعة من المدخلات، مما يجعلها أكثر تنوعًا وفعالية في التطبيقات المختلفة. علاوة على ذلك، تشكل ندرة مجموعات البيانات هذه تحديًا لمجتمع المصادر المفتوحة، الذي يعتمد على الموارد المشتركة لدفع الابتكار والتعاون.

لقد حققت نماذج LMM مفتوحة المصدر تقدمًا كبيرًا في السنوات الأخيرة، إلا أن نموها يعوقه محدودية توافر مجموعات البيانات المتداخلة واسعة النطاق. وللتغلب على هذه العقبة، يلزم تضافر الجهود لتنظيم مجموعات بيانات أكثر شمولاً وشرحها وإصدارها، بما يدعم التطوير والتحسين المستمرين للنماذج متعددة الوسائط. بالإضافة إلى ذلك، يتطلب إنشاء هذه المجموعات ونشرها التغلب على العديد من العقبات التقنية واللوجستية. يجب أن يكون جمع البيانات واسع النطاق وممثلاً للسياقات المتنوعة التي سيتم نشر نماذج LMM فيها. يتطلب الشرح دراسة متأنية لضمان محاذاة تسلسلات الصور والنصوص المتداخلة بطريقة تعزز قدرات التعلم في النموذج. علاوة على ذلك، فإن ضمان أن تكون مجموعات البيانات مفتوحة المصدر يستلزم معالجة الاعتبارات القانونية والأخلاقية المتعلقة بخصوصية البيانات وحقوق الاستخدام. إن توسيع نطاق توافر مجموعات البيانات المتداخلة متعددة الوسائط عالية الجودة وواسعة النطاق أمر ضروري لمستقبل البحث والتطوير في مجال الذكاء الاصطناعي. من خلال معالجة الندرة الحالية، يمكن لمجتمع الذكاء الاصطناعي تعزيز الابتكار والتعاون بشكل أكبر، مما يؤدي إلى إنشاء آلات التعلم الآلي أكثر قوة وتنوعًا وقادرة على معالجة المشكلات المعقدة في العالم الحقيقي.

وبناءً على هذه الملاحظة، تم إنشاء MINT-1T، أكبر مجموعة بيانات مفتوحة المصدر ومتعددة الوسائط وأكثرها تنوعًا حتى الآن. MINT-1T: نطاق أكبر بمقدار 10 أضعاف، بما في ذلك تريليون رمز نصي و3.4 مليار صورة مقارنة بمجموعات البيانات مفتوحة المصدر الحالية. تقدم مجموعة بيانات MINT-1T أيضًا مصادر لم يتم الكشف عنها مطلقًا مثل ملفات PDF وأوراق ArXiv. نظرًا لأن مجموعات البيانات المتداخلة متعددة الوسائط لا يمكن قياسها بسهولة، فمن المهم أن تشارك مجموعة بيانات MINT-1T عملية تنظيم البيانات حتى يتمكن الآخرون أيضًا من إجراء تجارب على مثل هذه المتغيرات الغنية بالمعلومات. توضح مجموعة بيانات MINT-1T أن طريقتها؛ تعد نماذج LM المدربة على MINT-1T قادرة على المنافسة (ولو إلى حد ما) مع أحدث طرازات OBELICS السابقة.

MINT-1T: مجموعة بيانات متعددة الوسائط تحتوي على تريليون رمز مميز

لقد لعبت مجموعات البيانات الكبيرة مفتوحة المصدر للتدريب المسبق دورًا محوريًا لمجتمع البحث في استكشاف هندسة البيانات وتدريب النماذج الشفافة ومفتوحة المصدر. في مجال النصوص، لعبت الأعمال المبكرة مثل C4 وThe Pile أدوارًا حاسمة في تمكين المجتمع من تدريب المجموعة الأولى من نماذج اللغات الكبيرة مفتوحة المصدر مثل GPT-J وGPT-Neo وغيرها. كما مهدت هذه الجهود التأسيسية الطريق لإجراء تحسينات لاحقة في أساليب تصفية البيانات وتوسيع نطاقها. وبالمثل، في مجال الصور والنصوص، حفزت مجموعات البيانات مفتوحة المصدر واسعة النطاق الابتكارات في أساليب أفضل لتنظيم البيانات، مثل شبكات تصفية البيانات وT-MARS. هناك تحول ملحوظ من المختبرات الحدودية نحو التدريب النماذج الكبيرة متعددة الوسائط (LMMs) التي تتطلب مجموعات بيانات واسعة النطاق ومتعددة الوسائط تشتمل على تسلسلات حرة الشكل من الصور والنصوص. مع التقدم السريع في قدرات النماذج الحدودية، تظهر فجوة كبيرة في بيانات التدريب متعدد الوسائط بين النماذج المغلقة والمفتوحة المصدر. تعد مجموعات البيانات المتداخلة متعددة الوسائط مفتوحة المصدر الحالية أصغر وأقل تنوعًا من نظيراتها النصية فقط، حيث يتم الحصول عليها بشكل أساسي من مستندات HTML، مما يحد من اتساع وتنوع البيانات. يعيق هذا القيد تطوير LMMs قوية مفتوحة المصدر ويخلق تباينًا بين قدرات النماذج مفتوحة المصدر ومغلقة المصدر.

ولمعالجة هذه الفجوة، تم إنشاء MINT-1T باعتبارها أكبر مجموعة بيانات مشذرة متعددة الوسائط ومفتوحة المصدر وأكثرها تنوعًا حتى الآن. يحتوي MINT-1T على إجمالي تريليون رمز نصي وثلاثة مليارات صورة، مصدرها أصول متنوعة مثل HTML وملفات PDF وArXiv. قبل MINT-1T، كانت أكبر مجموعة بيانات مفتوحة المصدر في هذا المجال هي OBELICS، والتي تضمنت 115 مليار رمز نصي و353 مليون صورة، جميعها مصدرها HTML.

مساهمات MINT-1T هي كما يلي:

- هندسة البيانات: يمثل قياس هذه البيانات المتداخلة متعددة الوسائط تحديًا هندسيًا أكثر من إنشاء مجموعات بيانات نصية فقط أو مجموعات بيانات زوجية من الصور والنص. يعد التعامل مع أحجام المستندات الكبيرة والحفاظ على الترتيب الأصلي للصور والنصوص أمرًا بالغ الأهمية.

- تنوع: يعد MINT-1T هو الأول من نوعه في مجال الوسائط المتعددة المتداخلة الذي يجمع مستندات متعددة الوسائط عالية الجودة على نطاق واسع من مصادر مثل ملفات CommonCrawl PDF وArXiv.

- التجارب النموذجية: تظهر التجارب أن LMMs التي تم تدريبها على MINT-1T لا تتطابق فقط مع أداء النماذج المدربة على أفضل مجموعة بيانات مفتوحة المصدر موجودة، وهي OBELICS، بل من المحتمل أن تتجاوزها، بينما تقدم زيادة في الحجم بمقدار عشرة أضعاف.

MINT-1T: إنشاء مجموعة البيانات

تُشرف MINT-1T على مجموعة بيانات مفتوحة المصدر واسعة النطاق، تستخدم مصادر أكثر تنوعًا للمستندات المتداخلة، مثل ملفات PDF وأوراق ArXiv. يُفصّل هذا القسم أساليب MINT-1T في الحصول على المستندات متعددة الوسائط، وتصفية المحتوى منخفض الجودة، وإزالة البيانات المكررة، وإزالة المواد غير الآمنة للعمل أو غير المناسبة للعمل (NSFW) والمواد غير المرغوب فيها. تتألف مجموعة البيانات النهائية من 922 مليار رمز HTML، و106 مليار رمز PDF، و9 مليارات رمز ArXiv.

توريد كميات كبيرة من المستندات متعددة الوسائط

خط أنابيب HTML

يتبع MINT-1T طريقة OBELICS لاستخراج المستندات متعددة الوسائط المتداخلة من ملفات CommonCrawl WARC عن طريق تحليل شجرة DOM الخاصة بكل إدخال WARC. في حين أن OBELICS قامت فقط بمعالجة المستندات من فبراير 2020 إلى فبراير 2023 من عمليات تفريغ CommonCrawl، قامت MINT-1T بتوسيع تجمع المستندات ليشمل مستندات HTML من مايو 2017 إلى أبريل 2024 (مع عمليات تفريغ كاملة من أكتوبر 2018 إلى أبريل 2024 وعمليات تفريغ جزئية من سنوات سابقة). على غرار OBELICS، يقوم MINT-1T بتصفية المستندات التي لا تحتوي على صور، أو أكثر من ثلاثين صورة، أو أي صور تحتوي على عناوين URL تتضمن سلاسل فرعية غير مناسبة مثل الشعار، والصورة الرمزية، والإباحية، وxxx.

خط أنابيب PDF

تقوم MINT-1T بمصادر مستندات PDF من ملفات CommonCrawl WAT من فبراير 2023 إلى أبريل 2024. في البداية، يتم استخراج جميع روابط PDF من هذه المقالب. يحاول MINT-1T بعد ذلك تنزيل وقراءة ملفات PDF باستخدام PyMuPDF، مع التخلص من ملفات PDF التي يزيد حجمها عن 50 ميجابايت (من المحتمل أن تحتوي على صور كبيرة) وتلك التي يزيد طولها عن 50 صفحة. يتم استبعاد الصفحات التي لا تحتوي على نص، ويتم إنشاء ترتيب القراءة للصفحات المتبقية. يتم تحديد ترتيب القراءة من خلال العثور على المربع المحيط بجميع الكتل النصية في الصفحة، وتجميع الكتل بناءً على الأعمدة، وترتيبها من أعلى اليسار إلى أسفل اليمين. يتم دمج الصور في التسلسل بناءً على قربها من الكتل النصية في نفس الصفحة.

خط أنابيب ArXiv

تقوم MINT-1T بإنشاء مستندات ArXiv المتداخلة من كود مصدر LaTeX باستخدام TexSoup للعثور على علامات الشكل وتداخل الصور مع النص الورقي. بالنسبة للأوراق متعددة الملفات، يحدد MINT-1T ملف Tex الرئيسي ويستبدل علامات الإدخال بمحتويات ملفاته. يتم تنظيف كود LaTeX عن طريق إزالة الواردات والببليوغرافيا والجداول وعلامات الاقتباس. نظرًا لأن ArXiv هو بالفعل مصدر بيانات منظم للغاية، فلا يتم إجراء أي تصفية إضافية وإلغاء البيانات المكررة.

تصفية جودة النص

يتجنب MINT-1T استخدام الأساليب الاستدلالية القائمة على النماذج لتصفية النص، باتباع الممارسات التي أنشأتها RefinedWeb وDolma وFineWeb. في البداية، يتم التخلص من المستندات غير الإنجليزية باستخدام نموذج تعريف اللغة الخاص بـ Fasttext (مع حد ثقة يبلغ 0.65). تتم أيضًا إزالة المستندات التي تحتوي على عناوين URL التي تحتوي على سلاسل فرعية NSFW لاستبعاد المحتوى الإباحي وغير المرغوب فيه. يتم تطبيق أساليب تصفية النص من RefinedWeb، وعلى وجه التحديد إزالة المستندات ذات وحدات n-gram المكررة بشكل مفرط أو تلك التي تم تحديدها على أنها منخفضة الجودة باستخدام قواعد MassiveText.

تصفية الصور

بعد تنظيم ملفات PDF وملفات HTML، يحاول MINT-1T تنزيل جميع عناوين URL للصور في مجموعة بيانات HTML، مع تجاهل الروابط غير القابلة للاسترداد وإزالة المستندات التي لا تحتوي على روابط صور صالحة. يتم تجاهل الصور التي يقل حجمها عن 150 بكسل لتجنب الصور المزعجة مثل الشعارات والأيقونات، ويتم أيضًا إزالة الصور الأكبر من 20,000 بكسل لأنها تتوافق عادةً مع صور خارج الموضوع. بالنسبة لمستندات HTML، تتم إزالة الصور ذات نسبة العرض إلى الارتفاع أكبر من اثنين لتصفية الصور منخفضة الجودة مثل لافتات الإعلانات. بالنسبة لملفات PDF، يتم ضبط الحد إلى ثلاثة للحفاظ على الأرقام والجداول العلمية.

يمثل الشكل أعلاه كيف يتضمن MINT-1T بشكل فريد البيانات من ملفات PDF ومستندات ArXiv خارج مصادر HTML.

تصفية السلامة

- تصفية الصور NSFW: يطبق MINT-1T كاشف الصور NSFW على جميع الصور الموجودة في مجموعة البيانات. إذا كان المستند يحتوي على صورة NSFW واحدة، فسيتم تجاهل المستند بأكمله.

- إزالة معلومات التعريف الشخصية: للتخفيف من مخاطر تسرب البيانات الشخصية، يتم إخفاء هوية عناوين البريد الإلكتروني وعناوين IP الموجودة في البيانات النصية. يتم استبدال رسائل البريد الإلكتروني بقوالب مثل "[البريد الإلكتروني محمي]" وعناوين IP ذات عناوين IP غير وظيفية تم إنشاؤها عشوائيًا.

إلغاء البيانات المكررة

يقوم MINT-1T بإلغاء البيانات المكررة للفقرات والمستندات داخل كل لقطة من CommonCrawl وإلغاء البيانات المكررة للصور لإزالة الصور المتكررة وغير المعلوماتية مثل الرموز والشعارات. يتم تنفيذ جميع خطوات إلغاء البيانات المكررة بشكل منفصل لكل مصدر بيانات.

إلغاء البيانات المكررة للفقرات والمستندات

باتباع منهجية Dolma، يستخدم MINT-1T مرشح Bloom لإلغاء البيانات المكررة بكفاءة، مع ضبط المعدل الإيجابي الخاطئ على 0.01 وإلغاء تكرار الفقرات ذات 13 جرامًا (المشار إليها من خلال محددات الأسطر الجديدة المزدوجة) من كل مستند. إذا كان أكثر من 80% من فقرات المستند مكررة، فسيتم تجاهل المستند بأكمله.

إزالة النص النمطي المشترك

بعد إلغاء البيانات المكررة للفقرة، يقوم MINT-1T بإزالة الجمل المعيارية القصيرة الشائعة في مستندات HTML، مثل "الانتقال إلى المحتوى" أو "أرشيف المدونة". ويتم ذلك عن طريق تشغيل إلغاء البيانات المكررة للفقرة بدقة بنسبة 2% من كل لقطة CommonCrawl، بما يتماشى مع ممارسات CCNet، مما يضمن في الغالب إزالة النص المعياري الشائع.

يوضح الشكل أعلاه عملية التصفية لـ MINT-1T، ويوضح كيفية إزالة الرموز المميزة عبر مسار البيانات لأوراق HTML وPDF وArXiv.

إلغاء البيانات المكررة للصورة

في كل لقطة CommonCrawl، يقوم MINT-1T بإزالة الصور التي تتكرر بشكل متكرر استنادًا إلى تجزئة SHA256. بدلاً من الإلغاء الصارم للتكرار، تتم إزالة الصور التي تظهر أكثر من عشر مرات في اللقطة فقط، وذلك باتباع ممارسات Multimodal-C4. بالتوافق مع OBELICS، تتم إزالة الصور المتكررة داخل مستند واحد، مع الاحتفاظ بالظهور الأول فقط.

البنية التحتية

طوال عملية معالجة البيانات، كان لدى MINT-1T إمكانية الوصول إلى ما متوسطه 2,350 نواة لوحدة المعالجة المركزية من مزيج من 190 معالجًا و90 عقدة معالجًا. في المجمل، تم استخدام ما يقرب من 4.2 مليون ساعة من ساعات وحدة المعالجة المركزية لإنشاء مجموعة البيانات هذه.

مقارنة تكوين المستند في MINT-1T مع OBELICS

عند تقييم تكوين مجموعات البيانات المتداخلة، يتم فحص خاصيتين رئيسيتين: توزيع الرموز النصية لكل مستند وعدد الصور لكل مستند. بالنسبة لهذا التحليل، تم أخذ عينات عشوائيًا من 50,000 مستند من كل من OBELICS وكل مصدر بيانات في MINT-1T. GPT-2's تم استخدام الرمز المميز لحساب عدد الرموز النصية. تمت إزالة القيم المتطرفة من خلال استبعاد المستندات التي تقع خارج النطاق الربعي 1.5 لعدد الرموز النصية والصور. كما هو موضح في الشكل التالي، تتوافق مجموعة HTML الفرعية لـ MINT-1T بشكل وثيق مع توزيع الرمز المميز الموضح في OBELICS. ومع ذلك، تميل المستندات التي يتم الحصول عليها من ملفات PDF وArXiv إلى أن تكون أطول من مستندات HTML في المتوسط، مما يسلط الضوء على فوائد الحصول على البيانات من مصادر متنوعة. يفحص الشكل 5 كثافة الصورة عبر جميع المستندات، ويكشف أن ملفات PDF ومستندات ArXiv تحتوي على صور أكثر مقارنة بمستندات HTML، حيث تكون عينات ArXiv هي الأكثر كثافة للصور.

كيف تعمل مصادر البيانات المختلفة على تحسين تنوع المستندات؟

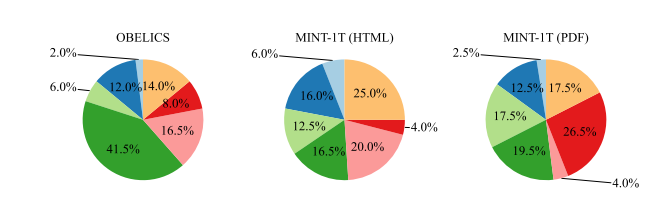

أحد الدوافع الهامة لتوسيع مجموعة المستندات متعددة الوسائط إلى ما هو أبعد من HTML هو تحسين تغطية المجال. لقياس تنوع وعمق هذه التغطية، تم تدريب نموذج تخصيص Dirichlet الخفي (LDA) على 100,000 مستند تم أخذ عينات منها من مجموعة بيانات OBELICS، ومجموعة HTML الفرعية لـ MINT-1T، ومجموعة PDF الفرعية (باستثناء ArXiv) من MINT-1T إلى احصل على 200 موضوع تم بعد ذلك استخدام GPT-4 لتصنيف مجموعة الكلمات لتحديد المجالات السائدة - مثل الصحة والطب، والعلوم، والأعمال التجارية، والعلوم الإنسانية، والتاريخ، وما إلى ذلك - بناءً على مجالات MMMU. يكشف التحليل عن اتجاهات متميزة في توزيع المجال:

- أوبليكس: تُظهر مجموعة البيانات هذه تركيزًا واضحًا في "العلوم الإنسانية والاجتماعية". قد يُعزى ذلك إلى عملية بناء البيانات، والتي تتضمن تصفية المستندات التي لا تشبه مقالات ويكيبيديا، وبالتالي من المحتمل تغيير التوزيع إلى معرفة أكثر عمومية ومحتوى يركز على العلوم الإنسانية.

- مجموعة HTML الفرعية لـ MINT-1T: على النقيض من OBELICS، فإن مجموعة HTML الفرعية لـ MINT-1T ليست متحيزة بشدة تجاه أي مجال محدد، مما يشير إلى تمثيل نطاق أوسع وأكثر توازناً.

- مجموعة PDF الفرعية الخاصة بـ MINT-1T: توجد نسبة أعلى من مستندات "العلوم والتكنولوجيا" ضمن مستندات PDF الخاصة بـ MINT-1T. من المحتمل أن يرجع هذا الاتجاه إلى طبيعة التواصل العلمي، حيث تعد ملفات PDF هي التنسيق المفضل لمشاركة الأوراق البحثية التفصيلية والتقارير الفنية.

مينت-1T: النتائج والتجارب

بالنسبة لجميع التجارب، تقوم MINT-1T بتدريب النموذج على 50% من دفعات التسميات التوضيحية والنصية للصور و50% من الدفعات المتداخلة متعددة الوسائط. يتم أخذ عينات بحد أقصى 2048 رمزًا مميزًا متعدد الوسائط من كل مستند مشذّر و340 رمزًا من كل عينة نص صورة. على غرار Flamingo، تتم إضافة رمز "النهاية" للإشارة إلى نهاية تسلسل نص الصورة المجاور. أثناء التدريب، يتم إسقاط 50% من المستندات المتداخلة ذات الصورة الواحدة بشكل عشوائي لتجميع المستندات متعددة الصور. تتكون مجموعة بيانات الصورة والنص من مزيج من مجموعات بيانات التسميات التوضيحية المنسقة داخليًا. ويتم تقييم قدرة النموذج على التفكير بشأن التسلسلات المتداخلة متعددة الوسائط من خلال قدرات التعلم في السياق وأداء التفكير متعدد الصور.

يوضح الشكل أعلاه النسبة المئوية للمستندات من كل مجال في MMMU لـ OBELICS ومجموعات فرعية من MINT-1T.

التعلم في السياق: يتم تقييم النماذج على أساس أداء التعلم في السياق رباعي وثماني لقطات على معايير التسميات التوضيحية المختلفة (COCO (اختبار Karpathy) وTextCaps (التحقق من الصحة)) ومجموعات بيانات الإجابة على الأسئلة المرئية (VQAv2 (التحقق من الصحة)، OK-VQA (التحقق من الصحة) و TextVQA (التحقق من الصحة) و VizWiz (التحقق من الصحة)). يتم أخذ عينات من العروض التوضيحية بشكل عشوائي من مجموعة التدريب. يتم حساب متوسط الدرجات عبر عمليات تقييم متعددة، مع عروض توضيحية عشوائية لمراعاة الحساسية للمطالبات المختارة. يتم إلغاء المطالبات المختلفة لكل مهمة لتحديد المهام الأفضل أداءً.

التفكير متعدد الصور: يتم تقييم النماذج على MMMU (التي تحتوي على أسئلة فردية ومتعددة الصور) وMantis-Eval (جميع الأسئلة متعددة الصور) لاستكشاف قدرات الاستدلال متعدد الصور بما يتجاوز تقييمات التعلم في السياق.

التدريب على مستندات HTML

في البداية، تتم مقارنة جزء HTML من MINT-1T بـ OBELICS، حيث أن OBELICS هي مجموعة البيانات المتداخلة الرائدة السابقة، والتي تم تنسيقها أيضًا من مستندات HTML. تم تدريب نموذجين على أجزاء HTML من MINT-1T وOBELICS بإجمالي 10B من الرموز المميزة متعددة الوسائط. ويتم تقييم أدائهم التعليمي في السياق. يعرض الجدول التالي أداء 4 طلقات و 8 طلقات على المعايير المشتركة؛ النموذج الذي تم تدريبه على مستندات MINT-1T HTML يعمل بشكل أفضل من OBELICS في مهام VQA ولكنه أسوأ في معايير التسميات التوضيحية. في المتوسط، أداء OBELICS أفضل قليلاً من MINT-1T (HTML).

إضافة مستندات PDF وArXiv

وبعد ذلك، يتم إجراء التدريب على مصادر البيانات الكاملة لـ MINT-1T، مع مزيج من مستندات HTML وPDF وArXiv. يتم أخذ عينات من المستندات المتداخلة بنسبة 50% من HTML، و45% من ملفات PDF، و5% من ArXiv. تم تدريب النموذج على إجمالي 10 مليار رمز متعدد الوسائط. كما هو موضح في الجدول أعلاه، يتفوق النموذج الذي تم تدريبه على مزيج بيانات MINT-1T الكامل على OBELICS وMINT-1T (HTML) في معظم معايير التعلم في السياق. في معايير الاستدلال متعدد الوسائط الأكثر تعقيدًا، يتفوق نموذج MINT-1T على OBELICS على MMMU ولكنه يؤدي بشكل أسوأ على Mantis-Eval.

الاتجاهات الدقيقة

كيف يمكن قياس أداء التعلم في السياق من خلال العروض التوضيحية؟

يتم تقييم أداء التعلم في السياق عندما يُطلب منك ذلك من خلال عرض واحد إلى ثمانية عروض توضيحية. يتم إجراء تجربة واحدة لكل عدد طلقات لكل معيار تقييم. كما هو موضح في الشكل التالي، يتفوق النموذج الذي تم تدريبه على MINT-1T على النموذج الذي تم تدريبه على مجموعة HTML الفرعية الخاصة بـ MINT-1T وOBELICS عبر جميع اللقطات. أداء نموذج MINT-1T (HTML) أسوأ قليلاً من أداء نموذج OBELICS.

الأداء في التسميات التوضيحية ومهام الإجابة على الأسئلة المرئية

يعرض الشكل التالي متوسط أداء التعلم في السياق فيما يتعلق بمعايير التسميات التوضيحية والإجابة على الأسئلة المرئية (VQA). يتفوق أداء OBELICS على جميع متغيرات MINT-1T في معايير التعليقات التوضيحية المكونة من أربع لقطات ويكون أداؤه أسوأ قليلاً مقارنة بـ MINT-1T في معايير التعليقات التوضيحية المكونة من ثماني لقطات. ومع ذلك، فإن MINT-1T يتفوق بشكل كبير على خطي الأساس في معايير VQA. يتفوق MINT-1T (HTML) أيضًا على OBELICS في مهام VQA.

الأداء في مجالات مختلفة

يهدف تضمين المجالات المتنوعة في MINT-1T إلى تحسين تعميم النموذج. يوضح الشكل سابقًا الأداء على MMMU لكل مجال. باستثناء مجال الأعمال، يتفوق MINT-1T على OBELICS وMINT-1T (HTML). تُعزى الزيادة في الأداء في مجالات العلوم والتكنولوجيا لـ MINT-1T إلى انتشار هذه المجالات في مستندات ArXiv وPDF.

الخلاصة

تحدثنا في هذه المقالة عن MINT-1T، وهي أكبر مجموعة بيانات مفتوحة المصدر ومتعددة الوسائط وأكثرها تنوعًا حتى الآن. MINT-1T: نطاق أكبر بمقدار 10 أضعاف، بما في ذلك تريليون رمز نصي و3.4 مليار صورة مقارنة بمجموعات البيانات مفتوحة المصدر الحالية. تقدم مجموعة بيانات MINT-1T أيضًا مصادر لم يتم الكشف عنها مطلقًا مثل ملفات PDF وأوراق ArXiv. نظرًا لأن مجموعات البيانات المتداخلة متعددة الوسائط لا يمكن قياسها بسهولة، فمن المهم أن تشارك مجموعة بيانات MINT-1T عملية تنظيم البيانات حتى يتمكن الآخرون أيضًا من إجراء تجارب على مثل هذه المتغيرات الغنية بالمعلومات. توضح مجموعة بيانات MINT-1T أن طريقتها؛ تعد نماذج LM المدربة على MINT-1T قادرة على المنافسة (ولو إلى حد ما) مع أحدث طرازات OBELICS السابقة.