زاوية أندرسون

إدخال التشبيهات البصرية إلى الذكاء الاصطناعي

تفشل نماذج الذكاء الاصطناعي الحالية في التعرف على أوجه التشابه "العلائقية" بين الصور، مثل تشابه طبقات الأرض مع الخوخ، مما يغفل جانباً أساسياً من كيفية إدراك البشر للصور.

على الرغم من أن هناك الكثير رؤية الكمبيوتر النماذج القادرة على مقارنة الصور وإيجاد أوجه التشابه بينها، لا يمتلك الجيل الحالي من أنظمة المقارنة إلا القليل منها أو لا يمتلكها على الإطلاق خيالي القدرة. تأمل بعض كلمات الأغنية الكلاسيكية من ستينيات القرن الماضي، طواحين الهواء في عقلك:

مثل دوامة تدور، تدور حلقات حول القمر

مثل ساعة تتحرك عقاربها بسرعة متجاوزة دقائق وجهها

والعالم أشبه بتفاحة تدور بصمت في الفضاء

تمثل هذه المقارنات مجالًا من التلميح الشعري ذي مغزى للبشر يتجاوز التعبير الفني بكثير؛ بل إنه مرتبط بكيفية تطويرنا لأنظمتنا الإدراكية؛ فبينما نخلق مجال "الموضوع" الخاص بنا، فإننا نطور القدرة على التشابه البصري، بحيث – على سبيل المثال – المقاطع العرضية التي تصور الخوخ وكوكب الأرض، أو التكرارات الكسورية مثل حلزونات القهوة وفروع المجرة، التسجيل على أنه مماثل معنا.

وبهذه الطريقة يمكننا استنتاج الروابط بين الأشياء وأنواع الأشياء التي تبدو غير مترابطة، و أنظمة الاستدلال (مثل الجاذبية والزخم والتماسك السطحي) التي يمكن تطبيقها على مجموعة متنوعة من المجالات وعلى نطاقات متنوعة.

رؤية الأشياء

حتى أحدث جيل من أنظمة الذكاء الاصطناعي لمقارنة الصور، مثل نظام تشابه رقع الصور الإدراكي المتعلم (LPIPS) و DINOوالتي تستند إلى ملاحظات بشرية، لا تقوم إلا بمقارنات سطحية حرفية.

قدرتهم على إيجاد وجوه حيث لا وجود لها - أي، الباريدوليا لا يمثل هذا النوع من آليات التشابه البصري التي يطورها البشر، بل يحدث لأن خوارزميات البحث عن الوجوه تستخدم بنية الوجه منخفضة المستوى ملامح والتي تتوافق أحيانًا مع أشياء عشوائية:

أمثلة على النتائج الإيجابية الخاطئة للتعرف على الوجوه في مجموعة بيانات "الوجوه مع الأشياء". مصدر

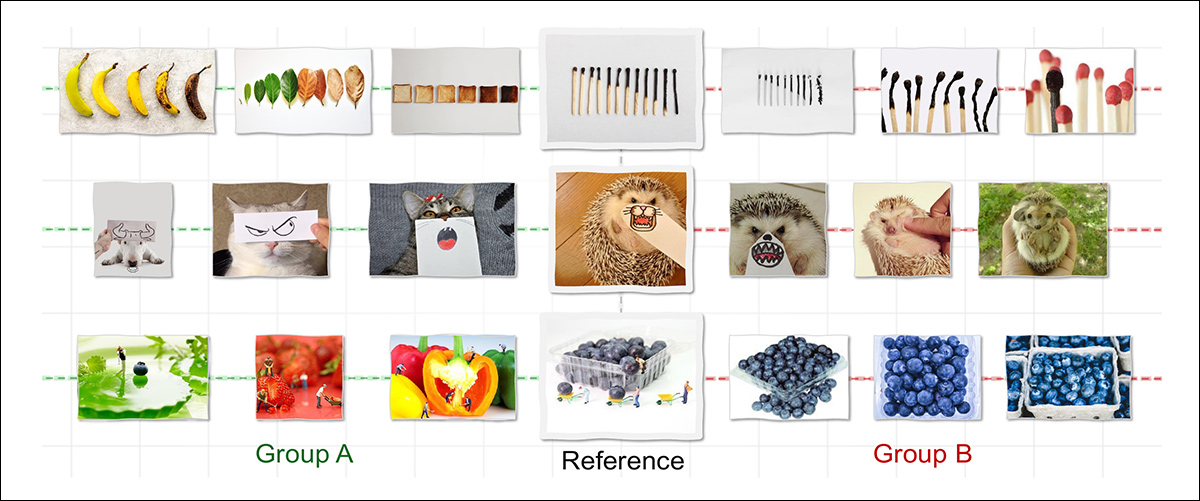

لتحديد ما إذا كانت الآلات قادرة بالفعل على تطوير قدرتنا التخيلية على التعرف على التشابه البصري عبر المجالات، أجرى باحثون في الولايات المتحدة دراسة دراسة حول التشابه البصري العلائقي، وتنسيق وتدريب مجموعة بيانات جديدة مصممة لإجبار العلاقات المجردة على التكوّن بين كائنات مختلفة، والتي مع ذلك ترتبط بعلاقة مجردة:

لا تتعرف معظم نماذج الذكاء الاصطناعي على التشابه إلا عندما تتشارك الصور سمات سطحية كالشكل أو اللون، ولذلك فهي تربط المجموعة "ب" (أعلاه) فقط بالصورة المرجعية. في المقابل، يرى البشر المجموعة "أ" متشابهة أيضاً، ليس لأن الصور متطابقة ظاهرياً، بل لأنها تتبع نفس المنطق الأساسي، كأن تُظهر تحولاً عبر الزمن. يسعى هذا العمل الجديد إلى محاكاة هذا النوع من التشابه البنيوي أو العلائقي، بهدف تقريب الإدراك الآلي من التفكير البشري.. المصدر: https://arxiv.org/pdf/2512.07833

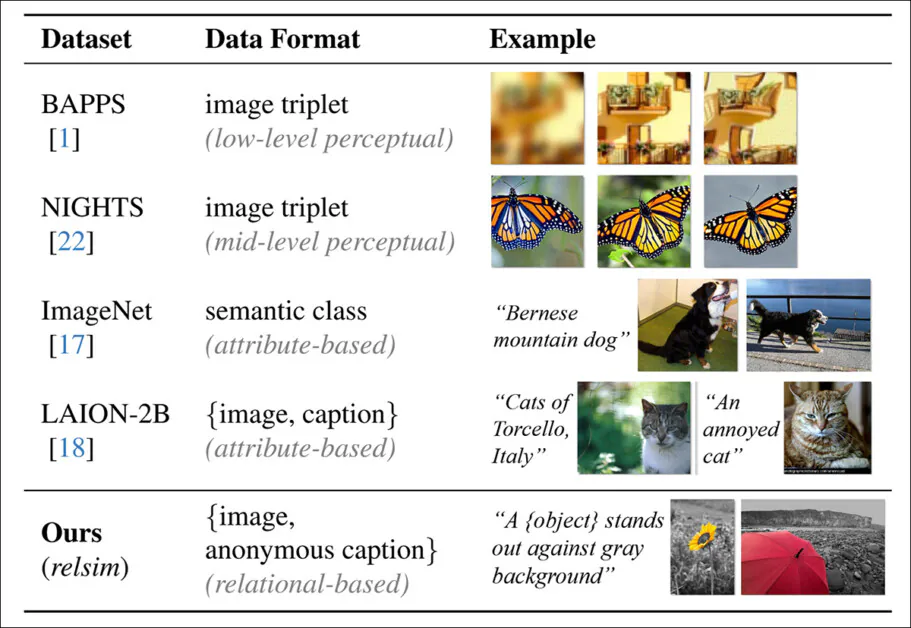

يُسهّل نظام التعليق الذي تم تطويره لمجموعة البيانات إضافة تعليقات توضيحية مجردة بشكل غير عادي، وهو مصمم لإجبار أنظمة الذكاء الاصطناعي على التركيز على الخصائص الأساسية بدلاً من التفاصيل المحلية المحددة:

التعليقات "المجهولة" المتوقعة التي تساهم في مقياس "الواقعية" الخاص بالمؤلفين.

تُغذي المجموعة المنسقة وأسلوب التعليق غير المألوف فيها المقياس الجديد الذي اقترحه المؤلفون relsimوالتي قام المؤلفون صقل في نموذج رؤية-لغة (VLM).

مقارنة بين أسلوب التعليق التوضيحي لمجموعات البيانات النموذجية، والذي يركز على تشابه السمات، بينما يؤكد نهج relsim (الصف السفلي) على التشابه العلائقي.

يعتمد النهج الجديد على منهجيات من العلوم المعرفية، ولا سيما منهجية ديدري جنتنر. نظرية رسم الخرائط الهيكلية (دراسة في القياس) وعاموس تفرسكي تعريف من حيث التشابه العلائقي والتشابه في السمات.

من موقع المشروع ذي الصلة، مثال على التشابه العلائقي. مصدر

يذكر المؤلفون:

يعالج البشر تشابه الصفات إدراكياً، لكن التشابه العلائقي يتطلب تجريداً مفاهيمياً، غالباً ما يكون مدعوماً باللغة أو المعرفة السابقة. وهذا يشير إلى أن إدراك التشابه العلائقي يتطلب أولاً فهم الصورة، والاستناد إلى المعرفة، وتجريد بنيتها الأساسية.

أكثر من ورقة جديدة بعنوان التشابه البصري العلائقي، ويأتي مع موقع المشروع (شاهد الفيديو المضمن في نهاية هذه المقالة).

الأسلوب

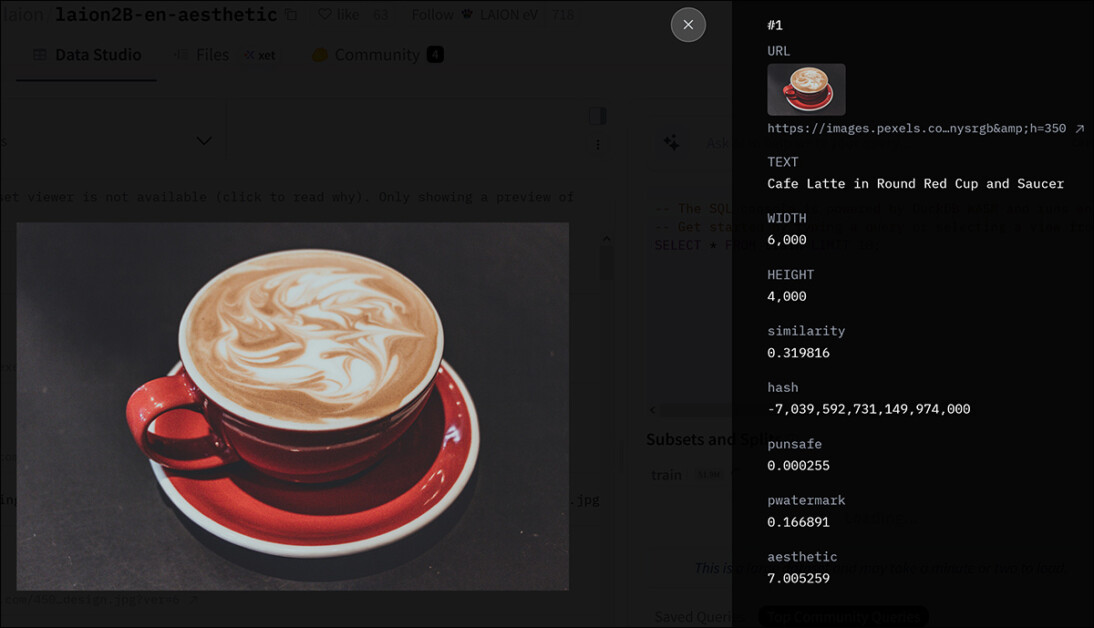

استخدم الباحثون إحدى أشهر مجموعات البيانات فائقة النطاق كنقطة انطلاق لمجموعتهم الخاصة – لايون -2 ب:

البيانات الوصفية لإدخال في مجموعة LAION-2B. مصدر

تم استخراج 114,000 صورة من المحتمل أن تحتوي على هياكل علائقية مرنة من LAION-2B، وهو ما تضمن تصفية العديد من الصور منخفضة الجودة الموجودة في مجموعة البيانات التي تم تنسيقها بشكل بسيط.

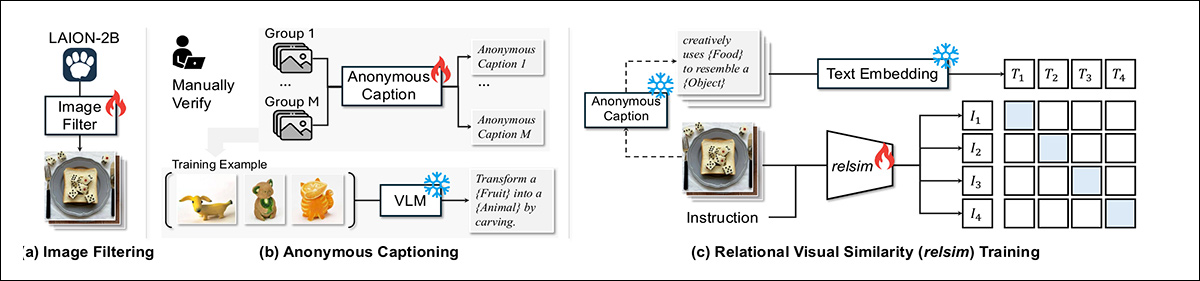

لإنشاء مسار لعملية الاختيار هذه، استخدم المؤلفون كوين 2.5-في ال-7 بي، بالاستفادة من 1,300 مثال إيجابي و11,000 مثال سلبي تم تصنيفها بواسطة البشر:

يتم تدريب نظام relsim على ثلاث مراحل: تصفية الصور من LAION-2B للحصول على محتوى علائقي؛ وتعيين تعليق مجهول مشترك لكل مجموعة يجسد منطقها الأساسي؛ وتعلم مطابقة الصور مع تلك التعليقات باستخدام خسارة تباينية.

تقول الورقة:

تم توجيه المُعلِّقين بالسؤال التالي: "هل يمكنك رؤية أي نمط علائقي أو منطق أو بنية في هذه الصورة يمكن أن تكون مفيدة لإنشاء صورة أخرى أو ربطها بها؟". يحقق النموذج المُحسَّن توافقًا بنسبة 93% مع الأحكام البشرية، وعند تطبيقه على مجموعة بيانات LAION-2B، ينتج عنه N = 114 ألف صورة تم تحديدها على أنها ذات أهمية علائقية.

لإنشاء تصنيفات علائقية، حثّ الباحثون نموذج Qwen على وصف المنطق المشترك وراء مجموعات الصور دون تسمية كائنات محددة. كان من الصعب الحصول على هذا التجريد عندما رأى النموذج صورة واحدة فقط، ولكنه أصبح قابلاً للتطبيق عندما أظهرت أمثلة متعددة النمط الكامن.

أدت التسميات التوضيحية الناتجة على مستوى المجموعة إلى استبدال المصطلحات المحددة بعناصر نائبة مثل '{موضوع}' or '{نوع الحركة}'مما يجعلها قابلة للتطبيق على نطاق واسع.

بعد التحقق البشري، تم ربط كل تعليق بجميع الصور في مجموعته. تم استخدام أكثر من 500 مجموعة من هذا القبيل لتدريب النموذج، والذي تم تطبيقه بعد ذلك على 114,000 صورة مُفلترة لإنتاج مجموعة كبيرة من العينات المُجردة والمُصنفة ترابطيًا.

البيانات والاختبارات

بعد استخراج السمات العلائقية باستخدام Qwen2.5-VL-7B، تم ضبط النموذج بدقة على البيانات باستخدام لورا، لـ 15,000 خطوة، عبر ثمانية وحدات معالجة رسومية A100*. أما بالنسبة للنص، فقد تم تضمين التعليقات التوضيحية باستخدام جميع MiniLM-L6-v2 من مكتبة مُحوِّلات الجمل.

مجموعة البيانات التي تضم 114,000 صورة مع تعليقات توضيحية كانت انقسم تم تقسيم البيانات إلى 100,000 للتدريب و14,000 للتقييم. ولاختبار النظام، استُخدم إعداد استرجاع: عند إعطاء صورة استعلام، كان على النموذج إيجاد صورة مختلفة من بين 28,000 صورة تُعبّر عن نفس الفكرة العلائقية. احتوت مجموعة الاسترجاع على 14,000 صورة تقييمية و14,000 عينة إضافية من LAION-2B، مع اختيار 1,000 استعلام عشوائيًا من مجموعة التقييم لأغراض المقارنة المعيارية.

لتقييم جودة الاسترجاع، جي بي تي-4o تم استخدام مقياس لتقييم التشابه العلائقي بين كل استعلام والصورة المسترجعة على مقياس من 0 إلى 10. كما تم إجراء دراسة بشرية منفصلة لقياس تفضيل المستخدم (انظر أدناه).

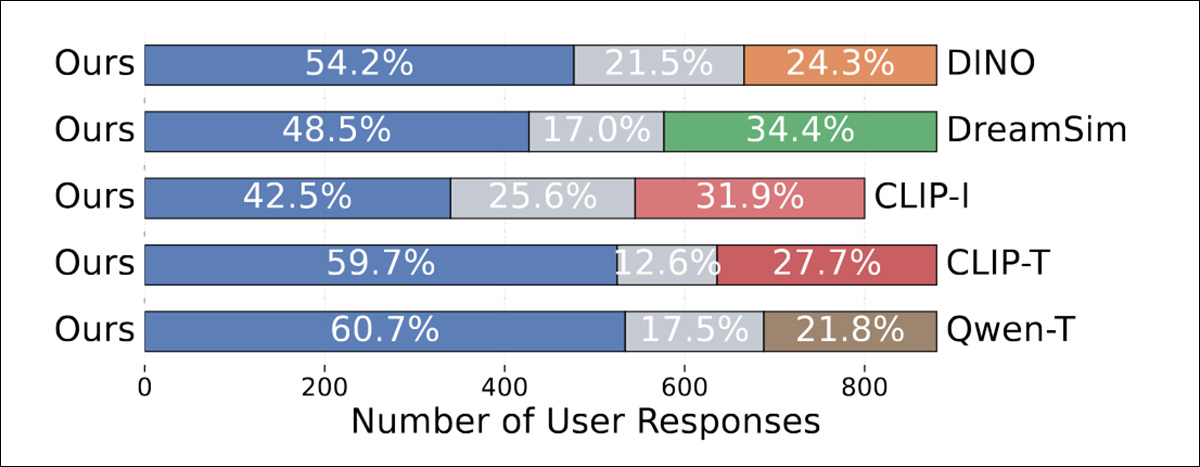

عُرضت على كل مشارك صورة استعلام مجهولة المصدر مع صورتين مرشحتين، إحداهما تم استرجاعها باستخدام الطريقة المقترحة، والأخرى باستخدام طريقة مرجعية. سُئل المشاركون عن الصورة الأكثر تشابهًا مع صورة الاستعلام، أو ما إذا كانت كلتاهما متقاربتين بنفس القدر. لكل طريقة مرجعية، تم إنشاء 300 مجموعة ثلاثية، وقام بتقييم كل منها ثلاثة أشخاص على الأقل، مما أسفر عن حوالي 900 استجابة.

تمت مقارنة أسلوب relsim بالعديد من طرق قياس التشابه بين الصور المعروفة، بما في ذلك طريقتي LPIPS وDINO المذكورتين سابقًا، بالإضافة إلى دريمسيمو كليب-1بالإضافة إلى الخطوط الأساسية التي تحسب مباشرة درجات التشابه بين أزواج الصور، مثل LPIPS وDINO وdreamsim وCLIP-I، اختبر المؤلفون أيضًا الطرق القائمة على التعليقات التوضيحية التي تم فيها استخدام Qwen لإنشاء تعليق توضيحي مجهول أو مجرد لكل صورة؛ ثم تم استخدام هذا كاستعلام استرجاع.

تم تقييم نوعين من أساليب الاسترجاع، حيث استُخدم أسلوب CLIP-T (استرجاع النص إلى صورة باستخدام CLIP) لاسترجاع النص إلى صورة، بينما استُخدم أسلوب Qwen-T (استرجاع النص إلى نص). واعتمد كلا الأسلوبين الأساسيين القائمين على التعليقات التوضيحية على نموذج Qwen الأصلي المُدرَّب مسبقًا، بدلًا من النسخة المُعدَّلة بناءً على المنطق العلائقي. وقد مكّن هذا الباحثين من عزل تأثير التدريب الجماعي، نظرًا لأن النموذج المُعدَّل قد عُرِّض لمجموعات من الصور، بدلًا من أمثلة منفردة.

المقاييس الحالية والتشابه العلائقي

قام المؤلفون في البداية باختبار ما إذا كانت المقاييس الحالية قادرة على رصد التشابه العلائقي:

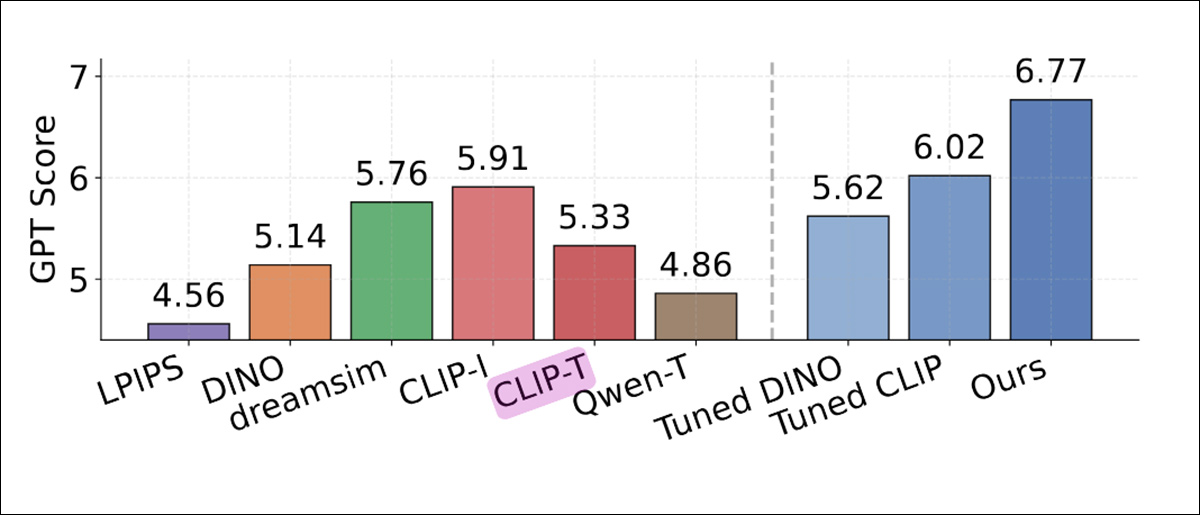

مقارنة أداء الاسترجاع وفقًا لتقييم GPT-4o، تُظهر متوسط درجة التشابه العلائقي لكل طريقة. سجلت مقاييس التشابه التقليدية مثل LPIPS وDINO وCLIP-I درجات أقل. كما كان أداء خطي الأساس Qwen-T وCLIP-T القائمين على التعليقات ضعيفًا. حققت relsim أعلى درجة (6.77، العمود الأزرق الأقصى يمينًا)، مما يشير إلى أن الضبط الدقيق لأنماط العلاقات القائمة على المجموعات قد حسّن التوافق مع تقييمات GPT-4o.

وفيما يتعلق بهذه النتائج، ذكر المؤلفون ما يلي:

يحقق نموذج [LPIPS]، الذي يركز حصراً على التشابه الإدراكي، أدنى درجة (4.56). ويتفوق عليه نموذج [DINO] بشكل طفيف (5.14)، على الأرجح لأنه مُدرَّب ذاتياً بالكامل على بيانات الصور. أما نموذج [CLIP-I] فيُحقق أفضل النتائج بين النماذج الأساسية (5.91)، ويُعزى ذلك على الأرجح إلى وجود بعض التجريد أحياناً في تعليقات الصور.

"ومع ذلك، لا يزال أداء CLIP-I أقل من أداء طريقتنا، حيث أن تحقيق درجة أفضل قد يتطلب القدرة على الوصول إلى مستويات تجريدية أعلى، مثل تلك الموجودة في التعليقات المجهولة."

في دراسة المستخدمين، فضّل البشر باستمرار طريقة الواقعية عبر جميع خطوط الأساس:

درجات التشابه العلائقي التي حددها نموذج GPT-4o لكل طريقة. سجلت مقاييس التشابه القياسية مثل LPIPS وDINO وCLIP-I درجات أقل، بينما حققت المتغيرات القائمة على التعليقات Qwen-T وCLIP-T أداءً أفضل قليلاً فقط. حتى النسخ المُحسّنة من DINO وCLIP لم تُقلّص الفجوة. حقق نموذج relsim، المُدرّب باستخدام الإشراف الجماعي، أعلى درجة، وهي 6.77.

يلاحظ المؤلفون:

هذا أمرٌ مُشجع للغاية، لأنه يُظهر ليس فقط أن نموذجنا، relsim، يمكنها استرجاع الصور المتشابهة من حيث العلاقة بنجاح، ولكنها تؤكد أيضاً، مرة أخرى، أن البشر يدركون التشابه من حيث العلاقة - وليس مجرد تشابه الصفات!

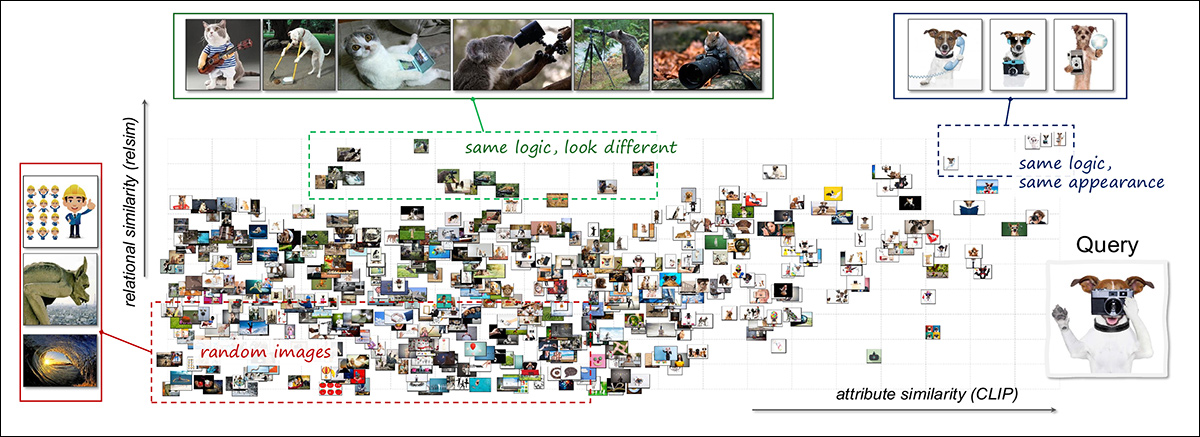

لاستكشاف كيفية تكامل التشابه العلائقي والتشابه في السمات، استخدم الباحثون طريقة تصوير مشتركة. صورة استعلام واحدة (كلب يحمل كاميراتمت مقارنة ) مع 3,000 صورة عشوائية، وتم حساب التشابه باستخدام كل من النماذج العلائقية والنماذج القائمة على السمات:

تمثيل مرئي مشترك لمساحة التشابه البصري باستخدام محاور العلاقات والسمات. تمت مقارنة صورة استعلام واحدة، تُظهر كلبًا يستخدم كاميرا، مع 3,000 صورة أخرى. نُظمت النتائج حسب تشابه العلاقات (عموديًا) وتشابه السمات (أفقيًا). تحتوي المنطقة العلوية اليمنى على صور تُشبه صورة الاستعلام من حيث المنطق والمظهر، مثل كلاب أخرى تستخدم أدوات. تحتوي المنطقة العلوية اليسرى على حالات ذات صلة دلالية ولكنها متميزة بصريًا، مثل حيوانات مختلفة تقوم بأفعال متعلقة بالكاميرا. تتجمع معظم الأمثلة المتبقية في الجزء السفلي من المساحة، مما يعكس تشابهًا أضعف. يوضح التصميم كيف تُبرز نماذج العلاقات والسمات جوانب مُكملة للبيانات المرئية. يُرجى الرجوع إلى الورقة البحثية الأصلية للحصول على دقة أفضل.

كشفت النتائج عن مجموعات تتوافق مع أنواع مختلفة من التشابه: بعض الصور كانت متشابهة من الناحية العلائقية والبصرية، مثل الكلاب الأخرى في وضعيات تشبه وضعيات البشر؛ والبعض الآخر يشترك في المنطق العلائقي ولكن ليس في المظهر، مثل الحيوانات المختلفة التي تحاكي تصرفات البشر؛ أما الباقي فلم يظهر أيًا منهما.

يشير هذا التحليل إلى أن نوعي التشابه يخدمان أدوارًا متميزة ويؤديان إلى بنية أكثر ثراءً عند دمجهما.

استخدم حالات

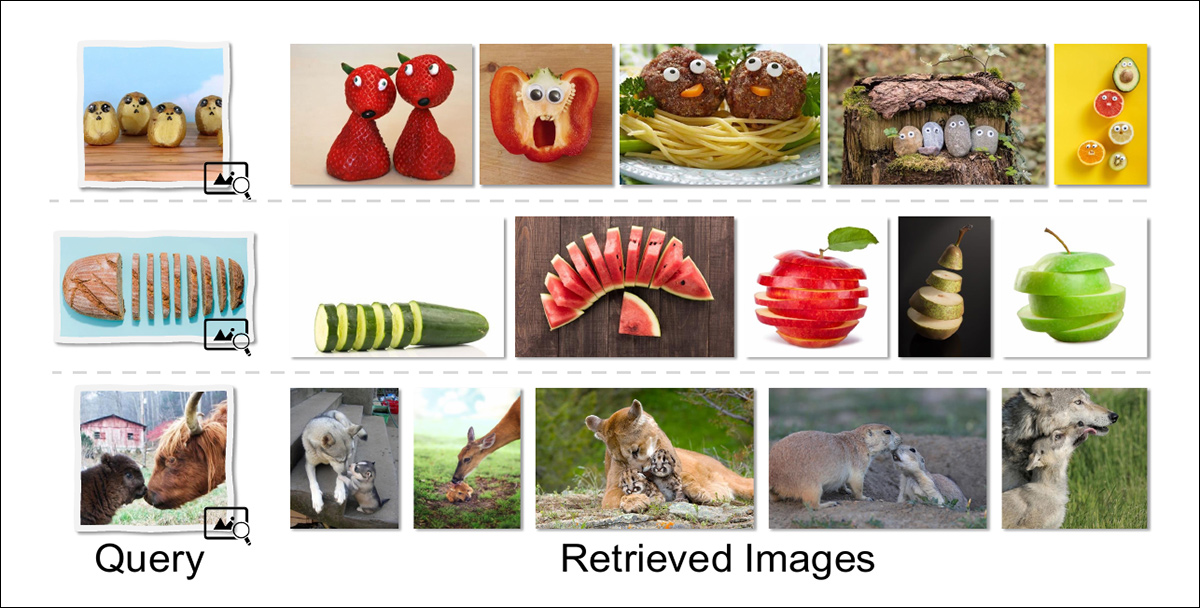

وتستكشف الورقة البحثية أيضاً بعض حالات الاستخدام النهائي المحتملة للتشابه العلائقي، بما في ذلك استرجاع الصور العلائقيةمما يسمح بالبحث عن الصور بطريقة أكثر انسجاماً مع الطريقة الإبداعية التي ينظر بها البشر إلى العالم:

يُعيد الاسترجاع العلائقي صورًا تشترك في بنية مفاهيمية أعمق مع الاستعلام، بدلاً من مطابقة السمات السطحية. على سبيل المثال، يُعيد عنصر غذائي مصمم ليشبه وجهًا صورًا لوجبات أخرى ذات خصائص بشرية؛ ويُعيد جسم مقطع صورًا لأشكال مقطعة أخرى؛ وتُعيد مشاهد تفاعل البالغين مع صغارهم صورًا ذات أدوار علائقية متشابهة، حتى عندما تختلف الأنواع والتكوين.

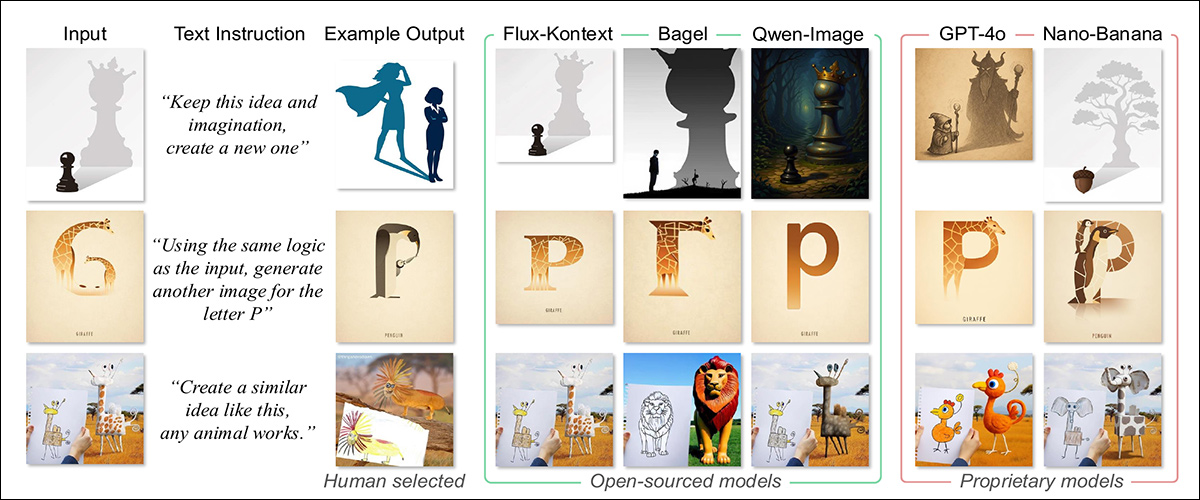

الاحتمال الآخر هو توليد الصور التناظريةمما يسمح بتوليف الاستعلامات التي تستخدم هياكل علائقية بدلاً من الأوصاف المباشرة. وبمقارنة النتائج المُستخلصة من الجيل الحالي لأحدث نماذج تحويل النصوص إلى صور، نلاحظ أن نتائج هذا النهج من المرجح أن تكون أكثر تنوعاً.

عند إدخال صورة وتوضيح علاقة معينة، طُلب من النماذج توليد صورة جديدة تعبر عن المفهوم الأساسي نفسه. أنتجت النماذج الخاصة تشبيهات أكثر دقة، محافظةً على المنطق البنيوي رغم التغيرات الكبيرة في الشكل، بينما مالت النماذج مفتوحة المصدر إلى التطابق الحرفي أو الأسلوبي، عاجزةً عن نقل الفكرة الأعمق. قورنت المخرجات بتشبيهات منتقاة يدويًا، والتي جسدت التحول المقصود.

الخاتمة

يبدو أن أنظمة الذكاء الاصطناعي التوليدي ستتحسن بشكل ملحوظ من خلال قدرتها على دمج التمثيل المجرد في تصوراتها. ففي الوضع الحالي، يؤدي طلب صور قائمة على مفاهيم مثل "الغضب" أو "السعادة" إلى إرجاع صور مُصممة من الصور الأكثر شيوعًا أو انتشارًا التي تحمل هذه المعاني في مجموعة البيانات؛ وهو ما حفظ بدلاً من التجريد.

من المفترض أن يكون هذا المبدأ أكثر فائدة إذا أمكن تطبيقه على الكتابة التوليدية - وخاصة الإنتاج التحليلي أو التأملي أو الخيالي.

اضغط للتشغيل. مصدر

* يمكن أن يحتوي جهاز A100 على ذاكرة وصول عشوائي للفيديو (VRAM) بسعة 40 جيجابايت أو 80 جيجابايت؛ وهذا غير محدد في الورقة.

** تم حذف الاستشهادات بالمؤلفين لأنها زائدة عن الحاجة.

نُشرت لأول مرة يوم الثلاثاء 16 ديسمبر 2025