Gedagte Leiers

Dekodering van geleenthede en uitdagings vir LLM-agente in generatiewe KI

Ons sien 'n vordering van Generatiewe KI-toepassings wat deur groot taalmodelle (LLM) aangedryf word, van aansporings tot herwinning versterkte generasie (RAG) tot agente. Daar word baie oor agente gepraat in die industrie en navorsingskringe, hoofsaaklik vir die krag wat hierdie tegnologie bied om ondernemingstoepassings te transformeer en voortreflike klantervarings te bied. Daar is algemene patrone vir bouagente wat eerste stappe in die rigting van kunsmatige algemene intelligensie (AGI) moontlik maak.

In my vorige artikel, het ons 'n leer van intelligensie van patrone gesien vir die bou van LLM-aangedrewe toepassings. Begin met aanwysings wat probleemdomein vaslê en LLM interne geheue gebruik om uitset te genereer. Met RAG vul ons die aansporing aan met eksterne kennis wat vanaf 'n vektordatabasis gesoek word om die uitsette te beheer. Volgende deur LLM-oproepe te ketting kan ons werkvloeie bou om komplekse toepassings te realiseer. Agente neem dit na 'n volgende vlak deur outomaties te bepaal hoe hierdie LLM-kettings gevorm moet word. Kom ons kyk in detail.

Agente – Onder die enjinkap

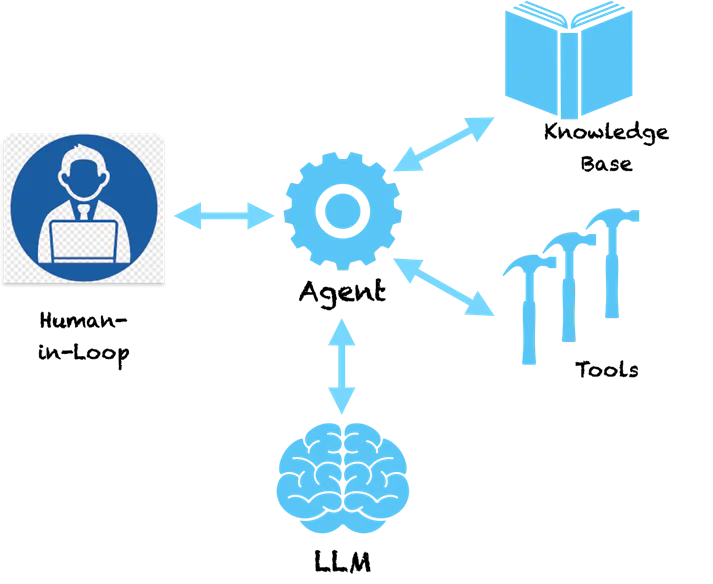

'n Sleutelpatroon by agente is dat hulle die taalbegripkrag van LLM gebruik om 'n plan te maak oor hoe om 'n gegewe probleem op te los. Die LLM verstaan die probleem en gee vir ons 'n reeks stappe om die probleem op te los. Dit stop egter nie daar nie. Agente is nie 'n suiwer ondersteuningstelsel wat jou aanbevelings sal gee oor die oplossing van die probleem en dan die aflosstokkie aan jou sal oordra om die aanbevole stappe te neem nie. Agente word bemagtig met gereedskap om voort te gaan en die aksie te neem. Skrikwekkend reg!?

As ons 'n agent 'n basiese vraag soos hierdie vra:

Mens: Watter maatskappy het die uitvinder van die telefoon begin?

Hier volg 'n voorbeeld van denkstappe wat 'n agent kan neem.

Agent (DINK):

- Gedagte: Ek moet soek na die uitvinder van die telefoon.

- Aksie: Soek [uitvinder van telefoon]

- Waarneming: Alexander Graham Bell

- Gedagte: Ek moet 'n maatskappy soek wat deur Alexander Graham Bell gestig is

- Aksie: Soek [maatskappy gestig deur Alexander Graham Bell]

- Waarneming: Alexander Graham Bell was medestigter van die American Telephone and Telegraph Company (AT&T) in 1885

- Gedagte: Ek het die antwoord gevind. Ek sal teruggaan.

Agent (RESPONS): Alexander Graham Bell het AT&T in 1885 mede-stigter

Jy kan sien dat die agent 'n metodiese manier volg om die probleem op te breek in subprobleme wat opgelos kan word deur spesifieke aksies te neem. Die aksies hier word deur die LLM aanbeveel en ons kan dit karteer na spesifieke instrumente om hierdie aksies te implementeer. Ons kan 'n soekinstrument vir die agent aktiveer sodat wanneer dit besef dat LLM soektog as 'n aksie verskaf het, dit hierdie instrument sal oproep met die parameters wat deur die LLM verskaf word. Die soektog hier is op die internet, maar kan ook herlei word om 'n interne kennisbasis soos 'n vektordatabasis te soek. Die stelsel word nou selfversorgend en kan uitvind hoe om komplekse probleme op te los na aanleiding van 'n reeks stappe. Raamwerke soos Langketting en LLaMAIndex gee jou 'n maklike manier om hierdie agente te bou en aan gereedskap en API te koppel. Amazon het onlangs hul Bedrock Agents-raamwerk bekendgestel wat 'n visuele koppelvlak bied vir die ontwerp van agente.

Onder die enjinkap volg agente 'n spesiale styl om opdragte na die LLM te stuur wat hulle 'n aksieplan laat opstel. Die bogenoemde Gedagte-Aksie-Waarneming-patroon is gewild in 'n tipe agent genaamd ReAct (Reasoning and Acting). Ander soorte agente sluit in MRKL en Plan & Execute, wat hoofsaaklik verskil in hul aansporingsstyl.

Vir meer komplekse agente kan die aksies gekoppel wees aan gereedskap wat veranderinge in bronstelsels veroorsaak. Ons kan byvoorbeeld die agent koppel aan 'n instrument wat vir vakansiebalans nagaan en aansoek doen vir verlof in 'n ERP-stelsel vir 'n werknemer. Nou kan ons 'n lekker kletsbot bou wat met gebruikers sal kommunikeer en via 'n kletsopdrag aansoek doen om verlof in die stelsel. Geen ingewikkelde skerms meer om aansoek te doen vir blare nie, 'n eenvoudige verenigde kletskoppelvlak. Klink opwindend!?

Waarskuwings en behoefte aan verantwoordelike KI

Nou wat as ons 'n instrument het wat transaksies op aandeleverhandeling oproep deur 'n vooraf-gemagtigde API te gebruik. Jy bou 'n toepassing waar die agent voorraadveranderinge bestudeer (met behulp van gereedskap) en vir jou besluite neem oor die koop en verkoop van voorraad. Wat as die agent die verkeerde voorraad verkoop omdat dit gehallusineer het en 'n verkeerde besluit geneem het? Aangesien LLM groot modelle is, is dit moeilik om vas te stel hoekom hulle sekere besluite neem, daarom is hallusinasies algemeen in die afwesigheid van behoorlike vangrelings.

Alhoewel agente almal fassinerend is, sou jy waarskynlik geraai het hoe gevaarlik hulle kan wees. As hulle hallusineer en 'n verkeerde aksie neem wat groot finansiële verliese of groot probleme in Enterprise-stelsels kan veroorsaak. Daarom word verantwoordelike KI van uiterste belang in die era van LLM-aangedrewe toepassings. Die beginsels van Verantwoordelike KI rondom reproduceerbaarheid, deursigtigheid en aanspreeklikheid, probeer om veiligheidsrelings te plaas op besluite wat deur agente geneem word en stel risiko-analise voor om te besluit watter aksies 'n mens-in-die-lus benodig. Soos meer komplekse agente ontwerp word, benodig hulle meer ondersoek, deursigtigheid en aanspreeklikheid om seker te maak ons weet wat hulle doen.

sluiting gedagtes

Die vermoë van agente om 'n pad van logiese stappe met aksies te genereer, bring hulle baie naby aan menslike redenasie. Deur hulle met kragtiger gereedskap te bemagtig, kan hulle superkragte gee. Patrone soos ReAct probeer naboots hoe mense die probleem oplos en ons sal beter agentpatrone sien wat relevant sal wees vir spesifieke kontekste en domeine (bankwese, versekering, gesondheidsorg, nywerheid, ens.). Die toekoms is hier en tegnologie agter agente is gereed vir ons om te gebruik. Terselfdertyd moet ons noukeurig aandag gee aan Verantwoordelike KI-relings om seker te maak ons bou nie Skynet nie!