安德森的角度

利用人工智能为真实视频添加对话

一种新的人工智能框架可以在一个端到端的系统中,无需重新拍摄,即可重写、删除或添加视频中人物的言语。

三年前,每周学术门户网站上都会发布 20-30 个 AI 视频修改框架,任何一个都会让互联网感到震惊;而现在,这一热门研究领域已经变得如此丰富,几乎构成了“AI 垃圾”的另一个分支,因此,我报道的此类发布数量远少于两三年前。

然而,该系列中的一款最新产品引起了我的注意:它是一个集成系统,可以干预真实的视频片段,并将新的语音插入到现有视频中(而不是像通常那样,从人脸或帧中创建整个生成片段)。

以下示例是我从发布会上提供的众多示例视频中剪辑而成的: 项目网站首先,我们看到的是真实的原始视频片段,然后在片段中间,我们看到的是后期添加的AI语音,包括语音合成和唇形同步:

点击播放。 局部编辑拼接——FacEDiT提供的多种编辑方式之一。请访问原网站查看更高分辨率的图片。 来源 – https://facedit.github.io/

这种方法是为新方法开发的三种方法之一,名为“局部拼接编辑”,也是作者(以及我本人)最感兴趣的方法。其基本原理是:以视频中间的某一帧作为人工智能进行新解读的起点,并以该帧的下一个(真实)帧作为目标帧,生成式插入的视频片段应与之匹配。在上面的视频片段中,这些“种子”帧和“目标”帧通过最上面的视频暂停,而下方经过修改的视频提供生成式填充来表示。

作者将这种面部和声音合成方法定义为首个完全集成的端到端人工智能视频编辑方法,并指出这种成熟框架在电视和电影制作方面具有巨大潜力:

电影制作人和媒体制作人经常需要修改录制视频中的特定部分——可能是说错了一个词,或者拍摄后剧本有所更改。例如,在那个标志性的场景中…… 泰坦尼克号 (1997 年)罗斯说道: “我永远不会放手,杰克。” 导演之后可能会决定应该这样做。 “我永远不会忘记你,杰克。”.

“传统上,这类修改需要重拍整个场景,这既费时又费钱。而语音合成技术提供了一种实用的替代方案,它能自动调整面部动作以匹配修改后的语音,从而无需重拍。”

尽管此类人工智能干预可能面临 文化 即使面临行业阻力,它们也可能构成以人为主导的视觉特效系统和工具套件中的一种新型功能。无论如何,就目前而言,挑战仅限于技术层面。

除了通过添加人工智能生成的对话来延长视频片段外,新系统还可以修改现有的语音:

点击播放。 这是一个修改现有对话而非插入新对话的例子。请参考源网站以获得更清晰的显示效果。

最先进的

目前还没有端到端的系统能够提供这种合成能力;尽管越来越多的生成式人工智能平台,例如谷歌的平台,正在努力实现这一目标。 Veo系列可以生成音频,其他各种框架也可以创建 深度伪造音频目前,为了以新系统(名为……)的方式干扰真实影像,人们必须创建一个相当复杂的、包含各种架构和技巧的流程。 脸书 可以完成。

该系统采用 扩散变压器 (DiT)与 流量匹配 该系统利用现有的常用面部重建软件包,生成基于周围环境(上下文)动作和语音音频内容的面部动作。 现场肖像 (最近被 Kling 收购)。

除了这种方法之外,鉴于他们的方法是第一个将这些挑战整合到一个单一解决方案中的,作者还创建了一种名为“新基准”的基准。 面面观以及几个完全适用于这项特定任务的全新评估指标。

这个 新工作 标题为 FacEDiT:基于面部动作填充的统一语音人脸编辑与生成该研究由韩国浦项科技大学 (POSTECH)、韩国科学技术院 (KAIST) 和德克萨斯大学奥斯汀分校的四位研究人员共同完成。

付款方式

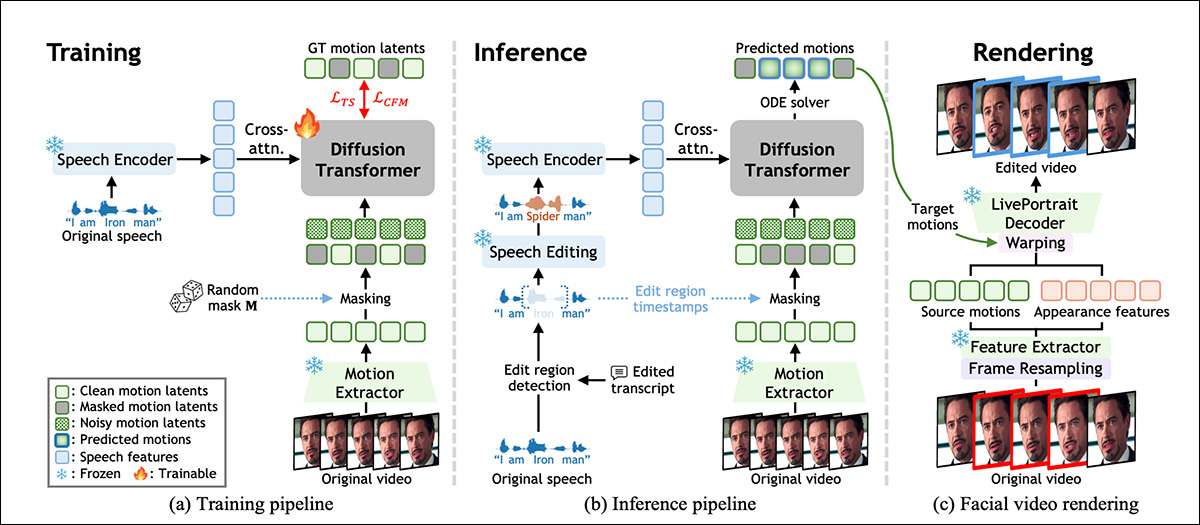

FacEDiT 通过学习如何根据周围环境运动和语音音频来填充演员原始表演中缺失的部分,从而重建面部动作。如下图所示,该模型在训练过程中可以充当“填补空白”的角色,预测与语音相匹配的面部动作,同时保持与原始视频的一致性:

FacEDiT 系统概述,展示了如何在训练期间通过自监督填充来学习面部运动,在推理时通过编辑的语音进行指导,最后通过重用原始素材的外观,同时仅替换目标运动,将面部运动渲染回视频。 来源

在推理时,相同的架构支持两种不同的输出,具体取决于视频被遮盖的程度:部分编辑,其中只更改一个短语,其余部分保持不变;或者完整句子生成,其中完全从头开始合成新的动作。

该模型通过以下方式进行训练 流匹配它将视频编辑视为两种面部动作版本之间的一种路径。

流程匹配并非从零开始猜测编辑后的面部表情,而是学习如何在嘈杂的占位符和正确的动作之间平滑过渡。为了实现这一点,系统使用上述 LivePortrait 系统的一个变体(参见上图)从每一帧中提取出一组紧凑的数字,并将面部动作表示为这些数字。

这些运动矢量旨在描述表情和头部姿态,而无需 纠缠 身份识别,以便能够局部化语音变化,而不影响人的整体外貌。

FaceDiT培训

为了训练 FacEDiT,每个视频片段都被分解成一系列面部运动快照,每一帧都与相应的音频片段配对。然后,随机隐藏部分运动数据,并让模型根据语音和周围未被遮挡的运动信息来猜测这些缺失的运动应该是什么样子。

由于掩码跨度及其位置因训练样本而异,模型会根据所获得的信息量,逐渐学习如何处理小的内部编辑和较长的间隙,从而生成完整的序列。

该系统的上述扩散变换器通过不断改进噪声输入来学习恢复被掩蔽的运动。音频不是一次性将语音和运动信号输入模型,而是通过不同的处理模块逐个输入。 交叉注意力帮助系统更精确地将唇部动作与语音匹配。

为了在剪辑过程中保持真实感,模型会将注意力集中在相邻帧而非整个时间线上,从而迫使模型专注于局部连续性,并防止在修改区域边缘出现闪烁或运动跳跃。位置嵌入(用于告知模型每一帧在序列中的位置)进一步帮助模型保持自然的时间流和上下文。

在训练过程中,系统通过基于语音和附近未被遮挡的动作重建被遮挡的面部动作范围,从而学习预测缺失的面部动作。在推理阶段,系统会重复使用相同的设置,但此时遮挡的位置会根据语音中的编辑进行调整。

当插入、删除或更改某个词语或短语时,系统会定位受影响的区域,将其屏蔽,并重新生成与新音频匹配的动作。完整序列生成则被视为一种特殊情况,此时整个区域都会被屏蔽并从头开始合成。

数据与测试

该系统的主干由22层扩散变换器组成,每层有16个单元。 注意力头 前馈尺寸为 1024 和 2024 像素。运动和外观特征提取使用 冻结 LivePortrait 组件,以及通过 LivePortrait 编码的语音 WavLM 并修改使用 语音工艺.

一个专用的投影层将 786 维语音特征映射到 DiT 的潜在空间,其中只有 DiT 和投影模块是从头开始训练的。

训练是在以下条件下进行的: 亚当 在两块 A6000 GPU(每块 GPU 配备 48GB 显存)上,以 1e-4 的目标学习率运行优化器,迭代一百万步,总共 批量大小 八个。

面面观

FacEDiTBench 数据集包含 250 个样本,每个样本都包含原始语音和编辑后语音的视频片段,以及两者的文本转录。这些视频来自三个来源,其中 100 个片段来自 高清TF,100来自 哈罗3,以及 50 个来自 CelebV-Dub我们对每个视频都进行了人工检查,以确认音频和视频都足够清晰,可以进行评估。

GPT‑4o 用于修订每份文本,以创建语法正确的修改版本。这些修订后的文本连同原始语音一起被提交给 VoiceCraft 生成新的音频;在每个阶段,文本和生成的语音都经过人工审核,以确保质量。

每个样本都标有编辑类型、更改时间和修改范围长度,编辑被分类为: 插入, 删除 或 换人修改的字数从 1 到 3 个字的短修改、4 到 6 个字的中等修改到 7 到 10 个字的长修改不等。

我们定义了三个自定义指标来评估编辑质量。 光度连续性通过比较边界处的像素级差异,来衡量编辑片段的光照和颜色与周围视频的融合程度; 运动连续性通过测量编辑帧和未编辑帧之间的光流变化来评估面部运动的一致性; 身份保护为了估计编辑后受试者的外观是否保持一致,我们通过比较原始序列和生成序列中的面部嵌入来评估这一指标。 弧面 人脸识别模型。

检测

测试模型使用上述三个数据集中的素材进行训练,总时长约为 200 小时的视频内容,包括视频博客、电影以及高分辨率 YouTube 视频。

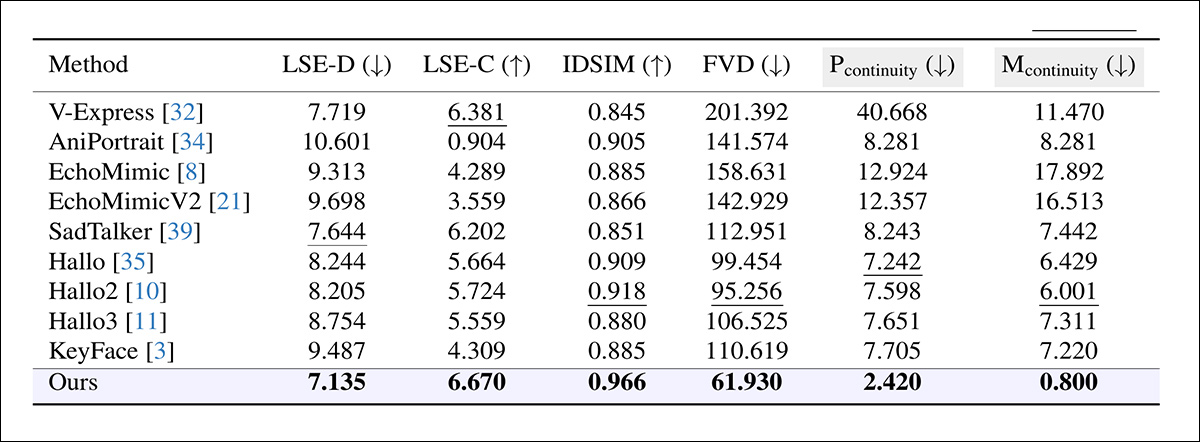

为了评估说话人脸编辑功能,除了HDTF测试划分之外,还使用了FacEDiTBench,HDTF测试划分已成为该系列任务的基准标准。

由于没有能够直接实现这种端到端功能的可比系统,作者选择了一系列能够重现至少部分目标功能并可作为基准的框架;具体而言, 键脸; 回声模仿; EchoMimicV2; 你好; 哈罗2; 哈罗3; V-Express; 动漫肖像;和 悲伤的谈话者.

此外,还采用了几种既定的指标来评估生成和编辑质量,并通过以下方式评估唇形同步准确性: 同步网络报告唇部动作与音频之间的绝对误差(LSE-D)和置信度评分(LSE-C); Fréchet 视频距离 (FVD)量化视频整体的真实感;以及 学习感知相似性度量 (LPIPS),测量生成帧和原始帧之间的感知相似性。

对于编辑,除 LPIPS 外的所有指标都只应用于修改后的片段;对于生成,则对整个视频进行评估,不包括边界连续性。

每个模型都用于合成一段匹配的视频片段,然后将其拼接到原始视频中(研究人员指出,这种方法经常会在编辑部分与周围素材的交界处引入明显的断点)。他们还测试了第二种方法,即根据修改后的音频重新生成整个视频——但这不可避免地覆盖了未编辑的区域,并且未能保留原始的表演效果:

本文比较了最初设计用于生成说话人脸的各种系统的编辑性能,结果表明 FacEDiT 在所有指标上均优于所有基线系统,实现了更低的唇部同步误差 (LSE-D)、更高的同步置信度 (LSE-C)、更强的身份保持性 (IDSIM)、更高的感知真实感 (FVD) 以及更平滑的编辑边界过渡 (Pcontinuity, Mcontinuity)。灰色阴影列突出显示了评估边界质量的关键标准;粗体和下划线数值分别表示最佳和次佳结果。

针对这些结果,作者评论道:

“[我们的]模型在编辑任务上显著优于现有方法。它实现了强大的边界连续性和高度的身份保留,展现了其在编辑过程中保持时间和视觉一致性的能力。此外,其卓越的唇形同步精度和低FVD值也反映了合成视频的真实性。”

点击播放。 结果由作者根据项目网站上发布的视频整理而成。如需更高分辨率的视频,请访问原始网站。

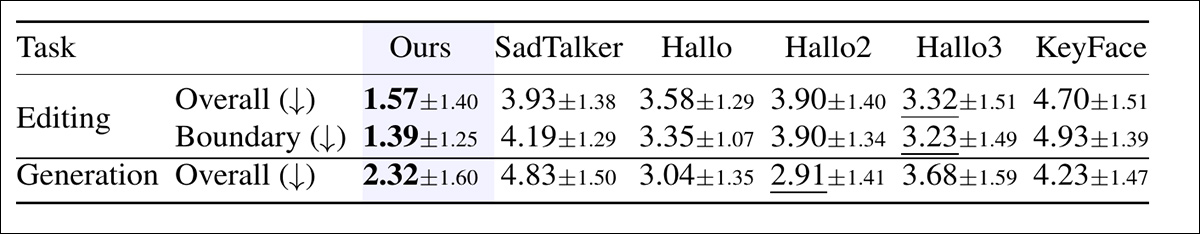

此外,还进行了一项人工研究,以评估编辑和生成过程中感知到的质量。

在每次对比测试中,参与者观看六段视频,并根据整体质量对其进行排名,排名依据包括唇形同步准确度、自然度和头部动作的真实性。在剪辑测试中,参与者还对剪辑片段和未剪辑片段之间的过渡流畅度进行了评分:

平均排名由人工评估员给出,分数越低越好。在编辑和生成两个环节,参与者都对每个视频的自然度和同步程度进行了评分。对于编辑环节,他们还对编辑后的语音和未编辑的语音之间的过渡流畅度进行了评分。粗体带下划线的数字表示最高的两个分数。

研究表明,FacEDiT 在编辑质量和过渡流畅性方面始终以明显优势排名第一,在生成设置中也获得了高分,这表明其衡量的优势转化为感知上更受欢迎的输出。

由于篇幅有限,我们建议读者参阅原文以了解更多消融研究的细节,以及新研究中开展和报告的其他测试。事实上,此类典型的研究成果很难产生有意义的测试结果部分,因为其核心内容本身不可避免地会成为后续研究的潜在基准。

结语

即使是推理,这类系统在推理时也可能需要大量的计算资源,这使得下游用户(此处指特效公司)难以在本地完成相关工作。因此,能够适应实际本地资源的方案始终会受到服务提供商的青睐,因为他们有法律义务保护客户的素材和知识产权。

这并不是要批评这个新产品,它很可能在量化权重或其他优化下完美运行,而且它是近段时间以来第一个吸引我重新关注这一研究方向的产品。

首次发布于 202 年 12 月 17 日星期三。当天 20:10 EET 进行了编辑,以增加第一段正文的空间。