安德森的角度

迈向 AI 视频生成的全面控制

视频基础模型例如 浑源 和 莞2.1虽然功能强大,但并不能为用户提供电影和电视制作(尤其是视觉特效制作)所要求的那种精细控制。

在专业视觉效果工作室中,像这样的开源模型,以及早期基于图像(而非视频)的模型,例如 稳定扩散, 康定斯基 和 助焊剂,通常与一系列支持工具一起使用,这些支持工具可调整其原始输出以满足特定的创意需求。当导演说, “看起来很棒,但是我们可以让它更 [n] 一点吗?” 你不能回答说模型不够精确,无法处理这样的请求。

相反,AI VFX 团队将使用一系列传统 CGI 和合成技术,结合随着时间的推移而开发的自定义程序和工作流程,以尝试进一步突破视频合成的极限。

因此,打个比方,基础视频模型很像 Chrome 等网络浏览器的默认安装;它可以完成很多开箱即用的功能,但如果您希望它适应您的需求,而不是相反,那么您将需要一些插件。

控制怪胎

在基于扩散的图像合成领域,最重要的第三方系统是 控制网.

ControlNet 是一种向基于扩散的生成模型添加结构化控制的技术,允许用户使用其他输入来指导图像或视频生成,例如 边缘图, 深度图或 姿势信息.

ControlNet 的各种方法允许深度>图像(上行)、语义分割>图像(左下)以及人类和动物的姿势引导图像生成(左下)。

ControlNet 不再仅仅依赖文本提示,而是引入了单独的神经网络分支,或者 适配器,处理这些条件信号,同时保留基础模型的生成能力。

这使得微调输出能够更紧密地遵循用户规范,使其在需要精确组合、结构或运动控制的应用中特别有用:

通过引导姿势,可以通过 ControlNet 获得多种精确的输出类型。 来源:https://arxiv.org/pdf/2302.05543

然而,这种基于适配器的框架在外部对一组非常注重内部的神经过程进行操作。这些方法有几个缺点。

首先,适配器是独立训练的,从而 分支冲突 当多个适配器组合在一起时,可能会导致生成质量下降。

其次,他们引入 参数冗余,每个适配器都需要额外的计算和内存,从而导致扩展效率低下。

第三,尽管适配器具有灵活性,但它通常会产生 次优 结果 与完全 微调 用于多条件生成。这些问题使得基于适配器的方法对于需要无缝集成多个控制信号的任务不太有效。

理想情况下,ControlNet 的能力应该得到训练 本地 以模块化的方式纳入模型,以便适应以后备受期待的明显创新,例如同时生成视频/音频或本机唇形同步功能(用于外部音频)。

就目前情况而言,每个额外的功能都代表着后期制作任务或非本机程序,该程序必须导航其所运行的基础模型的紧密绑定和敏感的权重。

全数字化技术

在这一僵局中,中国提出了一项新举措,即在训练时将 ControlNet 风格的测量直接融入生成视频模型中,而不是事后再考虑。

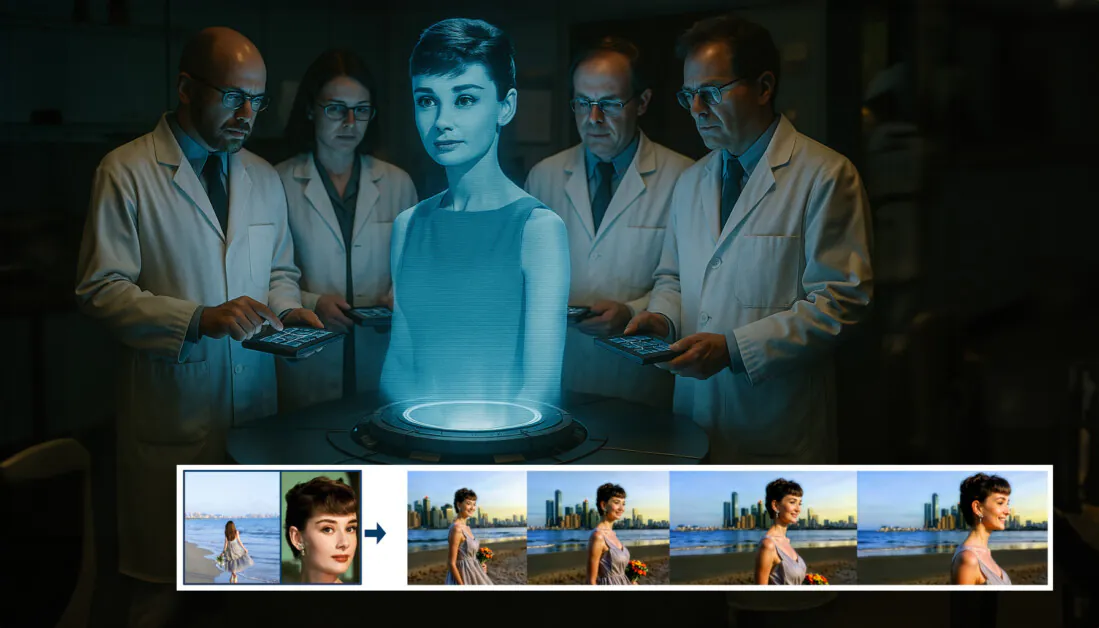

摘自新论文:FullDiT 方法可以将身份强加、深度和相机运动融入原生生成,并且可以同时召唤这些元素的任意组合资料来源:https://arxiv.org/pdf/2503.19907

标题 全数字化技术新方法将身份转移、深度映射和相机移动等多任务条件融合到经过训练的生成视频模型的集成部分中,作者为此制作了一个原型训练模型,并附带了视频剪辑。 项目现场.

在下面的例子中,我们看到了融合了摄像机运动、身份信息和文本信息(即引导用户文本提示)的生成:

点击播放。 仅使用本机训练的基础模型的 ControlNet 风格用户强加的示例。 来源:https://fulldit.github.io/

值得注意的是,作者并没有将他们的实验训练模型作为功能基础模型,而是作为原生文本到视频 (T2V) 和图像到视频 (I2V) 模型的概念验证,这些模型为用户提供不仅仅是图像提示或文本提示的更多控制。

由于目前还没有类似的模型,研究人员创建了一个新的基准,名为 全班,用于评估多任务视频,并声称在他们设计的与先前方法相比的同类测试中具有最先进的性能。然而,由于 FullBench 是由作者自己设计的,因此其客观性尚未经过检验,而且其 1,400 个案例的数据集可能过于有限,无法得出更广泛的结论。

这篇论文提出的架构最有趣的方面或许是它有可能融入新类型的控制。作者指出:

在这项工作中,我们仅探索了相机的控制条件、身份和深度信息。我们没有进一步研究其他条件和模态,例如音频、语音、点云、物体边界框、光流等。尽管 FullDiT 的设计能够以最小的架构修改无缝集成其他模态,但如何快速且经济高效地将现有模型适应新的条件和模态仍然是一个值得进一步探索的重要问题。

尽管研究人员认为 FullDiT 是多任务视频生成的一大进步,但应该认为这项新工作建立在现有架构之上,而不是引入了一个全新的范式。

尽管如此,FullDiT 目前(据我所知)作为具有“硬编码” ControlNet 风格设施的视频基础模型是独一无二的——并且很高兴看到所提出的架构也可以适应以后的创新。

点击播放。 来自项目现场的用户控制摄像机移动的示例。

这个 新文 标题为 FullDiT:具有充分注意力机制的多任务视频生成基础模型,由快手科技和香港中文大学的 9 名研究人员共同完成。项目页面为 点击这里 新的基准数据是 在 Hugging Face.

付款方式

作者认为,FullDiT 的统一注意力机制能够捕捉不同条件下的空间和时间关系,实现更强大的跨模态表征学习:

根据新论文,FullDiT 通过完全自注意力机制整合多种输入条件,将它们转换为统一的序列。相比之下,基于适配器的模型(上图最左边)对每个输入使用单独的模块,导致冗余、冲突和性能较弱。

与基于适配器的设置(单独处理每个输入流)不同,这种共享注意力结构可以避免分支冲突并减少参数开销。他们还声称,该架构可以扩展到新的输入类型,而无需进行重大重新设计 - 并且模型架构显示出推广到训练期间未见过的条件组合的迹象,例如将相机运动与角色身份联系起来。

点击播放。 来自项目现场的身份生成示例.

在 FullDiT 的架构中,所有条件输入(例如文本、相机运动、身份和深度)首先被转换为统一的 token 格式。然后,这些 token 被连接成一个长序列,并通过堆栈进行处理 变压器 层使用完全自注意力机制。这种方法遵循了之前的研究,例如 Open-Sora 计划 和 Movie Gen.

这种设计允许模型在所有条件下共同学习时间和空间关系。每个转换器块都在整个序列上运行,从而实现模态之间的动态交互,而无需为每个输入依赖单独的模块 - 而且,正如我们所指出的,该架构设计为可扩展的,这使得将来更容易合并其他控制信号,而无需进行重大结构更改。

三的力量

FullDiT 将每个控制信号转换为标准化的 token 格式,以便所有条件可以在统一的注意力框架中一起处理。对于相机运动,该模型为每一帧编码一系列外部参数(例如位置和方向)。这些参数带有时间戳,并投射到反映信号时间特性的嵌入向量中。

身份信息的处理方式有所不同,因为它本质上是空间的,而不是时间的。该模型使用身份图来指示每个帧的哪个部分中存在哪些角色。这些图被分为 补丁,每个补丁都投射到一个 嵌入 捕捉空间身份线索,允许模型将框架的特定区域与特定实体相关联。

深度是一种时空信号,该模型通过将深度视频划分为跨越空间和时间的 3D 块来处理它。然后以一种在帧间保留其结构的方式嵌入这些块。

一旦嵌入,所有这些条件标记(相机、身份和深度)将被连接成一个长序列,从而允许 FullDiT 使用完整的 自我注意。这种共享表示使得模型能够学习跨模态和跨时间的交互,而无需依赖于孤立的处理流。

数据与测试

FullDiT 的训练方法依赖于针对每种条件类型定制的选择性注释数据集,而不是要求所有条件同时存在。

对于文本条件,该计划遵循 MiraData 项目。

MiraData 项目的视频收集和注释管道。 来源:https://arxiv.org/pdf/2407.06358

对于相机运动, 房地产10K 数据集是主要数据源,因为它具有高质量的相机参数真实注释。

然而,作者发现,仅使用静态场景摄像机数据集(如 RealEstate10K)进行训练往往会减少生成的视频中的动态物体和人体运动。为了解决这个问题,他们使用包含更多动态摄像机运动的内部数据集进行了额外的微调。

身份注释是使用为 概念大师 项目,它可以有效地过滤和提取细粒度的身份信息。

ConceptMaster 框架旨在解决身份解耦问题,同时保留定制视频中的概念保真度。 来源:https://arxiv.org/pdf/2501.04698

通过数据排序进行优化

作者还实施了渐进式训练计划,引入了更具挑战性的条件 在训练早期 确保模型在添加更简单的任务之前获得稳健的表示。训练顺序从 文本 至 相机 条件,那么 身份,最后 深度其中较简单的任务通常会在稍后介绍,并且示例较少。

作者强调了以这种方式排序工作负载的价值:

“在预训练阶段,我们注意到更具挑战性的任务需要更长的训练时间,应该在学习过程的早期引入。这些具有挑战性的任务涉及与输出视频有很大不同的复杂数据分布,需要模型拥有足够的能力来准确捕捉和表示它们。

“相反,过早引入较简单的任务可能会导致模型优先学习它们,因为它们提供更直接的优化反馈,从而阻碍更具挑战性的任务的收敛。”

研究人员采用的数据训练顺序图,红色表示数据量较大。

在初始预训练之后,最终的微调阶段进一步完善了模型,以提高视觉质量和运动动态。此后,训练遵循标准扩散框架*:将噪声添加到视频潜伏层,模型 学会预测并消除它,使用嵌入的条件标记作为指导。

为了有效评估 FullDiT 并与现有方法进行公平比较,并且在没有其他合适的基准的情况下,作者引入了 全班,一套由 1,400 个不同测试用例组成的精选基准套件。

新 FullBench 基准的数据探索器实例。 来源:https://huggingface.co/datasets/KwaiVGI/FullBench

每个数据点都为各种调节信号提供了真实注释,包括 相机运动, 身分汽车保险理赔及 深度.

指标

作者使用十个指标对 FullDiT 进行了评估,涵盖了性能的五个主要方面:文本对齐、摄像头控制、身份相似性、深度准确性和一般视频质量。

文本对齐的测量方法为 CLIP 相似性,而相机控制则通过 旋转误差 (错误), 翻译错误 (传输错误), 相机运动一致性 (CamMC),遵循 摄像头I2V 在里面 相机控制 项目)。

身份相似度评估使用 恐龙一号 和 夹式并使用深度控制精度进行量化 平均绝对误差 (MAE)。

视频质量通过 MiraData 的三个指标进行评判:帧级 CLIP 相似度(平滑度);基于光流的运动距离(动态度); LAION-美学评分 为了视觉吸引力。

培训实施

作者使用内部(未公开)的文本到视频传播模型训练了 FullDiT,该模型包含大约 10 亿个参数。他们特意选择了适中的参数大小,以保持与先前方法的比较公平性并确保可重复性。

由于训练视频的长度和分辨率不同,作者对每个视频进行了标准化 批量 通过调整视频大小和填充到通用分辨率,每个序列采样 77 帧,并使用应用注意力和 丢失面具 优化培训效果。

这个 Adam 优化器使用于 学习率 的1×10 - 5 在由 64 个 NVIDIA H800 GPU 组成的集群中,总共配备 5,120GB VRAM(考虑到在发烧友综合社区中, 24GB 在 RTX 3090 上仍然被认为是豪华标准)。

该模型训练了大约 32,000 步,每个视频最多包含三个身份,以及 20 帧相机条件和 21 帧深度条件,均从总共 77 帧中均匀采样。

为了进行推理,该模型以 384 个扩散推理步骤和五个无分类器指导尺度生成了分辨率为 672×15 像素的视频(以每秒 50 帧的速度大约五秒)。

先前的方法

对于相机到视频的评估,作者将 FullDiT 与 运动控制、CameraCtrl 和 CamI2V,所有模型均使用 RealEstate10k 数据集进行训练,以确保一致性和公平性。

在身份条件生成中,由于没有可用的可比较的开源多身份模型,因此使用相同的训练数据和架构将该模型与 1B 参数 ConceptMaster 模型进行对比。

单任务视频生成的定量结果。在相机到视频生成方面,FullDiT 与 MotionCtrl、CameraCtrl 和 CamI2V 进行了比较;在身份到视频方面,与 ConceptMaster(1B 参数版本)进行了比较;在深度到视频方面,与 Ctrl-Adapter 和 ControlVideo 进行了比较。所有模型均使用其默认设置进行评估。为了保持一致性,从每种方法中均匀采样 16 帧,与先前模型的输出长度相匹配。

结果表明,尽管 FullDiT 同时处理多个调节信号,它在与文本、相机运动、身份和深度控制相关的指标方面仍然取得了最先进的性能。

在整体质量指标方面,该系统的表现普遍优于其他方法,尽管其流畅度略低于 ConceptMaster。作者对此进行了评论:

“FullDiT 的平滑度略低于 ConceptMaster,因为平滑度的计算基于相邻帧之间的 CLIP 相似性。由于 FullDiT 的动态性明显高于 ConceptMaster,因此平滑度指标受到相邻帧之间较大差异的影响。

“对于美学评分,由于评级模型偏爱绘画风格的图像,而 ControlVideo 通常以这种风格生成视频,因此它在美学方面获得了高分。”

关于定性比较,最好参考 FullDiT 项目网站上的示例视频,因为 PDF 示例不可避免地是静态的(并且太大而无法在此完全重现)。

PDF 中的定性结果的第一部分。请参阅源论文以获取其他示例,这些示例过于繁多,无法在此重现。

作者评论:

“与 [ConceptMaster] 相比,FullDiT 表现出了卓越的身份保存能力,并能生成动态和视觉质量更好的视频。由于 ConceptMaster 和 FullDiT 都是在同一个主干上进行训练的,因此这凸显了全注意力条件注入的有效性。

“……[其他]结果表明,与现有的深度到视频和摄像头到视频方法相比,FullDiT 具有卓越的可控性和生成质量。”

PDF 中 FullDiT 多信号输出示例的一部分。更多示例请参阅原论文和项目网站。

结语

尽管 FullDiT 是向功能更齐全的视频基础模型迈出的一次令人兴奋的尝试,但人们不禁要问,对 ControlNet 风格工具的需求是否能够证明大规模实现此类功能是合理的,至少对于 FOSS 项目而言,因为如果没有商业支持,这些项目将很难获得所需的大量 GPU 处理能力。

主要挑战在于,使用 Depth 和 Pose 等系统通常需要对 ComfyUI 等相对复杂的用户界面非常熟悉。因此,这种功能性 FOSS 模型似乎最有可能由一些规模较小的 VFX 公司开发,这些公司缺乏资金(或者缺乏意愿,因为此类系统很快就会因模型升级而过时)来私下策划和训练此类模型。

另一方面,API 驱动的“租用人工智能”系统可能有很好的动机为辅助控制系统直接训练的模型开发更简单、更用户友好的解释方法。

点击播放。 使用 FullDiT 对视频生成施加深度+文本控制。

* 作者没有指定任何已知的基础模型(即 SDXL 等)

首次发布于 27 年 2025 月 XNUMX 日星期四