人工智能

自注意力引导:提高扩散模型的样本质量

去噪扩散模型是生成式 AI 框架,可通过迭代去噪过程从噪声中合成图像。它们以其卓越的图像生成能力和多样性而闻名,这在很大程度上归功于文本或类条件指导方法,包括分类器指导和无分类器指导。这些模型在创建多样化的高质量图像方面取得了显着的成功。最近的研究表明,类标题和标签等指导技术在提高这些模型生成的图像质量方面发挥着至关重要的作用。

然而,扩散模型和引导方法在某些外部条件下面临局限性。无分类器指导(CFG)方法使用标签丢弃,增加了训练过程的复杂性,而分类器指导(CG)方法需要额外的分类器训练。这两种方法都在某种程度上受到对来之不易的外部条件的依赖,限制了它们的潜力并将其限制在条件设置中。

为了解决这些限制,开发人员制定了一种更通用的扩散指导方法,称为自我注意指导(SAG)。该方法利用扩散模型中间样本的信息来生成图像。我们将在本文中探讨 SAG,讨论其工作原理、方法以及与当前最先进的框架和流程相比的结果。

自注意力引导:提高扩散模型的样本质量

去噪扩散模型 (DDM) 因其能够通过迭代去噪过程从噪声创建图像而广受欢迎。这些模型的图像合成能力很大程度上归功于所采用的扩散引导方法。尽管具有优势,但扩散模型和基于引导的方法面临着复杂性增加和计算成本增加等挑战。

为了克服当前的限制,开发人员引入了自注意力引导方法,这是一种更通用的扩散引导方式,不依赖于扩散引导的外部信息,从而促进了无条件且灵活的引导方法 扩散框架。自注意力引导选择的方法最终有助于增强传统扩散引导方法对有或没有外部要求的情况的适用性。

自注意力指导基于广义公式的简单原理,并且假设中间样本中包含的内部信息也可以作为指导。基于这一原理,SAG方法首先引入了Blur Guidance,这是一种简单直接的提高样本质量的解决方案。模糊引导旨在利用高斯模糊的良性特性,通过使用高斯模糊所消除的信息来引导中间样本,从而自然地消除精细尺度细节。尽管模糊引导方法确实通过适度的引导尺度提高了样本质量,但它无法在大引导尺度上复制结果,因为它经常在整个区域引入结构模糊性。因此,模糊引导方法很难将原始输入与降级输入的预测对齐。为了提高模糊引导方法在更大引导规模上的稳定性和有效性,自注意力引导尝试利用扩散模型的自注意力机制,因为现代扩散模型已经在其架构中包含了自注意力机制。

假设自注意力对于捕获显着信息至关重要,自注意力引导方法使用扩散模型的自注意力图来对抗性地模糊包含显着信息的区域,并在此过程中指导 扩散模型 具有所需的剩余信息。然后,该方法在扩散模型的逆过程中利用注意力图来提高图像质量,并使用自我调节来减少伪影,而无需额外的训练或外部信息。

综上所述,Self-Attention Guidance方法

- 是一种新颖的方法,它使用扩散框架的内部自注意力图来提高生成的样本图像质量,而不需要任何额外的训练或依赖外部条件。

- SAG方法试图将条件引导方法推广为无条件方法,可以与任何扩散模型集成,而不需要额外的资源或外部条件,从而增强基于引导的框架的适用性。

- SAG方法还试图证明其与现有条件方法和框架的正交能力,从而通过促进与其他方法和模型的灵活集成来促进性能的提升。

接下来,自注意力引导方法从相关框架的研究结果中学习,包括去噪扩散模型、采样引导、生成式人工智能自注意力方法和扩散模型的内部表示。然而,自注意力引导方法的核心是从 DDPM 或去噪扩散概率模型、分类器引导、无分类器引导和扩散框架中的自注意力中学习。我们将在接下来的部分中深入讨论它们。

自我注意力指导:预备知识、方法论和架构

去噪扩散概率模型或 DDPM

DDPM 或 去噪扩散概率模型 是一种使用迭代去噪过程从白噪声中恢复图像的模型。传统上,DDPM 模型在某个时间步接收输入图像和方差表,以使用称为马尔可夫过程的前向过程来获取图像。

通过 GAN 实现分类器和无分类器指导

GAN 或生成对抗网络拥有独特的保真度交易多样性,为了将 GAN 框架的这种能力引入扩散模型,自注意力引导框架建议使用一种使用额外分类器的分类器引导方法。相反,无需使用额外的分类器也可以实现无分类器的引导方法以达到相同的结果。尽管该方法提供了期望的结果,但它在计算上仍然不可行,因为它需要额外的标签,并且还将框架限制为条件扩散模型,这些模型需要额外的条件,如文本或类以及额外的训练细节,这增加了复杂性该模型。

推广扩散指导

尽管分类器和无分类器指导方法可以提供所需的结果并有助于扩散模型中的条件生成,但它们依赖于额外的输入。对于任何给定的时间步长,扩散模型的输入包括广义条件和没有广义条件的扰动样本。此外,广义条件涵盖扰动样本内的内部信息或外部条件,或什至两者。由此产生的指导是通过使用假想回归器来制定的,并假设它可以预测广义条件。

使用自注意力图提高图像质量

广义扩散指导意味着通过提取扰动样本中包含的广义条件下的显着信息来为扩散模型的逆过程提供指导是可行的。在此基础上,自注意力引导方法可以有效地捕获逆向过程的显着信息,同时限制预训练扩散模型中由于分布外问题而产生的风险。

模糊指导

自注意力引导中的模糊引导基于高斯模糊,这是一种线性滤波方法,其中输入信号与高斯滤波器进行卷积以生成输出。随着标准偏差的增加,高斯模糊会减少输入信号中的精细细节,并通过将输入信号平滑至常数来导致局部无法区分的输入信号。此外,实验表明输入信号和高斯模糊输出信号之间存在信息不平衡,其中输出信号包含更精细的信息。

在此学习的基础上,自注意力引导框架引入了模糊引导,这是一种在扩散过程中有意排除中间重建信息的技术,而是使用这些信息来指导其预测,以增加图像与目标的相关性。输入信息。模糊指导本质上会导致原始预测与模糊输入预测的偏差更大。此外,高斯模糊的良性特性可以防止输出信号与原始信号发生适度偏差的显着偏差。简而言之,图像中自然会发生模糊,这使得高斯模糊成为更适合应用于预训练扩散模型的方法。

在自注意力引导管道中,首先使用高斯滤波器对输入信号进行模糊处理,然后用额外的噪声进行扩散以产生输出信号。通过这样做,SAG 管道减轻了由此产生的模糊的副作用,从而减少了高斯噪声,并使指导依赖于内容而不是依赖于随机噪声。尽管模糊引导在具有中等引导规模的框架上提供了令人满意的结果,但它无法在具有较大引导规模的现有模型上复制结果,因为它容易产生噪声结果,如下图所示。

这些结果可能是由于全局模糊在框架中引入的结构模糊性导致的,这使得 SAG 管道难以将原始输入的预测与降级输入对齐,从而导致输出噪声。

自注意力机制

如前所述,扩散模型通常具有内置的自注意力组件,它是扩散模型框架中更重要的组件之一。自注意力机制是扩散模型的核心,它允许模型在生成过程中关注输入的显着部分,如下图所示,顶行有高频掩模,和最终生成图像的底行中的自注意力蒙版。

所提出的自注意力引导方法基于相同的原理,并利用扩散模型中自注意力图的功能。总的来说,自注意力引导方法模糊了输入信号中的自注意斑块,或者简单地说,隐藏了扩散模型所关注的斑块信息。此外,自注意力引导中的输出信号包含输入信号的完整区域,这意味着它不会导致输入的结构模糊,并解决了全局模糊的问题。然后,管道通过进行 GAP 或全局平均池化来将自注意力图聚合到维度,并对最近邻进行上采样以匹配输入信号的分辨率,从而获得聚合的自注意力图。

自我注意指导:实验和结果

为了评估其性能,使用 8 个 Nvidia GeForce RTX 3090 GPU 对自注意力引导管道进行采样,并基于预先训练的 IDDPM、ADM 和 稳定的扩散框架.

带自注意力引导的无条件生成

为了衡量 SAG 管道在无条件模型上的有效性,并证明分类器指导和无分类器指导方法不具备的无条件属性,SAG 管道在 50 万个样本的无条件预训练框架上运行。

可以看出,SAG pipeline 的实现提高了无条件输入的 FID、sFID 和 IS 指标,同时降低了召回值。此外,实施 SAG 管道带来的质量改进在下图中很明显,其中顶部的图像是 ADM 和稳定扩散框架的结果,而底部的图像是 ADM 和稳定扩散框架的结果SAG 管道。

使用 SAG 进行条件生成

SAG 管道在现有框架中的集成在无条件生成方面提供了出色的结果,并且 SAG 管道具有条件不可知性,这使得 SAG 管道也可以用于条件生成。

具有自注意力引导的稳定扩散

尽管原始的稳定扩散框架可以生成高质量的图像,但将稳定扩散框架与自注意力引导管道集成可以极大地增强结果。为了评估其效果,开发人员使用空提示进行稳定扩散,并为每个图像对使用随机种子,并对 500 对图像(有或没有自我注意指导)进行人工评估。结果如下图所示。

此外,SAG 的实现可以增强稳定扩散框架的功能,因为将无分类器指导与自注意力指导融合可以将稳定扩散模型的范围扩大到文本到图像的合成。此外,由于 SAG 管道的自调节效果,具有自注意力引导的稳定扩散模型生成的图像质量更高,伪影更少,如下图所示。

目前的限制

尽管自注意力引导管道的实现可以显着提高生成图像的质量,但它确实有一些局限性。

主要限制之一是分类器指导和无分类器指导的正交性。如下图所示,SAG 的实施确实提高了 FID 分数和预测分数,这意味着 SAG 管道包含可以与传统制导方法同时使用的正交组件。

然而,它仍然需要以特定方式训练扩散模型,这增加了复杂性和计算成本。

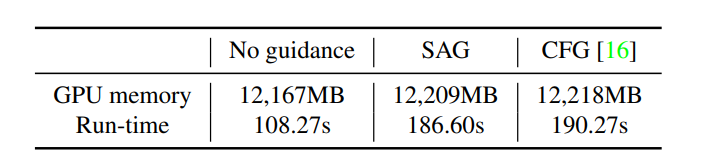

此外,Self-Attention Guidance的实现不会增加内存或时间消耗,这表明SAG中的掩蔽和模糊等操作产生的开销可以忽略不计。然而,它仍然增加了计算成本,因为与无引导方法相比,它包括一个额外的步骤。

总结

在本文中,我们讨论了自注意力引导,这是一种新颖且通用的引导方法,它利用扩散模型中可用的内部信息来生成高质量图像。自注意力指导基于广义公式的简单原理,并且假设中间样本中包含的内部信息也可以作为指导。自注意力引导管道是一种无条件、免训练的方法,可以在各种扩散模型中实现,并使用自调节来减少生成图像中的伪影,并提高整体质量。