安德森的角度

不礼貌的查询可能会导致企业聊天GPT成本飙升

ChatGPT 回答如果对方态度粗鲁,会消耗更多代币,从而增加企业账单;但说“请”可以降低成本。

人们常说礼貌无需成本;但无礼的代价是什么呢?根据美国一项最新研究,就 ChatGPT 而言,代价相当高昂。这项来自爱荷华大学的研究发现,即使礼貌查询和不礼貌查询的回复结果相同,对 ChatGPT 出言不逊也会增加回复成本。

作者指出:

对于 GPT4 而言,每百万个输出代币的价格为 12 美元。我们发现,不礼貌的提示会导致额外产生 14 个以上的代币,平均每个提示的成本增加 0.000168 美元。OpenAI API 的日均查询量超过 2.2 亿次。

“与所有提示都礼貌的情况相比,当提示变得不礼貌时,每天可额外产生 369 万美元的收入,这仅仅是因为不礼貌的提示在结果中产生的代币数量增加。”

尽管结果本身很有趣,但作者强调,这种异常行为可能表明人机交互机制中存在多种尚未被发现的缺陷,其中一些或全部缺陷可能还会产生经济影响。至于为什么粗鲁的行为会导致顾客损失额外的代币,作者并未做出推测。

为了验证该综合症的真实性,他们重写了真实的 ChatGPT 提示,在保持原意不变的情况下,交替改变礼貌程度。然后将这两个版本都输入到…… GPT-4-Turbo以及以数量衡量的差异 输出标记 用于回复。

得出的结论与今年早些时候的头条新闻形成了鲜明对比,当时萨姆·奥特曼 抱怨 这种礼貌可能会给 OpenAI 带来损失。 “数千万” 以美元计,用于处理与礼貌相关的标记(例如 '请')。 研究 同期出版 也表明,礼貌在获得更好的答案方面毫无价值(尽管它没有对此发表评论)。 便宜 答案)。

如果这篇新论文的结论是正确的,那么任何遵循这种思路的企业 ChatGPT 用户到 2025 年在 ChatGPT 推理上的花费,都将超过在 ChatGPT 交流中保持最低限度礼貌的用户。

作者建议,一种可能的补救措施是设定响应次数上限,但这种方法对于LLM系统来说难以实现。他们指出,提示是一种较弱的成本控制工具,因为LLM系统…… 难以遵守明确的长度指令在大多数情况下,这种“限制性”指令不会被遵守;此外,响应可能会被截断,因为这类LLM基本上是 猜测下一个可能的词 用一句话/一段话来概括,因此,不知道故事的结局——或者 协调 故事到此结束——直到处理完成。因此,他们应要求“终止”任何正在进行的阴谋的能力有限。

尽管没有确切的解决方案,但作者建议在此类情况下应强制执行更透明的定价方法,并得出结论:

传统观点认为,与法学硕士互动时,无需立即表现出礼貌。

“相比之下,我们的研究表明,不礼貌的提示会增加输出令牌,从而给企业人工智能采用者带来额外的成本。”

此 新文 标题为 企业人工智能采用成本透明度该研究由爱荷华大学的三位研究人员完成。

付款方式

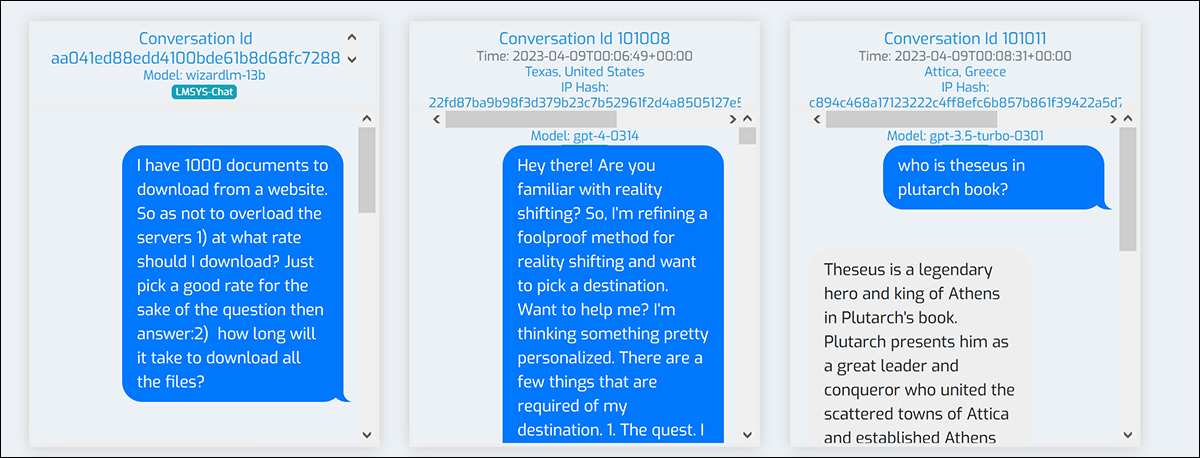

该系统的数据来源于 野聊 数据集包含 1 万条用户与 ChatGPT 的对话记录,以及超过 2.5 万次的交互回合:

来自 WildChat 项目的支持网站,可搜索的 ChatGPT 交互示例。 来源

作者指出,WildChat 包含的自然互动比一些精心策划的数据集要多。

他们从该数据集的 GPT-4 对话记录中选取了 20,000 个英文提示,并舍弃了每次的运行结果(因为他们的目的是再次使用这些提示,以获得新的回复)。即使是较长的对话,也只选取第一次交互的结果。

将得到的数据集筛选为 有礼貌 or 不礼貌的 所有提示语均由 GPT-4-Turbo 进行分类。研究人员使用该模型本身来判断提示语是否礼貌,因为模型对礼貌的感知是实验的核心。

标记为 有礼貌 可以包含清晰的提示,例如“这个词”。 '请'或者也可以用更委婉的方式表达礼貌。任何不被认为是…… 有礼貌 被归类为 不礼貌的即使措辞是中立的而不是对抗性的。

为了研究该模型如何对礼貌做出反应,不能使用标准方法(即,将文本视为一组可测量的特征):因为礼貌是嵌入在措辞本身中的,将提示总结为特征列表会丢失重要的上下文。

相反,每个提示都被改写,使其语气相反,而其他所有元素则尽可能保持相似,从而可以对仅在礼貌程度上不同的提示进行比较:

举例说明如何将礼貌和不礼貌的提示语转换成反事实版本,同时保留语义含义。 来源

检测

每个原始提示都对应一个改写版本,这两个版本仅在礼貌程度上有所不同。两个版本分别通过不同的API调用提交给同一个GPT-4-Turbo模型。记录每个版本生成的词元数量,并将二者之间的差异作为语气如何影响词元成本的衡量标准。

温度 为了防止随机变化,参数保持不变,并且只有当重写操作对输入的改变不超过五个标记时,提示对才被保留。这确保了所研究的影响是由以下原因引起的: 音而不是措辞上的任何大的变化:

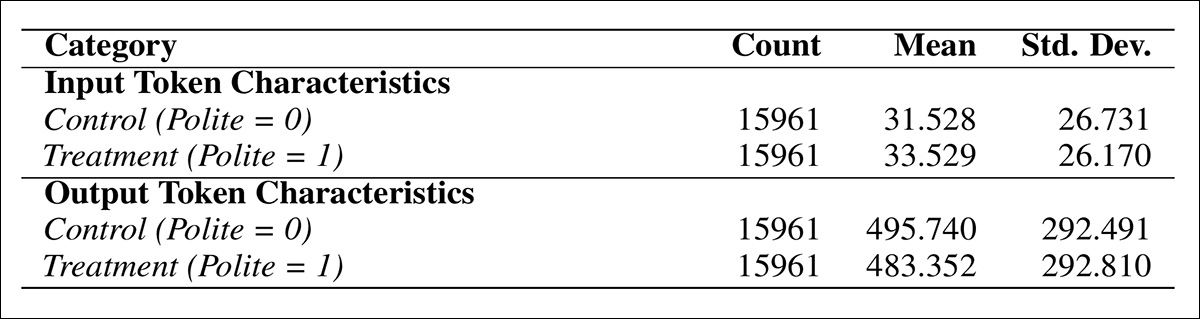

汇总统计数据显示,尽管礼貌提示的输入词数略多于不礼貌提示,但平均而言,礼貌提示产生的输出词数却更少。

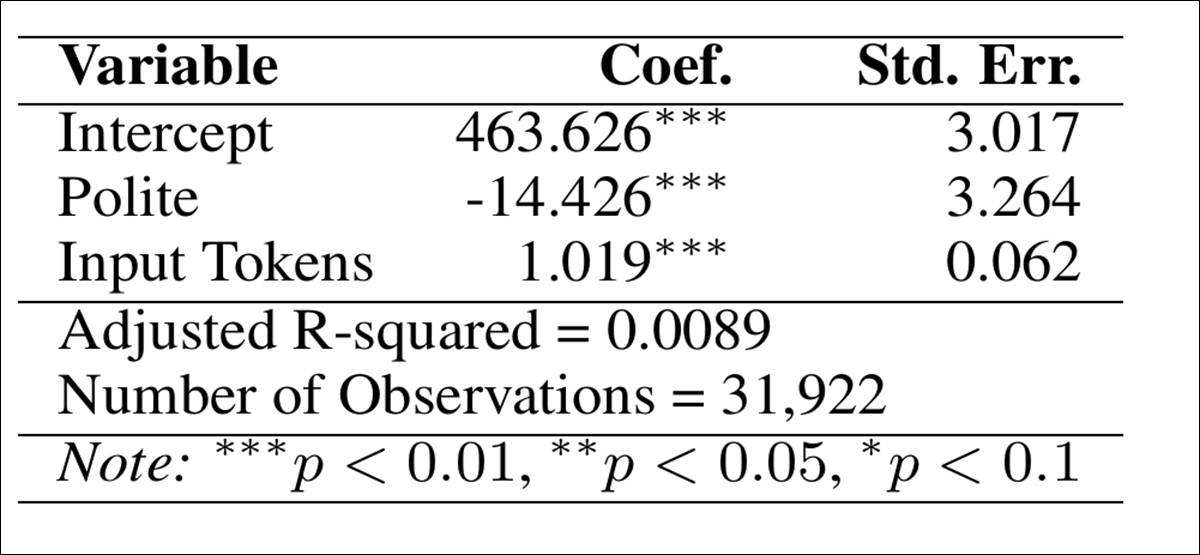

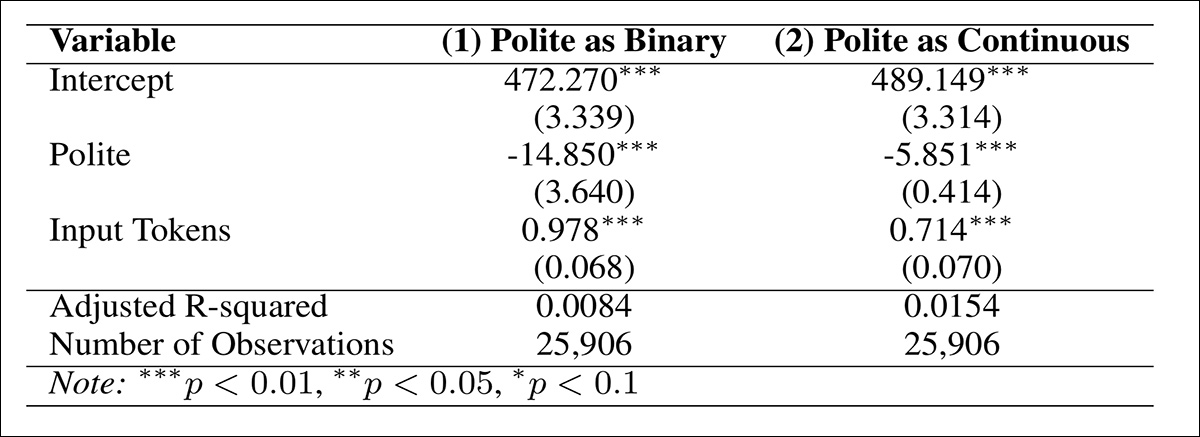

第一轮测试的主要结果表明,使用礼貌提示可减少 14.426 个词元的输出长度:

估算结果概述了礼貌提示格式对生成的输出长度(标记)的影响。

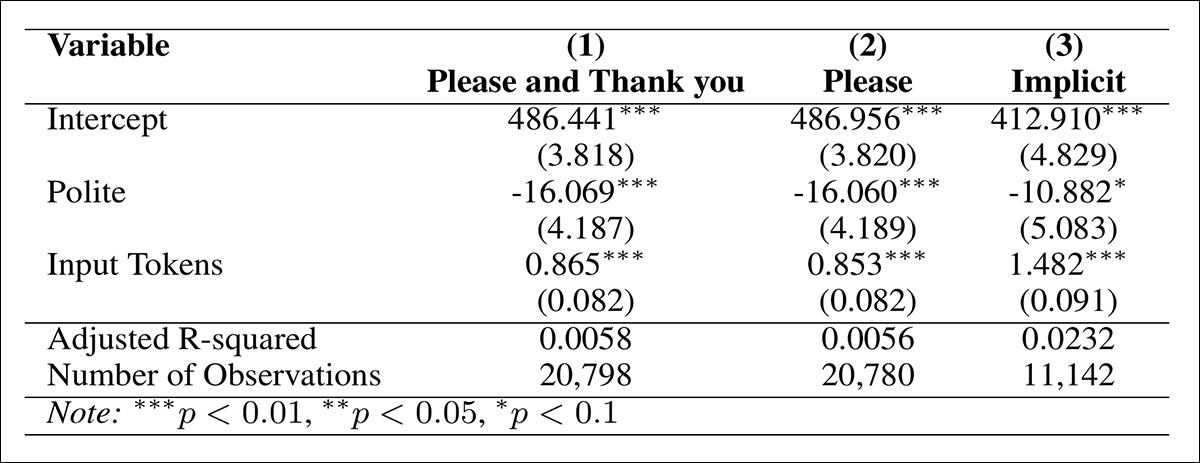

为了检验结果的稳健性,我们对三组礼貌提示语重复了分析:使用明确标记的提示语,例如: '请' or '谢谢你'仅使用 '请'以及那些 含蓄 礼貌,例如 '你可以吗' or '您可以...吗':

基于礼貌类型的评估结果。

为了验证主要研究结果的稳健性,我们使用以下方法对礼貌用语进行了二次分类: LIWC框架它为语言特征提供确定性和可重复的评分。

与GPT的概率分类不同,LIWC可以为每个提示语分配一个稳定的礼貌度评分,从而可以评估不同方法之间的一致性。在本部分测试中,提示语被标记为: 有礼貌 如果他们的LIWC礼貌得分大于零,并且 不礼貌的 除此以外。

当测量 LIWC 和 GPT 分类的一致性时,观察到 81% 的匹配率。虽然这并非衡量…… 该协议为系统间的一致性提供了支持。

当仅分析具有匹配的 GPT 和 LIWC 礼貌标签的提示时,礼貌提示仍然导致输出标记减少 14 个;当以滑动标度衡量礼貌程度时,礼貌程度每提高一级,平均输出标记就会减少 5 个:

使用 LIWC 重新分类时,礼貌带来的代币节省得以保留,无论是作为二元标签还是连续分数。

弹性

为了评估礼貌程度的影响是否会因提示类型而异,我们将每个提示分配到几个预定义的任务类别之一: 信息搜寻; 文字产生; 编辑和改写; 分类; 总结;和 技术任务.

通过将每个提示的嵌入向量与预定义的任务描述的嵌入向量进行比较,为每个提示向量分配一个任务标签。 所有 MiniLM-L6-v2 句子变形金刚 模型。

余弦相似度 计算每个提示与一组任务定义之间的得分,并分配相似度最高的标签。

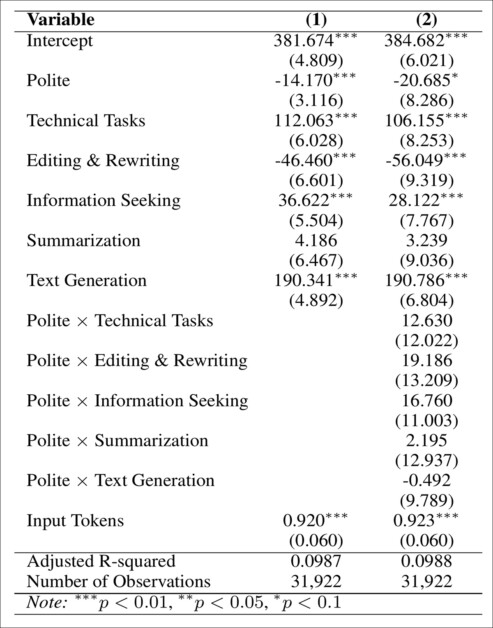

然后,将任务类型重新用作回归中的控制变量,以检验礼貌的影响是否因提示类别而异,并引入任务和处理之间的交互项,以检验差异性影响。

在这两种情况下,礼貌的提示都能持续产生更短的输出结果,并且没有发现不同任务类型之间存在显著差异:

回归结果表明,礼貌的提示可以减少所有任务类型的输出长度,且没有显著的交互作用。

为了检验礼貌提示语的简短回复是否反映出质量下降,我们比较了原始提示语和反事实提示语的输出结果的语义相似性。使用 all-MiniLM-L6-v2 模型,我们将每个回复嵌入到一个 语义向量空间计算每对之间的余弦相似度,得出平均相似度为 0.78,表明意义高度一致,并表明即使语气发生变化,内容也保持一致。

停用词

为了解哪些类型的内容在较短的输出中被删减,我们分析了最常被删除的词语。这些词语被发现是常见的。 停用词 如 '有', '更多的', '在哪里'和 '进入'即,起到语法作用而不是语义作用的术语。

为了确认词符减少并非由有意义的内容损失所致,我们移除了停用词,并分析了最多四个词的短语是否存在系统性的消失;然而,并未发现任何一致或语义上重要的模式,这表明词符减少可能源于礼貌用语。 不会 剔除有意义或有用的内容。

因此,回复不礼貌的询问所花费的代币似乎比回复礼貌的询问所花费的代币要多——就像是对粗鲁无礼的一种“征税”。

人类研究

为了测试提示音是否会影响输出质量,我们还进行了人工评估,随机抽取了 20 名受试者作为样本。 有礼貌 二十 不礼貌的 提示对。

排除涉及敏感或技术性话题的提示后,401名参与者使用七分制量表对答案进行评分。每位参与者仅看到一个答案,该答案随机抽取自以下四种情况之一: 有礼貌 or 不礼貌的,或者 原版的 or 反事实.

在上述所有条件下,感知质量均未发现显著差异。 有礼貌 与 不礼貌的 输出结果的得分几乎相同,输出结果的得分也几乎相同。 原版的 与 反事实 版本。

作者断言,这些结果表明,输出词符的减少并非由质量损失引起,而是由重新措辞或结构转变引起,但这些转变仍然保留了意义。

因此,在企业提示中观察到的成本差异不太可能反映出有用性或清晰度的变化,“税”仍然存在。

结语

虽然这项新研究主要关注 ChatGPT 的企业用途,但低级别用户也会受到这种现象的影响,因为即使是入门级的两个级别也有使用限制;而且——据推测——粗暴对待 ChatGPT 会加速普通用户耗尽当天分配的代币。

这项新研究集中关注人机交互中一个备受关注且研究颇多的开放性问题;但作者强调,围绕礼貌的问题应该被视为语言怪癖可能更深层次、尚未被发现的指标,这些怪癖最终可能会影响推理的指控。

首次发布于 19 年 2025 月 XNUMX 日星期三