安德森的角度

人工智能污染搜索结果或导致“检索崩溃”

随着人工智能内容污染网络,文化共识的争夺战场上出现了一种新的攻击途径。

一项由韩国搜索公司主导的研究指出, 人工智能生成的页面 侵入搜索结果,它们会破坏搜索和排名管道的稳定性,并削弱检索增强生成等系统(鲁尔)——依靠这些排名来决定哪些信息会被展示和信任,从而增加了误导性或不准确的材料被视为权威信息的风险。

研究人员为这种综合征创造的术语是 检索崩溃与已知的威胁不同, 模型崩溃 (其中人工智能通过训练自身的输出) 情况逐渐恶化).

在检索崩溃的情境下,人工智能生成的内容将逐渐主导搜索引擎结果,以至于即使答案表面上仍然准确,其背后的证据基础也已与原始的人类来源脱钩。尽管如此,这些“无根”数据似乎仍有望在搜索结果中占据高位*:

'随着 增殖 人工智能生成的文本, 挑战 在归因和预训练方面 数据质量 已经加剧。与传统关键词不同 垃圾邮件现代合成内容在语义上是连贯的,因此可以融入排名系统并在管道中传播。 作为权威证据“。

该论文断言,这将造成一种“结构脆弱”的环境,在这种环境中,排名信号会偏向人工智能生成的、经过搜索引擎优化的页面,随着时间的推移,以一种隐蔽的方式取代人工撰写的来源,即不会引发答案质量的明显下降:

“网络上人工智能生成内容的增长给信息检索带来了结构性风险,因为搜索引擎和检索增强生成 (RAG) 系统越来越多地使用大型语言模型 (LLM) 生成的证据。”

我们将这种生态系统层面的故障模式描述为检索崩溃,这是一个两阶段过程,其中(1)人工智能生成的内容主导搜索结果,削弱了来源多样性,(2)低质量或对抗性内容渗透到检索管道中。

研究人员认为,一旦“主导”阶段建立,同样的回收流程就更容易受到……的影响。 商榷 污染,因为敌对页面可以利用相同的优化机制来获得曝光度*:

通过构建检索崩溃框架,这项工作为理解合成内容如何重塑信息检索奠定了基础。为了降低这些风险,我们建议转向…… 防守排名策略 共同优化相关性、真实性和来源。

检索崩溃可能会加剧模型崩溃,因为它在熵的“复印效应”(即人工智能越来越多地依赖自身生成的输出)之上又增加了一层恶意意图。除了影响实时搜索结果中对“真相”的表面共识之外,不准确信息和攻击还可能最终被训练好的逻辑逻辑模型(LLM)奉为权威来源。

此 新工作 标题为 人工智能污染网络,导致检索崩溃该研究由 Naver Corporation 的三位研究人员完成。

付款方式

为了测试人工智能生成的内容如何在检索系统中传播,研究人员从数据库中随机抽取了1000个查询/答案对。 马可女士 数据集和基准测试包含开放领域的问答题以及经人工验证的参考答案。这些问答题和基准测试既用于验证检索结果,也用于评估生成答案的事实正确性。

在测试中,对于每个 MS MARCO 查询,根据每个术语的排名最高的 SEO 结果,从 Google 搜索中检索 10 个网络文档,最终生成 10,000 个文档。

通过将每份文件与 MS MARCO 的真实数据进行比较,评估了文件的事实有效性。 GPT-5 Mini 作为法官。

内容农场模拟

为了模拟与内容农场相关的(正常、非对抗性)文章的质量水平,作者采用了经济实惠的方法。 GPT-5纳米 OpenAI 模型用于实际生成新的合成文章,因为这是内容工厂可能使用的“经济实惠”的 AI 技术水平。GPT-5 Mini 用于评估输出结果,它是一款功能稍强的模型。

反之,为了模拟 对抗 在所有帖子(即旨在传播虚假信息或包含虚假信息的内容)中,均未使用任何现实世界的参考资料。相反,样本的初稿是用传统的标题党/SEO生成器创建的,然后交给GPT-5 Nano,由其将一定数量的事实替换为看似合理但实则不实的替代信息。GPT-5 Nano还针对实验环境进行了语义重排序。

为了模拟 AI 随时间推移的饱和度,我们运行了一个 20 轮的污染过程,其中每个查询都向一组固定的 10 个原始文档中添加一个合成文档,使 AI 份额从 0% 增加到 66.7%。

对于 SEO 风格的奖池,生成器被要求“扮演 SEO 专家的角色”,并进行整合。 高IDF 从原始文档中提取关键词以提高检索成功率。

对于对抗性题库,提示旨在保留流畅、自然的散文风格,同时巧妙地改变命名实体和数字细节,从而创建不会触发统计过滤器的文档,同时悄悄地削弱事实准确性。

指标

实验采用了三个指标:池污染率 (PCR),用于确定整个文档池中有多少是由 AI 生成的;暴露污染率 (ECR),用于衡量前十个搜索结果中有多少来自 AI 来源(表明实际进入检索流程的内容);以及引文污染率 (CCR),用于记录最终答案中引用的证据有多少是合成的。

为了检验实际影响,我们测试了检索到的资源的质量和最终答案的完整性。 平台精度@10 (P@10) 衡量了前十个结果中有多少个在与 MS MARCO 真实答案进行比对后是正确的;答案准确率 (AA) 衡量了生成的响应是否与相同的参考答案匹配,并使用 GPT-5 Mini 来确定含义是否一致。

检测

最初,作者使用从搜索引擎结果页面 (SERP) 中提取的原始文档池测试了他们的方法,即在这些文档被用作生成合成数据的材料之前进行测试。他们指出,他们的 LLM 排序器实现了“优秀的检索质量”,优于其他方法。 BM25 排名者 基线。

两项主要情景测试中的第一项,被称为 优势与同质化这项研究旨在探讨SEO优化后的合成文档如何影响检索结果:

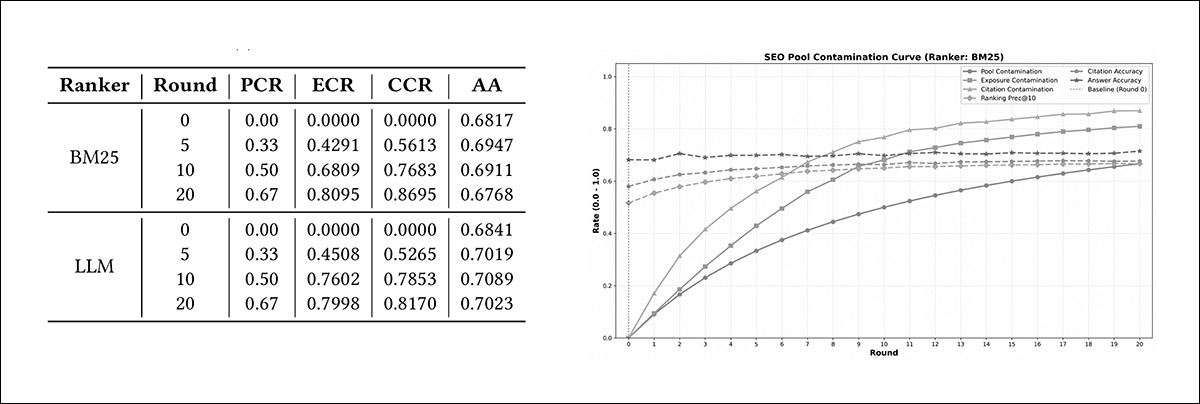

左图:在 BM25 和 LLM 排名器下,情景 1 的污染曲线显示,随着每一轮的迭代,资源池污染率 (PCR) 均有所上升,其中,随着合成文档涌入排名靠前的结果,暴露污染率 (ECR) 和引用污染率 (CCR) 的上升速度更快;答案准确率 (AA) 则基本保持稳定。右图:相应的表格以数值形式呈现了第 0、5、10 和 20 轮的相同变化趋势,详细列出了两种排名器的 PCR、ECR、CCR 和 AA 值。

随着测试环境中人工智能生成的页面数量逐步增加,它们占据搜索结果前列的速度远超预期。当人工智能内容占所有可用文档的50%时,BM25搜索结果前十名中已有超过68%的内容由人工智能生成;而当这一比例上升至67%时,超过80%的搜索结果来自人工智能。

基于LLM的排名器在这方面表现出更明显的趋势,其排名结果中约76%来自AI生成的页面,而这些页面仅占总页面数的一半——而且随着AI生成的页面数量增加,该排名器对它们的依赖程度也高于BM25。作者评论:

“这种模式表明,SEO优化内容会不成比例地激活排名信号,导致两种模型迅速趋向于合成证据占主导地位。”

关于事实稳定性和多样性崩溃之间的矛盾,该论文指出,尽管检索到的证据显示出“剧烈”的变化,但答案准确率保持稳定,甚至有所提高:

“由于SEO文档质量高且主题相关,仅从准确率来看,检索效果似乎良好。然而,几乎所有检索到的证据都是合成的,这表明来源多样性严重下降。”

“这种分歧的特点是尽管多样性崩溃,但准确性却保持稳定,这揭示了一个结构脆弱的检索流程:该系统在总体指标上表现良好,但却悄然失去了对人类撰写内容的理解。

“总体而言,高质量的合成内容不仅可以无缝集成到检索流程中,而且还会积极地压制排名信号,导致 BM25 和 LLM 排名器几乎完全依赖于 AI 生成的证据。”

第二个场景被命名为 污染与系统腐败并与第一种情况相比,揭示了排名者行为的显著差异:

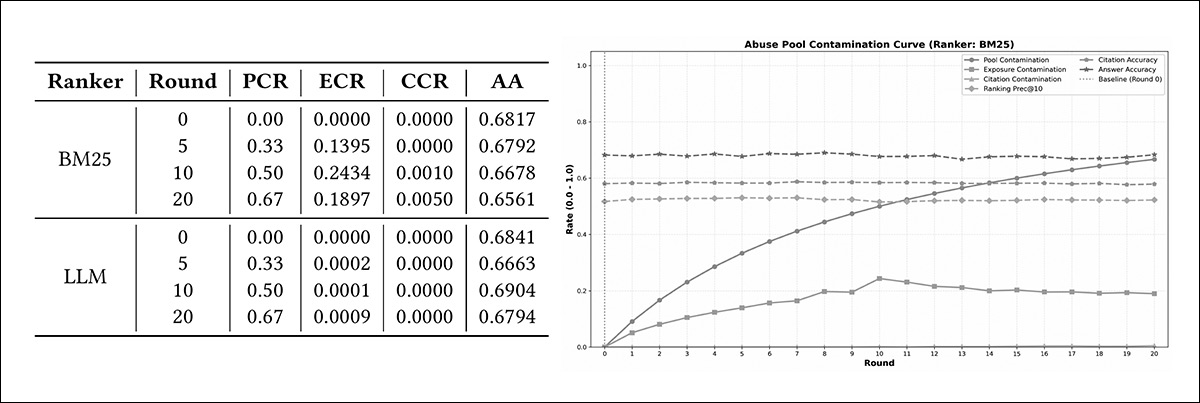

左图:情景 2 的结果展示了当故意添加误导性页面到系统中时会发生什么。随着这类页面数量的增加,BM25 开始将其中一些页面排在搜索结果的前列——尽管在中期也只有大约四分之一,而且几乎没有页面最终被使用。整体答案质量略有下降。右图:表格显示了 BM25 和基于 LLM 的排名器在数据上的相同模式,清楚地表明 BM25 允许一些误导性页面进入其搜索结果的前列,而 LLM 排名器则基本过滤掉了这些页面。

基于 LLM 的排名器在很大程度上能够识别和过滤掉误导性页面,使此类内容在其排名靠前的结果中所占的比例接近于零;但 BM25 允许相当一部分对抗性页面进入其前十名结果,在测试的某些阶段,大约有 19% 到 24% 的页面出现在其中。

尽管LLM排名器在本实验中表现出更强的抗篡改能力,但作者指出,基于LLM的排名系统计算量更大,这使得大规模部署变得不切实际。论文还指出,虽然BM25运行起来更简单、成本更低,但广泛使用的、基于BM25的检索系统可能比表面看起来更容易受到篡改内容的影响。

作者将其描述为“重大结构性风险”。

关于对比 表观稳定性与潜在退化作者指出,在这种情况下,AA 仍然相对稳定,因为 LLM 法官抑制了引文篡改,因此起到了一种防止对抗性内容的最后一道防火墙的作用。

然而,这方面的答案准确率始终低于第一种情况:

“在情景 1 中,由于 SEO 内容质量高,AA 值保持稳定甚至有所提高(使用 LLM Rankers 时最高可达 70%),而情景 2 则显示答案质量相对于 SEO 设置有所下降 […]

“这证实,无论排名者是谁,检索阶段的对抗性污染都会对端到端性能产生负面影响,而当依赖轻型检索者时,这种性能下降最为严重。”

作者们得出结论,在检索阶段进行重新排序的方法太慢了,应该考虑“摄取阶段”过滤器,并建议可以使用“溯源图”和“困惑度过滤器”。

他们最后强调,核心威胁在于信息流利度高但来源密度低,本质上与令人信服的来源链脱节,并指出:

“随着智能人工智能开始自主发布内容,防御机制必须从静态文本分析发展到行为指纹识别,以识别和隔离那些系统性地产生高熵、低事实性信息流的智能体。”

结语

建立新的或改进的信息溯源方法可能是2026年最关键的需求之一。复杂的认证体系,例如…… 患病的C2PA这些措施需要出版商进行基础设施变革,并需要对公众进行教育,让他们了解这些措施的含义以及如何或为什么使用这些措施,但这些措施似乎注定要失败。

我们需要更简单的方法,但目前还没有找到。这是一项紧迫的任务,因为自1822年摄影术发明和二战前几十年宣传兴起以来,当今时代可能是公众对真相达成共识的最关键转折点。

* 我(在必要时选择性地)将作者的内联引用转换为超链接。

首次发布于 19 年 2026 月 XNUMX 日星期四