Trí tuệ nhân tạo

StyleTTS 2: Chuyển văn bản thành giọng nói ở cấp độ con người với các mô hình ngôn ngữ lời nói lớn

Nhờ sự gia tăng các phương pháp tổng hợp giọng nói tự nhiên và tổng hợp, một trong những thành tựu lớn mà ngành AI đã đạt được trong vài năm qua là tổng hợp hiệu quả các khung chuyển văn bản thành giọng nói với các ứng dụng tiềm năng trong các ngành khác nhau bao gồm sách nói, trợ lý ảo, giọng nói. -qua tường thuật và hơn thế nữa, với một số chế độ hiện đại mang lại hiệu suất và hiệu quả ở cấp độ con người trong một loạt các tác vụ liên quan đến giọng nói. Tuy nhiên, bất chấp hiệu suất mạnh mẽ của chúng, vẫn còn chỗ để cải thiện các nhiệm vụ nhờ lời nói biểu cảm và đa dạng, yêu cầu một lượng lớn dữ liệu đào tạo để tối ưu hóa văn bản không có khung thành khung giọng nói và tính mạnh mẽ cho văn bản OOD hoặc Out of Distribution dẫn đầu các nhà phát triển làm việc trên một khung chuyển văn bản thành giọng nói mạnh mẽ hơn và dễ tiếp cận hơn.

Trong bài viết này, chúng ta sẽ nói về StyleTTS-2, một khung chuyển văn bản sang giọng nói mạnh mẽ và sáng tạo được xây dựng trên nền tảng của khung StyleTTS và nhằm mục đích trình bày bước tiếp theo hướng tới hệ thống chuyển văn bản sang giọng nói hiện đại. Khung StyleTTS2 mô hình hóa các kiểu giọng nói dưới dạng các biến ngẫu nhiên tiềm ẩn và sử dụng mô hình khuếch tán xác suất để lấy mẫu các kiểu giọng nói hoặc biến ngẫu nhiên này, do đó cho phép khung StyleTTS2 tổng hợp giọng nói thực tế một cách hiệu quả mà không cần sử dụng đầu vào âm thanh tham chiếu. Nhờ cách tiếp cận này, khung StyleTTS2 có thể mang lại kết quả tốt hơn và cho thấy hiệu quả cao khi so sánh với các khung văn bản và giọng nói hiện đại, nhưng cũng có thể tận dụng khả năng tổng hợp giọng nói đa dạng được cung cấp bởi các khung mô hình khuếch tán. Chúng ta sẽ thảo luận chi tiết hơn về khung StyleTTS2, đồng thời nói về kiến trúc và phương pháp của nó đồng thời xem xét các kết quả mà khung này đạt được. Vậy hãy bắt đầu.

StyleTTS2 để tổng hợp văn bản thành giọng nói: Giới thiệu

StyleTTS2 là mô hình tổng hợp Văn bản thành giọng nói cải tiến, thực hiện bước tiếp theo hướng tới xây dựng khung TTS ở cấp độ con người và được xây dựng dựa trên StyleTTS, một văn bản dựa trên kiểu để mô hình tạo lời nói. Khung StyleTTS2 mô hình hóa các kiểu giọng nói dưới dạng các biến ngẫu nhiên tiềm ẩn và sử dụng mô hình khuếch tán xác suất để lấy mẫu các kiểu giọng nói hoặc biến ngẫu nhiên này, do đó cho phép khung StyleTTS2 tổng hợp giọng nói thực tế một cách hiệu quả mà không cần sử dụng đầu vào âm thanh tham chiếu. Việc lập mô hình các kiểu dưới dạng các biến ngẫu nhiên tiềm ẩn là điểm khác biệt giữa khung StyleTTS2 với khung StyleTTS tiền nhiệm của nó và nhằm mục đích tạo ra kiểu giọng nói phù hợp nhất cho văn bản đầu vào mà không cần đầu vào âm thanh tham chiếu và có thể đạt được sự khuếch tán tiềm ẩn hiệu quả trong khi lấy lợi thế của khả năng tổng hợp giọng nói đa dạng được cung cấp bởi mô hình khuếch tán. Ngoài ra, khung StyleTTS2 cũng sử dụng Mô hình ngôn ngữ lời nói hoặc SLM lớn được đào tạo trước làm các bộ phân biệt như khung WavLM và kết hợp nó với phương pháp mô hình hóa khoảng thời gian khác biệt mới của riêng nó để đào tạo khung từ đầu đến cuối và cuối cùng tạo ra giọng nói với độ tự nhiên được nâng cao. Nhờ vào cách tiếp cận mà nó tuân theo, khung StyleTTS2 vượt trội hơn các khung hiện đại hiện nay cho các nhiệm vụ tạo giọng nói và là một trong những khung hiệu quả nhất để đào tạo trước các mô hình giọng nói quy mô lớn trong cài đặt zero-shot cho các nhiệm vụ thích ứng với người nói.

Tiếp tục, để chuyển văn bản ở cấp độ con người sang tổng hợp giọng nói, khung StyleTTs2 kết hợp các bài học từ các công trình hiện có, bao gồm các mô hình khuếch tán để tổng hợp giọng nói và các mô hình ngôn ngữ lời nói lớn. Các mô hình khuếch tán thường được sử dụng cho các nhiệm vụ tổng hợp giọng nói nhờ khả năng kiểm soát giọng nói chi tiết và khả năng lấy mẫu giọng nói đa dạng. Tuy nhiên, các mô hình khuếch tán không hiệu quả bằng các khung không lặp lại dựa trên GAN và lý do chính cho điều này là yêu cầu lấy mẫu các biểu diễn, dạng sóng và biểu đồ phổ tiềm ẩn lặp đi lặp lại theo thời lượng mục tiêu của lời nói.

Mặt khác, các công trình gần đây về Mô hình ngôn ngữ lời nói lớn đã chỉ ra khả năng nâng cao chất lượng văn bản cho các tác vụ tạo giọng nói và thích ứng tốt với người nói. Mô hình ngôn ngữ lời nói lớn thường chuyển đổi văn bản đầu vào thành các biểu diễn lượng tử hóa hoặc liên tục bắt nguồn từ các khung ngôn ngữ lời nói được đào tạo trước cho các tác vụ tái tạo giọng nói. Tuy nhiên, các tính năng của các Mô hình ngôn ngữ lời nói này không được tối ưu hóa để tổng hợp giọng nói một cách trực tiếp. Ngược lại, khung StyleTTS2 tận dụng kiến thức thu được từ các khung SLM lớn bằng cách sử dụng đào tạo đối nghịch để tổng hợp các tính năng của mô hình ngôn ngữ giọng nói mà không cần sử dụng bản đồ không gian tiềm ẩn và do đó, học trực tiếp không gian tiềm ẩn được tối ưu hóa tổng hợp giọng nói.

StyleTTS2: Kiến trúc và Phương pháp luận

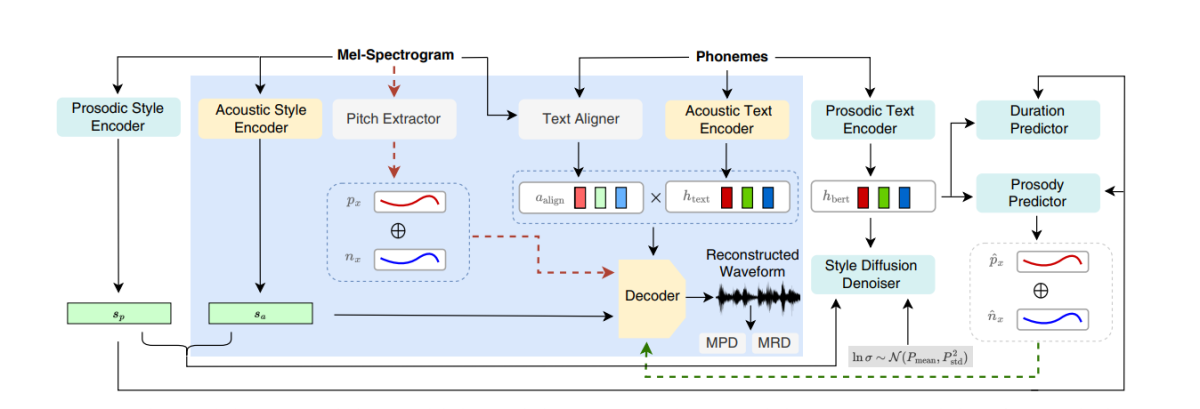

Về cốt lõi, StyleTTS2 được xây dựng trên nền tảng tiền thân của nó, khung StyleTTS, một khung chuyển văn bản thành giọng nói không tự động sử dụng bộ mã hóa kiểu để lấy vectơ kiểu từ âm thanh tham chiếu, do đó cho phép tạo ra giọng nói tự nhiên và biểu cảm. Vectơ kiểu được sử dụng trong khung StyleTTS được tích hợp trực tiếp vào bộ mã hóa, thời lượng và bộ dự đoán bằng cách sử dụng AdaIN hoặc Chuẩn hóa phiên bản thích ứng, do đó cho phép mô hình StyleTTS tạo ra đầu ra giọng nói với nhiều giai điệu, thời lượng và thậm chí cả cảm xúc khác nhau. Khung StyleTTS bao gồm tổng cộng 8 mô hình được chia thành ba loại

- Mô hình âm thanh hoặc Hệ thống tạo giọng nói với bộ mã hóa kiểu, bộ mã hóa văn bản và bộ giải mã giọng nói.

- Hệ thống dự đoán văn bản thành giọng nói sử dụng các công cụ dự đoán nhịp điệu và thời lượng.

- Hệ thống tiện ích bao gồm bộ căn chỉnh văn bản, bộ trích cao độ và bộ phân biệt cho mục đích đào tạo.

Nhờ cách tiếp cận của nó, khung StyleTTS mang lại hiệu suất hiện đại liên quan đến việc tổng hợp giọng nói đa dạng và có thể kiểm soát được. Tuy nhiên, hiệu suất này có những nhược điểm như suy giảm chất lượng mẫu, hạn chế về khả năng diễn đạt và phụ thuộc vào các ứng dụng cản trở lời nói trong thời gian thực.

Cải thiện dựa trên khung StyleTTS, mô hình StyleTTS2 mang lại khả năng biểu cảm nâng cao văn bản để nói các nhiệm vụ có hiệu suất phân phối được cải thiện và chất lượng con người cao. Khung StyleTTS2 sử dụng quy trình đào tạo từ đầu đến cuối để tối ưu hóa các thành phần khác nhau bằng đào tạo đối nghịch và tổng hợp dạng sóng trực tiếp. Không giống như khung StyleTTS, khung StyleTTS2 mô hình hóa kiểu giọng nói như một biến tiềm ẩn và lấy mẫu thông qua các mô hình khuếch tán, từ đó tạo ra các mẫu giọng nói đa dạng mà không cần sử dụng âm thanh tham chiếu. Chúng ta hãy có một cái nhìn chi tiết về các thành phần này.

Đào tạo từ đầu đến cuối về can thiệp

Trong khung StyleTTS2, phương pháp đào tạo từ đầu đến cuối được sử dụng để tối ưu hóa các thành phần chuyển văn bản thành giọng nói khác nhau để tránh nhiễu mà không cần phải dựa vào các thành phần cố định. Khung StyleTTS2 đạt được điều này bằng cách sửa đổi bộ giải mã để tạo ra dạng sóng trực tiếp từ vectơ kiểu, đường cong cao độ & năng lượng cũng như các biểu diễn căn chỉnh. Sau đó, khung sẽ loại bỏ lớp chiếu cuối cùng của bộ giải mã và thay thế nó bằng bộ giải mã dạng sóng. Khung StyleTTS2 sử dụng hai bộ mã hóa: bộ giải mã dựa trên HifiGAN để tạo trực tiếp dạng sóng và bộ giải mã dựa trên iSTFT để tạo ra pha và cường độ được chuyển đổi thành dạng sóng để can thiệp và huấn luyện nhanh hơn.

Hình trên thể hiện các mẫu âm thanh được sử dụng để luyện tập trước và luyện tập chung. Để giảm thời gian đào tạo, trước tiên, các mô-đun được tối ưu hóa trong giai đoạn tiền đào tạo, sau đó là tối ưu hóa tất cả các thành phần trừ đi bộ trích xuất cao độ trong quá trình đào tạo chung. Lý do tại sao quá trình luyện tập chung không tối ưu hóa công cụ trích xuất cao độ là vì nó được sử dụng để cung cấp mặt bằng thực tế cho các đường cong cao độ.

Hình trên biểu thị quá trình đào tạo đối nghịch và sự can thiệp của Mô hình Ngôn ngữ Lời nói với khung WavLM được đào tạo trước nhưng không được điều chỉnh trước. Quá trình này khác với quy trình được đề cập ở trên vì nó có thể lấy các văn bản đầu vào khác nhau nhưng tích lũy độ dốc để cập nhật các tham số trong mỗi lô.

Khuếch tán phong cách

Khung StyleTTS2 nhằm mục đích mô hình hóa lời nói dưới dạng phân phối có điều kiện thông qua một biến tiềm ẩn tuân theo phân phối có điều kiện và biến này được gọi là kiểu giọng nói tổng quát và thể hiện bất kỳ đặc điểm nào trong mẫu giọng nói ngoài phạm vi của bất kỳ nội dung ngữ âm nào bao gồm trọng âm từ vựng, ngữ điệu, tốc độ nói và thậm chí cả những chuyển đổi hình thức.

Bộ phân biệt mẫu ngôn ngữ lời nói

Mô hình ngôn ngữ lời nói nổi tiếng với khả năng chung là mã hóa thông tin có giá trị trên nhiều khía cạnh ngữ nghĩa và âm thanh, đồng thời các biểu diễn SLM theo truyền thống có thể bắt chước nhận thức của con người để đánh giá chất lượng của giọng nói tổng hợp được tạo ra. Khung StyleTTS2 sử dụng phương pháp đào tạo đối nghịch để tận dụng khả năng của bộ mã hóa SLM để thực hiện các tác vụ tổng hợp và sử dụng khung WavLM 12 lớp làm công cụ phân biệt đối xử. Cách tiếp cận này cho phép khuôn khổ cho phép đào tạo về các văn bản OOD hoặc Không phân phối có thể giúp cải thiện hiệu suất. Hơn nữa, để ngăn chặn các vấn đề về trang bị quá mức, khung lấy mẫu văn bản OOD và phân phối trong với xác suất bằng nhau.

Mô hình hóa thời lượng khác biệt

Theo truyền thống, một công cụ dự đoán thời lượng được sử dụng trong các khung văn bản thành giọng nói tạo ra thời lượng âm vị, nhưng các phương pháp lấy mẫu nâng cao mà những công cụ dự đoán thời lượng này sử dụng thường chặn luồng chuyển màu trong quá trình đào tạo E2E và khung NaturalSpeech sử dụng bộ lấy mẫu tăng cường dựa trên sự chú ý cho cấp độ con người chuyển đổi văn bản thành giọng nói. Tuy nhiên, khung StyleTTS2 nhận thấy cách tiếp cận này không ổn định trong quá trình đào tạo đối nghịch vì StyleTTS2 huấn luyện sử dụng phương pháp lấy mẫu tăng cường khác biệt với các quá trình đào tạo đối nghịch khác nhau mà không bị mất các điều khoản bổ sung do độ dài không khớp do sai lệch. Mặc dù việc sử dụng phương pháp uốn cong thời gian động mềm có thể giúp giảm thiểu sự không phù hợp này, nhưng việc sử dụng nó không chỉ tốn kém về mặt tính toán mà độ ổn định của nó cũng là mối lo ngại khi làm việc với các mục tiêu đối nghịch hoặc các nhiệm vụ tái thiết mel. Do đó, để đạt được hiệu suất ở cấp độ con người khi đào tạo đối nghịch và ổn định quá trình đào tạo, khung StyleTTC2 sử dụng phương pháp lấy mẫu nâng cao phi tham số. Lấy mẫu Gaussian là một phương pháp lấy mẫu không tham số phổ biến để chuyển đổi thời lượng dự đoán mặc dù nó có những hạn chế do độ dài cố định của hạt nhân Gaussian được xác định trước. Hạn chế này đối với việc lấy mẫu Gaussian hạn chế khả năng mô hình sắp xếp chính xác của nó với các độ dài khác nhau.

Để khắc phục hạn chế này, khung StyleTTC2 đề xuất sử dụng phương pháp lấy mẫu không tham số mới mà không cần đào tạo bổ sung và có khả năng tính toán các độ dài khác nhau của việc sắp xếp. Đối với mỗi âm vị, khung StyleTTC2 mô hình căn chỉnh dưới dạng một biến ngẫu nhiên và cho biết chỉ mục của khung giọng nói mà âm vị căn chỉnh.

Đào tạo và Đánh giá Mô hình

Khung StyleTTC2 được đào tạo và thử nghiệm trên ba bộ dữ liệu: VCTK, LibriTTS và LJSpeech. Thành phần loa đơn của khung StyleTTS2 được đào tạo bằng bộ dữ liệu LJSpeech chứa hơn 13,000 mẫu âm thanh được chia thành 12,500 mẫu đào tạo, 100 mẫu xác thực và gần 500 mẫu thử nghiệm, với tổng thời gian chạy tổng cộng là gần 24 giờ. Thành phần đa người nói của khung được đào tạo trên tập dữ liệu VCTK bao gồm hơn 44,000 clip âm thanh với hơn 100 người bản ngữ riêng lẻ với các giọng khác nhau và được chia thành 43,500 mẫu đào tạo, 100 mẫu xác thực và gần 500 mẫu thử nghiệm. Cuối cùng, để trang bị cho khung khả năng thích ứng không cần quay, khung này được đào tạo trên bộ dữ liệu LibriTTS kết hợp bao gồm các clip âm thanh có tổng thời lượng khoảng 250 giờ âm thanh với hơn 1,150 loa riêng lẻ. Để đánh giá hiệu suất của nó, mô hình sử dụng hai số liệu: MOS-N hoặc Điểm ý kiến trung bình về tính tự nhiên, và RÊU hoặc Điểm ý kiến trung bình về mức độ tương đồng.

Kết quả

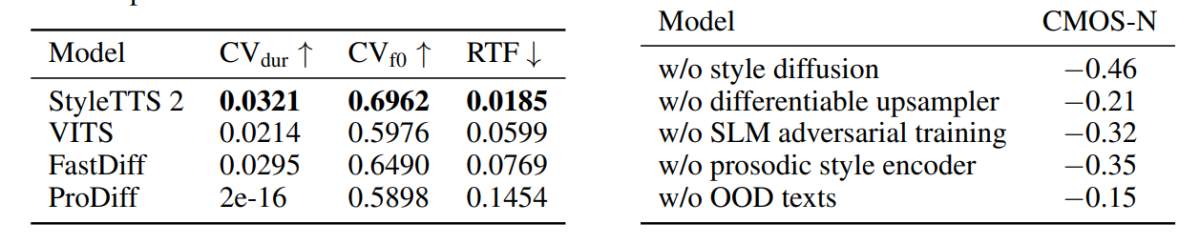

Cách tiếp cận và phương pháp được sử dụng trong khung StyleTTS2 được thể hiện ở hiệu suất của nó khi mô hình này vượt trội hơn một số khung TTS hiện đại, đặc biệt là trên tập dữ liệu NaturalSpeech và trên đường thiết lập tiêu chuẩn mới cho tập dữ liệu. Hơn nữa, khung StyleTTS2 hoạt động tốt hơn khung VITS hiện đại trên tập dữ liệu VCTK và kết quả được thể hiện trong hình sau.

Mô hình StyleTTS2 cũng hoạt động tốt hơn các mô hình trước đó trên tập dữ liệu LJSpeech và không hiển thị bất kỳ mức độ suy giảm chất lượng nào trên văn bản OOD hoặc Không phân phối như được hiển thị bởi các khung trước đó trên cùng số liệu. Hơn nữa, ở cài đặt không chụp, mô hình StyleTTC2 vượt trội hơn khung Vall-E hiện có về độ tự nhiên mặc dù nó kém hơn về độ tương tự. Tuy nhiên, điều đáng chú ý là khung StyleTTS2 có thể đạt được hiệu suất cạnh tranh mặc dù chỉ đào tạo trên 245 giờ mẫu âm thanh khi so sánh với hơn 60 nghìn giờ đào tạo của khung Vall-E, do đó chứng tỏ StyleTTC2 là một giải pháp thay thế hiệu quả về dữ liệu với các phương pháp đào tạo trước quy mô lớn hiện có như được sử dụng trong Vall-E.

Tiếp tục, do thiếu dữ liệu văn bản âm thanh được gắn nhãn cảm xúc, khung StyleTTC2 sử dụng mô hình GPT-4 để tạo ra hơn 500 phiên bản trên các cảm xúc khác nhau để trực quan hóa các vectơ kiểu mà khung tạo ra bằng cách sử dụng nó. phát sóng quá trình.

Trong hình đầu tiên, các kiểu cảm xúc đáp lại tình cảm của văn bản đầu vào được minh họa bằng các vectơ kiểu từ mô hình LJSpeech và nó thể hiện khả năng của khung StyleTTC2 trong việc tổng hợp lời nói biểu cảm với nhiều cảm xúc khác nhau. Hình thứ hai mô tả dạng cụm riêng biệt cho từng loa trong số năm loa riêng lẻ, do đó mô tả nhiều mức độ đa dạng có nguồn gốc từ một tệp âm thanh duy nhất. Hình cuối cùng thể hiện cụm cảm xúc lỏng lẻo từ người nói 1 và tiết lộ rằng, mặc dù có một số điểm trùng lặp, các cụm dựa trên cảm xúc vẫn nổi bật, do đó cho thấy khả năng điều khiển giai điệu cảm xúc của người nói bất kể mẫu âm thanh tham chiếu và âm đầu vào của nó . Mặc dù sử dụng cách tiếp cận dựa trên sự phổ biến, khung StyleTTS2 vẫn hoạt động tốt hơn các khung hiện đại hiện có bao gồm VITS, ProDiff và FastDiff.

.

Trong bài viết này, chúng ta đã nói về StyleTTS2, một khung chuyển văn bản sang giọng nói mới, mạnh mẽ và sáng tạo được xây dựng trên nền tảng của khung StyleTTS và nhằm mục đích trình bày bước tiếp theo hướng tới các hệ thống chuyển văn bản sang giọng nói hiện đại. Khung StyleTTS2 mô hình hóa các kiểu giọng nói dưới dạng các biến ngẫu nhiên tiềm ẩn và sử dụng mô hình khuếch tán xác suất để lấy mẫu các kiểu giọng nói hoặc biến ngẫu nhiên này, do đó cho phép khung StyleTTS2 tổng hợp giọng nói thực tế một cách hiệu quả mà không cần sử dụng đầu vào âm thanh tham chiếu. Khung StyleTTS2 sử dụng bộ khuếch tán kiểu và bộ phân biệt SLM để đạt được hiệu suất ở cấp độ con người trong các tác vụ chuyển văn bản thành lời nói và quản lý để thực hiện tốt hơn các khung công nghệ hiện đại trong một loạt các tác vụ lời nói.